Redis进阶学习08--多级缓存

什么是多级缓存

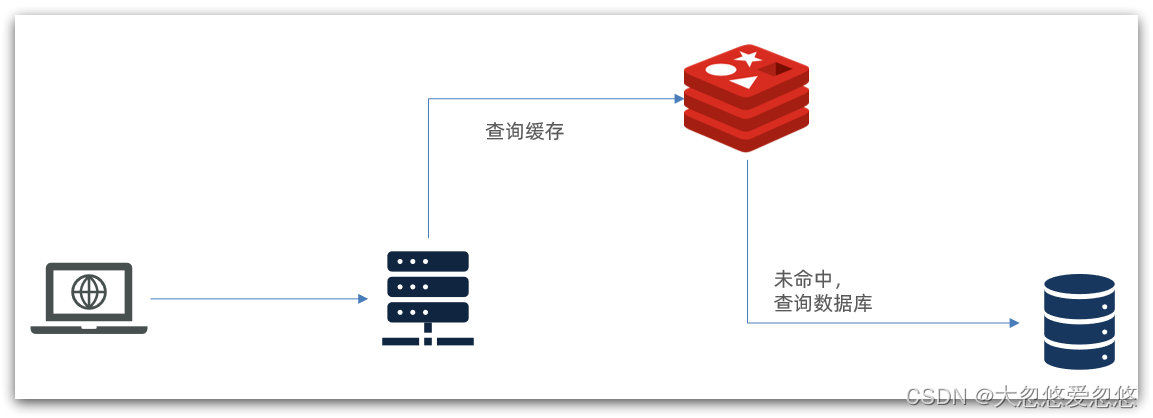

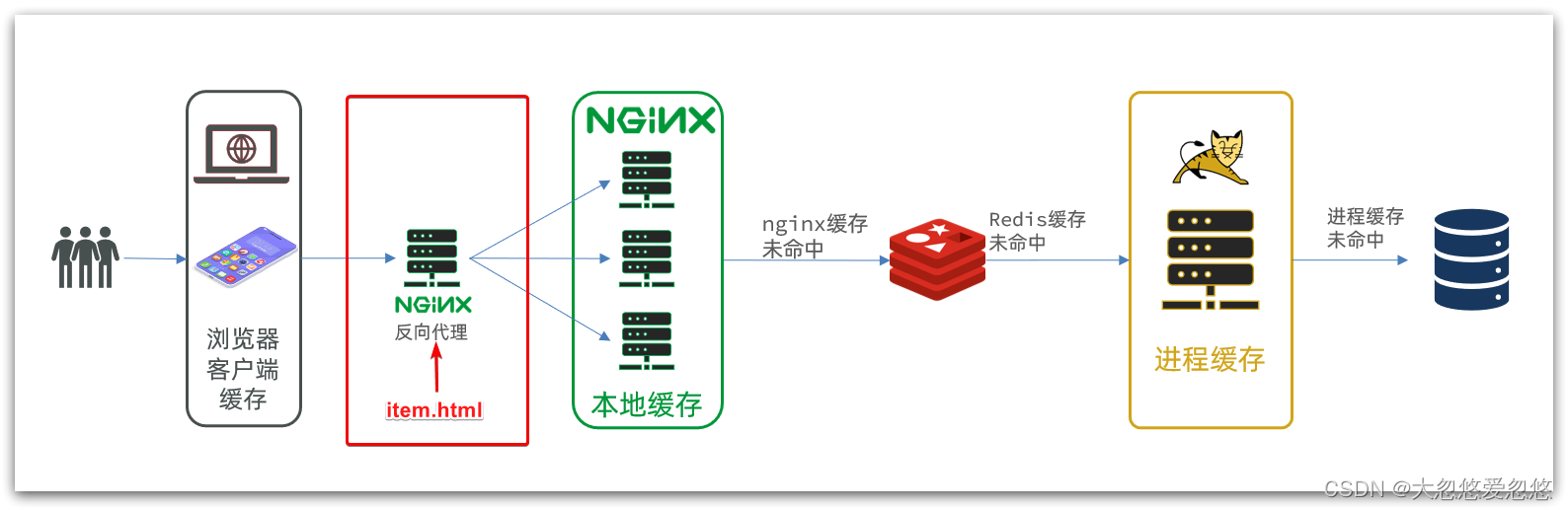

传统的缓存策略一般是请求到达Tomcat后,先查询Redis,如果未命中则查询数据库,如图:

存在下面的问题:

? 请求要经过Tomcat处理,Tomcat的性能成为整个系统的瓶颈

? Redis缓存失效时,会对数据库产生冲击

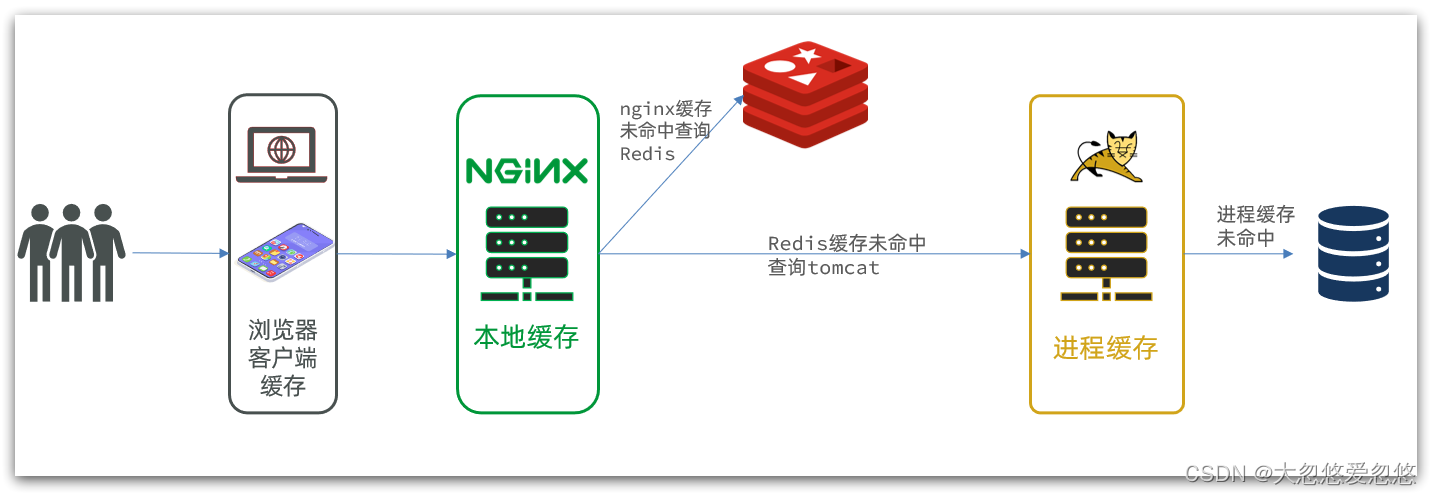

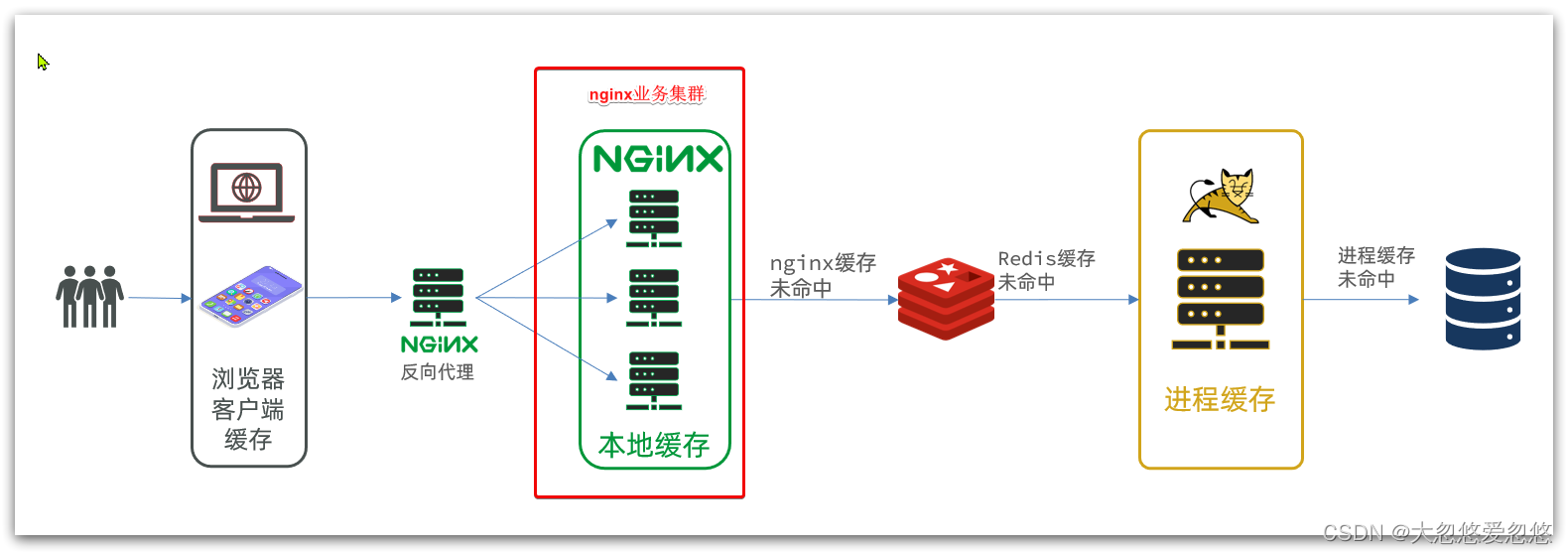

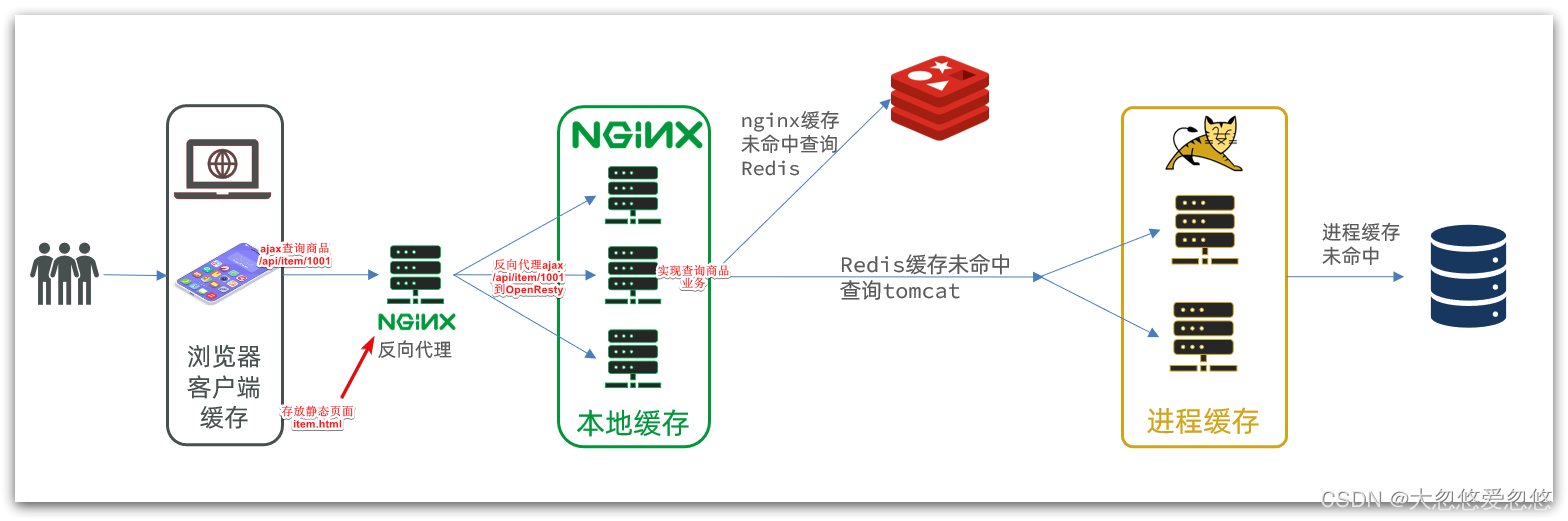

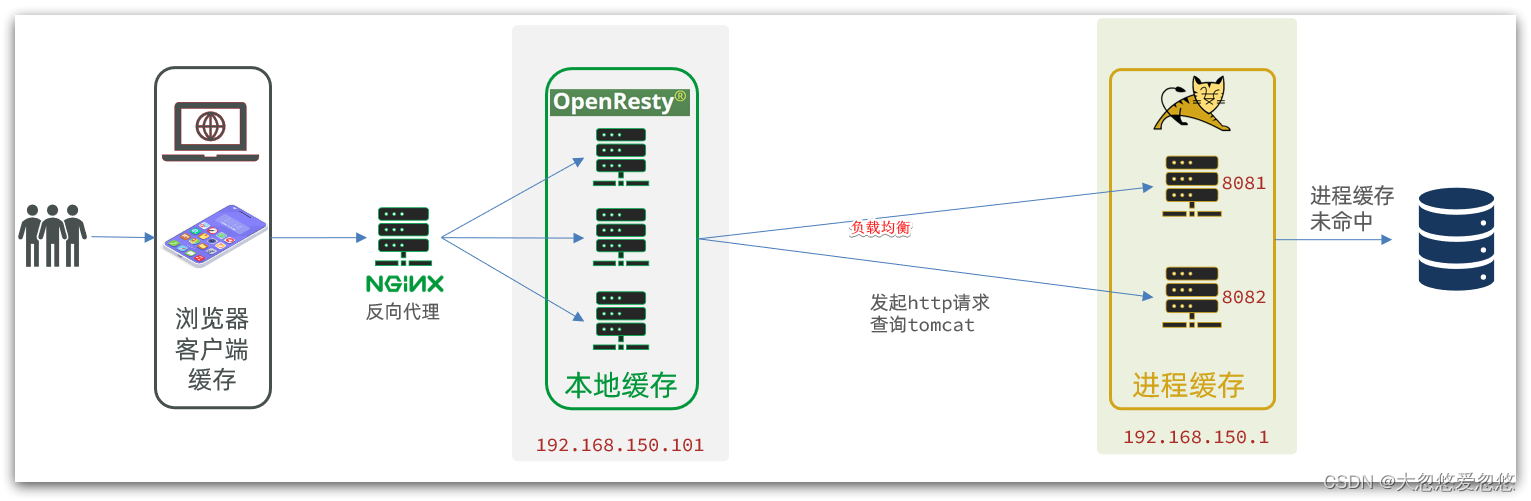

多级缓存就是充分利用请求处理的每个环节,分别添加缓存,减轻Tomcat压力,提升服务性能:

- 浏览器访问静态资源时,优先读取浏览器本地缓存

- 访问非静态资源(ajax查询数据)时,访问服务端

- 请求到达Nginx后,优先读取Nginx本地缓存

- 如果Nginx本地缓存未命中,则去直接查询Redis(不经过Tomcat)

- 如果Redis查询未命中,则查询Tomcat

- 请求进入Tomcat后,优先查询JVM进程缓存

- 如果JVM进程缓存未命中,则查询数据库

在多级缓存架构中,Nginx内部需要编写本地缓存查询、Redis查询、Tomcat查询的业务逻辑,因此这样的nginx服务不再是一个反向代理服务器,而是一个编写业务的Web服务器了。

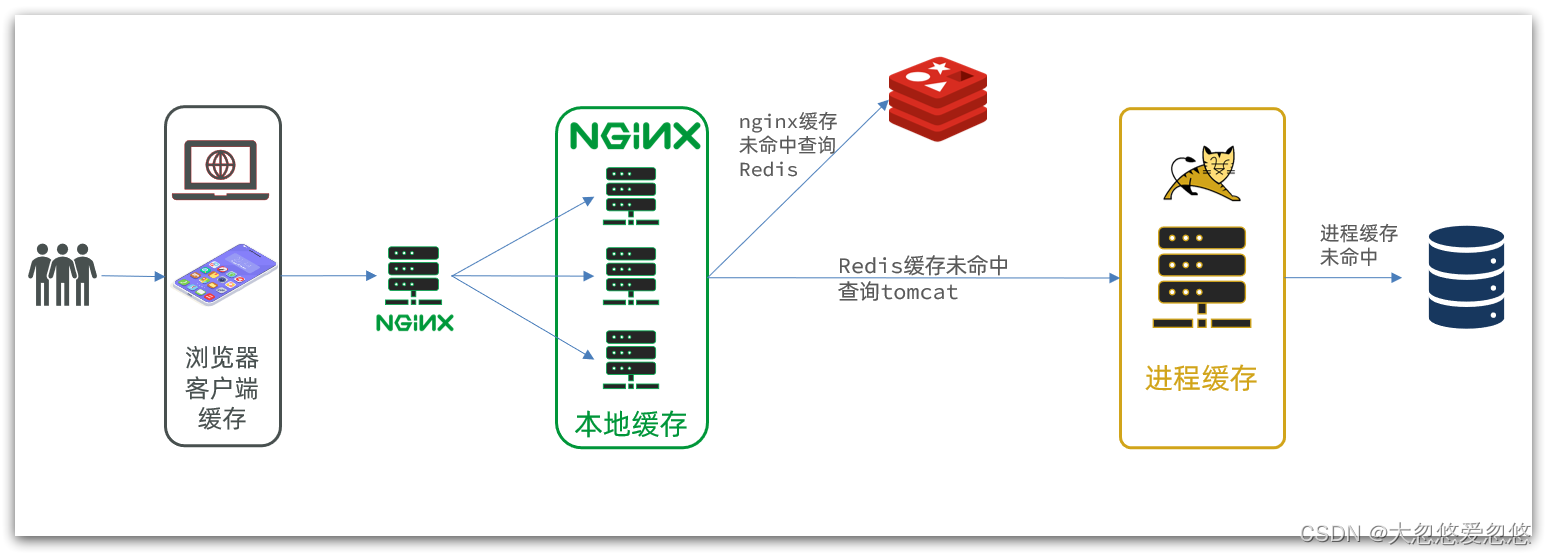

因此这样的业务Nginx服务也需要搭建集群来提高并发,再有专门的nginx服务来做反向代理,如图:

另外,我们的Tomcat服务将来也会部署为集群模式:

当然redis也可以部署为集群模式,mysql也可以部署为集群模式,nginx反向代理也可以配置多台,然后通过vip漂移,实现反向代理的统一接口访问

可见,多级缓存的关键有两个:

-

一个是在nginx中编写业务,实现nginx本地缓存、Redis、Tomcat的查询

-

另一个就是在Tomcat中实现JVM进程缓存

其中Nginx编程则会用到OpenResty框架结合Lua这样的语言。

JVM进程缓存

环境准备

docker安装mysql

- docker安装mysql—5.7

先准备一个my.cnf配置文件:

[mysqld]

#跳过域名解析

skip-name-resolve

#指定服务器级别的字符集

character_set_server=utf8

#指定数据存放目录

datadir=/dhy/mysql-new-1/data

#MySQL服务的ID

server-id=1000

执行以下docker命令:

docker run \

-p 3307:3306 \

--name mysql-new-1 \

-v $PWD/conf:/etc/mysql/conf.d \

-v $PWD/logs:/logs \

-v $PWD/data:/var/lib/mysql \

-e MYSQL_ROOT_PASSWORD=123456\

--privileged \

-d \

mysql:5.7

或者采用docker-compose方式–推荐

version: "3.3"

services:

mysql-new-1:

container_name: "msyql-new-1"

image: "mysql:5.7"

ports:

- "3307:3306"

volumes:

- "${PWD}/conf:/etc/mysql/conf.d"

- "${PWD}/logs:/logs"

- "${PWD}/data:/var/lib/mysql"

environment:

#root用户密码

MYSQL_ROOT_PASSWORD: 126433

# docker容器的时区纠正一下

TZ: Asia/Shanghai

MYSQL_USER: dhy #自定义数据库的用户,权限只作用于MYSQL_DATABASE配置的数据库

MYSQL_PASSWORD: dhy #自定义数据库的用户,权限只作用于MYSQL_DATABASE配置的数据库

privileged: true #一定要设置为true,不然数据卷可能挂载不了,启动不起

command:

--character-set-server=utf8mb4

--collation-server=utf8mb4_general_ci

restart: always

注意:如果先执行了第一种方式创建mysql容器,然后再执行第二种方式进行创建,并且数据目录位置不变,那么第二种方式设置的用户密码啥的都会无效,因为第一次创建时,已经将密码持久化到data目录下了,因此需要删除再重新创建一遍data目录才可以

sql文件如下:

create database item;

use item;

SET NAMES utf8mb4;

SET FOREIGN_KEY_CHECKS = 0;

-- ----------------------------

-- Table structure for tb_item

-- ----------------------------

DROP TABLE IF EXISTS `tb_item`;

CREATE TABLE `tb_item` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT '商品id',

`title` varchar(264) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL COMMENT '商品标题',

`name` varchar(128) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL DEFAULT '' COMMENT '商品名称',

`price` bigint(20) NOT NULL COMMENT '价格(分)',

`image` varchar(200) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL COMMENT '商品图片',

`category` varchar(200) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL COMMENT '类目名称',

`brand` varchar(100) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL COMMENT '品牌名称',

`spec` varchar(200) CHARACTER SET utf8 COLLATE utf8_general_ci NULL DEFAULT NULL COMMENT '规格',

`status` int(1) NULL DEFAULT 1 COMMENT '商品状态 1-正常,2-下架,3-删除',

`create_time` datetime NULL DEFAULT NULL COMMENT '创建时间',

`update_time` datetime NULL DEFAULT NULL COMMENT '更新时间',

PRIMARY KEY (`id`) USING BTREE,

INDEX `status`(`status`) USING BTREE,

INDEX `updated`(`update_time`) USING BTREE

) ENGINE = InnoDB AUTO_INCREMENT = 50002 CHARACTER SET = utf8 COLLATE = utf8_general_ci COMMENT = '商品表' ROW_FORMAT = COMPACT;

-- ----------------------------

-- Records of tb_item

-- ----------------------------

INSERT INTO `tb_item` VALUES (10001, 'RIMOWA 21寸托运箱拉杆箱 SALSA AIR系列果绿色 820.70.36.4', 'SALSA AIR', 16900, 'https://m.360buyimg.com/mobilecms/s720x720_jfs/t6934/364/1195375010/84676/e9f2c55f/597ece38N0ddcbc77.jpg!q70.jpg.webp', '拉杆箱', 'RIMOWA', '{\"颜色\": \"红色\", \"尺码\": \"26寸\"}', 1, '2019-05-01 00:00:00', '2019-05-01 00:00:00');

INSERT INTO `tb_item` VALUES (10002, '安佳脱脂牛奶 新西兰进口轻欣脱脂250ml*24整箱装*2', '脱脂牛奶', 68600, 'https://m.360buyimg.com/mobilecms/s720x720_jfs/t25552/261/1180671662/383855/33da8faa/5b8cf792Neda8550c.jpg!q70.jpg.webp', '牛奶', '安佳', '{\"数量\": 24}', 1, '2019-05-01 00:00:00', '2019-05-01 00:00:00');

INSERT INTO `tb_item` VALUES (10003, '唐狮新品牛仔裤女学生韩版宽松裤子 A款/中牛仔蓝(无绒款) 26', '韩版牛仔裤', 84600, 'https://m.360buyimg.com/mobilecms/s720x720_jfs/t26989/116/124520860/644643/173643ea/5b860864N6bfd95db.jpg!q70.jpg.webp', '牛仔裤', '唐狮', '{\"颜色\": \"蓝色\", \"尺码\": \"26\"}', 1, '2019-05-01 00:00:00', '2019-05-01 00:00:00');

INSERT INTO `tb_item` VALUES (10004, '森马(senma)休闲鞋女2019春季新款韩版系带板鞋学生百搭平底女鞋 黄色 36', '休闲板鞋', 10400, 'https://m.360buyimg.com/mobilecms/s720x720_jfs/t1/29976/8/2947/65074/5c22dad6Ef54f0505/0b5fe8c5d9bf6c47.jpg!q70.jpg.webp', '休闲鞋', '森马', '{\"颜色\": \"白色\", \"尺码\": \"36\"}', 1, '2019-05-01 00:00:00', '2019-05-01 00:00:00');

INSERT INTO `tb_item` VALUES (10005, '花王(Merries)拉拉裤 M58片 中号尿不湿(6-11kg)(日本原装进口)', '拉拉裤', 38900, 'https://m.360buyimg.com/mobilecms/s720x720_jfs/t24370/119/1282321183/267273/b4be9a80/5b595759N7d92f931.jpg!q70.jpg.webp', '拉拉裤', '花王', '{\"型号\": \"XL\"}', 1, '2019-05-01 00:00:00', '2019-05-01 00:00:00');

-- ----------------------------

-- Table structure for tb_item_stock

-- ----------------------------

DROP TABLE IF EXISTS `tb_item_stock`;

CREATE TABLE `tb_item_stock` (

`item_id` bigint(20) NOT NULL COMMENT '商品id,关联tb_item表',

`stock` int(10) NOT NULL DEFAULT 9999 COMMENT '商品库存',

`sold` int(10) NOT NULL DEFAULT 0 COMMENT '商品销量',

PRIMARY KEY (`item_id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8mb4 COLLATE = utf8mb4_general_ci ROW_FORMAT = COMPACT;

-- ----------------------------

-- Records of tb_item_stock

-- ----------------------------

INSERT INTO `tb_item_stock` VALUES (10001, 99996, 3219);

INSERT INTO `tb_item_stock` VALUES (10002, 99999, 54981);

INSERT INTO `tb_item_stock` VALUES (10003, 99999, 189);

INSERT INTO `tb_item_stock` VALUES (10004, 99999, 974);

INSERT INTO `tb_item_stock` VALUES (10005, 99999, 18649);

SET FOREIGN_KEY_CHECKS = 1;

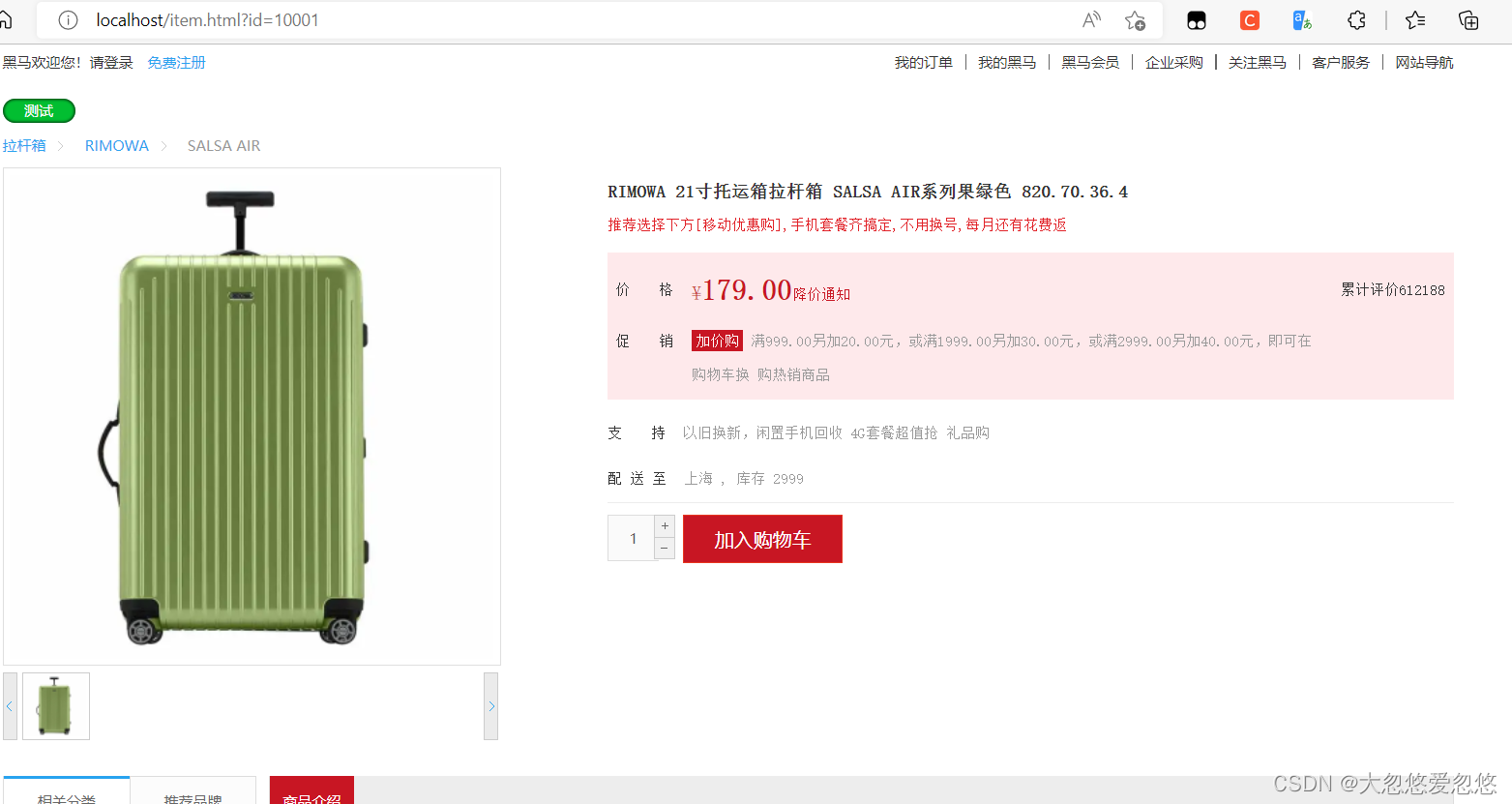

然后就是各位自己动手去搭建一个springboot项目,连接这个数据库,然后完成相关CURD简单接口测试,这里不做展示

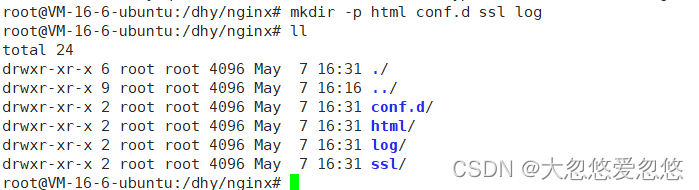

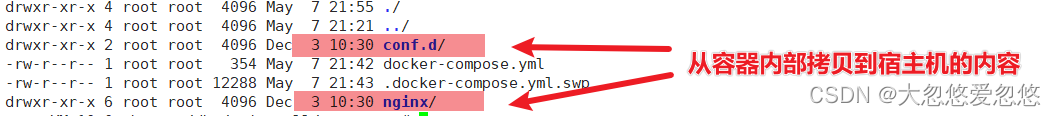

docker安装nginx

因为我们的项目是动静分离的,静态资源全部放在了nginx上面,因此我们还需要利用docker安装一台nginx,然后将相关静态资源放入nginx中

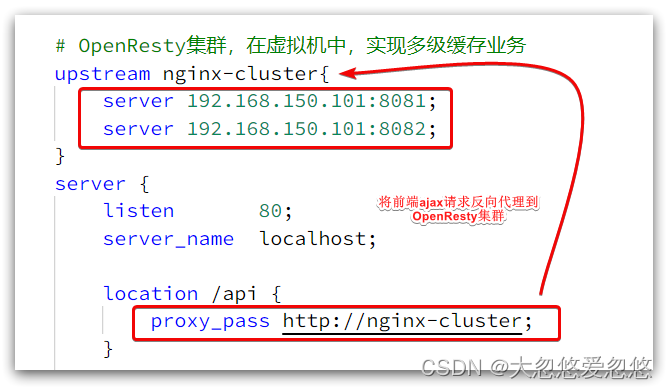

我们需要准备一个反向代理的nginx服务器,如上图红框所示,将静态的商品页面放到nginx目录中。

页面需要的数据通过ajax向服务端(nginx业务集群)查询。

docker安装nginx步骤:

- docker pull nginx(已有镜像,跳过此步骤)

- 创建nginx挂载目录

mkdir -p html conf.d ssl log

- 运行nginx容器

docker run -d -p 80:80 --name nginx --privileged=true nginx

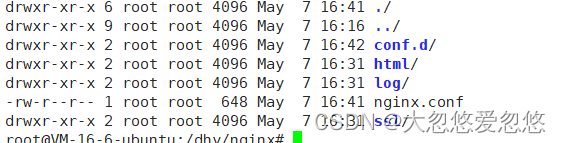

- 拷贝必要配置文件到宿主机

docker cp 用于容器与主机之间的数据拷贝,

语法 :

docker cp [OPTIONS] CONTAINER:SRC_PATH DEST_PATH|-

docker cp [OPTIONS] SRC_PATH|- CONTAINER:DEST_PATH

参数 :

- CONTAINER : 运行中的容器ID

- -L :保持源目标中的链接

使用参考:

文件:将主机/www/1.conf 拷贝到容器96f7f14e99ab的test目录下

docker cp /www/1.conf 96f7f14e99ab:/test/

文件:将容器96f7f14e99ab中www目录下的12.conf文件,拷贝到主机的/目录中

docker cp 96f7f14e99ab:/www/2.conf /

目录:将主机/www/runoob目录拷贝到容器96f7f14e99ab中,目录重命名为www

docker cp /www/runoob 96f7f14e99ab:/www

目录:将容器96f7f14e99ab的/www目录拷贝到主机的/tmp目录中

docker cp 96f7f14e99ab:/www /tmp/

我们这里需要做的就是将容器中的nginx.conf拷贝到宿主机目录下

docker cp nginx:/etc/nginx/nginx.conf ./

- 删除nginx示例容器

docker rm -f nginx

- 生成最终的nginx容器

docker run

-itd

--restart=always

-p 80:80

-p 443:443

-v $PWD/html:/usr/share/nginx/html

-v $PWD/conf.d/:/etc/nginx/conf.d

-v $PWD/ssl/:/etc/nginx/ssl

-v $PWD/log/:/var/log/nginx

-v $PWD/nginx.conf:/etc/nginx/nginx.conf

--name nginx

--privileged=true

nginx

docker-compose.yml方式来管理nginx

version: "3.3"

services:

nginx-proxy:

container_name: "nginx-proxy"

image: "nginx"

ports:

- "80:80"

- "433:433"

volumes:

- "${PWD}/nginx-proxy/html:/etc/nginx/html"

- "${PWD}/nginx-proxy/conf.d:/etc/nginx/conf.d"

- "${PWD}/nginx-proxy/ssl:/etc/nginx/ssl"

- "${PWD}/nginx-proxy/log:/var/log/nginx"

- "${PWD}/nginx-proxy/nginx.conf:/etc/nginx/nginx.conf"

privileged: true

restart: always

如果我们修改了配置文件,想进行热更新的话:

docker exec -it nginx-proxy nginx -s reload

nginx配置文件和静态资源管理:

user root;

worker_processes auto;

error_log /var/log/nginx/error.log notice;

pid /var/run/nginx.pid;

events {

worker_connections 1024;

}

http {

include /etc/nginx/mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

sendfile on;

#tcp_nopush on;

keepalive_timeout 65;

#nginx集群负载均衡配置

upstream nginx-cluster{

server 具体服务器地址:8081;

server 具体服务器地址:8082;

}

server{

listen 80;

server_name 具体服务器地址;

location /api {

proxy_pass http://nginx-cluster;

}

}

#gzip on;

include /etc/nginx/conf.d/*.conf;

}

conf.d目录下面的default.conf

server {

listen 80;

listen [::]:80;

server_name localhost;

#access_log /var/log/nginx/host.access.log main;

#兜底解决方案

location / {

#所有静态资源都会去这个目录下面找

root /usr/share/nginx/html;

#如果只是/,那么取查找root指定的目录下查找首页资源

index index.html index.htm;

}

#error_page 404 /404.html;

# redirect server error pages to the static page /50x.html

#

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

}

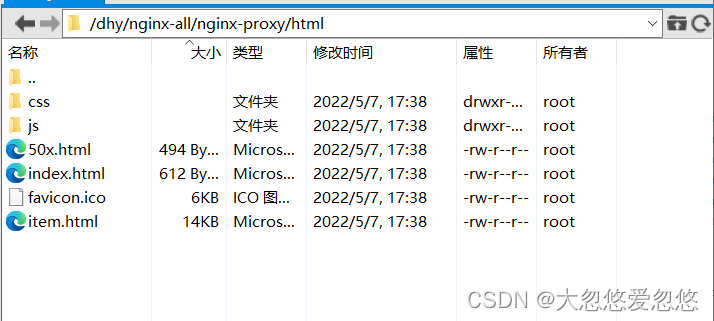

静态资源统一放到html静态资源目录下面即可:

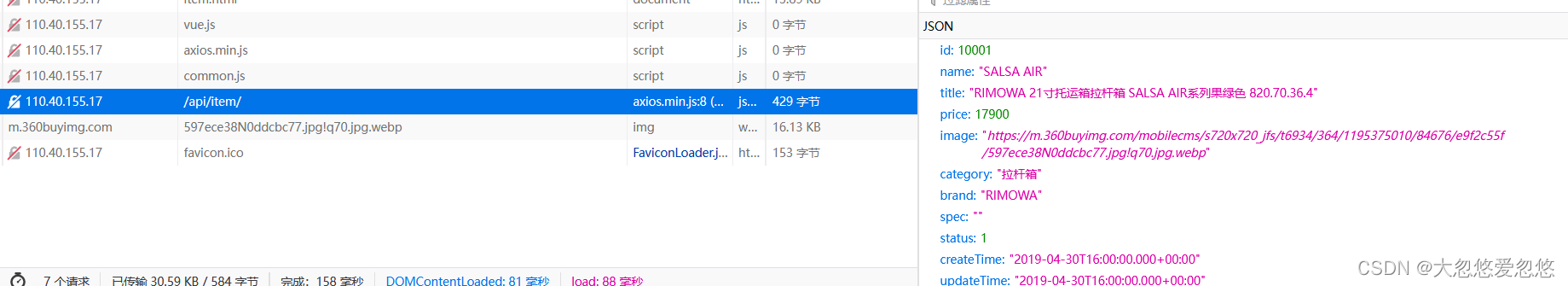

访问item.html进行测试:

反向代理

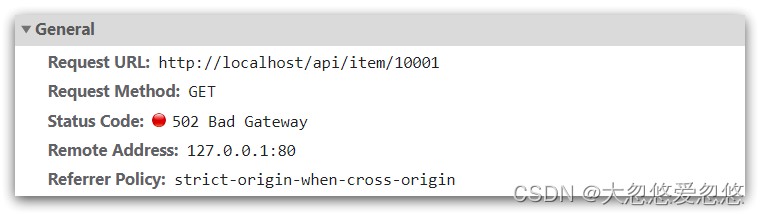

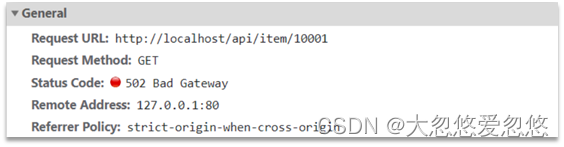

现在,页面是假数据展示的。我们需要向服务器发送ajax请求,查询商品数据。

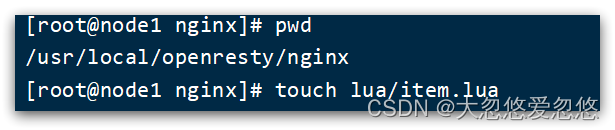

打开控制台,可以看到页面有发起ajax查询数据:

而这个请求地址同样是80端口,所以被当前的nginx反向代理了。

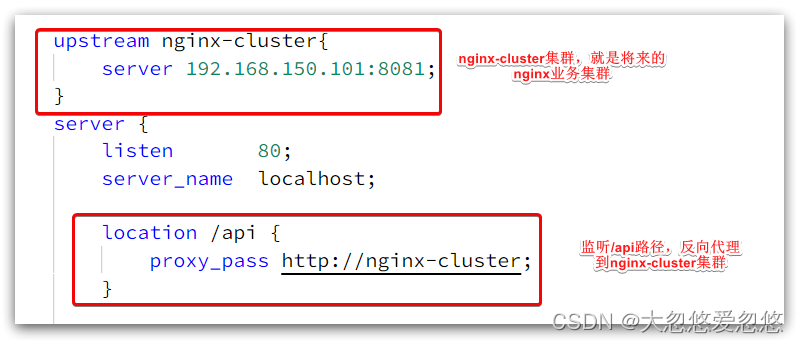

查看nginx的conf目录下的nginx.conf文件:

其中的192.168.150.101是我的虚拟机IP,也就是我的Nginx业务集群要部署的地方:

初识Caffeine

缓存在日常开发中启动至关重要的作用,由于是存储在内存中,数据的读取速度是非常快的,能大量减少对数据库的访问,减少数据库的压力。我们把缓存分为两类:

- 分布式缓存,例如Redis:

- 优点:存储容量更大、可靠性更好、可以在集群间共享

- 缺点:访问缓存有网络开销

- 场景:缓存数据量较大、可靠性要求较高、需要在集群间共享

- 进程本地缓存,例如HashMap、GuavaCache:

- 优点:读取本地内存,没有网络开销,速度更快

- 缺点:存储容量有限、可靠性较低、无法共享

- 场景:性能要求较高,缓存数据量较小

我们今天会利用Caffeine框架来实现JVM进程缓存。

Caffeine是一个基于Java8开发的,提供了近乎最佳命中率的高性能的本地缓存库。目前Spring内部的缓存使用的就是Caffeine。GitHub地址:https://github.com/ben-manes/caffeine

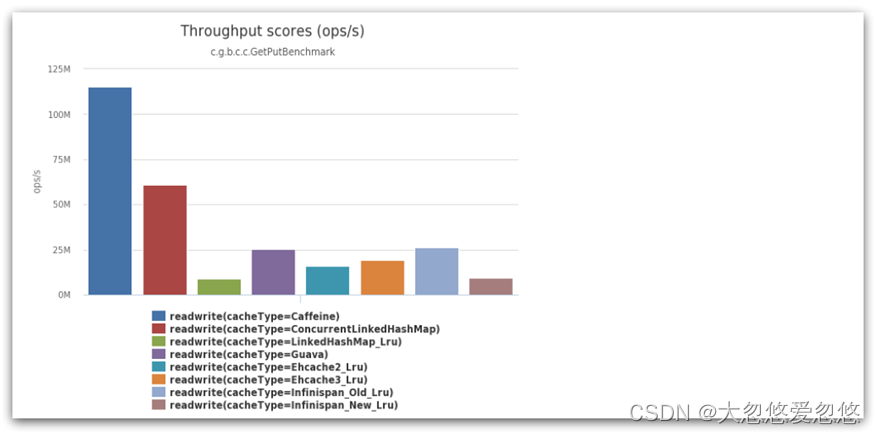

Caffeine的性能非常好,下图是官方给出的性能对比:

可以看到Caffeine的性能遥遥领先!

缓存使用的基本API:

/*

基本用法测试

*/

@Test

void testBasicOps() {

// 创建缓存对象

Cache<String, String> cache = Caffeine.newBuilder().build();

// 存数据

cache.put("gf", "迪丽热巴");

// 取数据,不存在则返回null

String gf = cache.getIfPresent("gf");

System.out.println("gf = " + gf);

// 取数据,不存在则去数据库查询

String defaultGF = cache.get("defaultGF", key -> {

// 这里可以去数据库根据 key查询value

return "柳岩";

});

System.out.println("defaultGF = " + defaultGF);

}

Caffeine既然是缓存的一种,肯定需要有缓存的清除策略,不然的话内存总会有耗尽的时候。

Caffeine提供了三种缓存驱逐策略:

-

基于容量:设置缓存的数量上限

// 创建缓存对象 Cache<String, String> cache = Caffeine.newBuilder() .maximumSize(1) // 设置缓存大小上限为 1 .build(); -

基于时间:设置缓存的有效时间

// 创建缓存对象 Cache<String, String> cache = Caffeine.newBuilder() // 设置缓存有效期为 10 秒,从最后一次写入开始计时 .expireAfterWrite(Duration.ofSeconds(10)) .build(); -

基于引用:设置缓存为软引用或弱引用,利用GC来回收缓存数据。性能较差,不建议使用。

注意:在默认情况下,当一个缓存元素过期的时候,Caffeine不会自动立即将其清理和驱逐。而是在一次读或写操作后,或者在空闲时间完成对失效数据的驱逐。

实现JVM进程缓存

需求

利用Caffeine实现下列需求:

- 给根据id查询商品的业务添加缓存,缓存未命中时查询数据库

- 给根据id查询商品库存的业务添加缓存,缓存未命中时查询数据库

- 缓存初始大小为100

- 缓存上限为10000

实现

首先,我们需要定义两个Caffeine的缓存对象,分别保存商品、库存的缓存数据。

在item-service的config包下定义CaffeineConfig类:

@Configuration

public class CaffeineConfig {

@Bean

public Cache<Long, Item> itemCache(){

return Caffeine.newBuilder()

.initialCapacity(100)

.maximumSize(10_000)

.build();

}

@Bean

public Cache<Long, ItemStock> stockCache(){

return Caffeine.newBuilder()

.initialCapacity(100)

.maximumSize(10_000)

.build();

}

}

然后,修改item-service中的web包下的ItemController类,添加缓存逻辑:

@RestController

@RequestMapping("item")

public class ItemController {

@Autowired

private IItemService itemService;

@Autowired

private IItemStockService stockService;

@Autowired

private Cache<Long, Item> itemCache;

@Autowired

private Cache<Long, ItemStock> stockCache;

// ...其它略

@GetMapping("/{id}")

public Item findById(@PathVariable("id") Long id) {

return itemCache.get(id, key -> itemService.query()

.ne("status", 3).eq("id", key)

.one()

);

}

@GetMapping("/stock/{id}")

public ItemStock findStockById(@PathVariable("id") Long id) {

return stockCache.get(id, key -> stockService.getById(key));

}

}

Lua语法入门

Nginx编程需要用到Lua语言,因此我们必须先入门Lua的基本语法。

初识Lua

Lua 是一种轻量小巧的脚本语言,用标准C语言编写并以源代码形式开放, 其设计目的是为了嵌入应用程序中,从而为应用程序提供灵活的扩展和定制功能。官网:https://www.lua.org/

Lua经常嵌入到C语言开发的程序中,例如游戏开发、游戏插件等。

Nginx本身也是C语言开发,因此也允许基于Lua做拓展。

HelloWorld

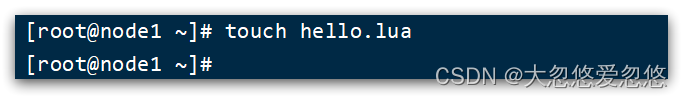

CentOS7默认已经安装了Lua语言环境,所以可以直接运行Lua代码。

1)在Linux虚拟机的任意目录下,新建一个hello.lua文件

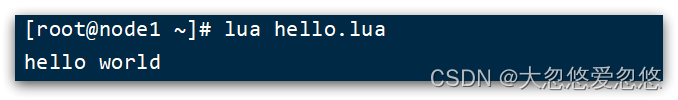

2)添加下面的内容

print("Hello World!")

3)运行

变量和循环

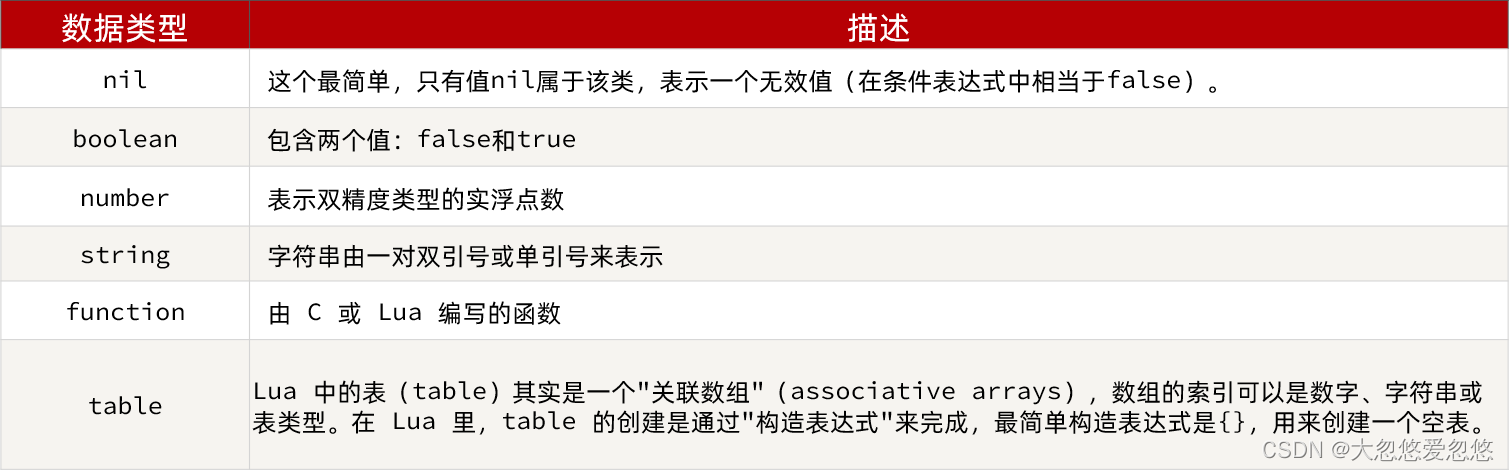

Lua的数据类型

Lua中支持的常见数据类型包括:

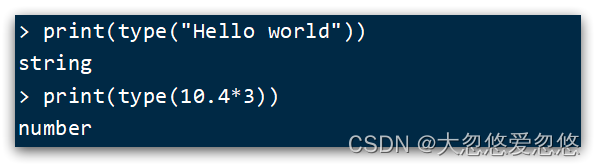

另外,Lua提供了type()函数来判断一个变量的数据类型:

声明变量

Lua声明变量的时候无需指定数据类型,而是用local来声明变量为局部变量:

-- 声明字符串,可以用单引号或双引号,

local str = 'hello'

-- 字符串拼接可以使用 ..

local str2 = 'hello' .. 'world'

-- 声明数字

local num = 21

-- 声明布尔类型

local flag = true

Lua中的table类型既可以作为数组,又可以作为Java中的map来使用。数组就是特殊的table,key是数组角标而已:

-- 声明数组 ,key为角标的 table

local arr = {'java', 'python', 'lua'}

-- 声明table,类似java的map

local map = {name='Jack', age=21}

Lua中的数组角标是从1开始,访问的时候与Java中类似:

-- 访问数组,lua数组的角标从1开始

print(arr[1])

Lua中的table可以用key来访问:

-- 访问table

print(map['name'])

print(map.name)

循环

对于table,我们可以利用for循环来遍历。不过数组和普通table遍历略有差异。

遍历数组:

-- 声明数组 key为索引的 table

local arr = {'java', 'python', 'lua'}

-- 遍历数组

for index,value in ipairs(arr) do

print(index, value)

end

遍历普通table

-- 声明map,也就是table

local map = {name='Jack', age=21}

-- 遍历table

for key,value in pairs(map) do

print(key, value)

end

条件控制、函数

Lua中的条件控制和函数声明与Java类似。

函数

定义函数的语法:

function 函数名( argument1, argument2..., argumentn)

-- 函数体

return 返回值

end

例如,定义一个函数,用来打印数组:

function printArr(arr)

for index, value in ipairs(arr) do

print(value)

end

end

条件控制

类似Java的条件控制,例如if、else语法:

if(布尔表达式)

then

--[ 布尔表达式为 true 时执行该语句块 --]

else

--[ 布尔表达式为 false 时执行该语句块 --]

end

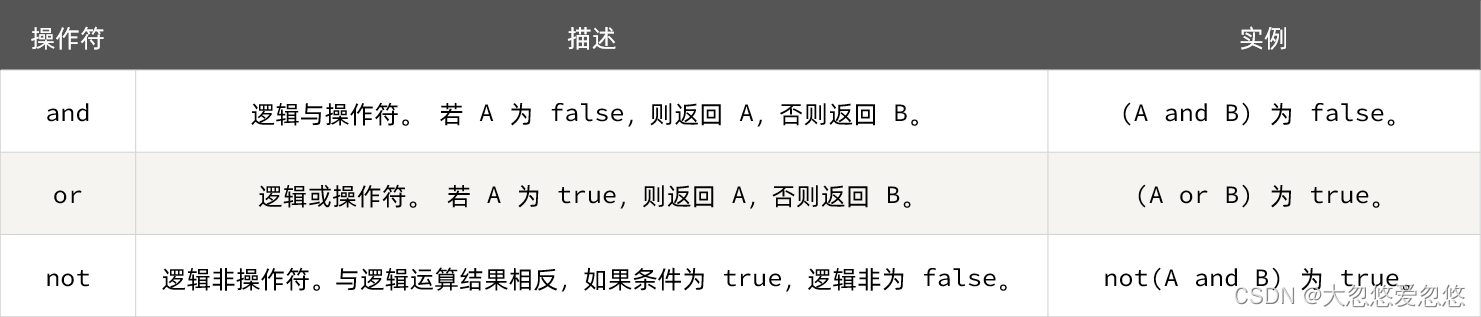

与java不同,布尔表达式中的逻辑运算是基于英文单词:

需求:自定义一个函数,可以打印table,当参数为nil时,打印错误信息

function printArr(arr)

if not arr then

print('数组不能为空!')

end

for index, value in ipairs(arr) do

print(value)

end

end

实现多级缓存

多级缓存的实现离不开Nginx编程,而Nginx编程又离不开OpenResty。

原始方式安装OpenResty

OpenResty? 是一个基于 Nginx的高性能 Web 平台,用于方便地搭建能够处理超高并发、扩展性极高的动态 Web 应用、Web 服务和动态网关。具备下列特点:

- 具备Nginx的完整功能

- 基于Lua语言进行扩展,集成了大量精良的 Lua 库、第三方模块

- 允许使用Lua自定义业务逻辑、自定义库

官方网站: https://openresty.org/cn/

安装开发库

首先要安装OpenResty的依赖开发库,执行命令:

yum install -y pcre-devel openssl-devel gcc --skip-broken

安装OpenResty仓库

你可以在你的 CentOS 系统中添加 openresty 仓库,这样就可以便于未来安装或更新我们的软件包(通过 yum check-update 命令)。运行下面的命令就可以添加我们的仓库:

yum-config-manager --add-repo https://openresty.org/package/centos/openresty.repo

如果提示说命令不存在,则运行:

yum install -y yum-utils

然后再重复上面的命令

安装OpenResty

然后就可以像下面这样安装软件包,比如 openresty:

yum install -y openresty

安装opm工具

opm是OpenResty的一个管理工具,可以帮助我们安装一个第三方的Lua模块。

如果你想安装命令行工具 opm,那么可以像下面这样安装 openresty-opm 包:

yum install -y openresty-opm

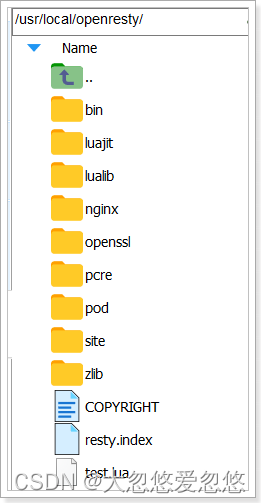

目录结构

默认情况下,OpenResty安装的目录是:/usr/local/openresty

看到里面的nginx目录了吗,OpenResty就是在Nginx基础上集成了一些Lua模块。

配置nginx的环境变量

打开配置文件:

vi /etc/profile

在最下面加入两行:

export NGINX_HOME=/usr/local/openresty/nginx

export PATH=${NGINX_HOME}/sbin:$PATH

NGINX_HOME:后面是OpenResty安装目录下的nginx的目录

然后让配置生效:

source /etc/profile

启动和运行

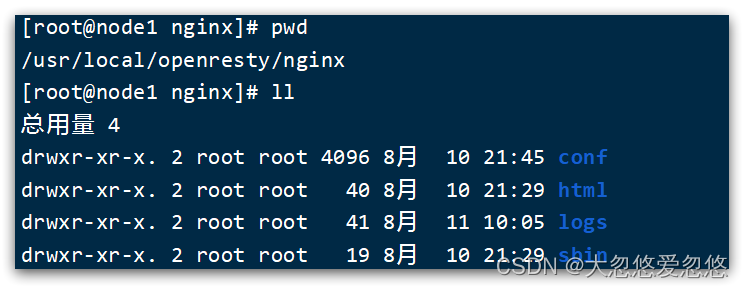

OpenResty底层是基于Nginx的,查看OpenResty目录的nginx目录,结构与windows中安装的nginx基本一致:

所以运行方式与nginx基本一致:

# 启动nginx

nginx

# 重新加载配置

nginx -s reload

# 停止

nginx -s stop

nginx的默认配置文件注释太多,影响后续我们的编辑,这里将nginx.conf中的注释部分删除,保留有效部分。

修改/usr/local/openresty/nginx/conf/nginx.conf文件,内容如下:

#user nobody;

worker_processes 1;

error_log logs/error.log;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

sendfile on;

keepalive_timeout 65;

server {

listen 8081;

server_name localhost;

location / {

root html;

index index.html index.htm;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

}

在Linux的控制台输入命令以启动nginx:

nginx

然后访问页面:http://192.168.150.101:8081,注意ip地址替换为你自己的虚拟机IP:

docker方式安装

- 安装镜像

docker pull openresty/openresty

- 运行一个简单的容器

docker run -d --name openresty -p 80:80 openresty/openresty

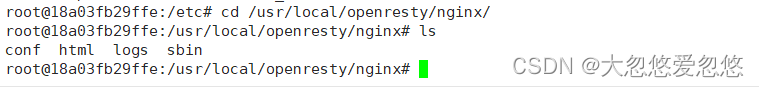

- 容器中的配置文件位置如下,这里需要将容器内文件夹拷贝到宿主机中,因为宿主机目录一定会覆盖,或者清空容器中的目录

docker cp 477:/usr/local/openresty/nginx ./

docker cp 477:/etc/nginx/conf.d ./

- docker-compose安装

version: "3.3"

services:

nginx-proxy:

container_name: "nginx-proxy"

image: "nginx"

ports:

- "80:80"

- "433:433"

volumes:

- "${PWD}/nginx-proxy/html:/etc/nginx/html"

- "${PWD}/nginx-proxy/conf.d:/etc/nginx/conf.d"

- "${PWD}/nginx-proxy/ssl:/etc/nginx/ssl"

- "${PWD}/nginx-proxy/log:/var/log/nginx"

- "${PWD}/nginx-proxy/nginx.conf:/etc/nginx/nginx.conf"

privileged: true

restart: always

openresty:

container_name: "openresty"

image: "openresty/openresty"

ports:

- "8081:8081"

volumes:

- "${PWD}/openresty/conf.d:/etc/nginx/conf.d"

- "${PWD}/openresty/nginx:/usr/local/openresty/nginx"

privileged: true

restart: always

启动即可

docker-compose up -d

OpenResty快速入门

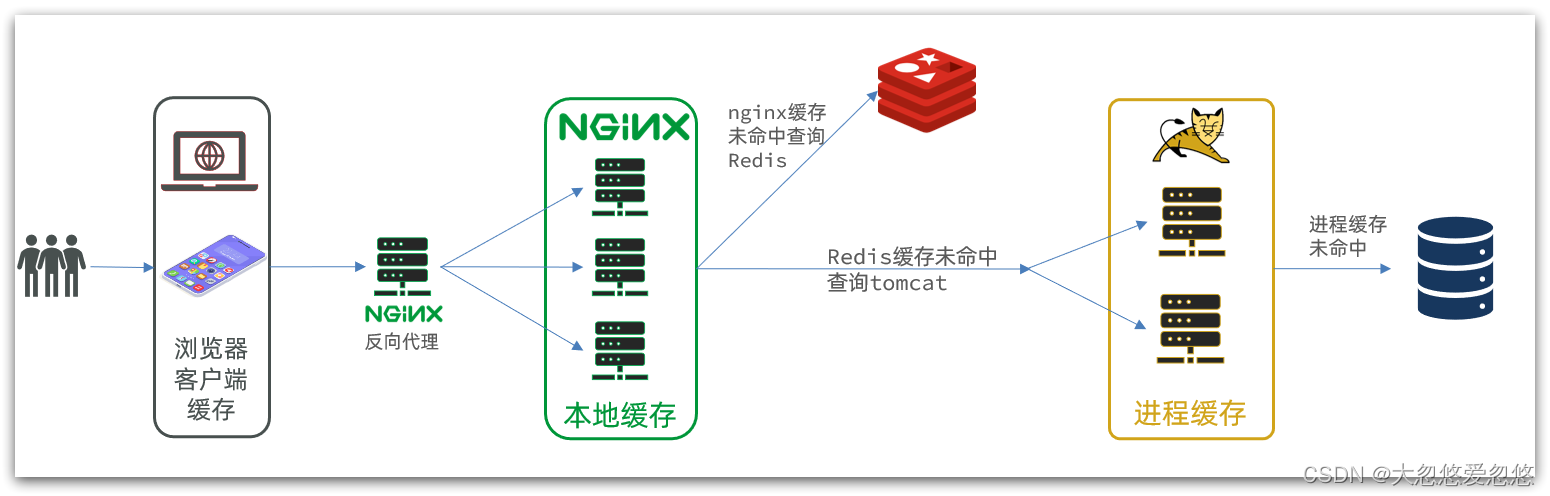

我们希望达到的多级缓存架构如图:

其中:

-

第一台nginx用来做反向代理服务,将前端的查询商品的ajax请求代理到OpenResty集群

-

OpenResty集群用来编写多级缓存业务

反向代理流程

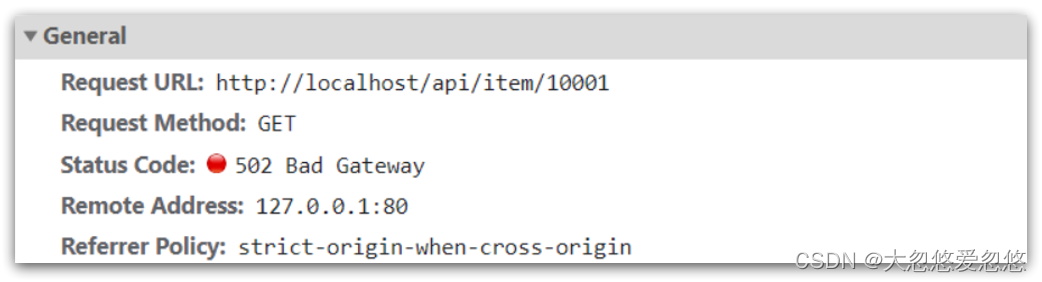

现在,商品详情页使用的是假的商品数据。不过在浏览器中,可以看到页面有发起ajax请求查询真实商品数据。

这个请求如下:

请求地址是localhost,端口是80,就被Nginx服务给接收到了。然后代理给了OpenResty集群:

我们需要在OpenResty中编写业务,查询商品数据并返回到浏览器。

但是这次,我们先在OpenResty接收请求,返回假的商品数据。

OpenResty监听请求

监听/api/item路径

修改/usr/local/openresty/nginx/conf/nginx.conf文件,在nginx.conf的server下面,添加对/api/item这个路径的监听:

location /api/item {

# 默认的响应类型

default_type application/json;

# 响应结果由lua/item.lua文件来决定

content_by_lua_file lua/item.lua;

}

这个监听,就类似于SpringMVC中的@GetMapping("/api/item")做路径映射。

而content_by_lua_file lua/item.lua则相当于调用item.lua这个文件,执行其中的业务,把结果返回给用户。相当于java中调用service。

完整配置文件:

#user nobody;

#worker_processes 1;

# Enables the use of JIT for regular expressions to speed-up their processing.

pcre_jit on;

#error_log logs/error.log;

error_log /usr/local/openresty/nginx/logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

# Enables or disables the use of underscores in client request header fields.

# When the use of underscores is disabled, request header fields whose names contain underscores are marked as invalid and become subject to the ignore_invalid_headers directive.

# underscores_in_headers off;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /usr/local/openresty/nginx/logs/access.log main;

server {

listen 8081;

server_name 110.40.155.17;

location /api/item {

# 默认的响应类型

default_type application/json;

# 响应结果由lua/item.lua文件来决定

content_by_lua_file lua/item.lua;

}

location / {

root /usr/local/openresty/nginx/html;

index index.html index.htm;

}

# error_page 404 /404.html;

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/local/openresty/nginx/html;

}

}

# See Move default writable paths to a dedicated directory (#119)

# https://github.com/openresty/docker-openresty/issues/119

client_body_temp_path /var/run/openresty/nginx-client-body;

proxy_temp_path /var/run/openresty/nginx-proxy;

fastcgi_temp_path /var/run/openresty/nginx-fastcgi;

uwsgi_temp_path /var/run/openresty/nginx-uwsgi;

scgi_temp_path /var/run/openresty/nginx-scgi;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

#include /etc/nginx/conf.d/*.conf;

}

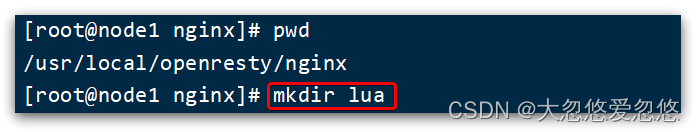

编写item.lua

1)在/usr/loca/openresty/nginx目录创建文件夹:lua

2)在/usr/loca/openresty/nginx/lua文件夹下,新建文件:item.lua

3)编写item.lua,返回假数据

item.lua中,利用ngx.say()函数返回数据到Response中

ngx.say('{"id":10001,"name":"SALSA AIR","title":"RIMOWA 21寸托运箱拉杆箱 SALSA AIR系列果绿色 820.70.36.4","price":17900,"image":"https://m.360buyimg.com/mobilecms/s720x720_jfs/t6934/364/1195375010/84676/e9f2c55f/597ece38N0ddcbc77.jpg!q70.jpg.webp","category":"拉杆箱","brand":"RIMOWA","spec":"","status":1,"createTime":"2019-04-30T16:00:00.000+00:00","updateTime":"2019-04-30T16:00:00.000+00:00","stock":2999,"sold":31290}')

4)重新加载配置

docker-compose exec openresty nginx -s reload

刷新商品页面:http://服务器地址/item.html?id=1001,即可看到效果:

请求参数处理

上面,我们在OpenResty接收前端请求,但是返回的是假数据。

要返回真实数据,必须根据前端传递来的商品id,查询商品信息才可以。

那么如何获取前端传递的商品参数呢?

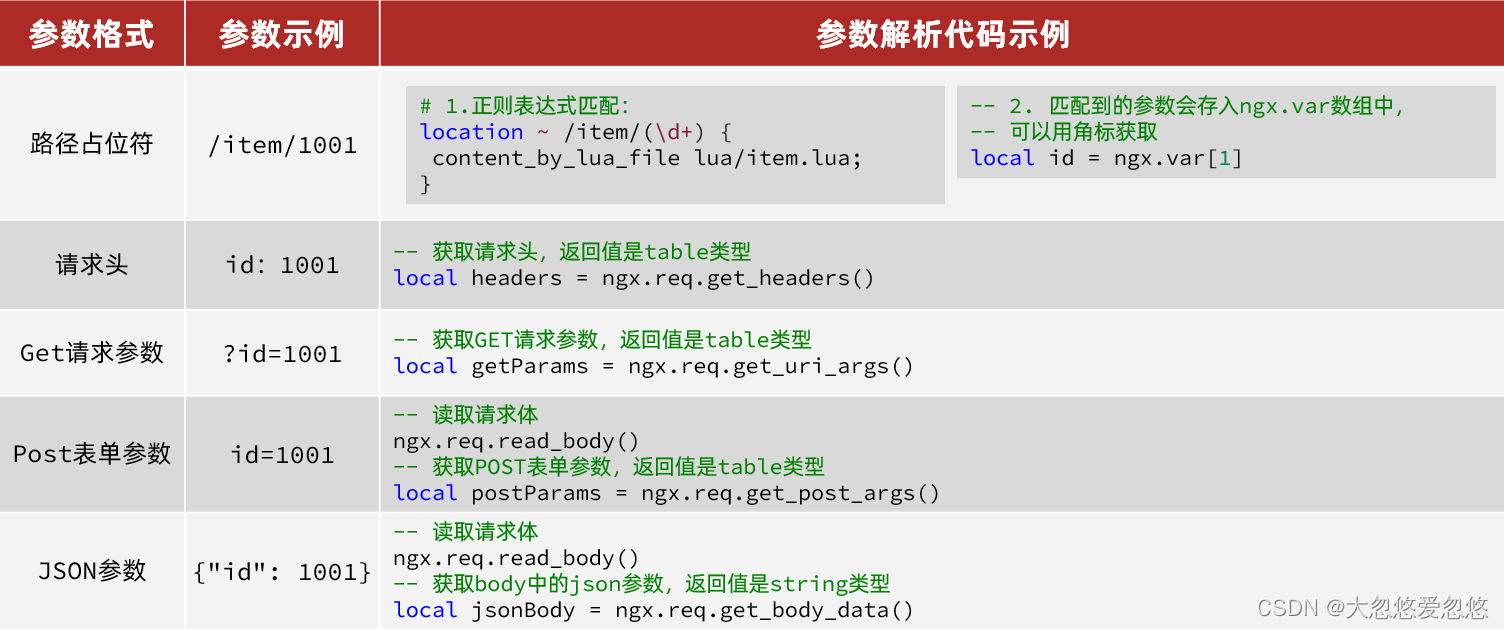

获取参数的API

OpenResty中提供了一些API用来获取不同类型的前端请求参数:

获取参数并返回

在前端发起的ajax请求如图:

可以看到商品id是以路径占位符方式传递的,因此可以利用正则表达式匹配的方式来获取ID

1)获取商品id

修改/usr/loca/openresty/nginx/nginx.conf文件中监听/api/item的代码,利用正则表达式获取ID:

location ~ /api/item/(\d+) {

# 默认的响应类型

default_type application/json;

# 响应结果由lua/item.lua文件来决定

content_by_lua_file lua/item.lua;

}

2)拼接ID并返回

修改/usr/loca/openresty/nginx/lua/item.lua文件,获取id并拼接到结果中返回:

-- 获取商品id

local id = ngx.var[1]

-- 拼接并返回

ngx.say('{"id":' .. id .. ',"name":"SALSA AIR","title":"RIMOWA 21寸托运箱拉杆箱 SALSA AIR系列果绿色 820.70.36.4","price":17900,"image":"https://m.360buyimg.com/mobilecms/s720x720_jfs/t6934/364/1195375010/84676/e9f2c55f/597ece38N0ddcbc77.jpg!q70.jpg.webp","category":"拉杆箱","brand":"RIMOWA","spec":"","status":1,"createTime":"2019-04-30T16:00:00.000+00:00","updateTime":"2019-04-30T16:00:00.000+00:00","stock":2999,"sold":31290}')

3)重新加载并测试

运行命令以重新加载OpenResty配置:

docker-compose up -d

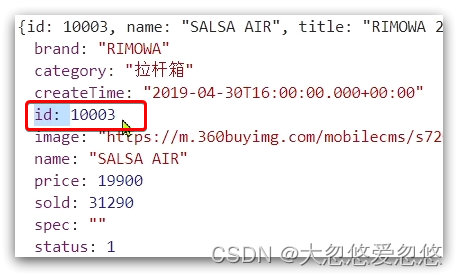

刷新页面可以看到结果中已经带上了ID:

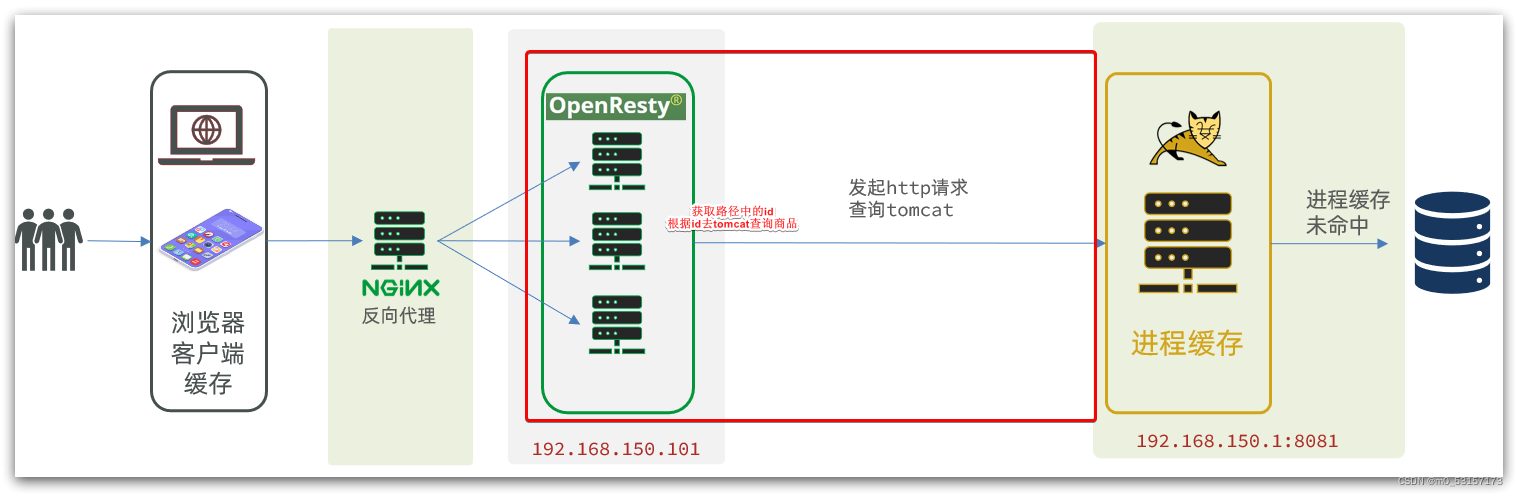

查询Tomcat

拿到商品ID后,本应去缓存中查询商品信息,不过目前我们还未建立nginx、redis缓存。因此,这里我们先根据商品id去tomcat查询商品信息。我们实现如图部分:

发送http请求的API

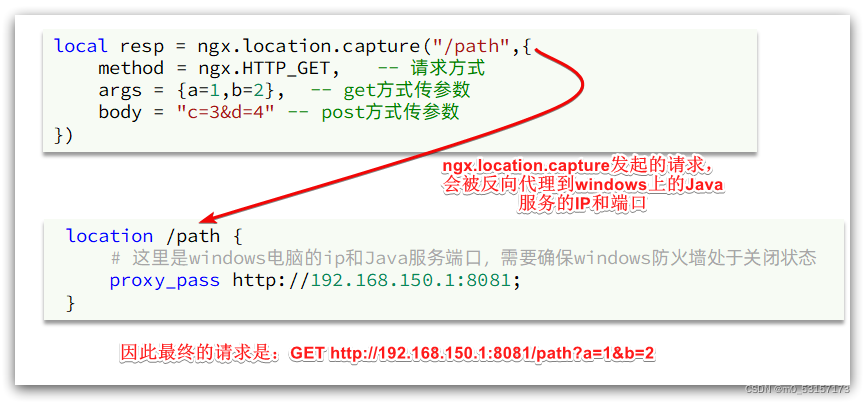

nginx提供了内部API用以发送http请求:

local resp = ngx.location.capture("/path",{

method = ngx.HTTP_GET, -- 请求方式

args = {a=1,b=2}, -- get方式传参数

})

返回的响应内容包括:

- resp.status:响应状态码

- resp.header:响应头,是一个table

- resp.body:响应体,就是响应数据

注意:这里的path是路径,并不包含IP和端口。这个请求会被nginx内部的server监听并处理。

但是我们希望这个请求发送到Tomcat服务器,所以还需要编写一个server来对这个路径做反向代理:

location /path {

proxy_pass http://192.168.150.1:8081;

}

原理如图:

封装http工具

下面,我们封装一个发送Http请求的工具,基于ngx.location.capture来实现查询tomcat。

1)添加反向代理,将nginx拦截到的请求代理到tomcat

因为item-service中的接口都是/item开头,所以我们监听/item路径,代理到tomcat服务。

修改 /usr/local/openresty/nginx/conf/nginx.conf文件,添加一个location:

location /item {

proxy_pass http://192.168.150.1:8081;

}

以后,只要我们调用ngx.location.capture("/item"),就一定能发送请求到windows的tomcat服务。

2)封装工具类

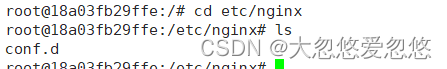

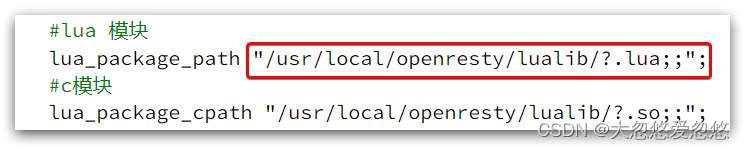

之前我们说过,OpenResty启动时会加载以下两个目录中的工具文件:

所以,自定义的http工具也需要放到这个目录下。

在/usr/local/openresty/lualib目录下,新建一个common.lua文件:

vi /usr/local/openresty/lualib/common.lua

这里需要先将openresty中的lualib目录拷贝一份到宿主机中:

docker cp openresty:'/usr/local/openresty/lualib' ./openresty/

修改docker-compose.yml文件,添加对lualib目录的映射:

version: "3.3"

services:

nginx-proxy:

container_name: "nginx-proxy"

image: "nginx"

ports:

- "80:80"

- "433:433"

environment:

TZ: Asia/Shanghai

volumes:

- "${PWD}/nginx-proxy/html:/etc/nginx/html"

- "${PWD}/nginx-proxy/conf.d:/etc/nginx/conf.d"

- "${PWD}/nginx-proxy/ssl:/etc/nginx/ssl"

- "${PWD}/nginx-proxy/log:/var/log/nginx"

- "${PWD}/nginx-proxy/nginx.conf:/etc/nginx/nginx.conf"

privileged: true

restart: always

openresty:

container_name: "openresty"

image: "openresty/openresty"

ports:

- "8081:8081"

environment:

TZ: Asia/Shanghai

volumes:

- "${PWD}/openresty/conf.d:/etc/nginx/conf.d"

- "${PWD}/openresty/nginx:/usr/local/openresty/nginx"

- "${PWD}/openresty/lualib:/usr/local/openresty/lualib"

privileged: true

restart: always

${PWD}/openresty/lualib目录下,添加一个common.lua,内容如下:

--封装函数,发送http请求,并解析响应

local function read_http(path,params)

local resp=ngx.location.capture(

--发送的请求路径

path,{

--使用的请求方式

method =ngx.HTTP_GET,

--请求参数

args=params

})

if not resp then

--记录错误信息,返回404

ngx.log(ngx.ERR,'http请求查询失败,path: ',path,', args: ',args)

ngx.exit(404)

end

--返回请求体

return resp.body

end

--导出方法

local _M={

read_http=read_http

}

return _M

1 使用function声明的函数为全局函数,在被引用时可以不会因为声明的顺序而找不到

2 使用local function声明的函数为局部函数,在引用的时候必须要在声明的函数后面

这个工具将read_http函数封装到_M这个table类型的变量中,并且返回,这类似于导出。

使用的时候,可以利用require('common')来导入该函数库,这里的common是函数库的文件名。

3)实现商品查询

最后,我们修改/usr/local/openresty/lua/item.lua文件,利用刚刚封装的函数库实现对tomcat的查询:

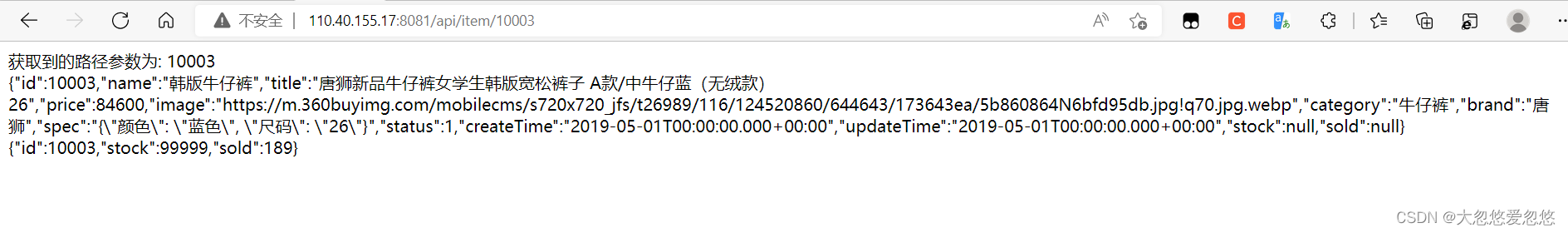

--引入自定义common工具模块,返回值是common中返回的_M

local common=require('common')

--从common中获取read_http这个函数

local read_http=common.read_http

--获取路径参数

local id=ngx.var[1]

ngx.say('获取到的路径参数为: '..id..'</br>')

--根据id查询商品

local itemJSON=read_http("/item/"..id,nil)

ngx.say(itemJSON..'</br>')

--根据id查询商品库存

local itemStockJSON=read_http("/item/stock/"..id,nil)

--输出

ngx.say(itemStockJSON..'</br>')

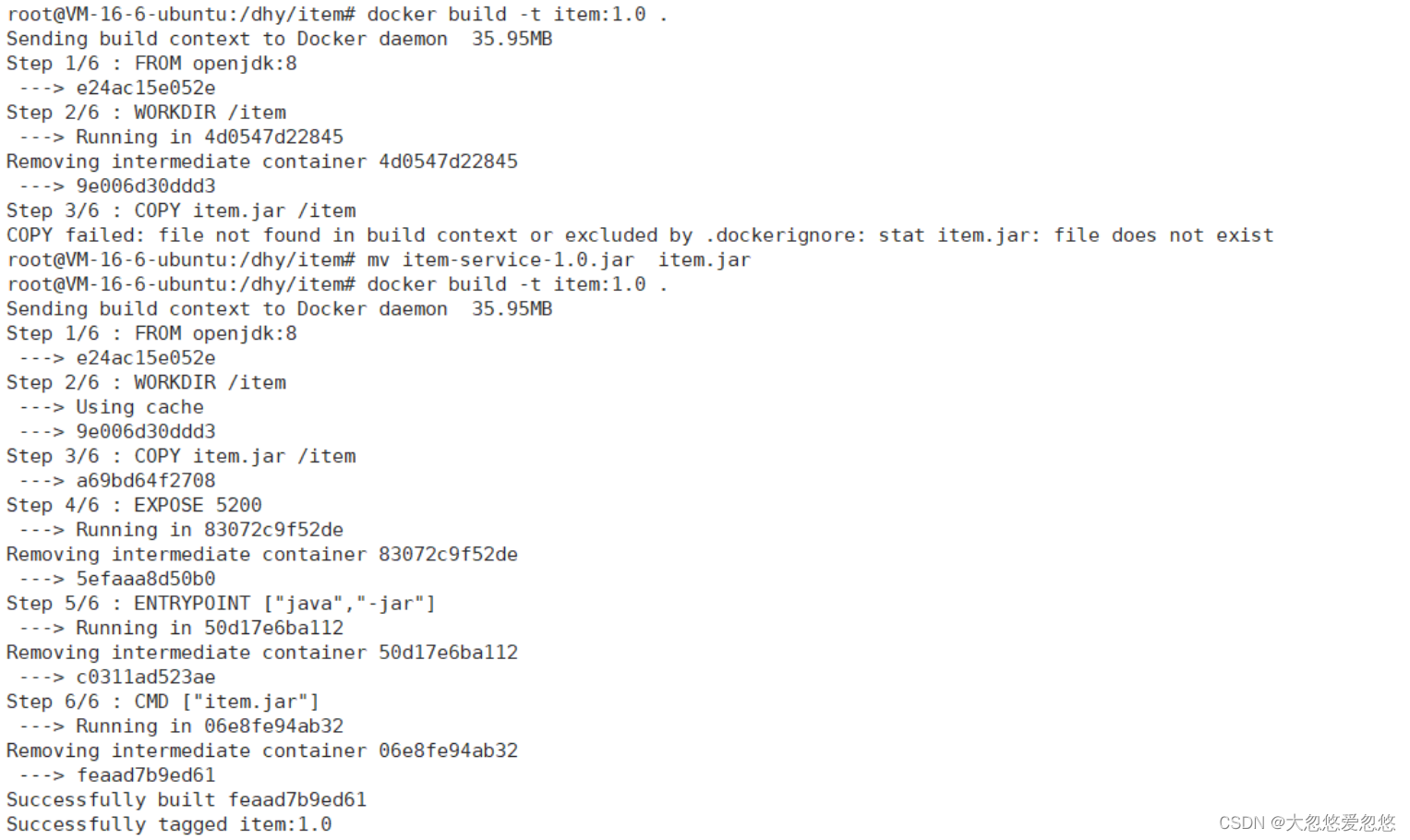

利用Dockefile部署springboot项目

- 编写Dockerfile

FROM openjdk:8

WORKDIR /item

#赋值上下文环境中的item.jar到镜像层

COPY item.jar /item

EXPOSE 5200

#不能后台启动,否则docker容器直接就停止了

ENTRYPOINT ["java","-jar"]

CMD ["item.jar"]

- 构建镜像

- 运行容器

docker run -p 5200:5200 --name item -d item:1.0

测试

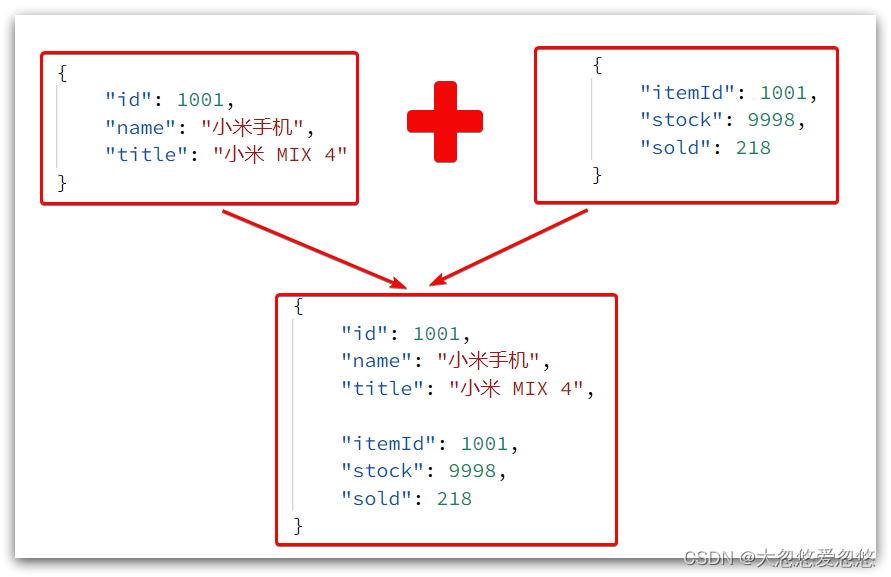

这里查询到的结果是json字符串,并且包含商品、库存两个json字符串,页面最终需要的是把两个json拼接为一个json:

这就需要我们先把JSON变为lua的table,完成数据整合后,再转为JSON。

CJSON工具类

OpenResty提供了一个cjson的模块用来处理JSON的序列化和反序列化。

官方地址: https://github.com/openresty/lua-cjson/

1)引入cjson模块:

local cjson = require "cjson"

2)序列化:

local obj = {

name = 'jack',

age = 21

}

-- 把 table 序列化为 json

local json = cjson.encode(obj)

3)反序列化:

local json = '{"name": "jack", "age": 21}'

-- 反序列化 json为 table

local obj = cjson.decode(json);

print(obj.name)

实现Tomcat查询

下面,我们修改之前的item.lua中的业务,添加json处理功能:

--引入自定义common工具模块,返回值是common中返回的_M

local common=require('common')

--从common中获取read_http这个函数

local read_http=common.read_http

--导入cjson库

local cjson=require('cjson')

--获取路径参数

local id=ngx.var[1]

--根据id查询商品

local itemJSON=read_http("/item/"..id,nil)

--根据id查询商品库存

local itemStockJSON=read_http("/item/stock/"..id,nil)

--JSON转换为Lua的table

local item=cjson.decode(itemJSON)

local stock = cjson.decode(itemStockJSON)

--组合数据

item.stock=stock.stock

item.sold=stock.sold

--把item序列化为json返回结果

ngx.say(cjson.encode(item))

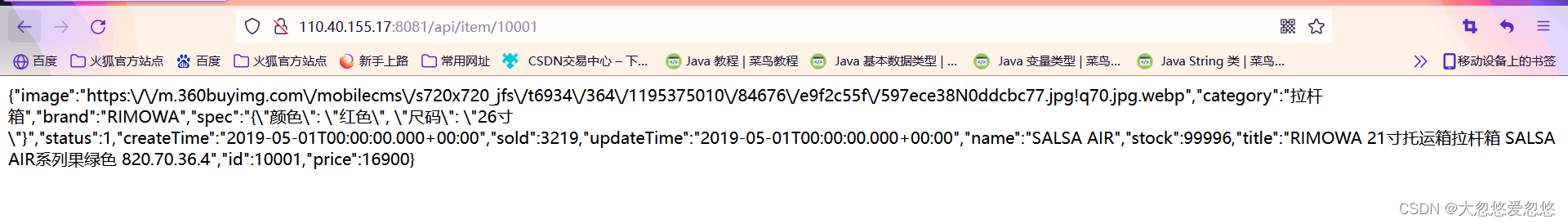

测试:

基于ID负载均衡

刚才的代码中,我们的tomcat是单机部署。而实际开发中,tomcat一定是集群模式:

因此,OpenResty需要对tomcat集群做负载均衡。

而默认的负载均衡规则是轮询模式,当我们查询/item/10001时:

- 第一次会访问8081端口的tomcat服务,在该服务内部就形成了JVM进程缓存

- 第二次会访问8082端口的tomcat服务,该服务内部没有JVM缓存(因为JVM缓存无法共享),会查询数据库

- …

你看,因为轮询的原因,第一次查询8081形成的JVM缓存并未生效,直到下一次再次访问到8081时才可以生效,缓存命中率太低了。

怎么办?

如果能让同一个商品,每次查询时都访问同一个tomcat服务,那么JVM缓存就一定能生效了。

也就是说,我们需要根据商品id做负载均衡,而不是轮询。

1)原理

nginx提供了基于请求路径做负载均衡的算法:

nginx根据请求路径做hash运算,把得到的数值对tomcat服务的数量取余,余数是几,就访问第几个服务,实现负载均衡。

例如:

- 我们的请求路径是 /item/10001

- tomcat总数为2台(8081、8082)

- 对请求路径/item/1001做hash运算求余的结果为1

- 则访问第一个tomcat服务,也就是8081

只要id不变,每次hash运算结果也不会变,那就可以保证同一个商品,一直访问同一个tomcat服务,确保JVM缓存生效。

2)实现

修改/usr/local/openresty/nginx/conf/nginx.conf文件,实现基于ID做负载均衡。

首先,定义tomcat集群,并设置基于路径做负载均衡:

upstream tomcat-cluster {

hash $request_uri;

server 192.168.150.1:5200;

server 192.168.150.1:5201;

}

然后,修改对tomcat服务的反向代理,目标指向tomcat集群:

location /item {

proxy_pass http://tomcat-cluster;

}

通过上面构建的项目镜像,再运行一份实例:

docker run -p 5201:5200 --name item1 -d item:1.0

重新加载OpenResty

docker-compose openresty nginx -s reload

测试这里就不演示了

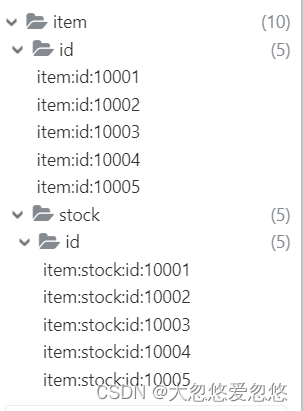

Redis缓存预热

Redis缓存会面临冷启动问题:

冷启动:服务刚刚启动时,Redis中并没有缓存,如果所有商品数据都在第一次查询时添加缓存,可能会给数据库带来较大压力。

缓存预热:在实际开发中,我们可以利用大数据统计用户访问的热点数据,在项目启动时将这些热点数据提前查询并保存到Redis中。

我们数据量较少,并且没有数据统计相关功能,目前可以在启动时将所有数据都放入缓存中。

1)在item-service服务中引入Redis依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

2)配置Redis地址

spring:

redis:

host: 192.168.150.101

port: 6380

4)编写初始化类

缓存预热需要在项目启动时完成,并且必须是拿到RedisTemplate之后。

这里我们利用InitializingBean接口来实现,因为InitializingBean可以在对象被Spring创建并且成员变量全部注入后执行。

@Component

public class RedisHandler implements InitializingBean {

@Autowired

private StringRedisTemplate redisTemplate;

@Autowired

private IItemService itemService;

@Autowired

private IItemStockService stockService;

private static final ObjectMapper MAPPER = new ObjectMapper();

@Override

public void afterPropertiesSet() throws Exception {

// 初始化缓存

// 1.查询商品信息

List<Item> itemList = itemService.list();

// 2.放入缓存

for (Item item : itemList) {

// 2.1.item序列化为JSON

String json = MAPPER.writeValueAsString(item);

// 2.2.存入redis

redisTemplate.opsForValue().set("item:id:" + item.getId(), json);

}

// 3.查询商品库存信息

List<ItemStock> stockList = stockService.list();

// 4.放入缓存

for (ItemStock stock : stockList) {

// 2.1.item序列化为JSON

String json = MAPPER.writeValueAsString(stock);

// 2.2.存入redis

redisTemplate.opsForValue().set("item:stock:id:" + stock.getId(), json);

}

}

}

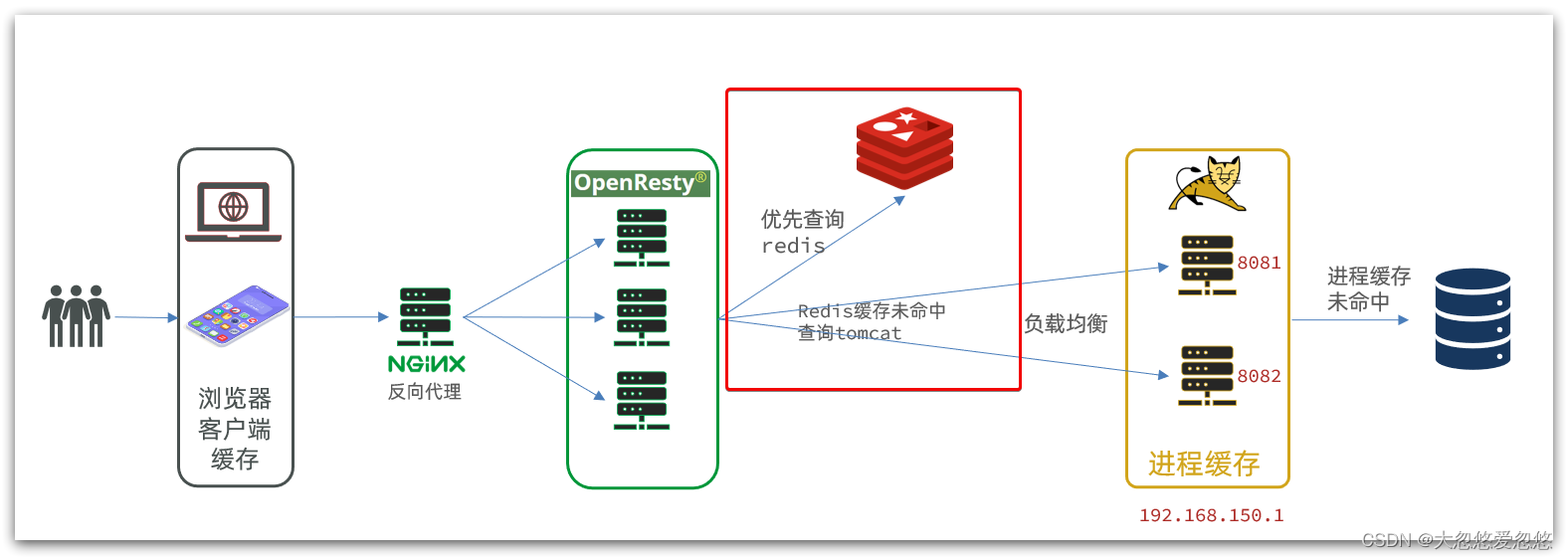

查询Redis缓存

现在,Redis缓存已经准备就绪,我们可以再OpenResty中实现查询Redis的逻辑了。如下图红框所示:

当请求进入OpenResty之后:

- 优先查询Redis缓存

- 如果Redis缓存未命中,再查询Tomcat

封装Redis工具

OpenResty提供了操作Redis的模块,我们只要引入该模块就能直接使用。但是为了方便,我们将Redis操作封装到之前的common.lua工具库中。

修改/usr/local/openresty/lualib/common.lua文件:

1)引入Redis模块,并初始化Redis对象

-- 导入redis

local redis = require('resty.redis')

-- 初始化redis

local red = redis:new()

--建立连接的超时时间,发送请求的超时时间,响应结果的超时时间

red:set_timeouts(1000, 1000, 1000)

2)封装函数,用来释放Redis连接,其实是放入连接池

-- 关闭redis连接的工具方法,其实是放入连接池

local function close_redis(red)

local pool_max_idle_time = 10000 -- 连接的空闲时间,单位是毫秒

local pool_size = 100 --连接池大小

local ok, err = red:set_keepalive(pool_max_idle_time, pool_size)

if not ok then

ngx.log(ngx.ERR, "放入redis连接池失败: ", err)

end

end

3)封装函数,根据key查询Redis数据

-- 查询redis的方法 ip和port是redis地址,key是查询的key

local function read_redis(ip, port, key)

-- 获取一个连接

local ok, err = red:connect(ip, port)

if not ok then

ngx.log(ngx.ERR, "连接redis失败 : ", err)

return nil

end

-- 查询redis

local resp, err = red:get(key)

-- 查询失败处理

if not resp then

ngx.log(ngx.ERR, "查询Redis失败: ", err, ", key = " , key)

end

--得到的数据为空处理

if resp == ngx.null then

resp = nil

ngx.log(ngx.ERR, "查询Redis数据为空, key = ", key)

end

close_redis(red)

return resp

end

4)导出

-- 将方法导出

local _M = {

read_http = read_http,

read_redis = read_redis

}

return _M

完整的common.lua:

-- 导入redis

local redis = require('resty.redis')

-- 初始化redis

local red = redis:new()

--建立连接的超时时间,发送请求的超时时间,响应结果的超时时间

red:set_timeouts(1000, 1000, 1000)

-- 关闭redis连接的工具方法,其实是放入连接池

local function close_redis(red)

local pool_max_idle_time = 10000 -- 连接的空闲时间,单位是毫秒

local pool_size = 100 --连接池大小

local ok, err = red:set_keepalive(pool_max_idle_time, pool_size)

if not ok then

ngx.log(ngx.ERR, "放入redis连接池失败: ", err)

end

end

-- 查询redis的方法 ip和port是redis地址,key是查询的key

local function read_redis(ip, port, key)

-- 获取一个连接

local ok, err = red:connect(ip, port)

if not ok then

ngx.log(ngx.ERR, "连接redis失败 : ", err)

return nil

end

-- 查询redis

local resp, err = red:get(key)

-- 查询失败处理

if not resp then

ngx.log(ngx.ERR, "查询Redis失败: ", err, ", key = " , key)

end

--得到的数据为空处理

if resp == ngx.null then

resp = nil

ngx.log(ngx.ERR, "查询Redis数据为空, key = ", key)

end

close_redis(red)

return resp

end

-- 封装函数,发送http请求,并解析响应

local function read_http(path, params)

local resp = ngx.location.capture(path,{

method = ngx.HTTP_GET,

args = params,

})

if not resp then

-- 记录错误信息,返回404

ngx.log(ngx.ERR, "http查询失败, path: ", path , ", args: ", args)

ngx.exit(404)

end

return resp.body

end

-- 将方法导出

local _M = {

read_http = read_http,

read_redis = read_redis

}

return _M

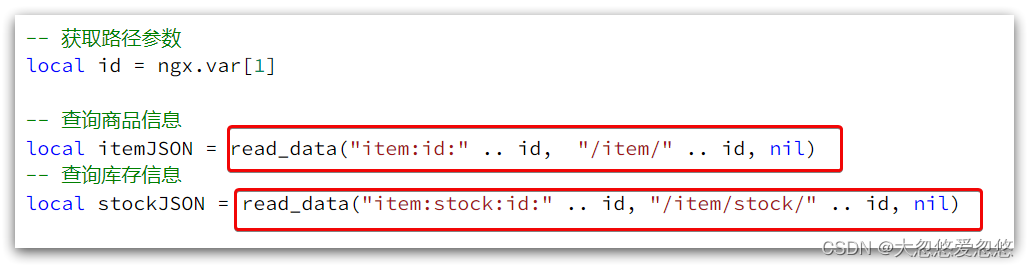

实现Redis查询

接下来,我们就可以去修改item.lua文件,实现对Redis的查询了。

查询逻辑是:

- 根据id查询Redis

- 如果查询失败则继续查询Tomcat

- 将查询结果返回

1)修改/usr/local/openresty/lua/item.lua文件,添加一个查询函数:

-- 导入common函数库

local common = require('common')

local read_http = common.read_http

local read_redis = common.read_redis

-- 封装查询函数

function read_data(key, path, params)

-- 查询本地缓存

local val = read_redis("127.0.0.1", 6379, key)

-- 判断查询结果

if not val then

ngx.log(ngx.ERR, "redis查询失败,尝试查询http, key: ", key)

-- redis查询失败,去查询http

val = read_http(path, params)

end

-- 返回数据

return val

end

2)而后修改商品查询、库存查询的业务:

--引入自定义common工具模块,返回值是common中返回的_M

local common=require('common')

local read_http=common.read_http

local read_redis=common.read_redis

-- 封装查询函数

function read_data(key, path, params)

-- 查询本地缓存

local val = read_redis("110.40.155.17", 6380, key)

-- 判断查询结果

if not val then

ngx.log(ngx.ERR, "redis查询失败,尝试查询http, key: ", key)

-- redis查询失败,去查询http

val = read_http(path, params)

end

-- 返回数据

return val

end

--导入cjson库

local cjson=require('cjson')

--获取路径参数

local id=ngx.var[1]

--根据id查询商品

local itemJSON=read_data("item:id:"..id,"/item/"..id,nil)

--根据id查询商品库存

local itemStockJSON=read_data("item:stock:id:" .. id,"/item/stock/"..id,nil)

--JSON转换为Lua的table

local item=cjson.decode(itemJSON)

local stock = cjson.decode(itemStockJSON)

--组合数据

item.stock=stock.stock

item.sold=stock.sold

--把item序列化为json返回结果

ngx.say(cjson.encode(item))

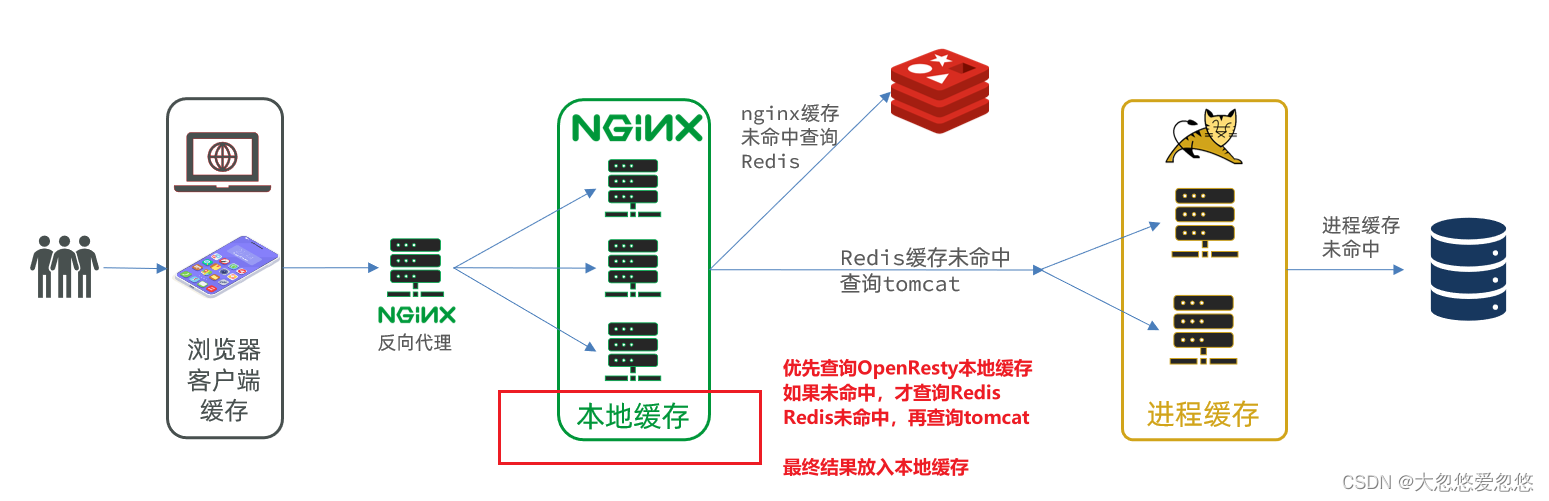

Nginx本地缓存

现在,整个多级缓存中只差最后一环,也就是nginx的本地缓存了。如图:

本地缓存API

OpenResty为Nginx提供了shard dict的功能,可以在nginx的多个worker之间共享数据,实现缓存功能。

1)开启共享字典,在nginx.conf的http下添加配置:

# 共享字典,也就是本地缓存,名称叫做:item_cache,大小150m

lua_shared_dict item_cache 150m;

2)操作共享字典:

-- 获取本地缓存对象

local item_cache = ngx.shared.item_cache

-- 存储, 指定key、value、过期时间,单位s,默认为0代表永不过期

item_cache:set('key', 'value', 1000)

-- 读取

local val = item_cache:get('key')

如果想要增删查改openresty缓存中的内容,更多可以查看下面这篇文章:

实现本地缓存查询

1)修改/usr/local/openresty/lua/item.lua文件,修改read_data查询函数,添加本地缓存逻辑:

-- 导入共享词典,本地缓存

local item_cache = ngx.shared.item_cache

-- 封装查询函数

function read_data(key, expire, path, params)

-- 查询本地缓存

local val = item_cache:get(key)

if not val then

ngx.log(ngx.ERR, "本地缓存查询失败,尝试查询Redis, key: ", key)

-- 查询redis

val = read_redis("127.0.0.1", 6379, key)

-- 判断查询结果

if not val then

ngx.log(ngx.ERR, "redis查询失败,尝试查询http, key: ", key)

-- redis查询失败,去查询http

val = read_http(path, params)

end

end

-- 查询成功,把数据写入本地缓存

item_cache:set(key, val, expire)

-- 返回数据

return val

end

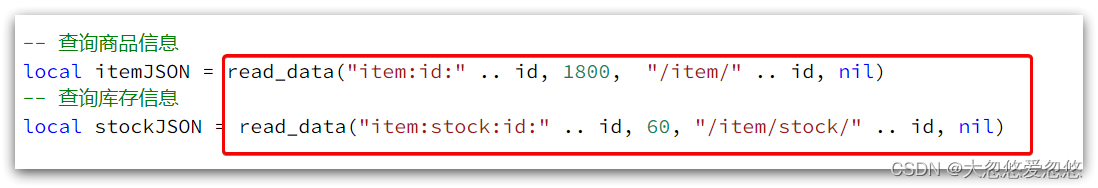

2)修改item.lua中查询商品和库存的业务,实现最新的read_data函数:

其实就是多了缓存时间参数,过期后nginx缓存会自动删除,下次访问即可更新缓存。

这里给商品基本信息设置超时时间为30分钟,库存为1分钟。

因为库存更新频率较高,如果缓存时间过长,可能与数据库差异较大。

3)完整的item.lua文件:

--引入自定义common工具模块,返回值是common中返回的_M

local common=require('common')

local read_http=common.read_http

local read_redis=common.read_redis

-- 导入共享词典,本地缓存

local item_cache = ngx.shared.item_cache

-- 封装查询函数

function read_data(key,expire,path, params)

-- 查询本地缓存

local val=item_cache:get(key)

if not val then

ngx.log(ngx.ERR,'本地缓存查询失败,尝试查询Redis, key: ',key)

val = read_redis("192.168.0.1", 6380, key)

-- 判断查询结果

if not val then

ngx.log(ngx.ERR, "redis查询失败,尝试查询http, key: ", key)

-- redis查询失败,去查询http

val = read_http(path, params)

end

end

--查询成功,数据写入本地缓存

item_cache:set(key,val,expire)

-- 返回数据

return val

end

--导入cjson库

local cjson=require('cjson')

--获取路径参数

local id=ngx.var[1]

--根据id查询商品

local itemJSON=read_data("item:id:"..id,1800,"/item/"..id,nil)

--根据id查询商品库存

local itemStockJSON=read_data("item:stock:id:" .. id,60,"/item/stock/"..id,nil)

--JSON转换为Lua的table

local item=cjson.decode(itemJSON)

local stock = cjson.decode(itemStockJSON)

--组合数据

item.stock=stock.stock

item.sold=stock.sold

--把item序列化为json返回结果

ngx.say(cjson.encode(item))

OpenResty小结

想要了解更多OpenResty的内容,可以查看下面的资料: