本文内容来自 张涛的《从零开始学Scrapy网络爬虫》

1.创建项目

- 首先创建一个项目,项目名为QQMusic

scrapy startproject QQMusic

2.使用Item封装数据

- 打开项目QQMusic中的items.py源文件。添加榜单歌曲字段,实现代码如下:

import scrapy

class QqmusicItem(scrapy.Item):

song_name = scrapy.Field()

album_name = scrapy.Field()

singer_name = scrapy.Field()

interval = scrapy.Field()

3.创建Spider文件及Spider类

- 在Spider文件中新建music.py文件。在music.py中定义MusicSpider类,实现爬虫功能,代码如下:

from scrapy import Request

import sys

sys.path.append('D:\\pythonProject\\scrapy\\QQMusic')

from scrapy.spiders import Spider

from QQMusic.items import QqmusicItem

import json

class MusicSpider(Spider):

name = 'music'

headers = {"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"}

def start_requests(self):

url = "https://c.y.qq.com/v8/fcg-bin/fcg_v8_toplist_cp.fcg?&topid=4"

yield Request(url,headers=self.headers)

def parse(self, response):

item = QqmusicItem()

json_text = response.text

music_dict = json.loads(json_text)

for one_music in music_dict["songlist"]:

item["song_name"] = one_music["data"]["songname"]

item["album_name"] = one_music["data"]["albumname"]

item["singer_name"] = one_music["data"]["singer"][0]["name"]

item["interval"] = one_music["data"]["interval"]

yield item

- 首先要导入JSON库,用于解析JSON格式数据。

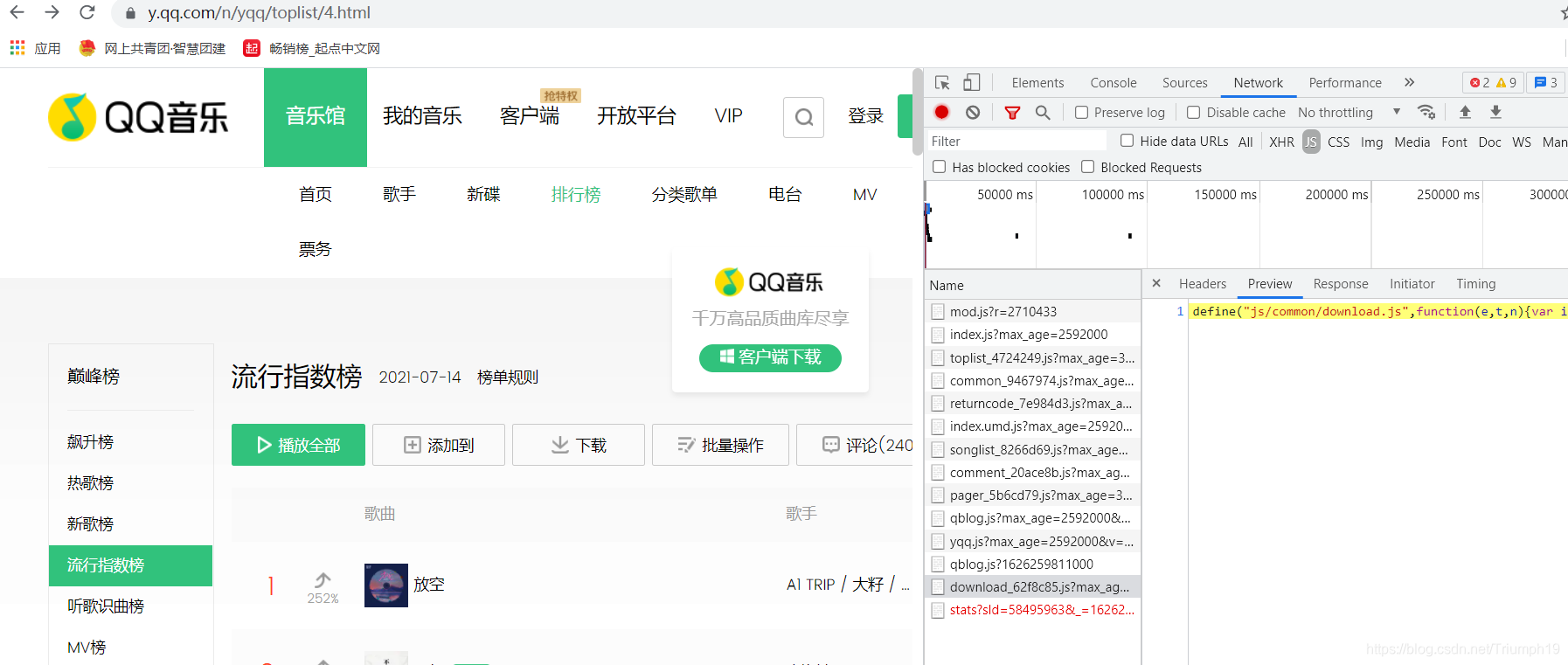

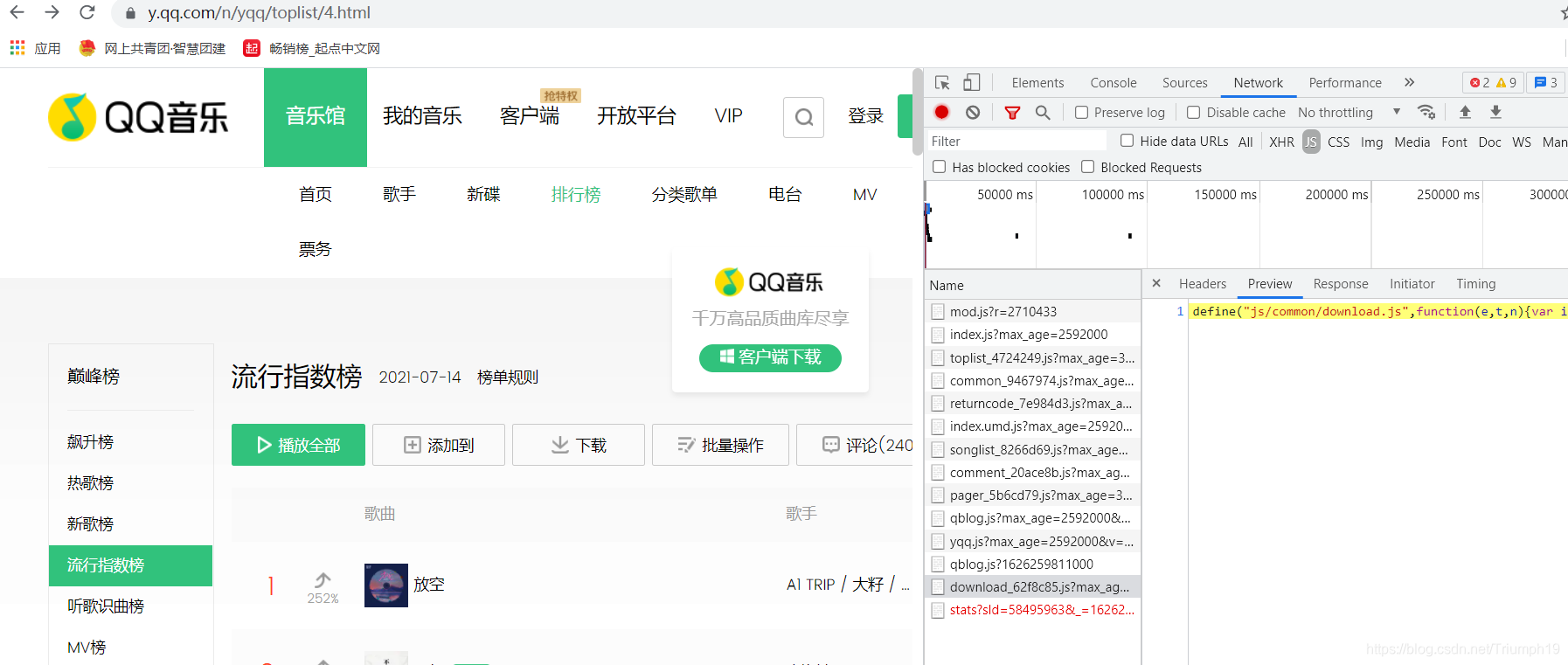

- 在start_request()方法中,url为访问服务器中fcg_v8_toplist_cp.fcg文件的地址。原文中查找改url是通过如下方法:

- 而我自己打开时没有找到fcg_v8_toplist_cp.fcg文件,不知道是哪里出了问题

- 在parse()方法中,首先生成QqmusicItem对象,用于保存结构化数据;然后使用JSON库中的load()方法解码获取到的JSON格式数据,返回Python的数据类型(这里是字典型);最后使用for循环遍历每首歌曲,将其保存在Item中。

4.运行爬虫

scrapy crawl music -o music.csv

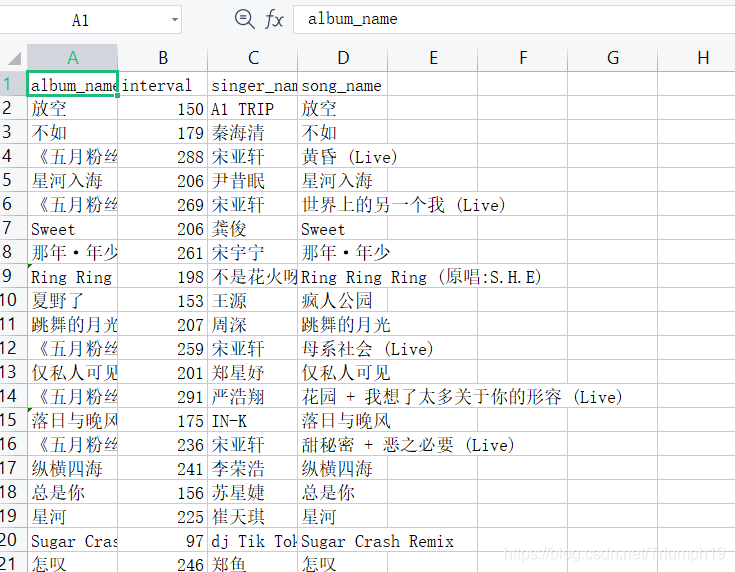

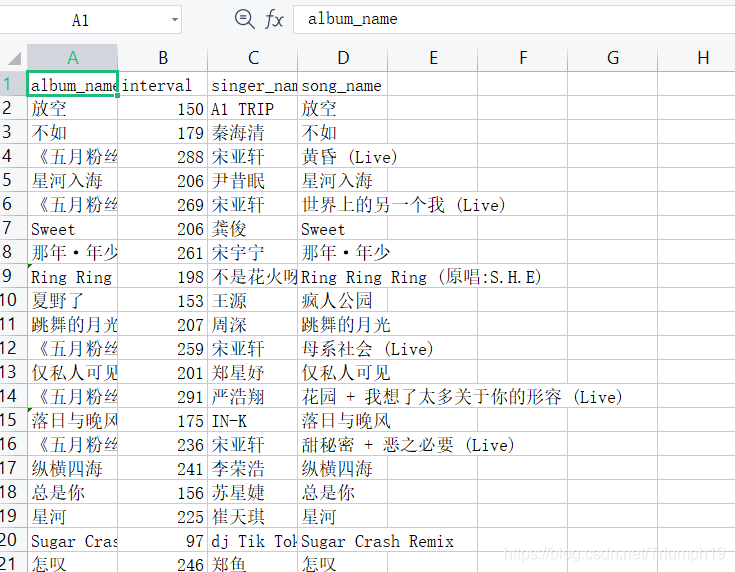

5.查看结果

|