Python爬虫、数据分析、网站开发等案例教程视频免费在线观看

https://space.bilibili.com/523606542

前言

2021年的七月,最大的瓜应该就是吴亦凡了。娱乐圈爆瓜,早已不是什么新鲜事,但吴亦凡这个瓜,尤其的大!

事情是这样的,一位叫“都美竹”的大一女孩在微博爆料,称与吴亦凡恋爱期间遭受冷暴力,并称吴亦凡存在“选妃”及“诱骗”未成年女孩的行为,随后,又有多位自称和吴亦凡有过关系牵扯的女孩纷纷晒出聊天记录,以佐证吴亦凡的行径。

刚好今天无聊,就那这位“吴先生”的微博来当做一个案例练练手了

受害者地址:https://m.weibo.cn/search?containerid=231583

目标微博

50多万的转发,100万的评论,1700万的点赞,依然是牛的

不知为何,看到网友的评论就想笑

废话不多说,开始撸代码

完整源码加Python学习交流群:1039649593找管理员免费获取

开发环境:

- 解释器: Python 3.6.5 | Anaconda, Inc.

- 编辑器: pycharm 专业版

开始代码

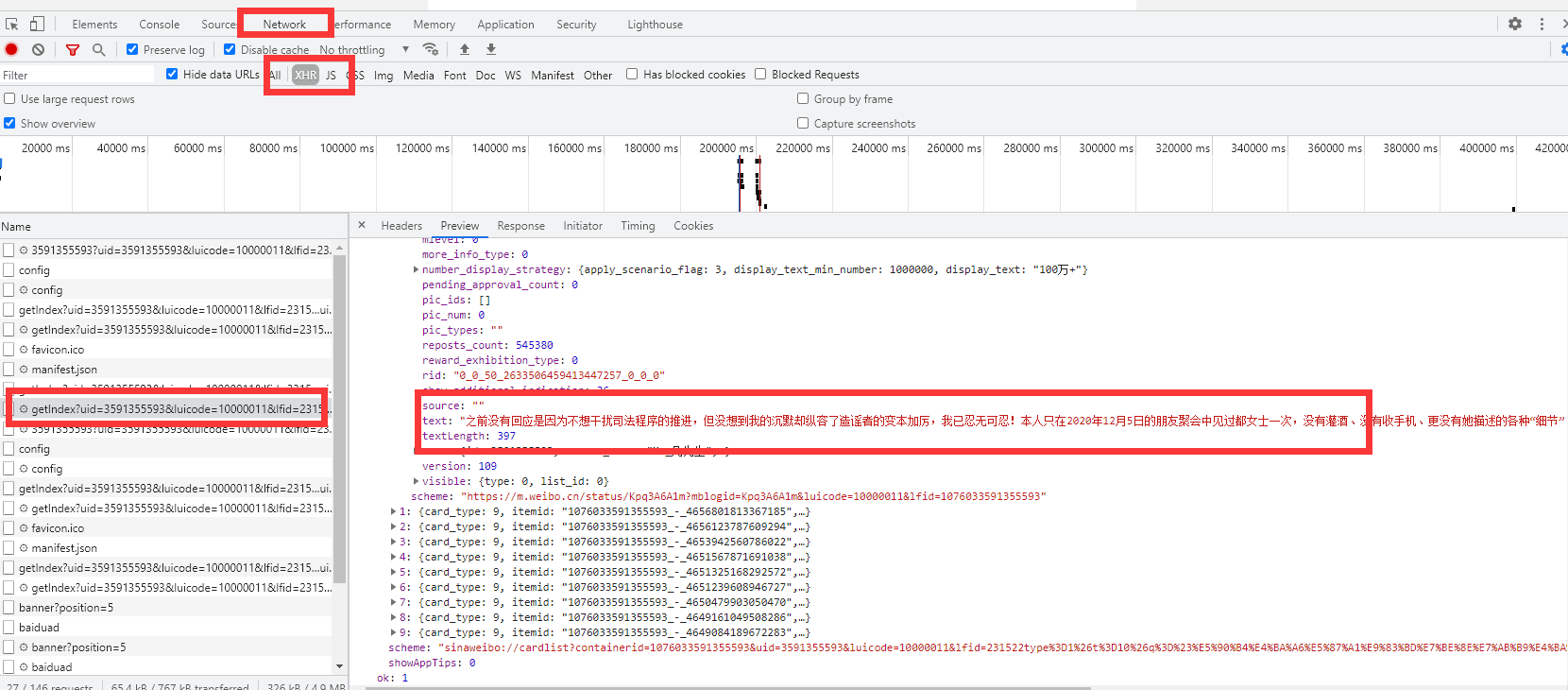

1. 找到网页数据

先F12打开开发者工具,在里面找到数据所在的位置,获取URL

请求打印一下

import requests

import pprint

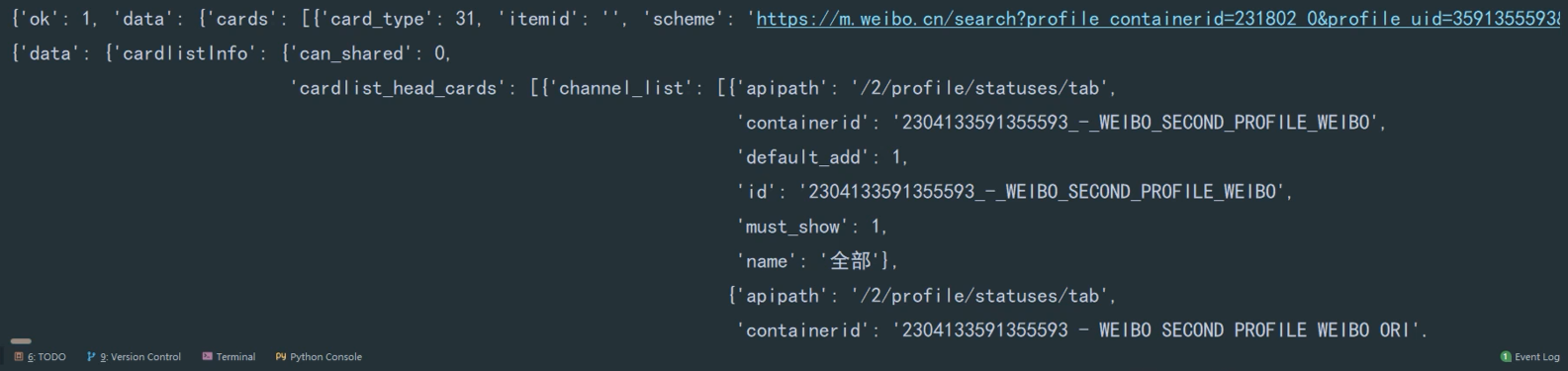

comments_url = 'https://m.weibo.cn/api/container/getIndex?containerid=2304133591355593_-_WEIBO_SECOND_PROFILE_WEIBO&luicode=10000011&lfid=2302833591355593&page_type=03&page='

response = requests.get(comments_url)

pprint.pprint( comments data)

2. 分析提取网页数据

for card in cards:

if card.get('mblog'):

m_blog = card.get('mblog')

text = m_blog.get('text')

mid = m_blog.get('mid') # 本身就是字符串不需要转化

screen_name = m_blog.get('user').get('screen_name')

print([screen_name, mid, text])

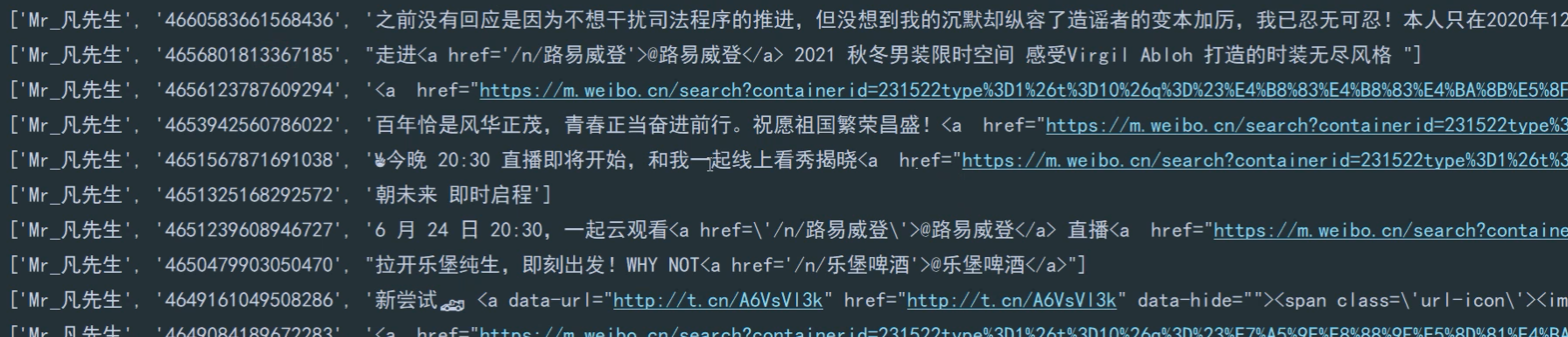

运行代码,就可以得到“吴先生”所发的微博了

3.提取热评数据

sub_comment_url = 'https://m.weibo.cn/comments/hotflow?id=' + str(mid) + '&mid=' + mid + '&max_id_type=0'

sub_response = requests.get(sub_comment_url)

sub_data = sub_response.json()

pprint.pprint(sub_data) # 获取字典里面提取数据

data_list = sub_data['data']['data']

for data in data_list:

print('data', data)

text = data['text']

mid = data['mid']

if 'more_info_users' in data:

screen_name = data['more_info_users'][0]['screen_name']

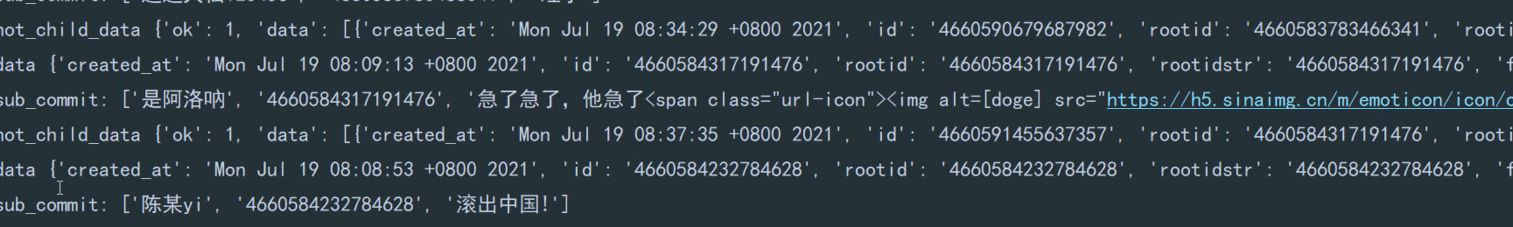

print('sub_commit:', [screen_name, mid, text])

4. 保存数据

import openpyxl

# 创建 excel 表格

workbook = openpyxl.Workbook()

# 使用一张数据表

sheet = workbook.active

workbook.save('吴先生.xlsx')

运行代码得到完整的数据