最近欲望有点强烈,想看片了。迫不及待拿出我的Python。

需求分析

- 爬取豆瓣电影分类排行榜

- 保存至本地

准备工作

安装 requests 和 pyquery 库:

快捷键 Windows+r 打开运行控制框,输入 cmd,进入命令行,输入:

pip install requests

pip install pyquery

导入:

import requests

from pyquery import PyQuery as pq

网页解析与请求

打开网址:https://movie.douban.com/chart

第一步:爬取分类关键字

我们首先要爬取电影分类的文字信息:

我们首先要发送 get 请求获得 html 源码并解析,获取分类信息。

右键,点击检查元素,调出开发者模式,我们先点击Network栏,录制我们的网络活动。刷新一下网页,可以看到这里有一个链接,就是我们这个网页的网址:

在这里找到网址和请求头,当然,请求头中有许多都是不必要的参数,我们只需要 Cookie、Referer、User-Agent 就可以了。发送请求:

url1 = 'https://movie.douban.com/chart'

headers1 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/',

'User-Agent': '...'

}

response1 = requests.get(url1, headers=headers1) # 发送请求

获取到网页源码后,点击Elements,然后点击左上角的箭头,选中分类标签,寻找该部分的html源码:

找到分类标签的位置后,用 pyquery 解析一下:

typelabels = pq(response1.text).find('.types span a') # 查找节点

typeslist = list(typelabels.items()) # 转为列表,方便之后的索引

然后我们循环遍历列表,打印出序号和关键词,并等待用户输入:

for i, n in enumerate(typeslist):

print(str(i) + ':', n.text())

choose = int(input('请选择:'))

第二步:获取分类榜单

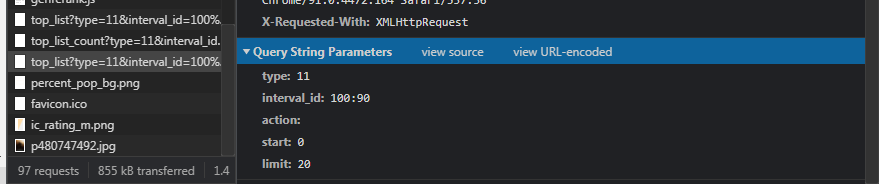

照样是点击Network栏,录制我们的网络活动。这次我们点击一个分类,进入分类界面。可以看到这里有一个链接,就是我们进行请求的网址,Preview 里有我们需要的榜单。注意这里会有两个类似的网址,注意区分:

但是请求的参数我们无法获取:

这时候要说一下,我们在发送请求时,一般地址中问号后面的可以省略,是因为问号后面的即是请求参数,我们发送 params 信息就不需要后面的参数了。params 设置发送请求时所带的参数,字典或字节流格式,作为额外参数连接到url中(问号后的部分)。既然这样,那么我们也可以反过来,在地址中放入参数,就能够省略掉 params 了。

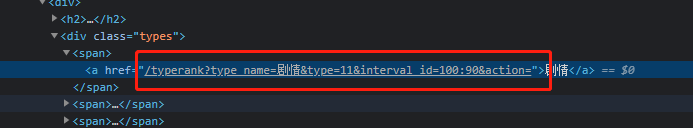

我们可以发现,在网页源代码的分类标签中,href 属性里面有链接后缀:

这时候我们只需将请求的网址'https://movie.douban.com/j/chart/top_list'和后缀除/typerank的部分连接起来,就能够得到需要的地址:

add = typeslist[choose].attr('href')

url2 = 'https://movie.douban.com/j/chart/top_list' + add.lstrip('/typerank')

#'https://movie.douban.com/j/chart/top_list?type_name=剧情&type=11&interval_id=100:90&action='

最后发送 get 请求,获取榜单信息,并不需要params传入参数:

headers2 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/typerank',

'User-Agent': '...'

}

response2 = requests.get(url=url2, headers=headers2)

然后再筛选出需要的信息,打印出来:

for i, n in enumerate(response2.json()):

print(i+1, n['title'] + ' ' + n['rating'][0] + '【' + ','.join(n['types']) + '】', sep=' ')

#打印排名、名称、评分及影片类型

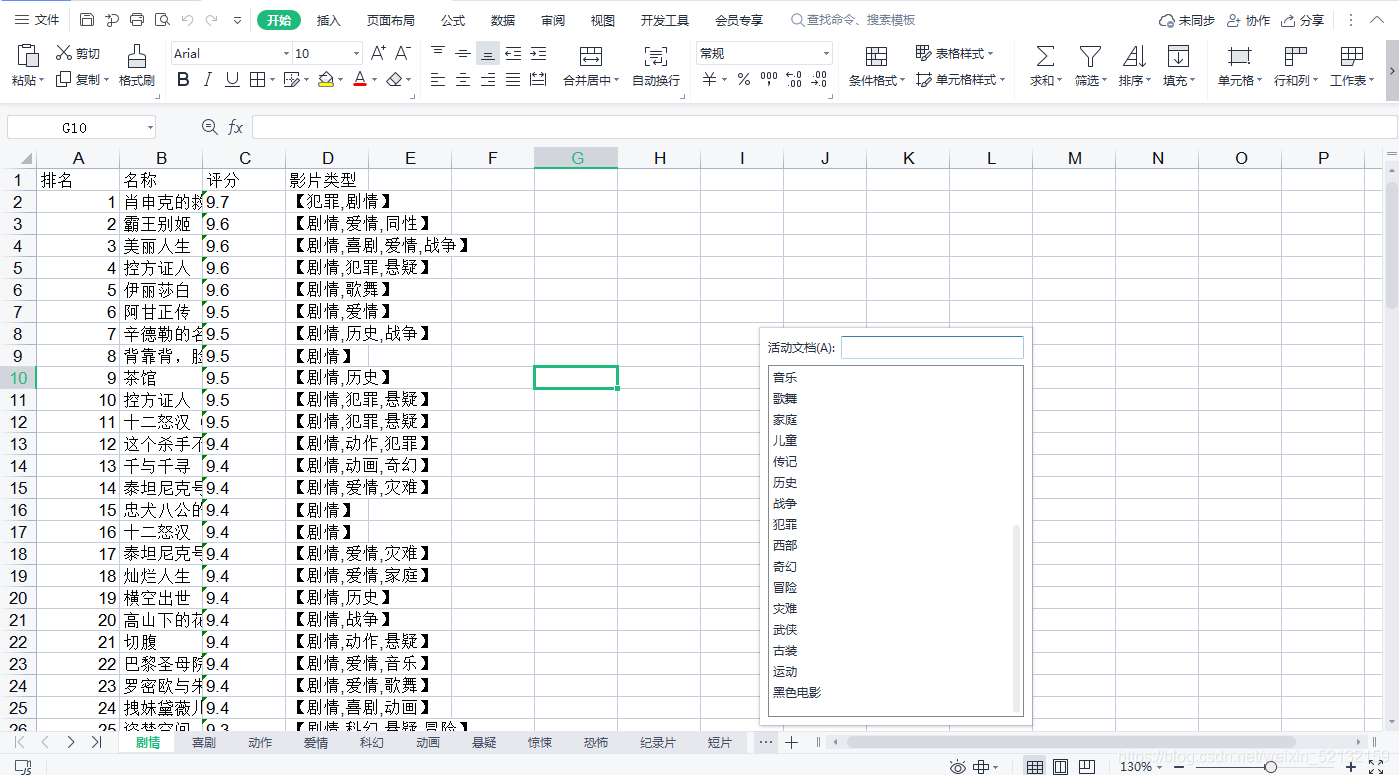

效果:

完整代码

from pyquery import PyQuery as pq

import requests

url1 = 'https://movie.douban.com/chart'

headers1 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/',

'User-Agent': '...'

}

response1 = requests.get(url1, headers=headers1) # 第一次请求,获取关键词

typelabels = pq(response1.text).find('.types span a') # 查找节点

typeslist = list(typelabels.items()) # 转为列表,方便之后的索引

for i, n in enumerate(typeslist):

print(str(i) + ':', n.text()) # 打印关键词

choose = int(input('请选择:'))

add = typeslist[choose].attr('href')

url2 = 'https://movie.douban.com/j/chart/top_list' + add.lstrip('/typerank') # 合并生成url

headers2 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/typerank',

'User-Agent': '...'

}

response2 = requests.get(url=url2, headers=headers2) # 第二次请求,获取榜单

for i, n in enumerate(response2.json()): # 打印榜单/

print(i, n['title'] + ' ' + n['rating'][0] + '【' + ','.join(n['types']) + '】', sep=' ')

选:保存到本地

一般来说,以上的功能就足以满足查询的需要,但有时候我们也想要把它保存下来,以下是爬取并保存的完整代码:

import requests

from pyquery import PyQuery as pq

import xlwt

# 新建工作簿

wb = xlwt.Workbook(encoding='utf-8')

url1 = 'https://movie.douban.com/chart'

headers1 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/',

'User-Agent': '...'

}

response1 = requests.get(url1, headers=headers1).text

typelabels = pq(response1.text).find('.types span a') # 查找节点

typeslist = list(typelabels.items()) # 转为列表,方便之后的索引

headers2 = {

'Cookie': '...',

'Referer': 'https://movie.douban.com/typerank',

'User-Agent': '...'

}

for j in typeslist:

# 新建工作表

ws = wb.add_sheet(i.text, cell_overwrite_ok=True)

#发送请求

add = i.attr('href')

url2 = 'https://movie.douban.com/j/chart/top_list' + add.lstrip('/typerank')

response2 = requests.get(url=url2, headers=headers2)

#提取有用信息

datas = [[i+1, n['title'], n['rating'][0], '【' + ','.join(n['types']) + '】'] for i, n in enumerate(response2.json())]

# 将表头和内容合并

table += [j for i in datas for j in i]

# 填入内容

for i, n in enumerate(table):

ws.write(i // 4, i % 4, n)

# 保存工作表

wb.save('豆瓣电影分类排行榜.xls')

效果:

温馨提示:爬取并保存全部,所耗费的时间过长,请耐心等待……

– the End –

以上就是我分享的全部内容,感谢阅读!

本文收录于专栏:Python爬虫

关注作者,持续阅读作者的文章,学习更多Python知识!

https://blog.csdn.net/weixin_52132159

2021/8/8

推荐阅读

- Python爬虫 | 爬取b站北京奥运会开幕式弹幕,有多少人从东京奥运会跑过来的?

- 绝密!Python爬虫告诉你刷分机器人背后的原理!这篇文章差点没过审

- Python每天一道题:昆虫繁殖问题?我把密密麻麻的幼虫和成虫搞定了

- 没想到我连五年级的题目都解不出来?可不能被人小看,让万能的Python登场

- Python:程序猿怎么追女生?教你短短几行代码表白,告别表白尴尬!

- 想学Python不知从何入手?学习Python必备秘籍,附地址,速拿!

- Python标准库:datetime 时间和日期模块 —— 时间的获取和操作详解

- 学习笔记 | PyInstaller 使用教程——用pyinstaller打包exe应用程序【建议收藏!】

- 【Python爬虫】爬虫利器 requests 库小结(建议收藏!)