首先是准备工作:

要用到的库

import matplotlib.pyplot as plt #用于可视化画图

from wordcloud import WordCloud #词云

import jieba #用于中文分词

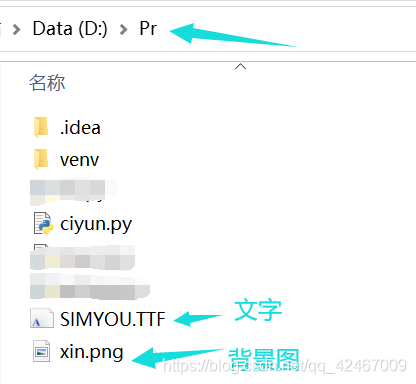

字体文件处理

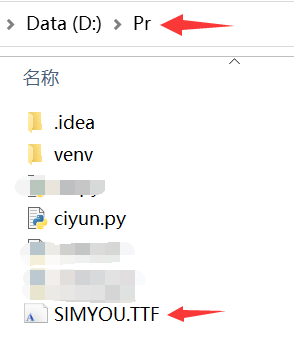

如果text(用于生成词云的数据是中文的话),需要将字体文件复制在项目文件里:

字体文件所在地址:

复制到项目文件中:

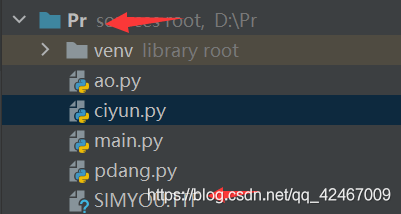

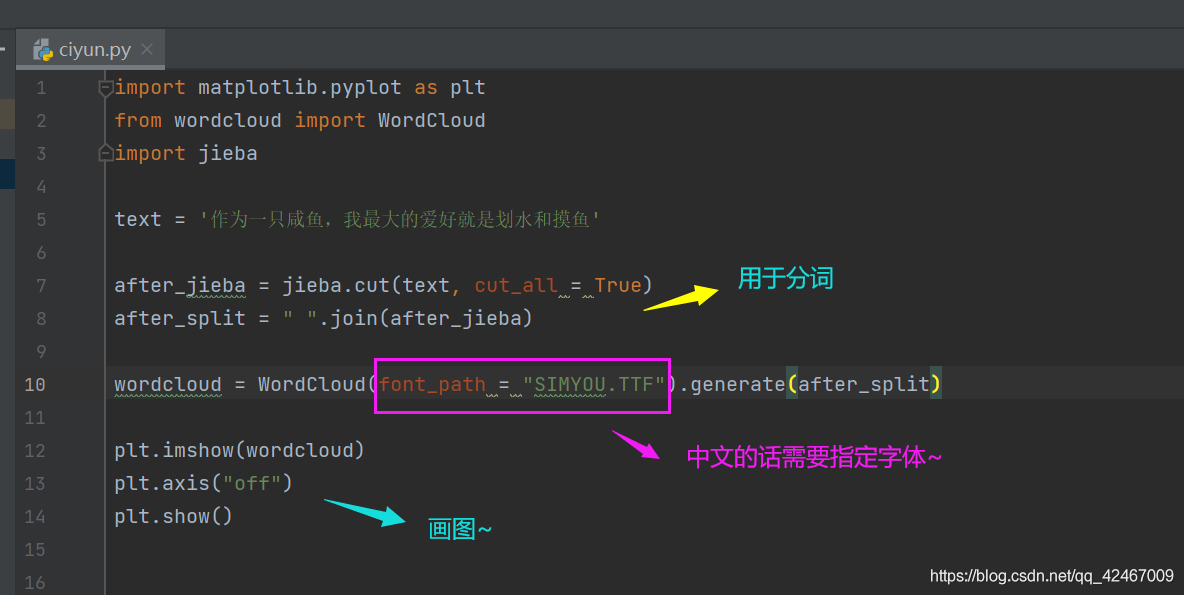

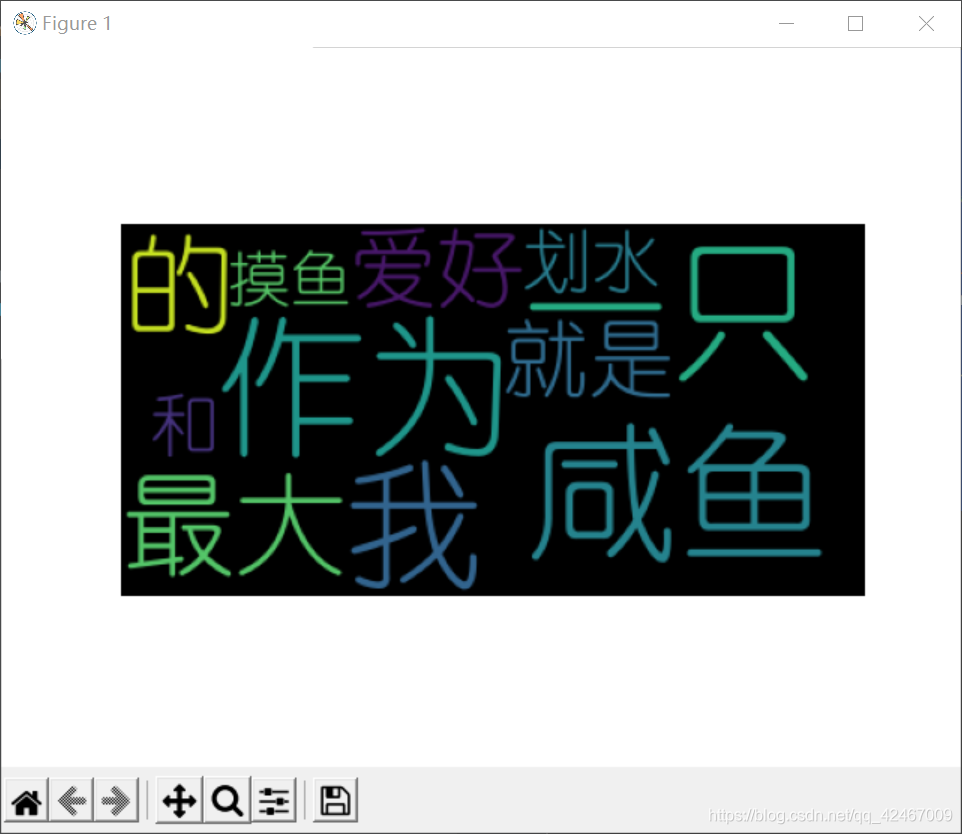

第一个很简单但是很丑的

先来一个很简单的,当然简单就意味着丑陋 (╬▔皿▔)╯

顺序:

1、text文字数据

2、jieba库 进行分词

3、生成词云 wordcloud库

4、画图

?【jieba】的用法:

https://blog.csdn.net/TFATS/article/details/108810284

实现:

import matplotlib.pyplot as plt

from wordcloud import WordCloud

import jieba

text = '作为一只咸鱼,我最大的爱好就是划水和摸鱼'

after_jieba = jieba.cut(text, cut_all = True)

after_split = " ".join(after_jieba)

wordcloud = WordCloud(font_path = "SIMYOU.TTF").generate(after_split)

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

生成了一个初始化的词云~

?【wordcloud】的用法:

https://blog.csdn.net/weixin_43826242/article/details/86658573

?词云调整文字颜色:

https://blog.csdn.net/weixin_45203845/article/details/104324863

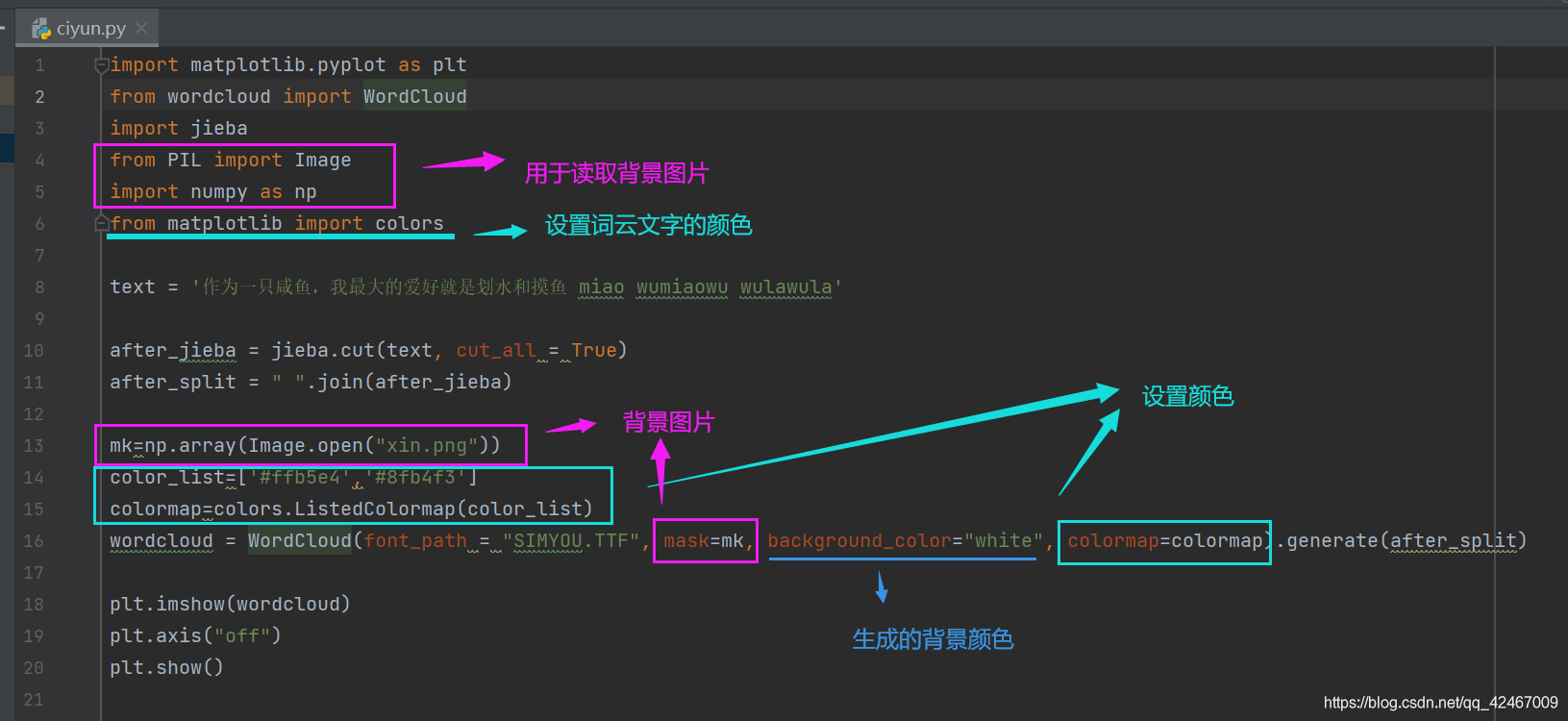

在了解了wordcloud的参数情况~ 可以尝试对词云的形状进行变形~

用到的背景图是这张,取名为 xin.png

将这个图片文件和前面提到的文字一样存到项目文件下~

然后呢~在上一个的基础上修改一下代码:

实现:

import matplotlib.pyplot as plt

from wordcloud import WordCloud

import jieba

from PIL import Image

import numpy as np

from matplotlib import colors

text = '作为一只咸鱼,我最大的爱好就是划水和摸鱼 miao wumiaowu wulawula'

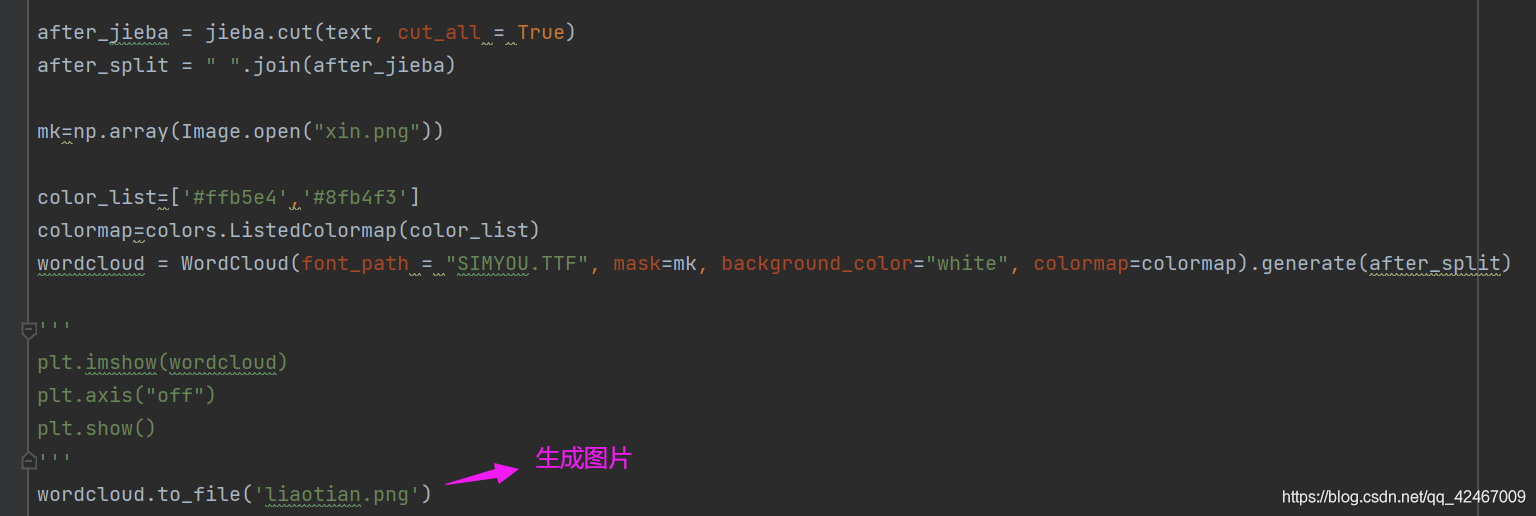

after_jieba = jieba.cut(text, cut_all = True)

after_split = " ".join(after_jieba)

mk=np.array(Image.open("xin.png"))

color_list=['#ffb5e4','#8fb4f3']

colormap=colors.ListedColormap(color_list)

wordcloud = WordCloud(font_path = "SIMYOU.TTF", mask=mk, background_color="white", colormap=colormap).generate(after_split)

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

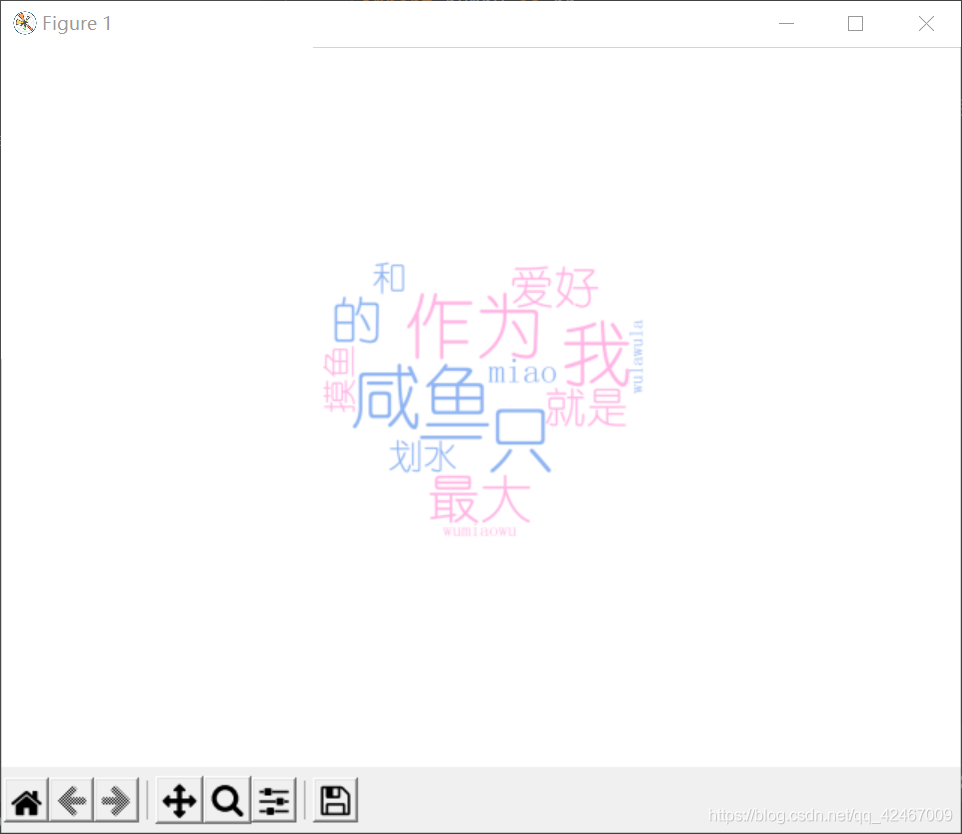

生成了一个很Q的词云~~好可爱QAQ

来一个有一点难度的吧,用聊天记录做词云~

顺序:

1、导出聊天记录

2、处理聊天记录数据

3、修改上一个代码(皮)

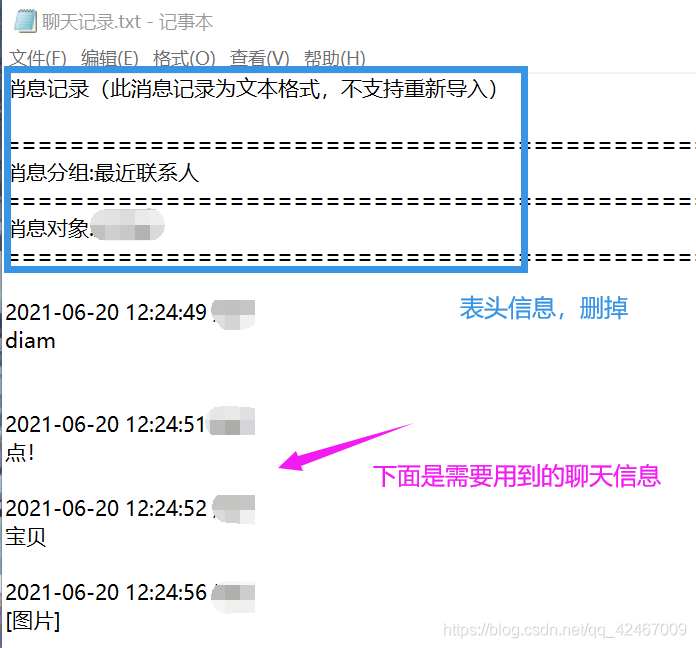

导出记录长这样~:

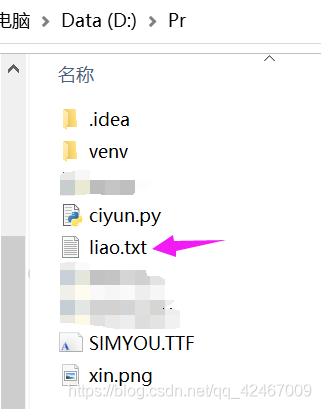

同样可以先将聊天记录放入项目文件夹中~用英文名字最好

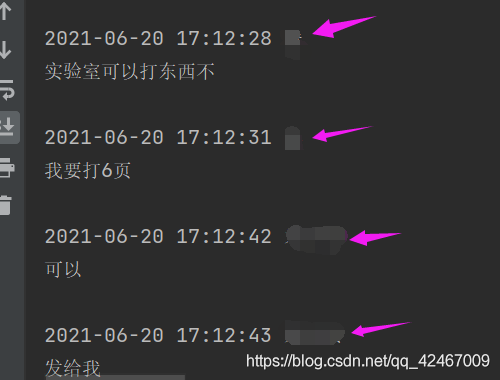

然后是对聊天记录进行数据清洗~

比如我想去掉紫色箭头指向的日期和昵称。我用正则表达式来做~

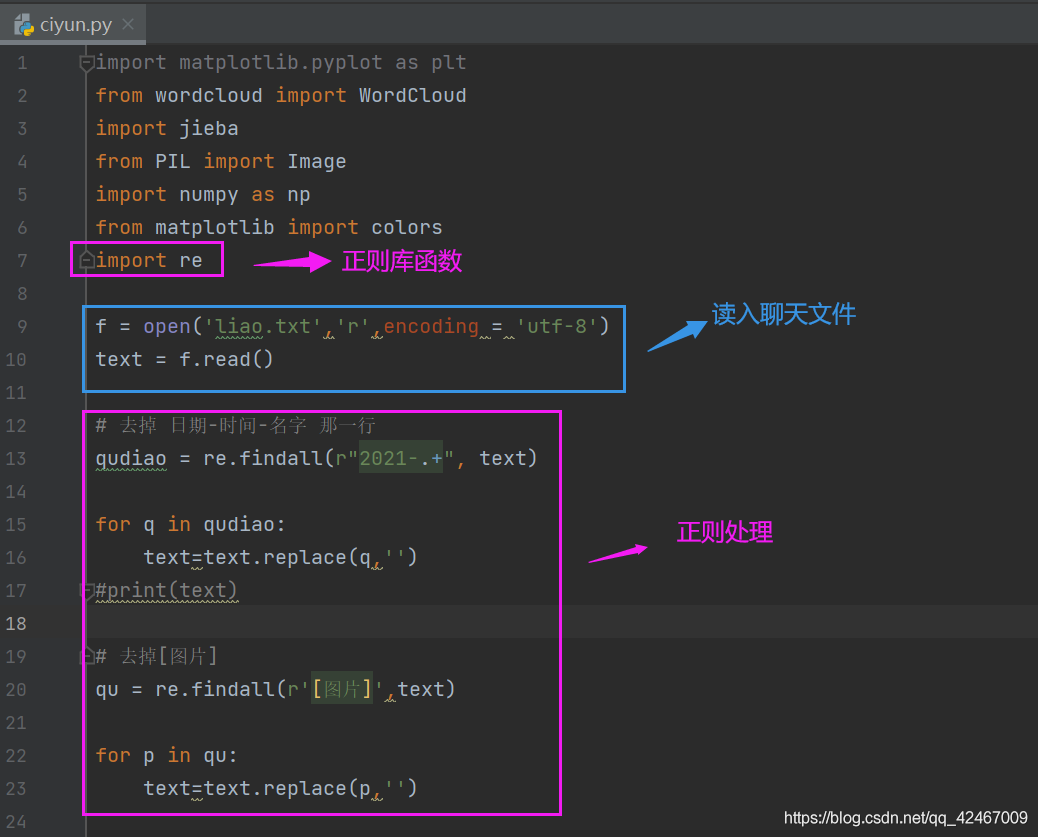

首先要用到的库库

import re

实现:

import matplotlib.pyplot as plt

from wordcloud import WordCloud

import jieba

from PIL import Image

import numpy as np

from matplotlib import colors

import re

f = open('liao.txt','r',encoding = 'utf-8')

text = f.read()

# 去掉 日期-时间-名字 那一行

qudiao = re.findall(r"2021-.+", text)

for q in qudiao:

text=text.replace(q,'')

#print(text)

# 去掉[图片]

qu = re.findall(r'[图片]',text)

for p in qu:

text=text.replace(p,'')

after_jieba = jieba.cut(text, cut_all = True)

after_split = " ".join(after_jieba)

mk=np.array(Image.open("xin.png"))

color_list=['#ffb5e4','#8fb4f3']

colormap=colors.ListedColormap(color_list)

wordcloud = WordCloud(font_path = "SIMYOU.TTF", mask=mk, background_color="white", colormap=colormap).generate(after_split)

'''

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

'''

wordcloud.to_file('liaotian.png')

成果~

但是呢,我发现这个词云图上面显示的聊天记录分词并不完全。。不知道为啥 今天先到这里吧。