记上一篇Debian配置python3.7环境后,吧dirsearch通过sshd的协议本地传到公网,这里就有人问了, 本地不好嘛?

- 公网更隐蔽,,

- Debian内核效应高,,响应快这一点是大多数渗透测试喜爱Debain的原因。

3.缺点,不是很友好,(这里的不友好是玩的转有些困难,不是傻瓜式的)

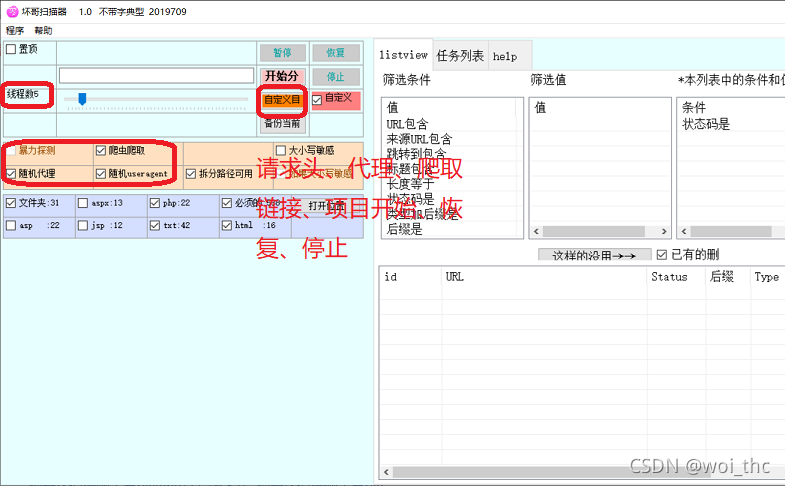

1.坏哥扫描器,图文化参考

在用之前,我这里参考坏哥的扫描器

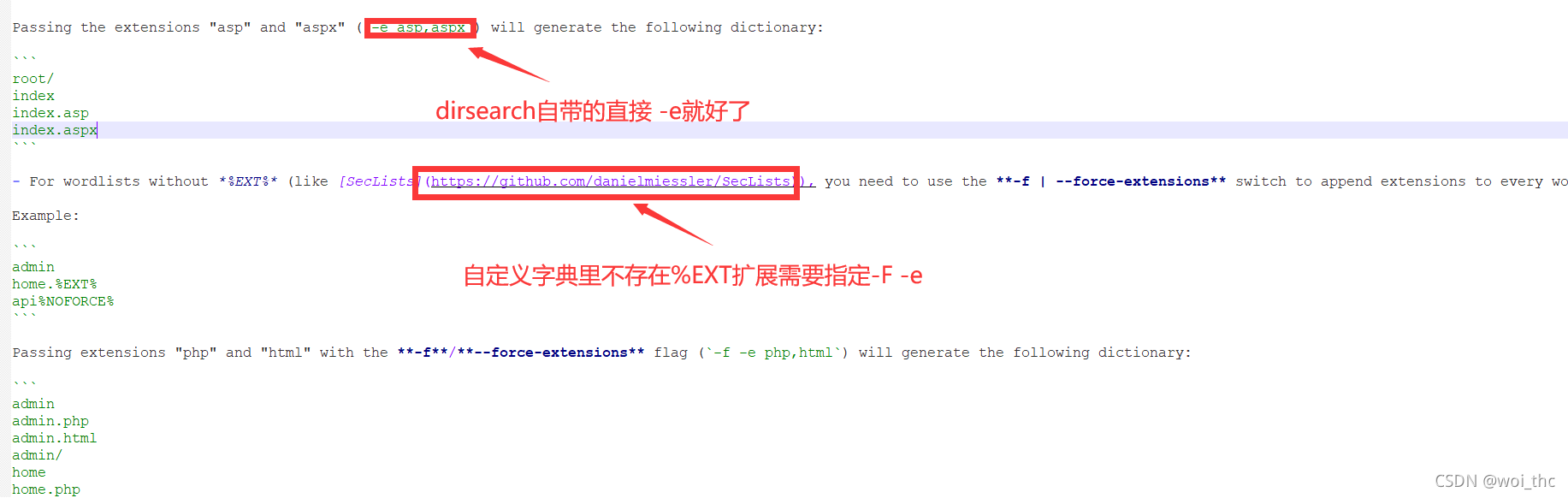

2.dirsearch命令行化如何配置

图形化的好处就在于好配置,,,但他响应慢,内核不是C这种高效率写的,兼容性很差,,坏哥确实好用,但很容易出问题,所以转向命令行的dirsearch。

目前dirsearch已经更新到了4.2,个人觉得和4.1只是优化了一点,4.1在自定义目录做了比较详细的解释,这是3.8没有的地方。

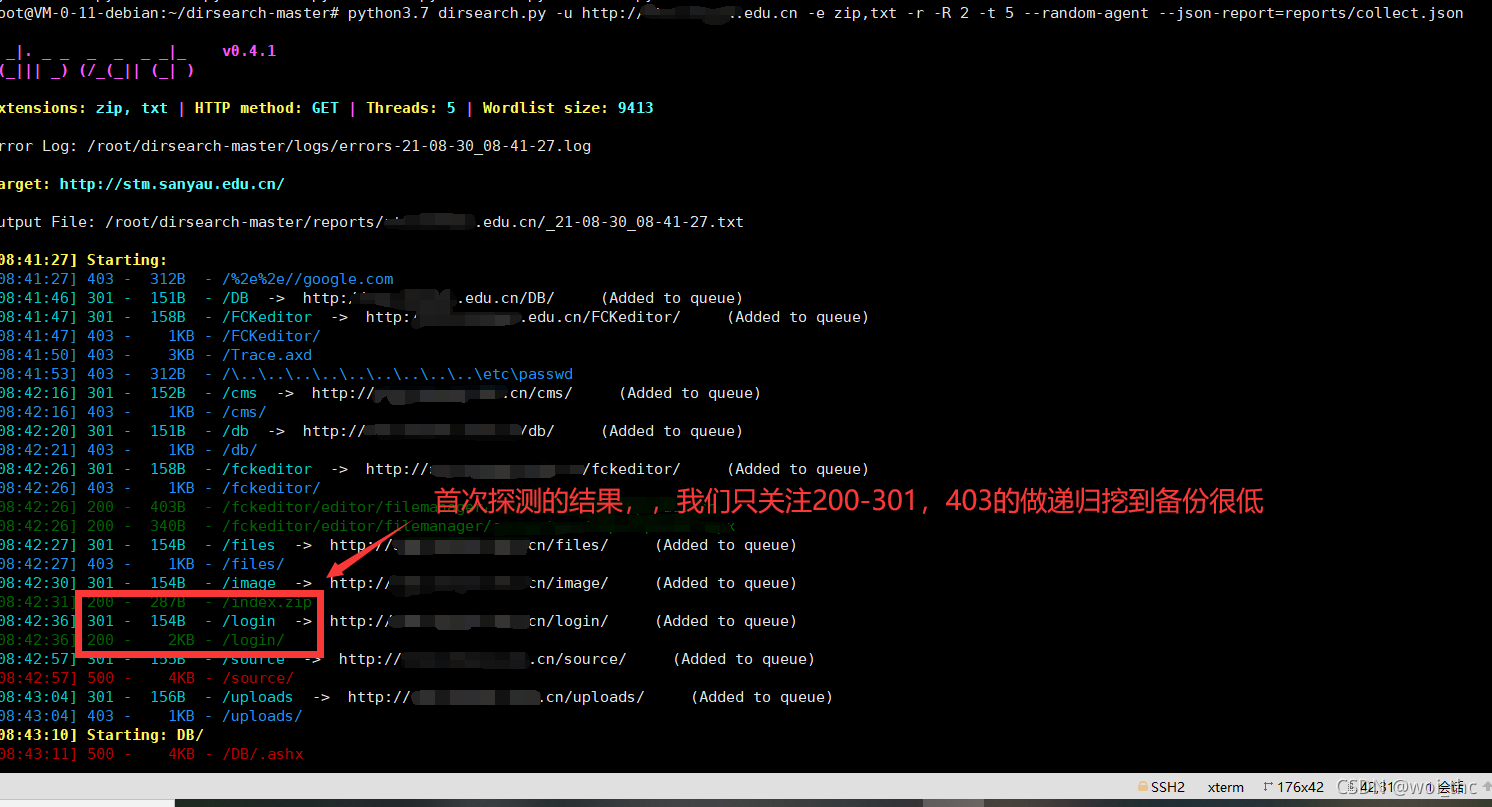

真实演绎:

站点:http://abc.xxx.xxx.cn/UpLoadFile/20210821111134.asp

探测工具: dirsearch 0.4.1

站点环境: asp.net

3.实际站点目录探测

这是之前拿到的shell,发现站点存在source备份,而且shequ目录下存在_ABC 的管理登录,做信息收集完全掉点了。

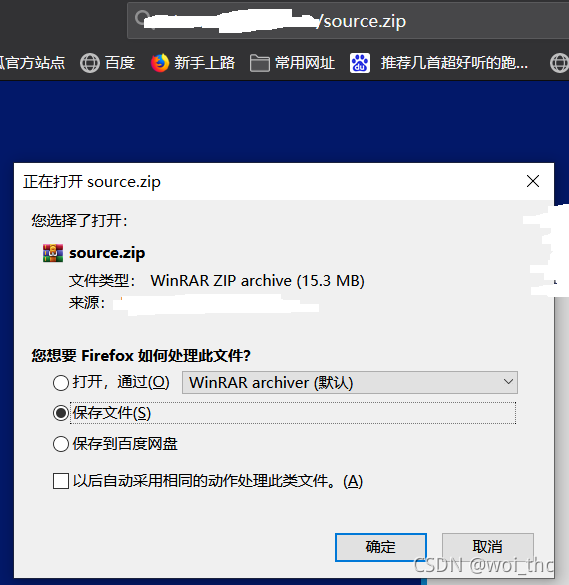

探测备份zip文件,,(zip是种玄学)

python3.7 dirsearch.py -u http://abc.xxx.xxx.cn -e zip,txt -r -R 2 -t 5 --random-agent --json-report=reports/collect.json

配置随机请求头,输出为json格式,-r R 2 做目录两层递归,, -e是他自带的字典,所以不加-f

4.递归探测

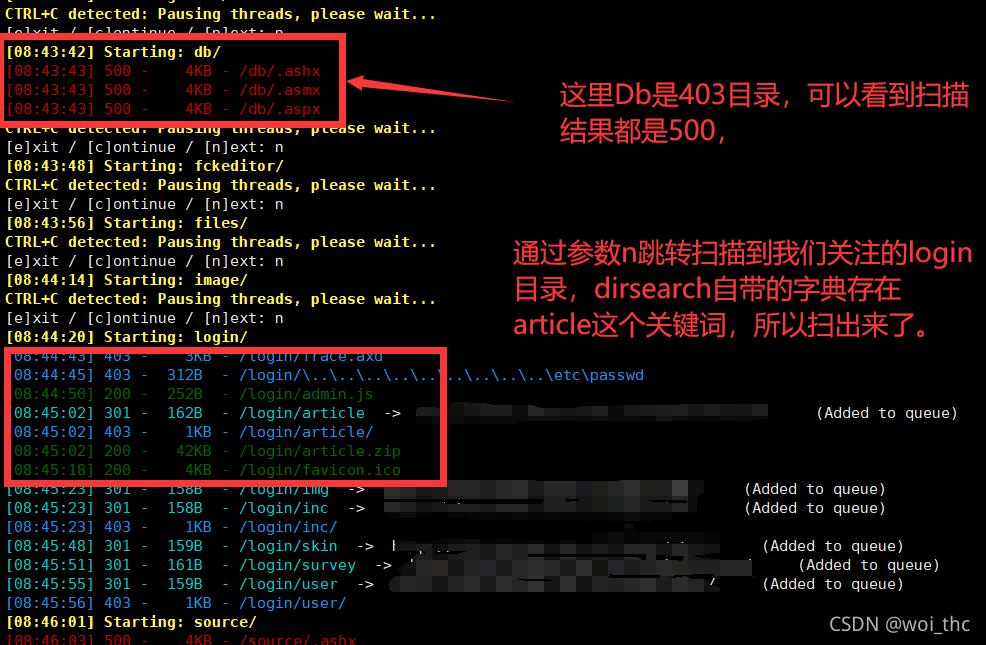

然后看递归部分,,login

5.扫到站点备份

这里我们已经扫到一个article.zip的备份,由于他在后端,他大概率是编辑文章的源代码,但这对我们前期渗透测试价值是很低的。。

同时,由于这边已经拿到shell,发现在根目录是存在全站的源代码的,但dirsearch竟然没扫出来,关键词是source.zip

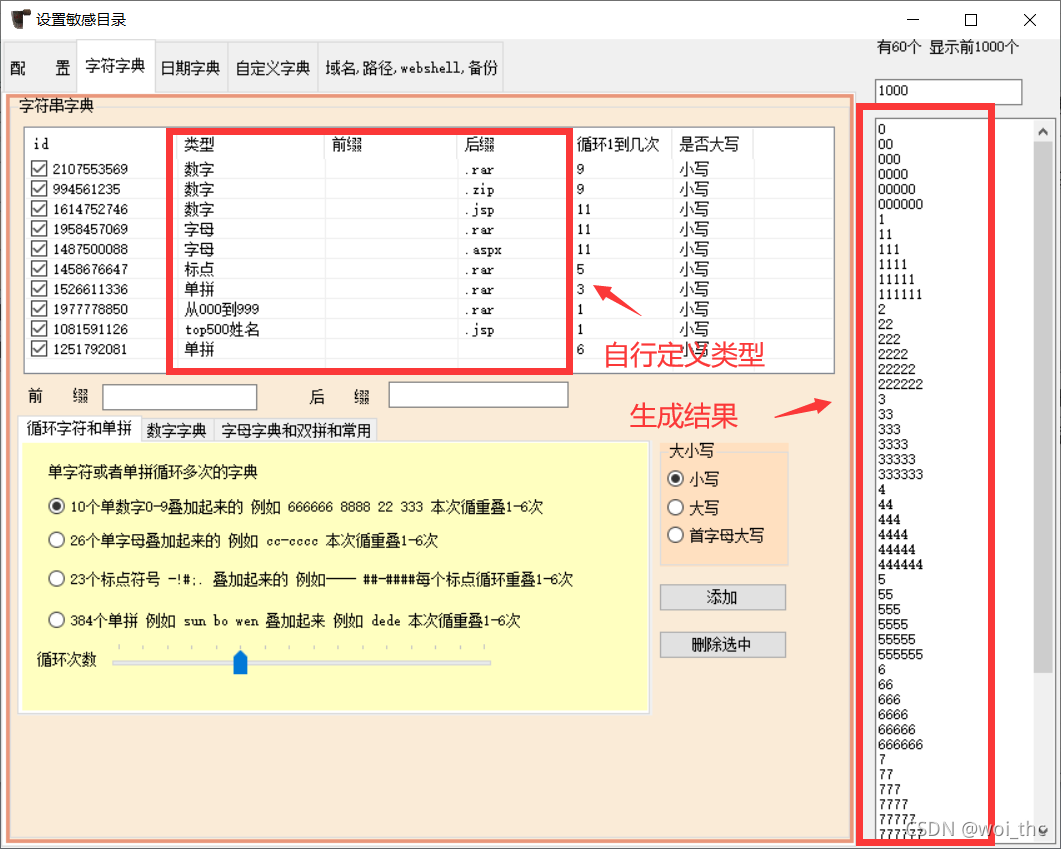

6.自定义字典

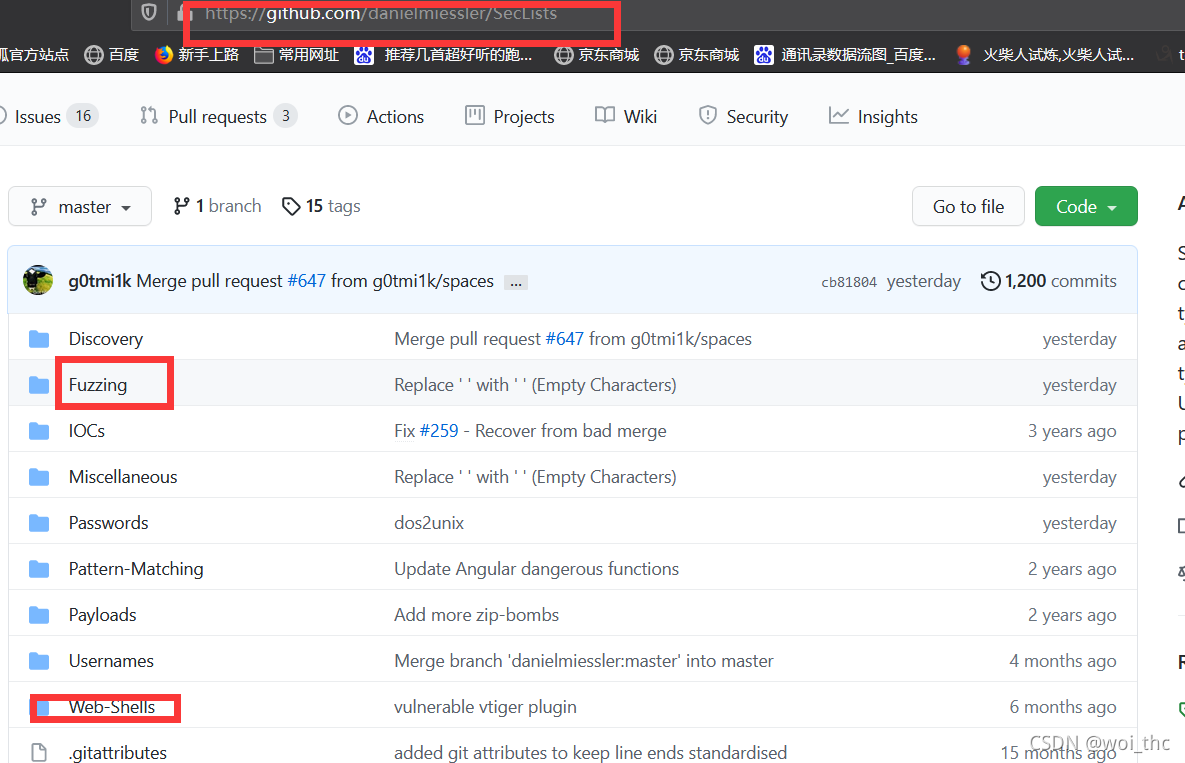

所以,解决这问题的唯一办法是自定义字典,,dir作者推荐了某项目的fuzz,大佬们都自觉专研过了,

7.目录探测优化

这里,,由于我的水平不够,只能做几点建议:

1.dirsearch 是暴力探测的目录扫描工具,他没有爬虫的功能。

2.能不能扫到东西,比如站点根目录,,200状态码,login目录下,,二级目录下,,根据他的环境选择字典。

3,dirsearch生成字典后,二级目录,三级目录都用的同一套字典,这里要注意。