pandas

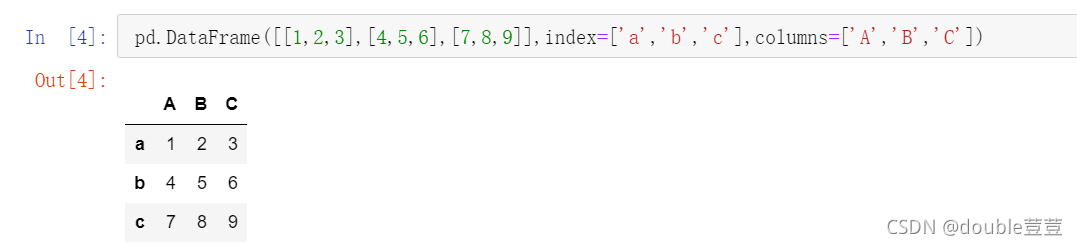

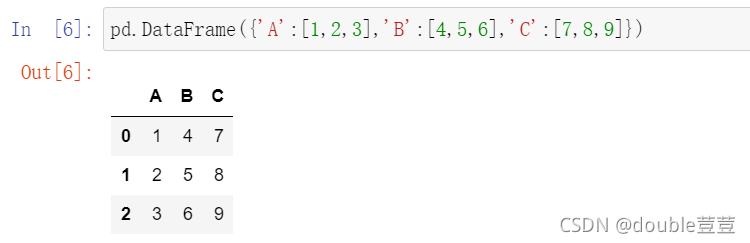

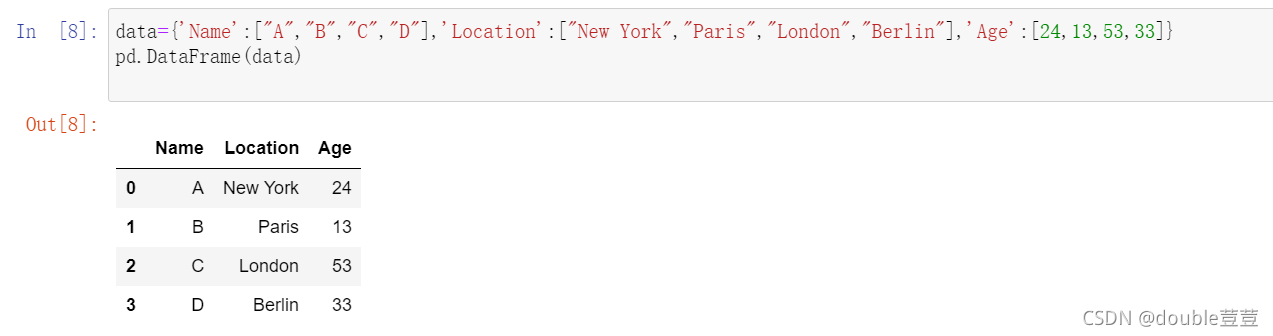

构造DataFrame的方式:

import pandas as pd

1.pd.DataFrame([[1,2,3],[4,5,6],[7,8,9]],index=['a','b','c'],columns=['A','B','C'])

2.pd.DataFrame('A':[1,2,3],'B':[4,5,6],'C':[7,8,9])

data={'Name':["A","B","C","D"],'Location':["New York","Paris","London","Berlin"],'Age':[24,13,53,33]}

pd.DataFrame(data)

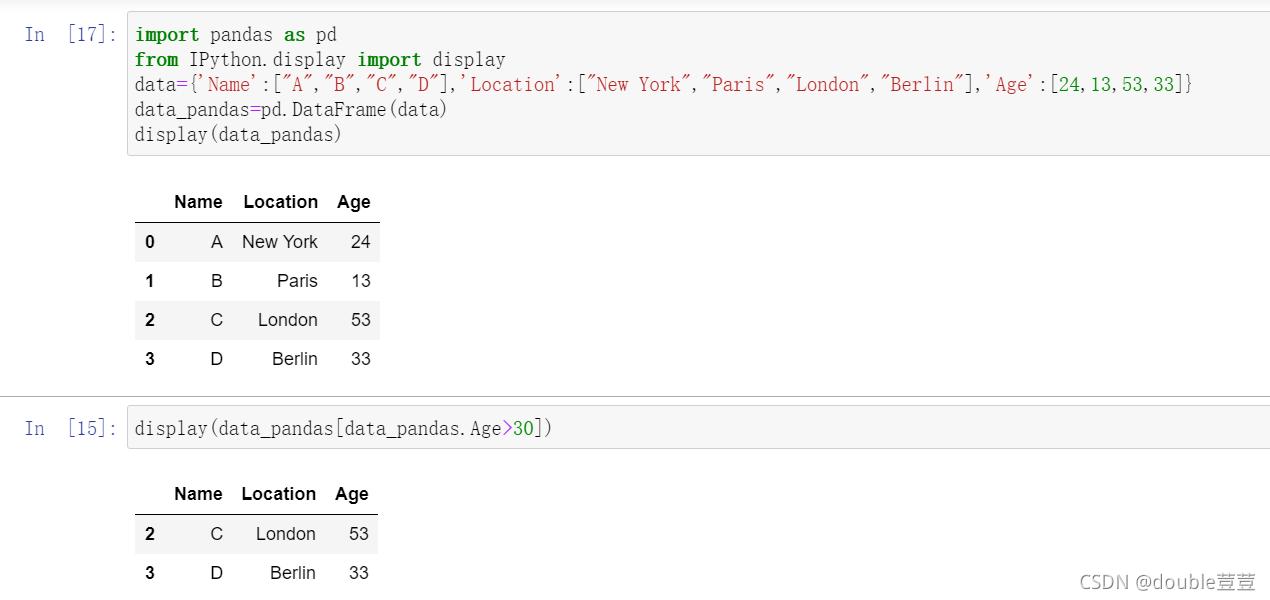

IPython.diaplay :打印出“美观的”DataFrame

import pandas as pd

from IPython.display import display

data={'Name':["A","B","C","D"],'Location':["New York","Paris","London","Berlin"],'Age':[24,13,53,33]}

data_pandas=pd.DataFrame(data)

display(data_pandas)

筛选:选择年龄大于30的所有行

display(data_pandas[data_pandas.Age>30])

空缺值的处理

dropna(axis=0,how='any',thresh=None,subset=None,inplace=False)

参数:

| 参数 | 意义 |

|---|---|

| axis | 过滤行或列 行:0/index 列:1/columns |

| how | 过滤的标准 any:删除 |

axis:过滤行或列

how:过滤的标准,

thresh:表示有效数据量的最小要求。若传入2,则是要求该行或该列至少有两个非

NAN值时将其保留

mglearn库

用来快速美化绘图,或者用于获取一些有趣的数据

本学期常用库

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

import mglearn

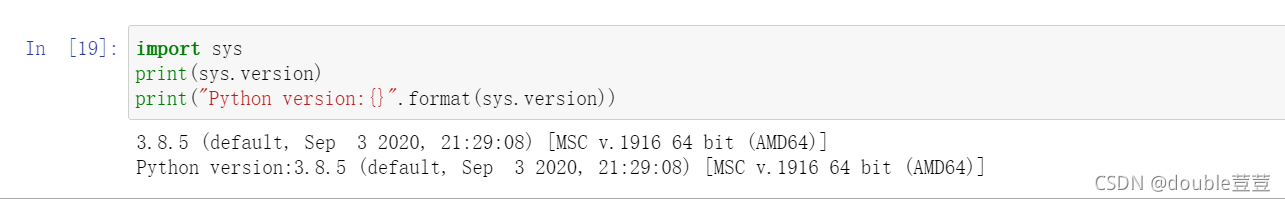

输出代码版本

1.pip show keras/tensorflow

2.import sys

print(sys.version)

print("Python version:{}".format(sys.version))

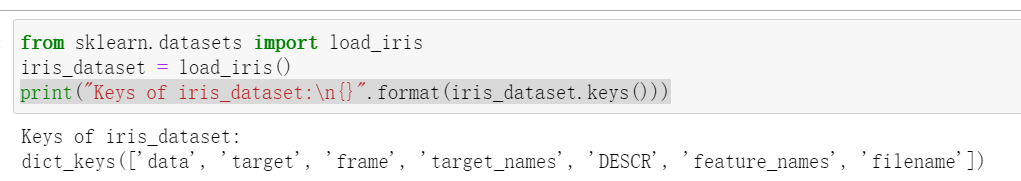

鸢尾花

本例中我们用到了鸢尾花(Iris) 的数据集,这是机器学习和统计学中一个经典的数据集。它包含在scikit-learn的datasets模块中。我们可以用load_iris函数来加载数据:

from sklearn.datasets import load_iris

iris_dataset = load_iris()

load_iris返回的iris对象是一个Bunch对象,与字典非常相似,里面包含键和值:

鸢尾花数据中键的相关介绍

iris.keys()

print("Keys of iris_dataset:\n{}".format(iris_dataset.keys()))

数据包含在data和target中。

1.data

data里面是花萼长度、花萼宽度、花瓣长度、花瓣宽度的测量数据,格式为NumPy数组。

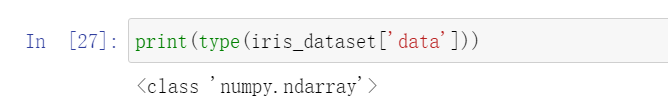

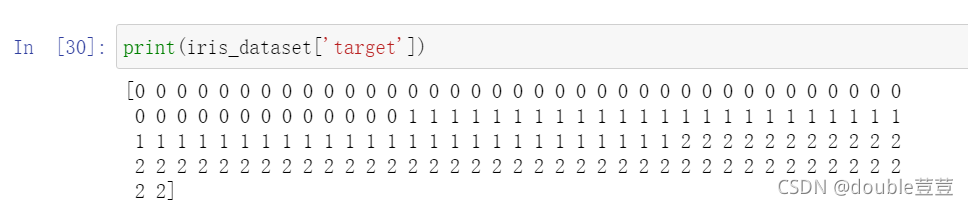

查看data数据的格式:

data数组的每一行对应一朵花,列代表每朵花的四个测量数据

可以看出,数组中包含了150朵不同的花的测量数据。

机器学习中,个体叫做样本(sample),属性叫做特征(feature)。data数组的**形状(shape)**是样本数乘以特征数。

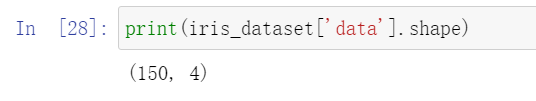

下面列出前五个样本的特征数值

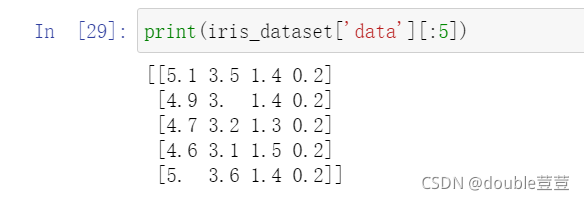

2.target

target数组中包含的是测量过的每朵花的品种,也是一个NumPy数组。

0代表:setosa 1代表: versicolor 2代表:virginica

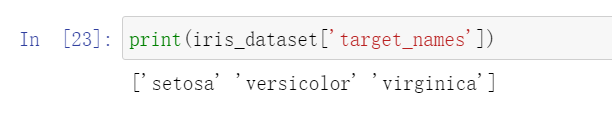

3.target_names

target_names键对应的值是一个字符串数组,里面包含我们要预测的花的品种

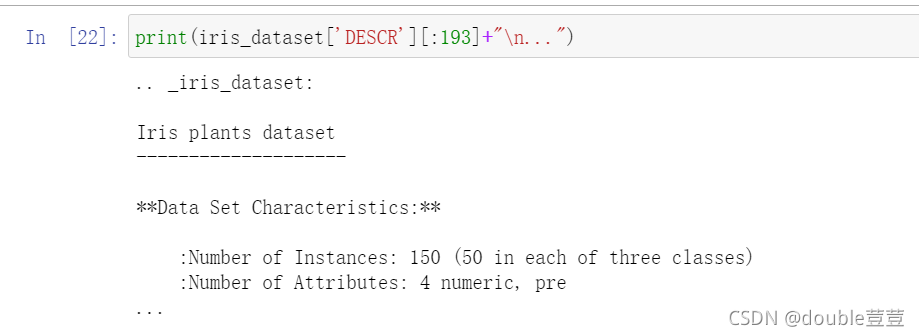

DESCR键对应的值是数据集的简要说明

print(iris_dataset['DESCR'][:193]+"\n...")

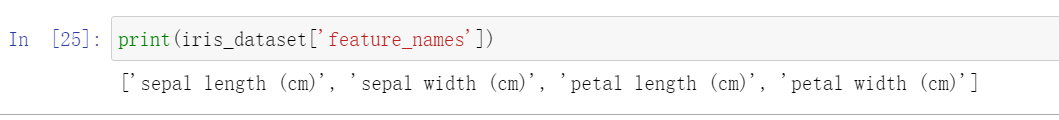

4.feature_names

feature_names键对应的值是一个字符串列表,对每一个特征进行了说明

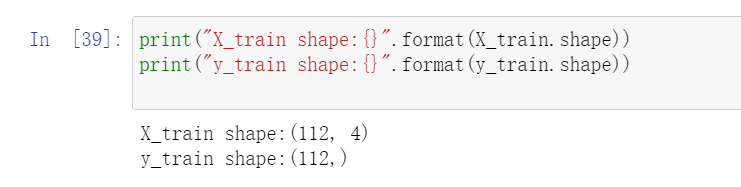

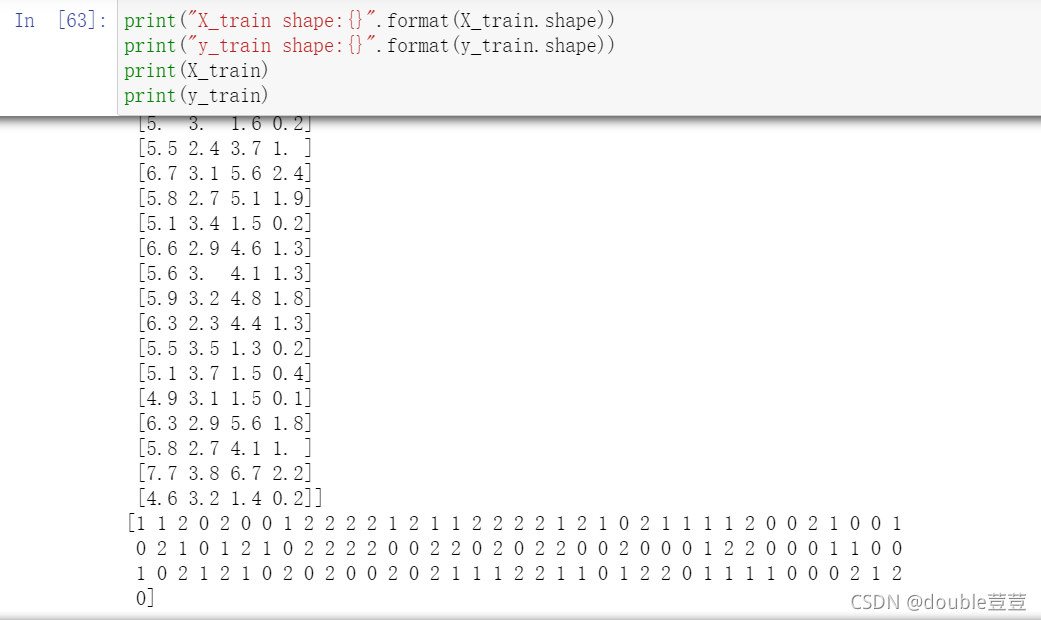

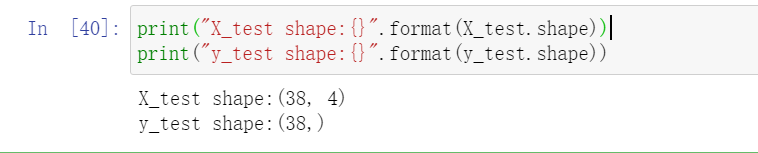

train_test_split函数可以打乱数据集并进行拆分。这个函数讲75%的行数据作为训练集,

剩下的25%作为测试集。

X_train:训练数据 y_train:训练标签

import random

from sklearn.model_selection import train_test_split

X_train,X_test,y_train,y_test = train_test_split(iris_dataset['data'],iris_dataset['target'],random_state=0)

print("X_train shape:{}".format(X_train.shape))

print("y_train shape:{}".format(y_train.shape))

print("X_test shape:{}".format(X_test.shape))

print("y_test shape:{}".format(y_test.shape))

衡量模型

构建一个模型:k近邻算法

原理:构建此模型只需要保存训练集即可。要对一个新的数据点做出预测,算法会在训练集中寻找与这个新数据点距离最近的数据点,然后将找到的数据点的标签赋值给新的数据点。

k的含义是:我们可以考虑训练集中与新数据点最近的任意k个邻居(比如说,距离最近的3个或5个邻居),而不是只考虑最近的那一个。然后,我们可以用这些邻居中数量最多的类别做出预测。

k近邻分类算法是在neighbors模块的KNeighborsClassifier类中实现的。我们需要将这个类实例化为一个对象,然后才能使用这个模型。这时我们需要设置模型的参数。KNeighborsClassifier最重要的参数就是邻居的数目,这里我们设为1:

from sklearn.neighbors import KNeighborsClassifier

knn = KNeighborsClassifier(n_neighbors=1)

想要基于训练集来构建模型,需要调用knn对象的fit方法,输入参数为X_train,y_train.

knn.fit()对训练集进行训练

knn.fit(),训练函数,它是最主要的函数。接收参数只有1个,就是训练数据集,每一行是一个样本,每一列是一个属性。它返回对象本身,即只是修改对象内部属性,因此直接调用就可以了,后面用该对象的预测函数取预测自然及用到了这个训练的结果。

knn.fit(X_train,y_train)

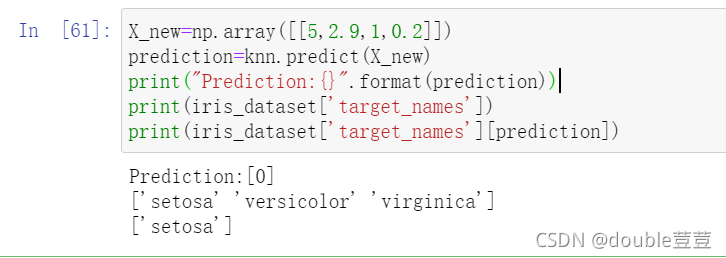

做出预测

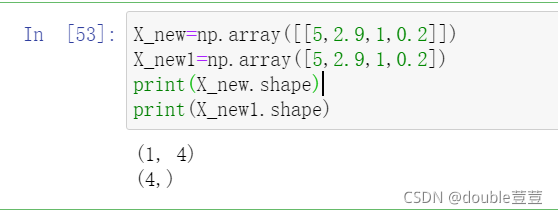

发现一朵鸢尾花,花萼长5cm宽2.9cm,花瓣长1cm宽0.2cm.预测这朵鸢尾花属于哪个品种?

X_new=np.array([[5,2.9,1,0.2]])

prediction=knn.predict(X_new)

print("Prediction:{}".format(prediction))

print(iris_dataset['target_names'][prediction])

knn.predict()预测新输入的类别

knn.predict(),预测函数 接收输入的数组类型测试样本,一般是二维数组,每一行是一个样本,每一列是一个属性。返回数组类型的预测结果。

评估模型

knn.score()计算预测的准确率

knn.score(),计算准确率的函数,输出为一个float型数,表示准确率。

X: 接收输入的数组类型测试样本,一般是二维数组,每一行是一个样本,每一列是一个属性。

y: X这些预测样本的真实标签,一维数组或者二维数组。

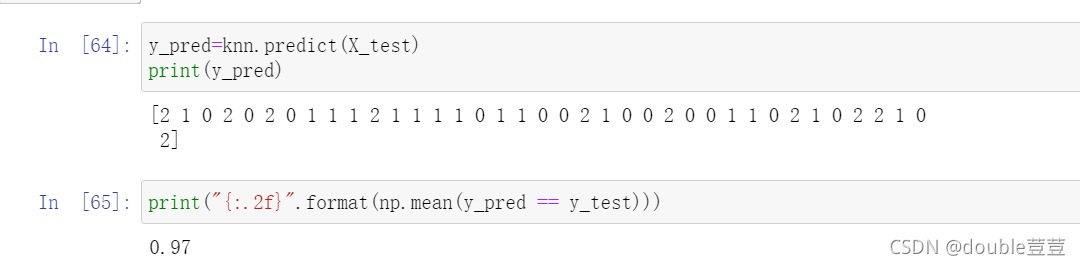

y_pred=knn.predict(X_test)

print(y_pred)

print("{:.2f}".format(np.mean(y_pred == y_test)))

调用knn.score()计算预测的准确率

knn.score(),计算准确率的函数,接受参数有3个。输出为一个float型数,表示准确率。内部计算是按照predict()函数计算的结果记性计算的。

接收的3个参数:

X: 接收输入的数组类型测试样本,一般是二维数组,每一行是一个样本,每一列是一个属性。

y: X这些预测样本的真实标签,一维数组或者二维数组。