?2021SC@SDUSC

一、项目地址

二、项目背景

在如今的互联网时代,网络给我们提供了很多便捷的服务,不管是网上购物,网上阅读,还是从网络上获取实时新闻,了解国内外大事。同时,网络也带来了爆炸式的海量数据。

过去,人们获取信息一般都是通过报纸、电视和广播等传播媒介,但这些信息是经过筛选的有限信息,信息面过去狭窄,以致于人们视野受限,无法了解更多的知识与信息。

现在的大数据时代,人们可以从网络上获取到海量的信息数据,但大部分都是垃圾无用的信息。人们如何在这些海量的碎片化信息中寻找到自己想要的信息呢。

这就需要“筛选”,通过某种技术将信息整合起来,分析过滤掉无用的信息,才能获得想要的信息。

这种技术就是“爬虫”,网络爬虫是一种按照一定的规则,自动地抓取万维网信息的程序或脚本。它可以进行收集分析整合的工作,可应用的范畴非常的广泛,无论是生活服务、出行旅行,还是金融投资、各类制造业的产品市场需求等等。

三、项目概述

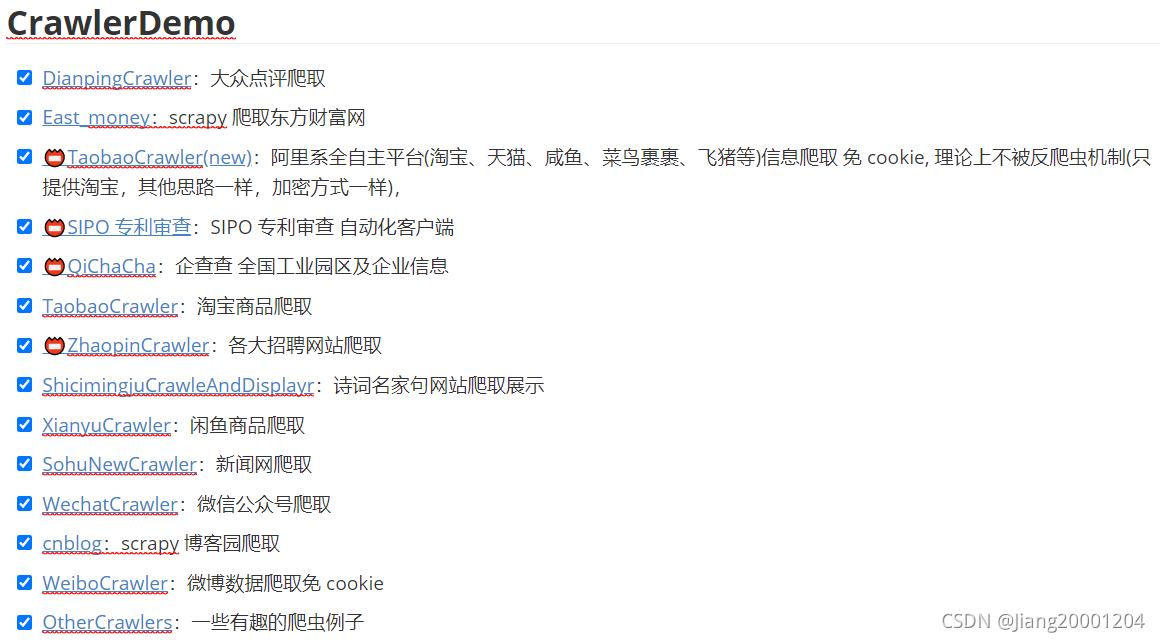

ECommerceCrawlers是一个多种网站、电商数据的Python爬虫合集。涵盖了淘宝、企查查、搜狐新闻、闲鱼等比较热门的网站和电商平台。具体demo如下图所示:

每个项目都有对应的readme,可供了解爬虫的相关过程。

项目涉及的技术有:

- 数据分析:chrome Devtools、Fiddler、anyproxy、mitmproxy

- 数据采集:urllib、requests、scrapy、selenium

- 数据解析:re、beautifulsoup、xpath、pyquery、css

- 数据保存:txt文本、csv、Excel、mysql、redis、mongodb

- 反爬验证:mitmproxy 绕过淘宝检测、js 数据解密、js 数据生成对应指纹库、文字混淆

- 效率爬虫:单线程、多线程、多进程、异步协成、生产者消费者多线程、分布式爬虫系统

四、项目准备

- 根据对应网址下载项目代码

- 配置好python开发环境(python版本采用python3.9),下载配置python的开发工具(PyCharm Community Edition 2021.2.2)

- 安装配置所需要的一些python库(例如爬虫需要的request库)

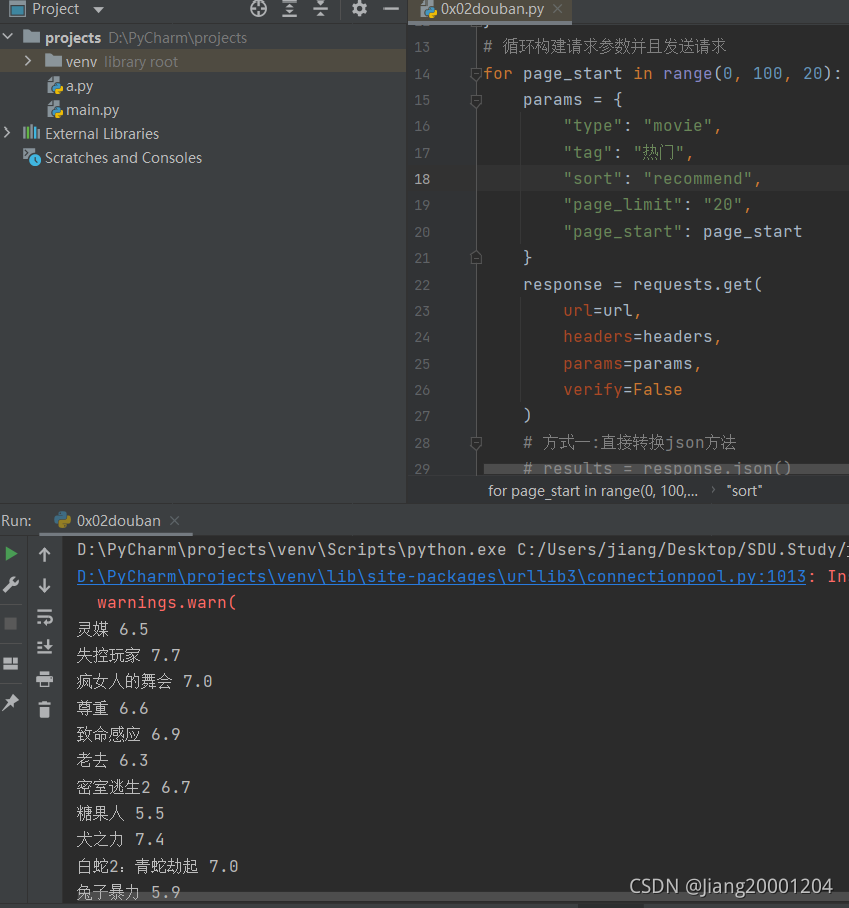

- 尝试先运行部分代码(例:成功运行豆瓣电影排行榜的爬虫程序)

?五、组内分工

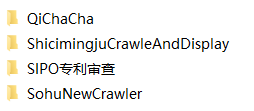

?我们小组是四人组,我们将16个项目均分为四份,而我负责分析的项目如图:

六、未来博客更新

?在接下来的几个月中,我会一边学习爬虫的相关技术和知识,一边分析本项目的代码,并且之后的每周我会更新详细的代码分析博客以及一些学习心得

?

?