一、代码

#UA伪装:让爬虫对应的请求载体身份标识伪装成某一款浏览器

#UA检测是否为正常服务器请求

import requests

headers={'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:92.0) Gecko/20100101 Firefox/92.0'

}

url='https://www.bilibili.com/all'

#处理url携带的参数:封装到字典里

kw=input('enter a word:')

#参数

param={

'keyword':kw

}

#对指定url发起的请求对应的url是携带参数的,并且在此过程中处理了参数

response=requests.get(url=url,params=param,headers=headers)

page_text=response.text

fileName =kw+'html'

with open(fileName,'w',encoding='utf-8')as fp:

fp.write(page_text)

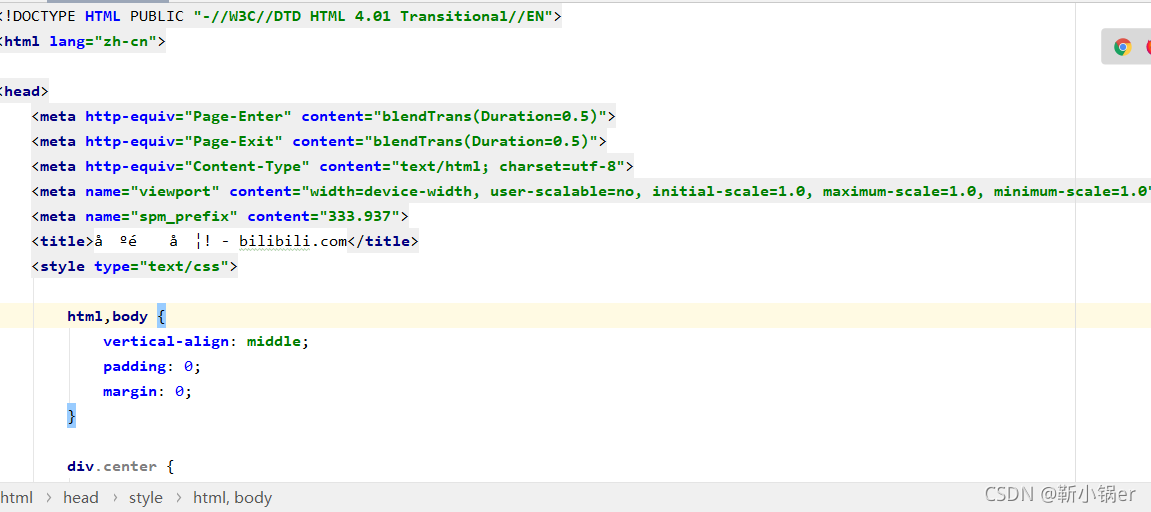

print(fileName,'保存成功')二、显示结果

?