前言

当我们刚开始学习爬虫的朋友开始学习接触爬虫做练习时,经常会发现网页结果无法爬取,或者频率过大被封ip地址等,下面就为大家介绍三种基本的反反爬手段

user-agent

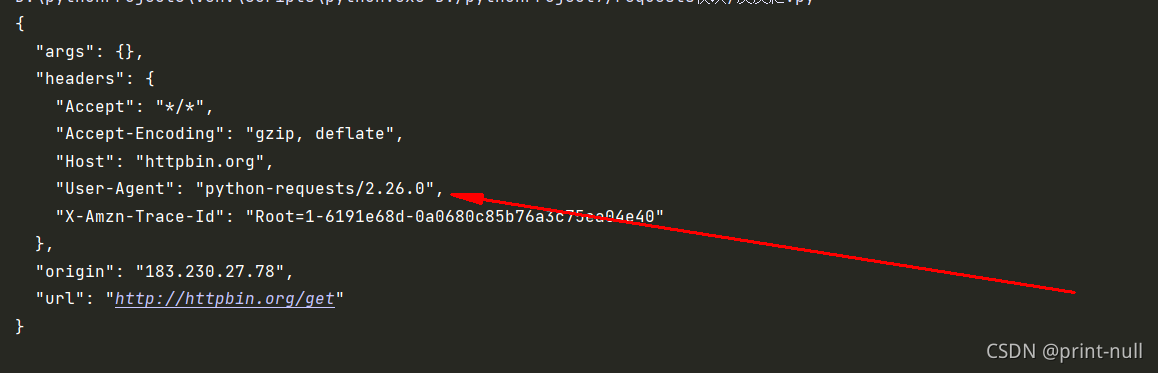

user-agent是识别我们是不是爬虫的第一道防线,某些ua是特殊的与正常浏览器的ua有极大的差别,比如requests发送的请求与正常的浏览器ua就是不同,某些网页是禁止Python的ua的,当浏览器识别出来就会拒绝我们的请求

从上面可以看出我们的user-agent不是正常浏览器的ua,服务器可以识别我们是通过python的requests发送的请求

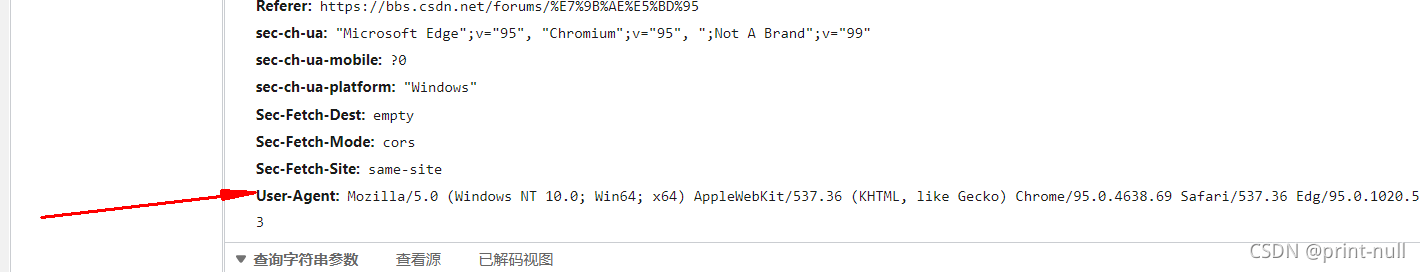

我们可以通过浏览器开发者模式查看浏览器的user-agent

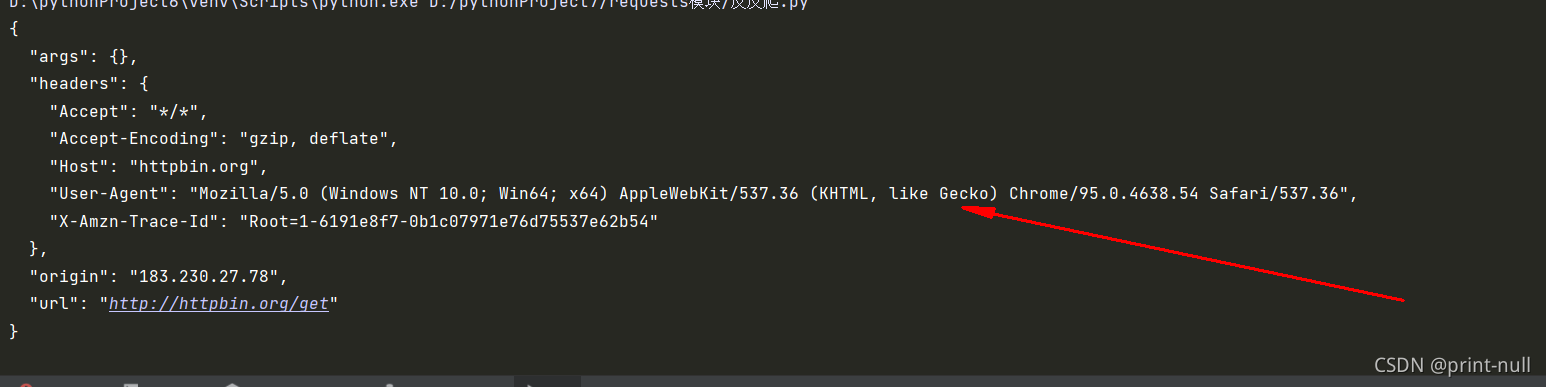

通常我们在编写爬虫程序时,都会传入参数,用于反反爬,传入user-agent主要是把我们伪装成浏览器。

下图是传入user-agent后打印的结果

具体代码如下:

import requests

# url地址

url='http://httpbin.org/get'

# user-agent

henders={'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.54 Safari/537.36'}

# 发送请求

res=requests.get(url,headers=henders)

# 打印结果

print(res.text)

IP封禁

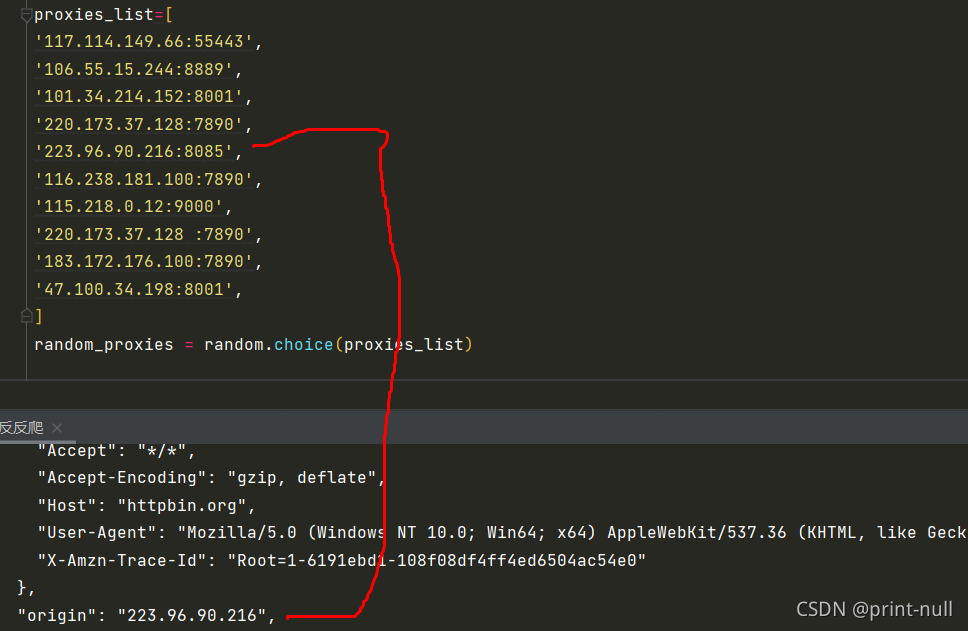

当我们访问频繁以后,网页会识别出我们是爬虫程序,他就会封禁我们的ip地址,我们可以通过创建ip池解决,现在免费的代理平台主要有快代理等,从平台获取了高匿ip地址以后我们可以自己创建ip代理池以突破服务器对我们的ip封禁,具体如下

这里采用了IP池,创建一个列表在列表里面存放多个ip地址,通过random随机从列表选择一个ip,在通过下一步组合为一个完整的ip地址

高匿名ip可以从快代理等平台获取

快代理

使用快代理ip主要关注ip,port,以及类型,写入ip池时格式为IP:PORT

**示例代码如下:

import requests

import random

# url地址

url='http://httpbin.org/get'

proxies_list=[

'117.114.149.66:55443',

'106.55.15.244:8889',

'101.34.214.152:8001',

'220.173.37.128:7890',

'223.96.90.216:8085',

'116.238.181.100:7890',

'115.218.0.12:9000',

'220.173.37.128 :7890',

'183.172.176.100:7890',

'47.100.34.198:8001',

]

random_proxies = random.choice(proxies_list)

# 创建headers

proxies = {'http' : random_proxies}

# user-agent

henders={'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.54 Safari/537.36'}

# 发送请求

res=requests.get(url,headers=henders,proxies=proxies)

# 打印结果

print(res.text)

随机休眠

我们没有设置随机休眠,爬虫程序对网页发起请求的频率都是固定的,也就是说访问非常机械有规律,比如固定一秒一个网页,这样运行久了以后服务器就会识别出来我们是爬虫程序不是人为操作,为了防止以上情况我们可以设置随机休眠,代码如下

所需库:time,random

time.sleep(random.randint(1,3))

当然反反爬措施远不止这一点,还有更多反反爬手段,后续将为打家持续更新