好久没有做爬虫测试,今天测试爬取网站素材上的图片,测试爬取前10页风景图片测试。

基本步骤:

1. 请求对象的定制

2. 获取网页源码

3. 分析图片的url,图片的名称

4.下载

爬取图片前做网页源码分析,进入主页https://sc.chinaz.com/

选择高清风景图片https://sc.chinaz.com/tupian/

进入后 url 为?https://sc.chinaz.com/tupian/fengjingtupian.html

下一页:?https://sc.chinaz.com/tupian/fengjingtupian_2.html

第三页:https://sc.chinaz.com/tupian/fengjingtupian_3.html

可看出规律,处理第一页特殊外,其它都是以_2,_3,_4…数字标注的HTLM页面。

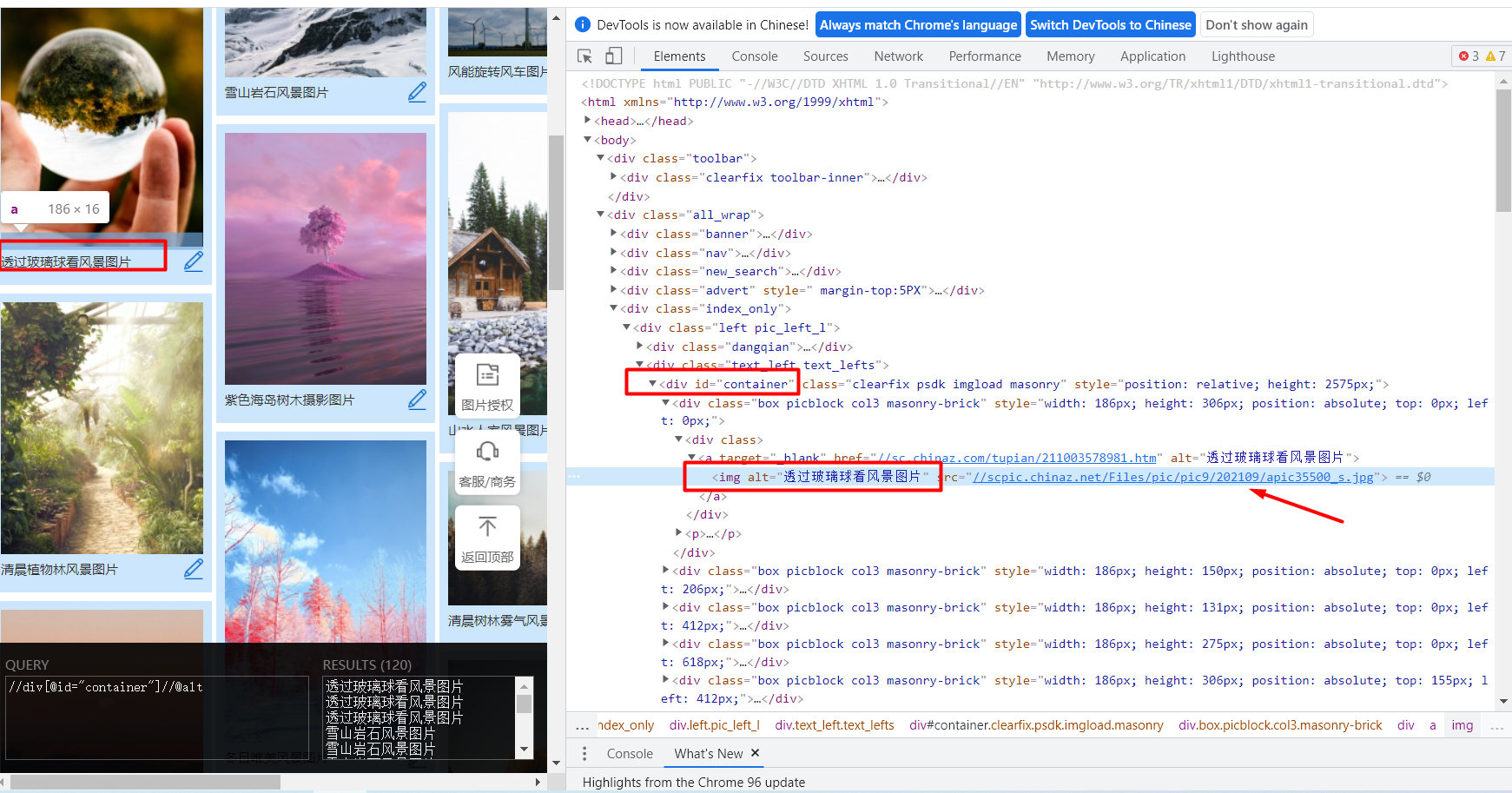

分析图片名称和图片源码,F12

使用Xpath 插件

获取名称://div[@id=“container”]//@alt

获取Src,执行需要改动以下即可://div[@id=“container”]//@src2

src是呈现后更新的,实际为Src2

网页源码分析完成,开始写代码:

第一步,导入库:

import urllib.request

from lxmlimport etree

第二步,定制请求对象:

def create_request(page):

if page==1:

url =‘https://sc.chinaz.com/tupian/fengjingtupian.html’

else:

url =‘https://sc.chinaz.com/tupian/fengjingtupian_’+str(page)+’.html’

headers = {

‘User-Agent’:‘Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.45 Safari/537.36’

}

request = urllib.request.Request(url=url, headers=headers)

return request

第三步,获取网页源码:

def get_content(request):

response = urllib.request.urlopen(request)

content = response.read().decode(‘utf-8’)

return content

第四步,下载图片:

def download(content):

tree = etree.HTML(content)

name_list = tree.xpath(’//div[@id=“container”]//@alt’)

src_list = tree.xpath(’//div[@id=“container”]//@src2’)# 图片底层懒加载

for i in range(len(name_list)):

name = name_list[i]

src = src_list[i]

url =“https:”+src

print(name, url)

urllib.request.urlretrieve(url=url, filename=’./Images/’+name+".jpg")

第五步,在主程序中执行上逻辑函数

if __name__ ==’__main__’:

start_page =int(input(“请输入起始页码”))

end_page =int(input(“请输入结束页码”))

for pagein range(start_page, end_page+1):

request = create_request(page)

content = get_content(request)

download(content)

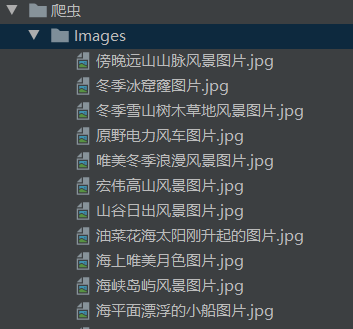

测试效果如下:

因为网速问题,实际测试1页的图片

截取部分信息,实际图片已经下载到Images文件夹

爬取图片成功。