论一只爬虫的自我修养

①

python如何访问互联网?

python的电池:urllib

urllib=url+lib

url:网页地址

url由三部分组成:

第一部分是协议:http,https,ftp,file,ed2k

第二部分是存放资源的服务器的域名系统或IP地址(有时候要包含端口号,各种传输协议都有默认的端口号,如http的默认端口为80)。

第三部分是资源的具体地址,如目录或文件名等。

urlib分为四个模块,主要学urllib.request,它最复杂,因为它包含对服务器的请求发出,跳转,代理等方面

用urlopen()函数打开网页

打开网址会返回一个对象

对象是获取的网页,然后用read()函数读取网页,因为直接读取返回的是二进制的代码,所以还要用decode()方法解码

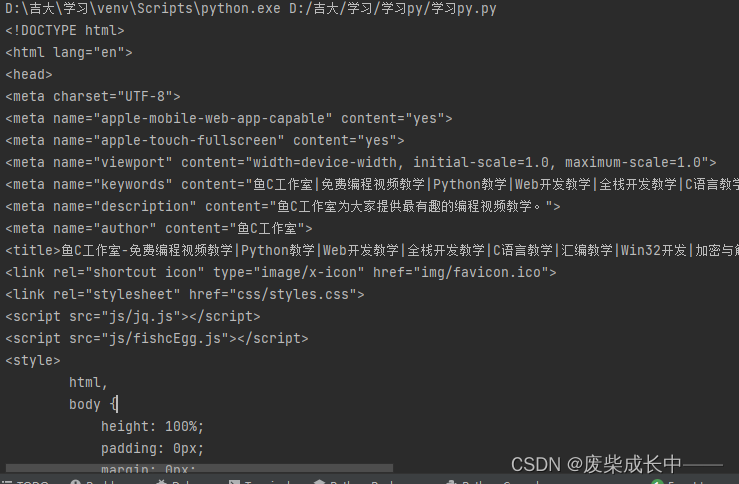

import urllib.request

response=urllib.request.urlopen('http://www.fishc.com')

html=response.read()

html=html.decode('utf-8')#将二进制解码

print(html)

插入一个小知识点,因为按照以前的f=open(路径,方式)的代码要加上try-finally来保证出错时也能关闭文件,是在繁琐,所以python引入了with语句来自动帮我们调用close()方法,和原来的try-finally是一样的,但是代码更加简洁,并且不必调用f.close()方法

如:

with open('路径','读写方式') as f:

print(f.read())

图片也是文件,不过它是由二进制数据组成的,所以待会open里的方式要写为’wb’