代码练习:

import requests #引用requests库

import re#引用re库

headers={'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36'}#模拟浏览器访问强求,在谷歌浏览器输入about:version即可获取

#自定义函数,设置网址和代理

def baidu(company,page):

num=(page-1)*10#变量定义

url='https://www.baidu.com/s?tn=news&rtt=4&bsst=1&cl=2&wd='+company+'&pn='+str(num)#rtt=1改rtt=4,把按焦点排序改成按时间排序,在末尾加&pn=str(num)作翻页作用

res=requests.get(url,headers=headers,timeout=10).text#获取的网页源代码,timeout()超时访问报错

# 正则表达式提取内容

p_source = '新闻来源:(.*?)"'

source = re.findall(p_source, res, re.S)

p_date = '发布于:(.*?)"'

date = re.findall(p_date, res, re.S)

p_href = '<h3 class="news-title_1YtI1"><a href="(.*?)"'

href = re.findall(p_href, res, re.S)

p_title = '标题:(.*?)"'

title = re.findall(p_title, res, re.S)

# title清洗并输出

for i in range(len(title)):

file1.write(str((page - 1) * 10 + i + 1) + '.' + title[i] + '(' + date[i] + '-' + source[i] + ')' + '\n') #这一行只写入标题,日期和来源,最后记得换行

file1.write(href[i] + '\n') # '\n'表示换行 ,这一行写入新闻链接

file1.write('——————————————————————————————'+ '\n')

companys = ['阿里巴巴', '万科', '京东', '恒大','百度','腾讯','碧桂园']#对列表中的关键词依次进行baidu()函数运行

for company in companys:

#由于要运行完一个关键词再写数据挖掘completed,所以要在列表循环用write()函数

file1 = open('F:\\05pycharm\\20220227学习\\7家公司的5页爬取信息.txt', 'a') # 新建txt文件,a为追加模式,w为写模式

file1.write('\n'+company + '数据挖掘completed!'+'\n'+'^^^^^^^^^^^^^^^^^^^^'+'\n'+'\n') # 用write()函数写入字符串

for i in range(5):#此处爬取5页,i是从0开始的,所以下面要写成i+1

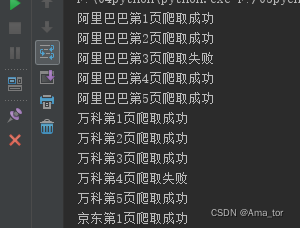

try:#(由于爬取数据比较多,用try/except函数能防止程序报错中断)

baidu(company, i + 1)

print(company + '第' + str(i + 1) + '页爬取成功')

except:

print(company+ '第' + str(i + 1) + '页爬取失败')

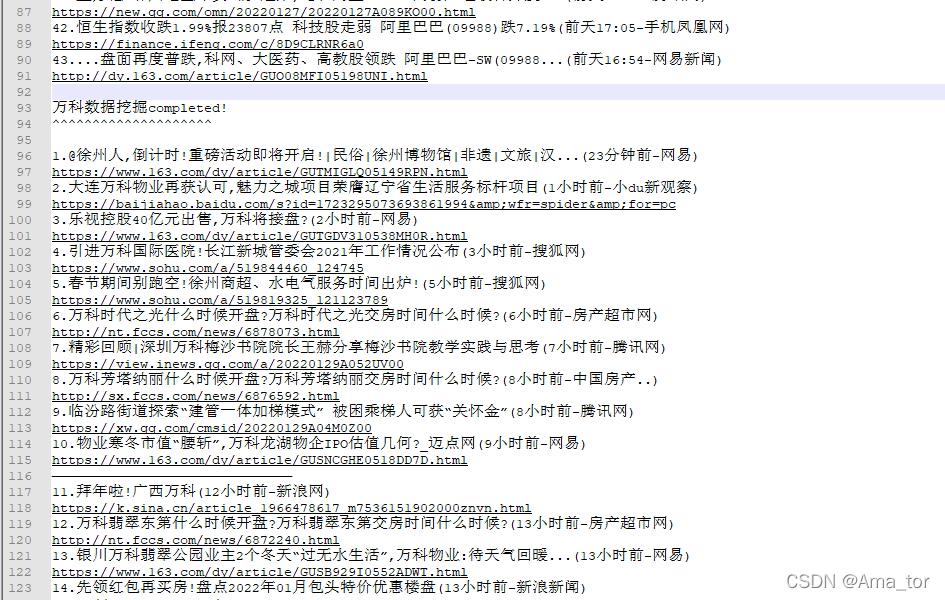

运行结果:

?

?