近期需要爬取一些关于银行的新闻,通过尚硅谷老师的讲课进行学习,然后应用到东方财富网和新浪财经,现在以新浪财经为例,记录一下学习成果(有一说一,尚硅谷老师教的真不错(>ω<)喵)。此部分只讲操作,具体scrapy框架原理可以自行学习和了解。

1.首先是scrapy的安装

正常pip install scrapy就行,可能会遇到各种各样的报错,把错误复制到百度,一堆解决方案,这里就不赘述了。

2.scrapy项目创建

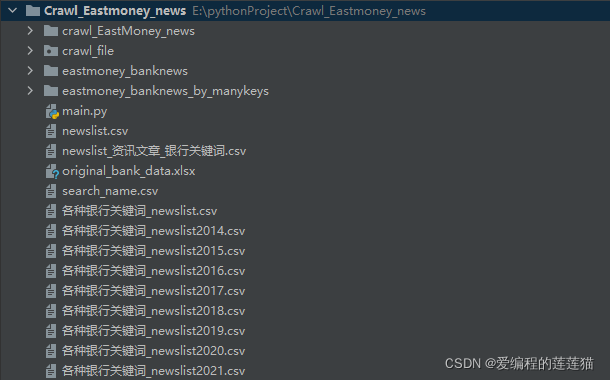

我想在E:\PythonProject\Crawl_Eastmoney_news下面创建,其中Crawl_Eastmoney_news是一个python工程

在终端中进入到E:\PythonProject\Crawl_Eastmoney_news路径,

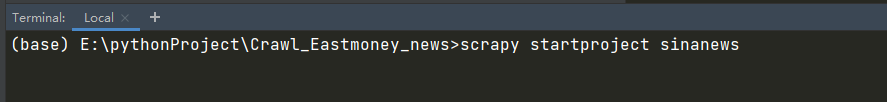

然后输入命令 scrapy stratproject sinanews

这里sinanews是我项目的名字,大家可以根据需要改成自己项目的名字

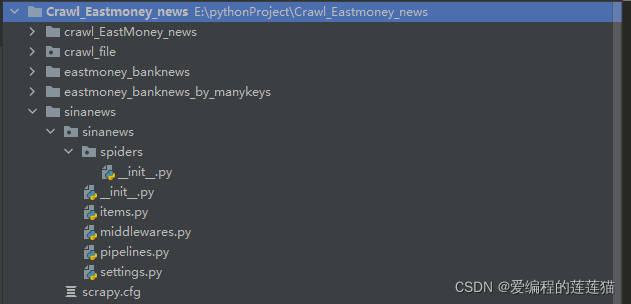

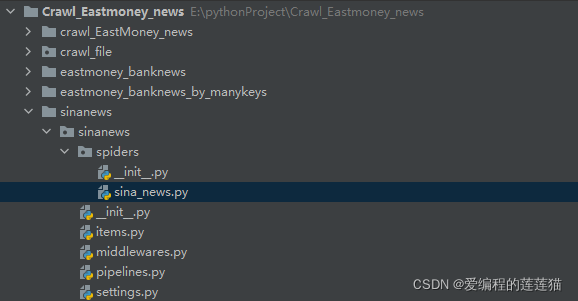

回车运行一下,可以发现此时Crawl_Eastmoney_news项目下多了一个目录,就是我们刚刚新建的sinanews,sinanews下会出现一个spider目录、一个items.py文件、一个middlewares.py、一个pipelines.py文件和一个settings.py文件

3.创建爬虫文件

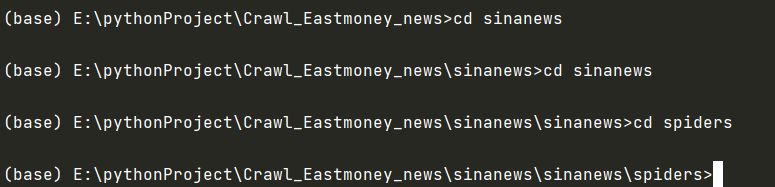

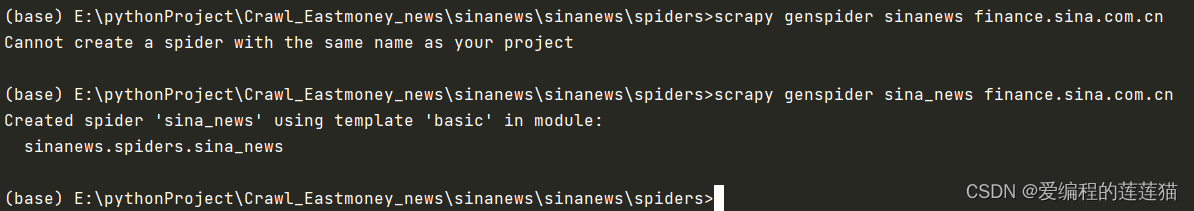

(1)首先在终端进入到spiders目录下

(2)终端输入 scrapy genspider sina_news finance.sina.com.cn

注意到sina_news是爬虫名称,不能跟爬虫项目名称sinanews一样

(3)结果

spiders下面会产生一个爬虫文件

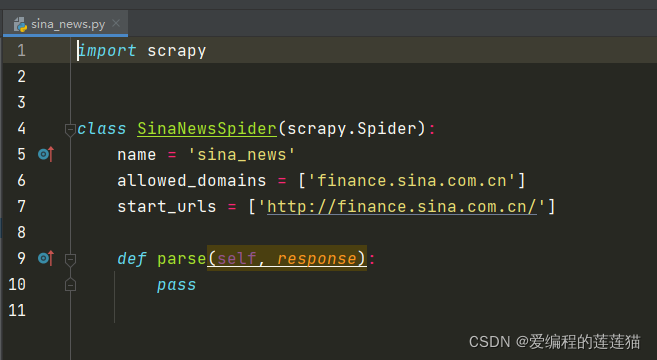

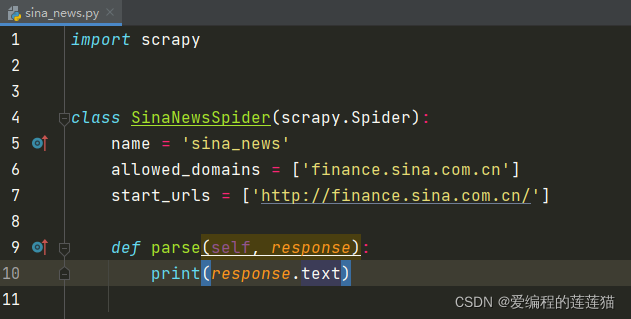

爬虫文件的内容如下:

4.对网站进行简单测试

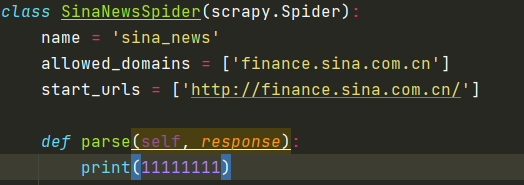

(1)修改parse

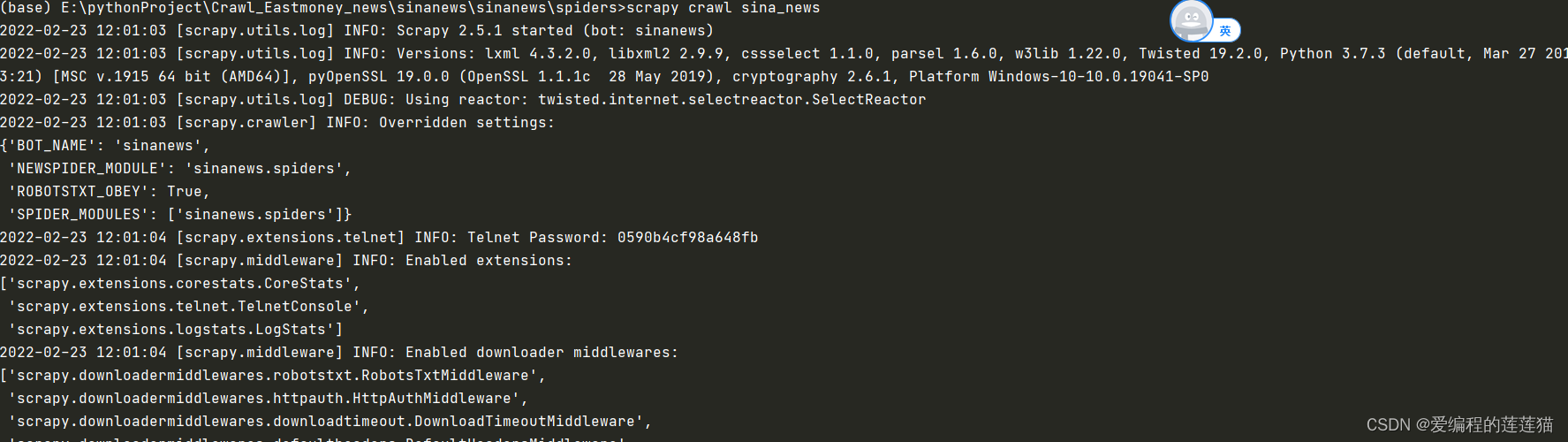

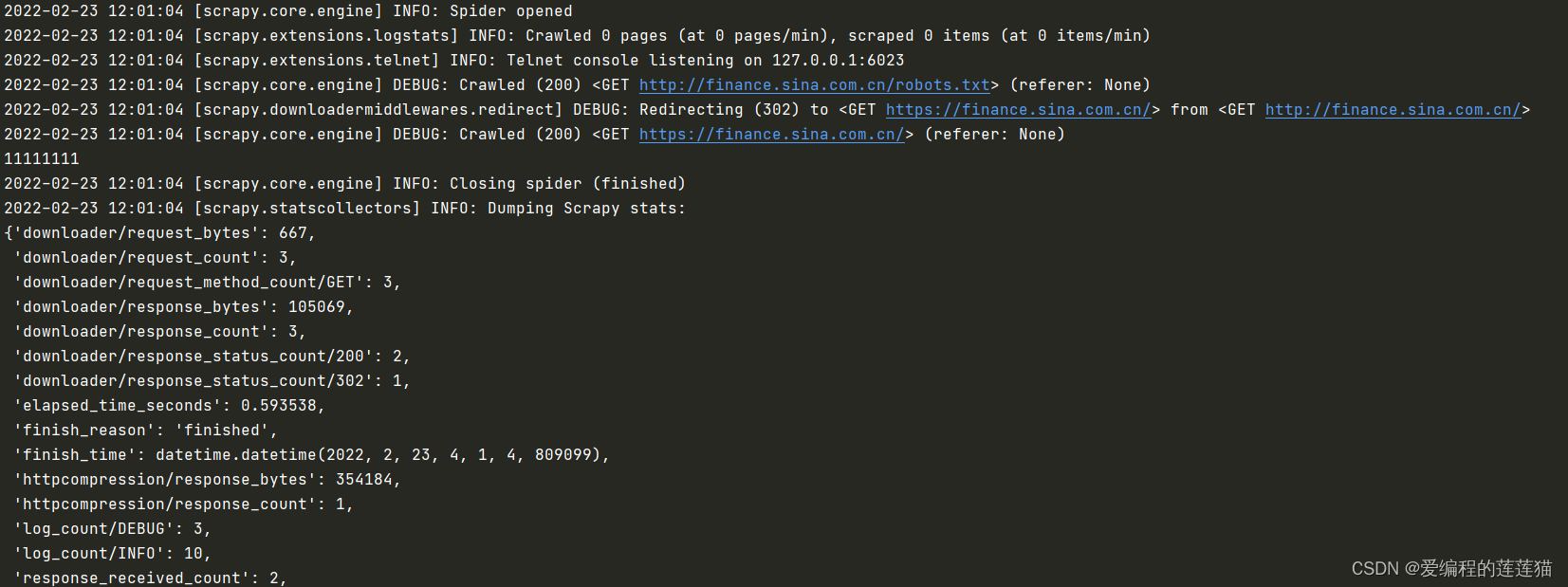

(2)运行scrapy crawl sina_news可以看到打印内容

如果不想看到这么多日志内容,可以在settings.py文件中加入:LOG_LEVEL = 'WARNING’

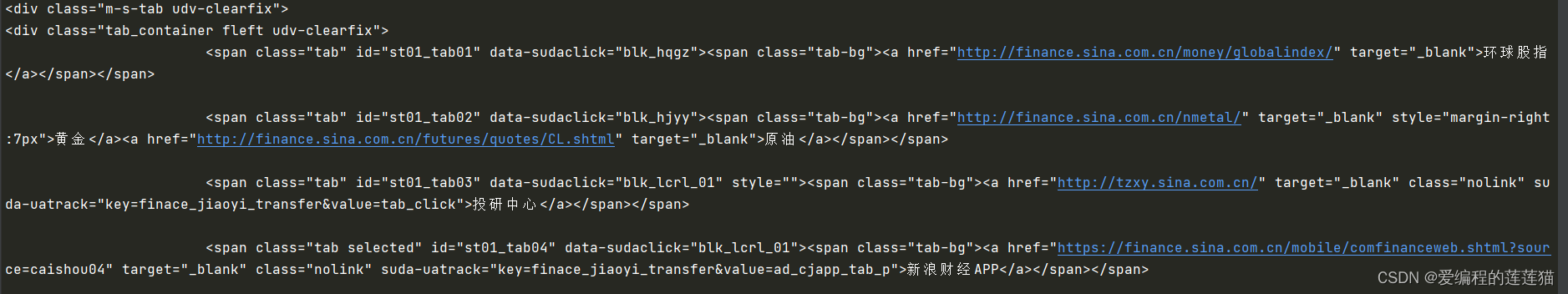

查看网页内容,则用response.text

可以在控制台或者终端查看到网页源码