TensorRT是可以在NVIDIA各种GPU硬件平台下运行的一个C++推理框架。我们利用Pytorch、TF或者其他框架训练好的模型,可以转化为TensorRT的格式,然后利用TensorRT推理引擎去运行我们这个模型,从而提升这个模型在英伟达GPU上运行的速度。速度提升的比例是比较可观的。

————————————————

版权声明:本文为CSDN博主「老潘的博客」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/IAMoldpan/article/details/117908232

0.根据我这边是踩坑实验结论

1.在windows是使用tensorrt加速还要通过python进行调用的话,需要选择tensorrt (windows版本) 8或以上的版本,然后才能在python里面如下进行调用

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

import tensorrt as trt

if __name__ == "__main__":

print(trt.__version__)

print("hello trt!!")

2.python版本用的话可以不需要使用vs2019进行编译,vs2019只是通过运行tensorrt加速模块里面的手写数字的例子进行验证用的

一.下载tensorrt安装包并移动文件

我上传的0积分tensorrt windwos下的8.2版本下载

————————————————————————————————

官网的tensorrt连接,可能要科学上网,连不上直接下载我上传的0积分的

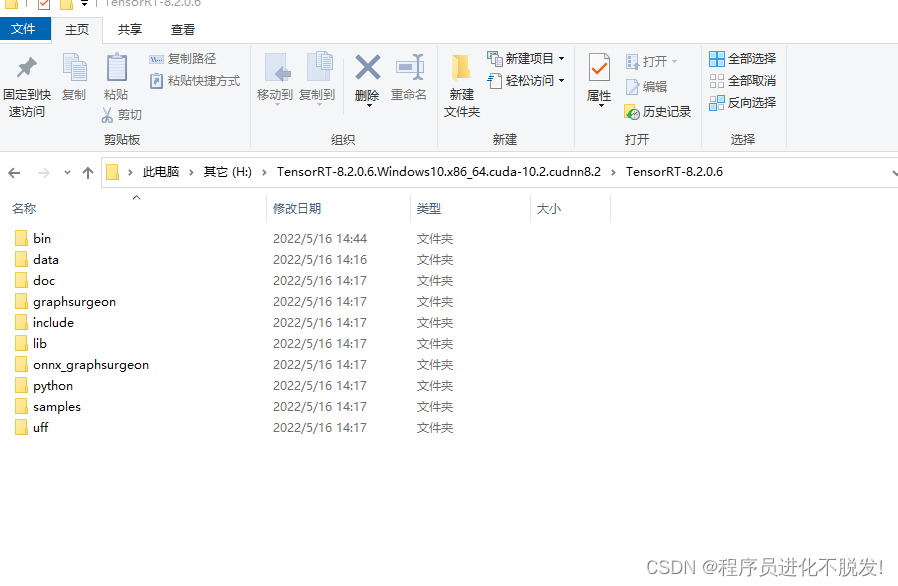

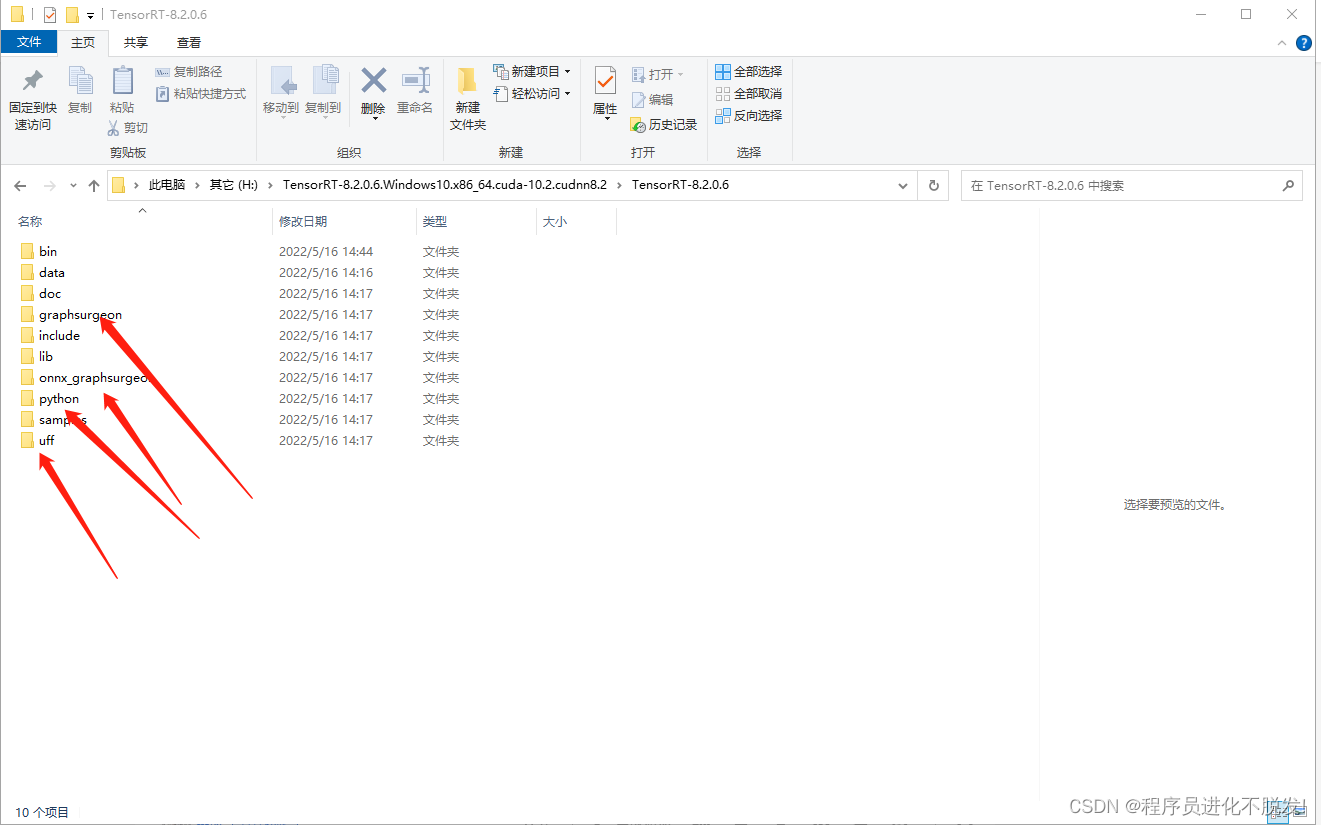

然后将下载好后的部分,

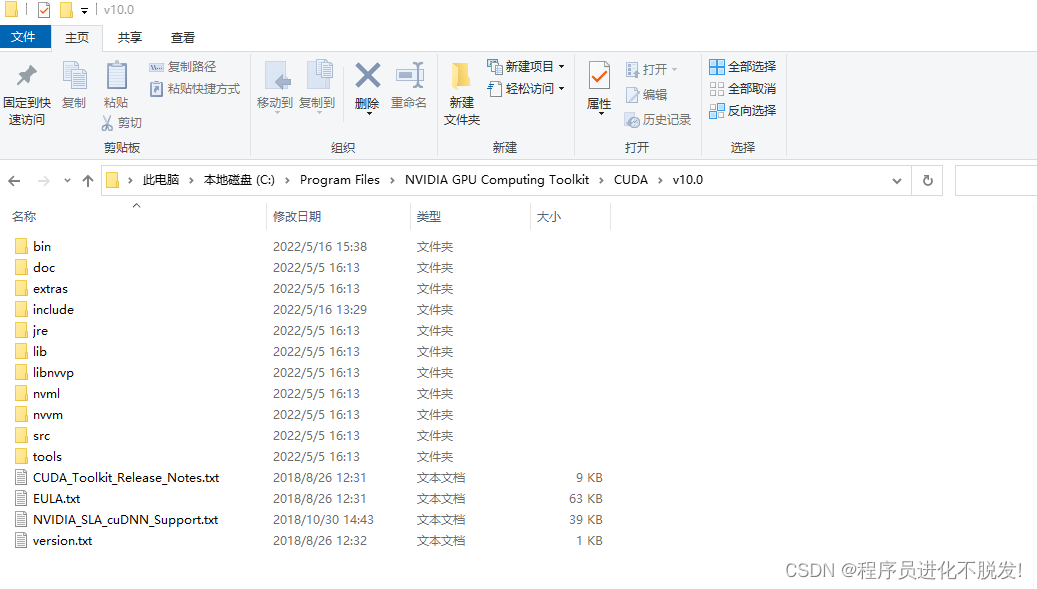

如我这的TensorRT-8.2.0.6文件夹中的include文件移动到你的CUDA文件夹下的include,我这是(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0),

如我这的TensorRT-8.2.0.6文件夹中的lib中的dll与lib文件分别放到CUDA下的bin与lib\x64文件夹中

否则按照别的链接里面说的为其添加环境变量

二.pip安装包内的whl文件

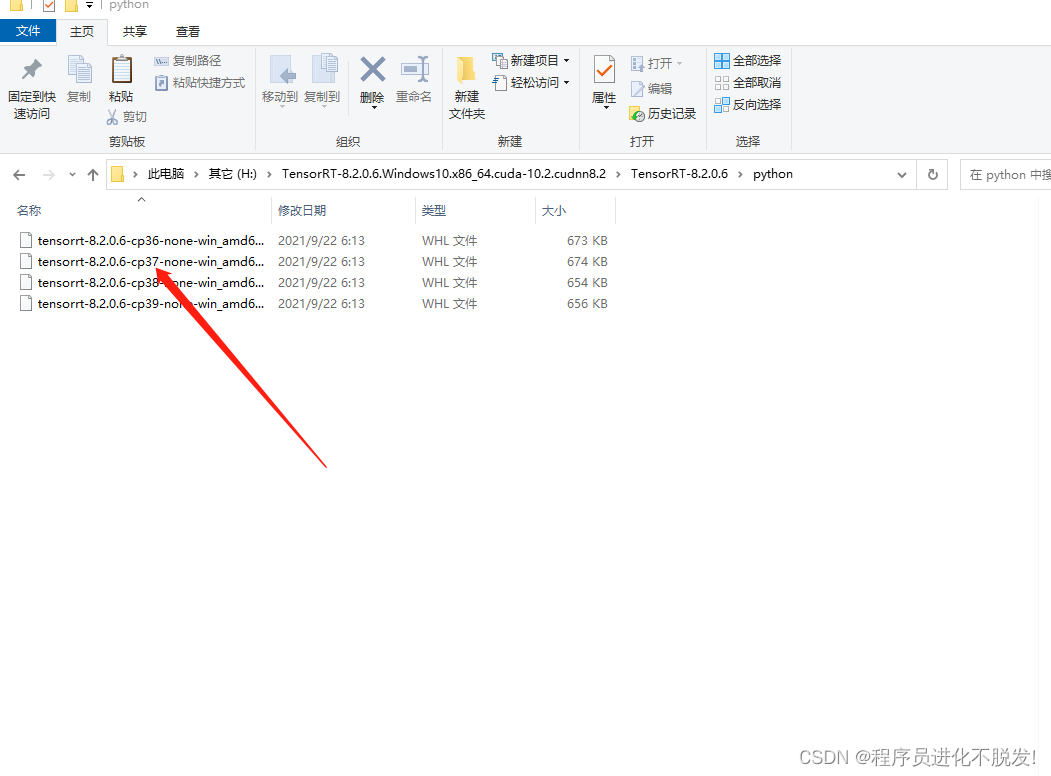

一共需要安装4个whl文件如下箭头的文件夹里面,安装方式如下,注意安装tensorrt的whl的时候,要根据你python环境来,我这里是3.7版本,所有就选的cp37

pip install tensorrt-8.2.0.6-cp37-none-win_amd64.whl

三.运行例子

如果你运气好的话就可以成功运行下面的了,也就代表tensorrt安装好了

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

import tensorrt as trt

if __name__ == "__main__":

print(trt.__version__)

print("hello trt!!")

然而我运气比较差,报错说缺了一堆dll文件,具体在bin文件夹下

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0\bin

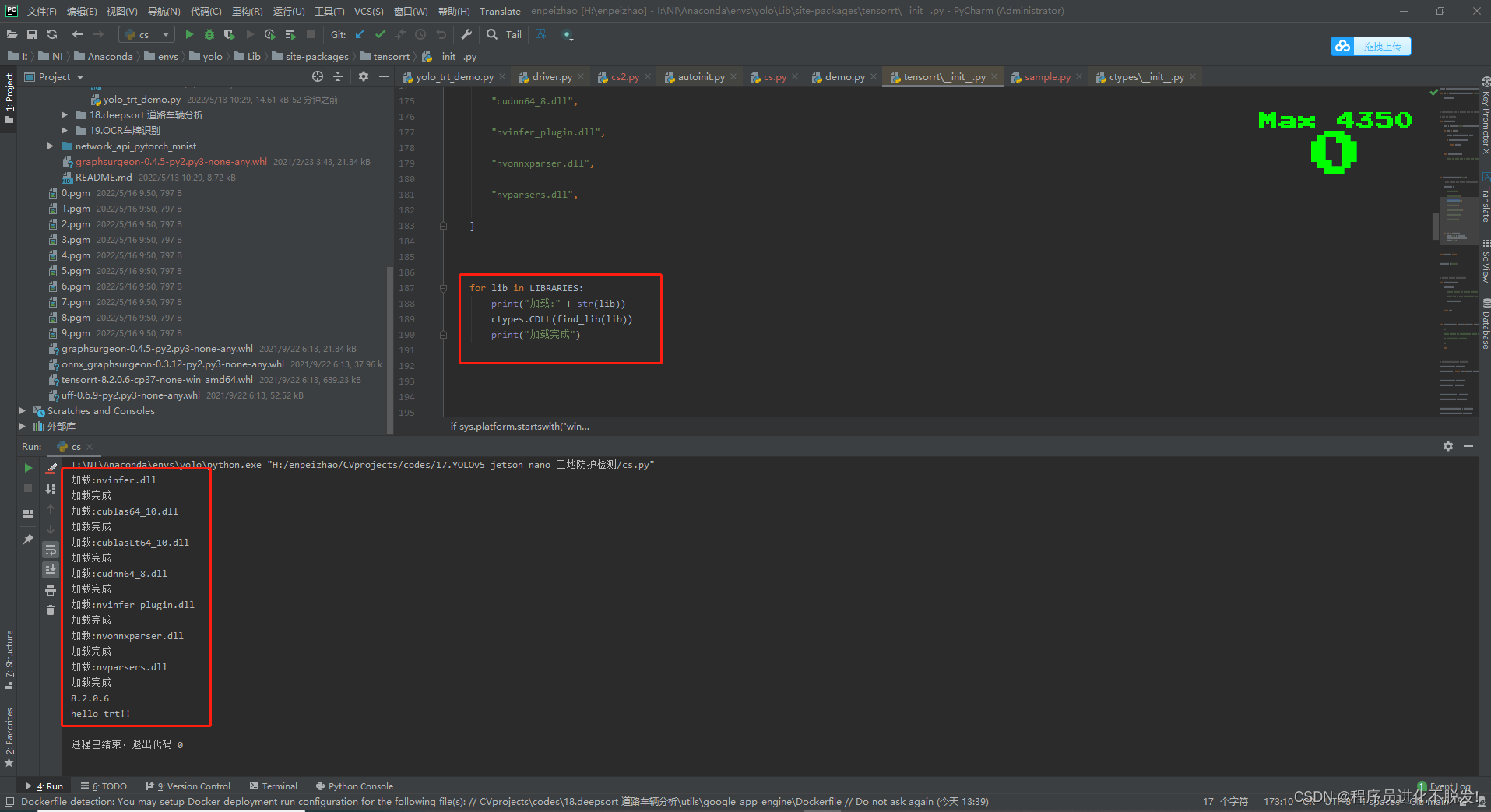

如下我直接该改了加载dll文件的那部分代码(报错后你点击报错点可以直接跳过去的哈,不要傻乎乎的按照我下面的路径翻),打印了下加载的那个部分,然后缺什么dll补什么dll进bin文件夹里面…

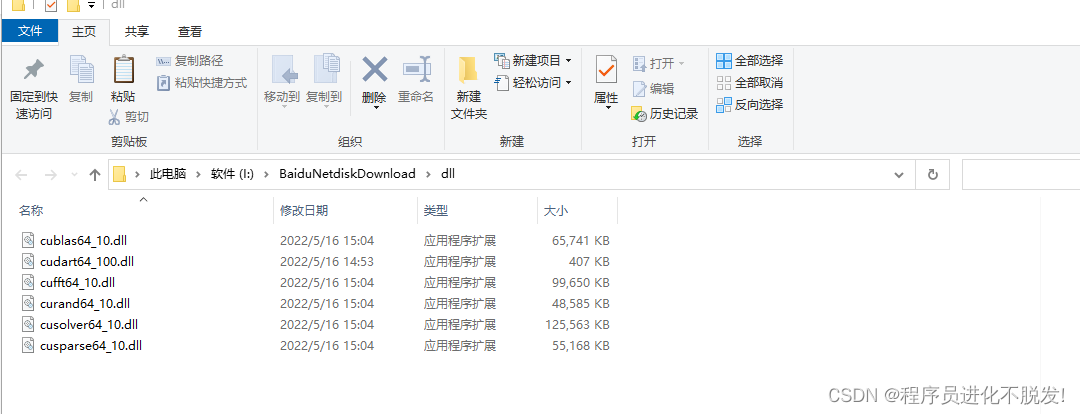

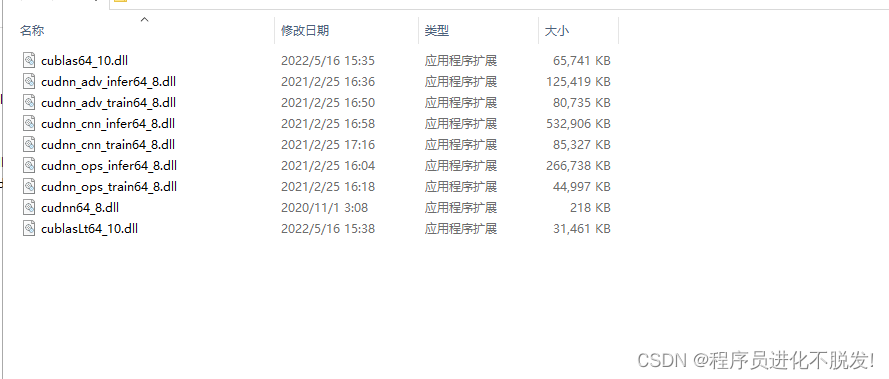

以下图片内容就是我上传的dll文件,下载自取,缺啥补啥

我打包的dll文件

——————————————————————————

dll文件缺失查找网址

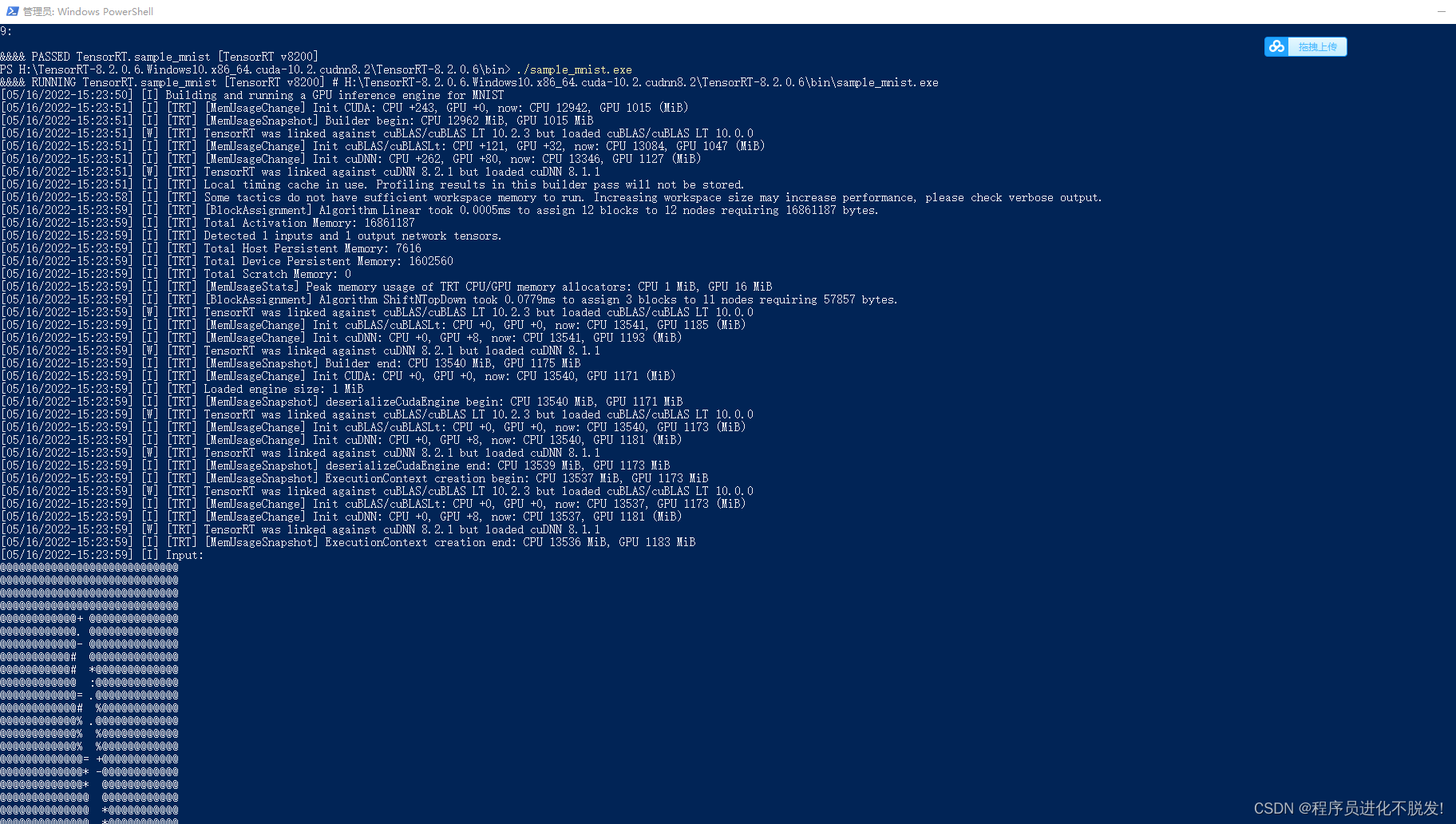

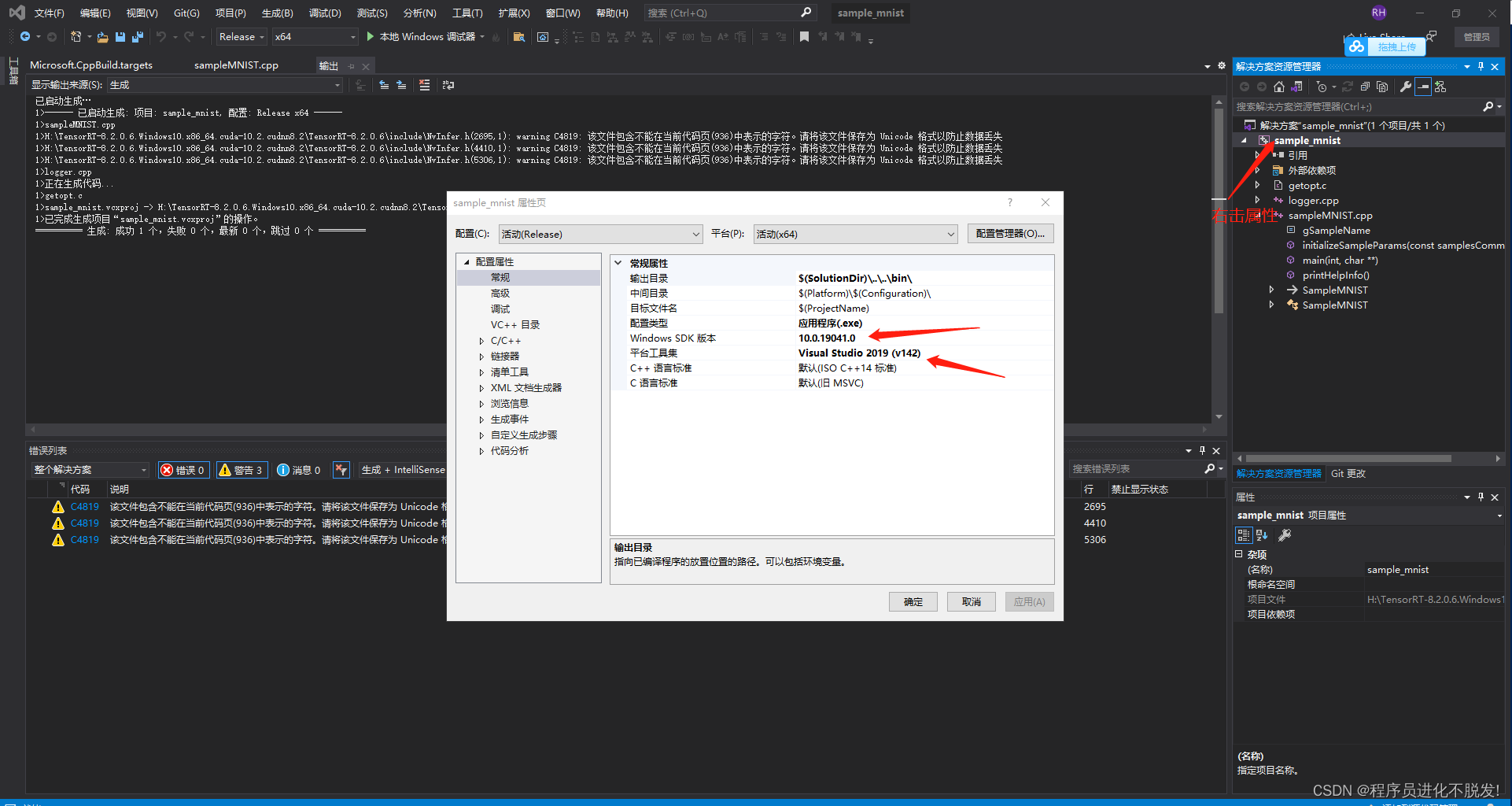

补VS2019验证

上面成功了也可以不验证,不过如果还是出错搭建个这个环境验证下也行

成功如下效果

注意vs2019里面配置弄对,不然 右击生成不出来

参考链接: