前言

昨天geekbyte大佬发布了篇文章 ,文章名是 python完美突破tls/ja3。过程是先编译curl-impersonate,编译成功后再继续编译 spike 大佬魔改过的pycurl,最后用编译好 pycurl 去访问 https://tls.peet.ws/api/all 来进行测试是否编译成功。(感兴趣的小伙伴们可以根据文章试下手动编译)

原文链接:https://mp.weixin.qq.com/s/GU2AgushvIEtLHtYR7BQzg

就当我跃跃欲试的时候,有个大佬(帝国皇家近卫军),把编译好的直接打包发到了 pypi 社区。也就是说,我们只需要pip install 库,就可以直接用了!你没有听错,可以直接用,不需要再进行任何麻烦的编译操作。

教程原链接:https://github.com/synodriver/pycurl/blob/master/special.markdown

Q佬的文章:python完美突破tls/ja3(docker版),文章链接:https://mp.weixin.qq.com/s/UZlLuzlQZrI7w82HI7zGuw

正文

准备环节

1.环境准备:vmware + ubuntu 22.04(建议直接使用ubuntu最新版。kali有问题,不建议使用)

2.带上双手(真·有手就行)

上手环节

ubuntu22.04版本虽然自带了python3.10,但是没有pip,我们需要先更新下apt,然后下载pip。

apt update

apt install pip

然后直接一键安装大佬提供好的库

pip install pycurl-antitls==7.45.3rc1

安装好了以后还有一个简单的小步骤,需要移动一个文件到usr的lib文件夹下。大佬甚至贴心的附上了代码。

import sys

import os

base = os.path.join("/usr/local", "lib", "libcurl-impersonate-chrome.so")

with open(base, "rb") as inp, open("/usr/lib/libcurl-impersonate-chrome.so.4","wb") as out:

data = inp.read()

out.write(data)

libcurl-impersonate-chrome.so 这个文件是在 python3.10 同级目录下,然后我的 python3.10 是在/usr/local/lib 文件夹下,所以 libcurl-impersonate-chrome.so也在这。

然后就,就结束了…

因为我科学上网没弄好,没能成功访问测试网站。所以拿了猿人学练习平台的几道题进行了测试,直接通杀了,真是嘎嘎猛啊。

测试代码如下(写的有点随便,但问题不大),请小伙伴们自行修改访问的网址

import pycurl

import json

from requests import Session

# 打印看下pycurl的版本是否和文章中的一致

print(pycurl.version)

result = 0

def my_func(data):

global result

d = json.loads(data)['data']

for i in d:

result += int(i['value'])

print(result)

headers = [

'Host: www.python-spider.com',

'accept: application/json, text/javascript, */*; q=0.01',

'accept-language: zh-CN,zh;q=0.9',

'content-type: application/x-www-form-urlencoded; charset=UTF-8',

'cookie: Cookie不能公开~',

'origin: https://www.python-spider.com',

'referer: https://www.python-spider.com/challenge/29',

'sec-ch-ua: ".Not/A)Brand";v="99", "Google Chrome";v="103", "Chromium";v="103"',

'sec-ch-ua-mobile: ?0',

'sec-ch-ua-platform: "Windows"',

'sec-fetch-dest: empty',

'sec-fetch-mode: cors',

'sec-fetch-site: same-origin',

'user-agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.0.0 Safari/537.36',

'x-requested-with: XMLHttpRequest'

]

curl = pycurl.Curl()

curl.setopt(

curl.SSL_CIPHER_LIST,

'TLS_AES_128_GCM_SHA256,TLS_AES_256_GCM_SHA384,TLS_CHACHA20_POLY1305_SHA256,ECDHE-ECDSA-AES128-GCM-SHA256,ECDHE-RSA-AES128-GCM-SHA256,ECDHE-ECDSA-AES256-GCM-SHA384,ECDHE-RSA-AES256-GCM-SHA384,ECDHE-ECDSA-CHACHA20-POLY1305,ECDHE-RSA-CHACHA20-POLY1305,ECDHE-RSA-AES128-SHA,ECDHE-RSA-AES256-SHA,AES128-GCM-SHA256,AES256-GCM-SHA384,AES128-SHA,AES256-SHA'

)

curl.setopt(curl.HTTP_VERSION, curl.CURL_HTTP_VERSION_2_0)

curl.setopt(curl.SSLVERSION, curl.SSLVERSION_TLSv1_2)

curl.setopt(curl.SSL_ENABLE_NPN, 0)

curl.setopt(curl.SSL_ENABLE_ALPS, 1)

# curl.setopt(curl.SSL_FALSESTART, 0)

curl.setopt(curl.SSL_CERT_COMPRESSION, "brotli")

curl.setopt(pycurl.HTTP2_PSEUDO_HEADERS_ORDER, "masp")

curl.setopt(pycurl.HTTPHEADER, headers)

# my_func是处理数据返回的回调事件

curl.setopt(pycurl.WRITEFUNCTION, my_func)

url = 'https://www.python-spider.com/api/challenge29'

for i in range(1, 101):

data = "page={}".format(i)

curl.setopt(pycurl.POSTFIELDS, data)

# curl.setopt(curl.PROXY, 'https://127.0.0.1:xxxx')

curl.setopt(pycurl.URL, url)

curl.perform()

curl.close()

战果

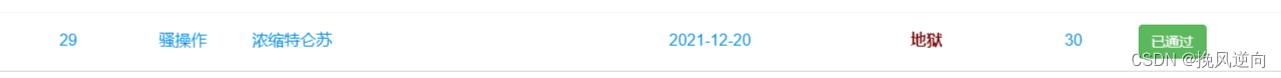

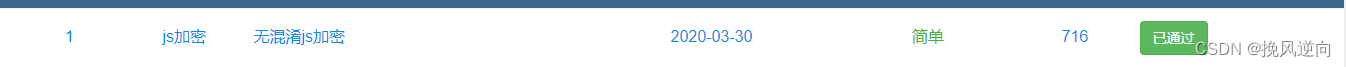

从这点稀疏的过关人数就能知道,在这之前,这一块的难度是多么高。来对比下第一道题的过关人数

致谢

我对tls、ja3这一块还不怎么了解,然而大佬们已经为大家铺平了道路。真心感谢大佬们的辛勤付出,为爬虫er们降低了学习门槛。