由于学习需要,搜索引擎项目中要加入爬虫功能,便开始了初识爬虫之路,因为目前只是学习需要,故我的思路比较简单,就是将多个搜索网站搜索某一关键词得到的网页链接同时存入我的本地数据库即可,同时去重(这个可用线程锁或者set集合来实现)。这里只用一个搜索网站(光明网https://zhonghua.cloud.gmw.cn/)举例。

需要的Python模块:requests(爬虫主体)、re(正则获取)、json(字符串转json)。

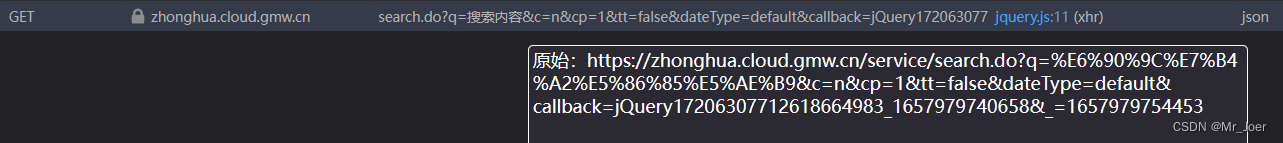

首先要通过浏览器或者抓包工具获取到该网站返回的数据集:

?然后要把这只爬虫包装地更拟人化,即加上一些用户消息头(User-Agent、Cookie、Host)(加上User-Agent可以防止一些网站的反爬机制):

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:101.0) Gecko/20100101 Firefox/101.0',

'Cookie':'user=null; _ga=GA1.2.583868995.1654254451; _gid=GA1.2.521556273.1654254451',

'Host':'zhonghua.cloud.gmw.cn',

}?之后就可以调用requests模块中的get方法来获取响应数据并设置编码格式(注意顺序):

res = requests.get(url,headers=headers)#获取响应

res.encoding = 'utf-8'注:获取的响应res后,res.status_code可以查询请求状态码(200,404等)

经过几番周折,我发现该网站使用jsonp格式的消息作为查询数据包,我们需要将其转为规范的json格式才能用json模块将字符串转为json字典。

- jsonp与json的区别

- 从光明网获取的jsonp:

jQuery17207559889411706068_1654337198082({"isBlock":false,"result":{"statistics":"3012万","total":"349","count":"349","cost":"104","list":[{"articleid":35851267,"title":"东北煤城跑出绿色转型“加速度”","url":"https://tech.gmw.cn/2022-06/30/content_35851267.htm","synopsis":"杨扬、\u003cb\u003e王\u003c/b\u003e\u003cb\u003e濛\u003c/b\u003e、孙琳琳、范可新等多位冬奥冠军从这里走向世界 ...","coverPic":"","master":"新华网","pubtime":"2022-06-30 17:23:00","count":"349","cost":"104"},{"articleid":1303009447,"title":"中国奥委会授予七台河“奥运冠军之城”纪念奖杯","url":"https://m.gmw.cn/2022-06/22/content_1303009447.htm","synopsis":"七台河市曾先后培养输送了10位世界冠军,我国在历届冬奥会获得的22枚金牌中,7枚金牌和七台河有关,先后涌现出杨扬、\u003cb\u003e王\u003c/b\u003e\u003cb\u003e濛\u003c/b\u003e、孙琳琳、范可 ...","coverPic":"","master":"中国新闻网","pubtime":"2022-06-22 13:20:56","count":"349","cost":"104"}]},"keywords":"王濛","searchItem":{"timeOrder":true,"adv":false,"title":false,"fuzzyMatch":false},"page":{"totalCount":349,"numPerPage":10,"pageNumShown":10,"currentPage":1,"pageCount":0},"dateType":"default"})

?由于规范的json数据格式只有键值对(值可以为字典),故要将“jQuery17207559889411706068_1654337198082({})”内层花括号中的键值对用正则表达式取出来。

由正则的语法知,匹配字符串中最外层花括号的表达式为:

.*?(\{.*\})?????????????? 注意不要有^$开始与结尾标志

?提取出标准的json格式后,再通过json库的loads方法将json字符串转为字典,就可以通过键值对调用爬取到的内容啦

html = re.match('.*?(\{.*\})',res.text,re.S).group(1)

jList = json.loads(html)循环将有关数据读出并存入数据库:

for i in range(0,5):

info = jList['result']['list'][i]['synopsis'].replace('<b>','').replace('</b>','')

title = jList['result']['list'][i]['title']

url = jList['result']['list'][i]['url']

Message.objects.create(title=title,url=url,info=info,keyPerson=keyword)完整的方法定义如下:

def crawler(request):

if(request.method == 'POST'):

keyword = request.POST['keyword']

#执行爬虫操作

url = 'https://zhonghua.cloud.gmw.cn/service/search.do?q=+'+keyword+'+&c=n&cp=1&tt=false&dateType=default&callback=jQuery17207559889411706068_1654337198082&_=1654337198381'

#添加消息请求头

headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:101.0) Gecko/20100101 Firefox/101.0',

'Cookie':'user=null; _ga=GA1.2.583868995.1654254451; _gid=GA1.2.521556273.1654254451',

'Host':'zhonghua.cloud.gmw.cn',

}

res = requests.get(url,headers=headers)

html = re.match('.*?(\{.*\})',res.text,re.S).group(1)

jList = json.loads(html)

for i in range(0,5):

info = jList['result']['list'][i]['synopsis'].replace('<b>','').replace('</b>','')

title = jList['result']['list'][i]['title']

url = jList['result']['list'][i]['url']

Message.objects.create(title=title,url=url,info=info,keyPerson=keyword)

return rect('/')

if(request.method == 'GET'):

return render(request,'Testapp/crawler.html')