1?Logistic回归

1 二分类及符号引入

Logistic回归是一种用于二分类的算法,以特征向量为输入,输出预测结果y的值为0或1的问题被称为二分类问题,下面先引入一些符号以方便后面的学习:

: 表示一个

维数据,作为输入数据,维度为

;

: 表示输出结果,取值为0,1之间的一个;

?:表示第i组样本数据,有可能是训练集,也有可能是测试集,但是学习时默认是训练集;

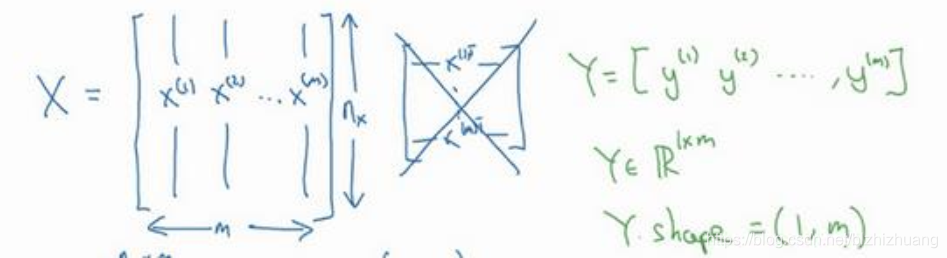

: 表示所有训练集数据的输入值,放在一个

的矩阵中,其中m为样本数目;

: 表示对应所有预测结果的输出值,维度为

。

我们的样本数据X由一个矩阵表示,输出结果Y也由一个矩阵表示:

2?逻辑回归

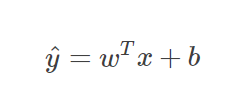

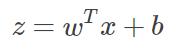

逻辑回归中我们所要预测的值是一个概率值?,表示的是预测值为1的概率,其取值范围为0到1之间的某个值,这与二分类中输出0或1的整数值不一样。如果我们使用线性模型对这个问题进行描述,同时引入参数w,b,w的维度是

,即

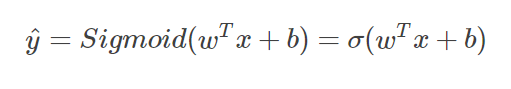

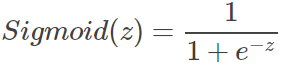

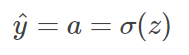

需要注意的是上式中输出是整个实数范围,而逻辑回归的要求是范围在[0,1]之间,因此我们引入了Sigmoid函数,让逻辑回归的结果被限制在我们所需要的范围,这样,完整的输出公式就是:

Sigmoid函数是一种非线性的S型函数,它的特点是将输出限制在[0,1]之间,因此常用于神经网络之中作为激活函数使用,其表达式如下所示

3?逻辑回归的代价函数

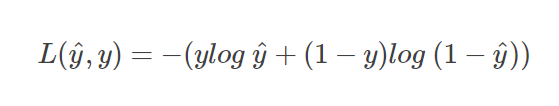

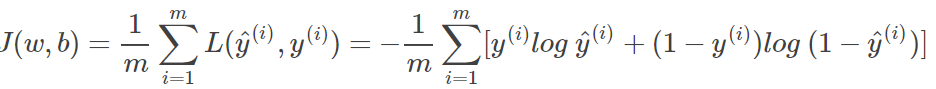

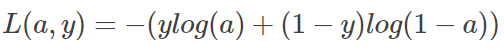

我们引入了假设函数用来描述逻辑回归问题后,需要获得参数w,b,通过训练代价函数来获得较为精确的参数,如何定义m个样本的代价函数?我们首先从单个样本出发,按照以前的学习经验,通常使用的是预测值与实际值做差平方求和的方式,但是对于逻辑回归,这样的代价函数是非凸函数,在使用梯度下降算法时,容易陷入局部最优,因此,我们构建了另一种代价函数来评判预测输出和真实输出的接近程度:

这个代价函数针对的是单个样本,对于整个训练集,代价函数可以表示为

在得到代价函数值后,我们的目标就是迭代求得最合适的w和b,最小化代价函数,从而使代价函数值尽可能归零。

逻辑回归问题实际上是一个最简单的神经网络,它只有一个神经元,因此我们通过学习逻辑回归开始进入神经网络的学习。

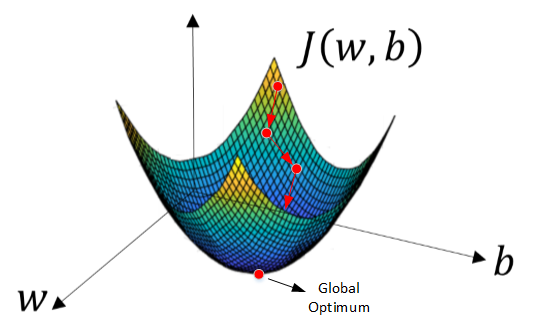

?4 梯度下降

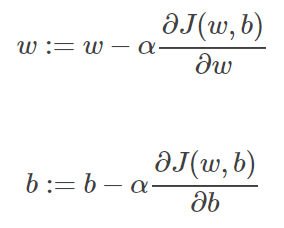

梯度下降先随机初始化一组参数w,b的值,然后每次迭代的过程都是通过公式更改w,b的值,具体而言就是沿着w,b的梯度方向反向前进,不断迭代更新,使之趋于全局最优解,其下降的过程如图所示:

每次迭代更新的过程,w,b的表达式为

上式中α是学习因子,表示每次梯度下降的中改变参数值的幅度。

5?计算图

神经网络的训练过程实际上可以分为两个过程:正向传播和反向传播。正向传播是指从输入到输出的计算过程,反向传播是指从输出到输入,对参数w,b计算梯度的过程,下面我们通过计算图的形式来理解这两个过程。

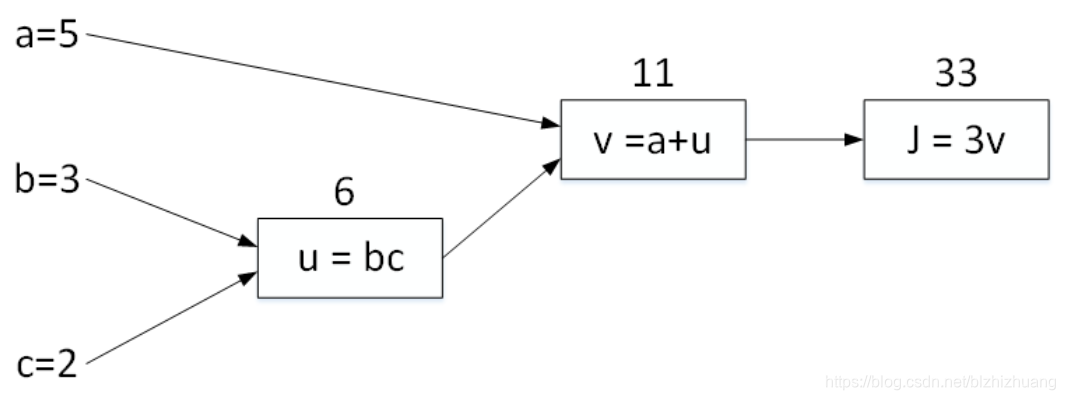

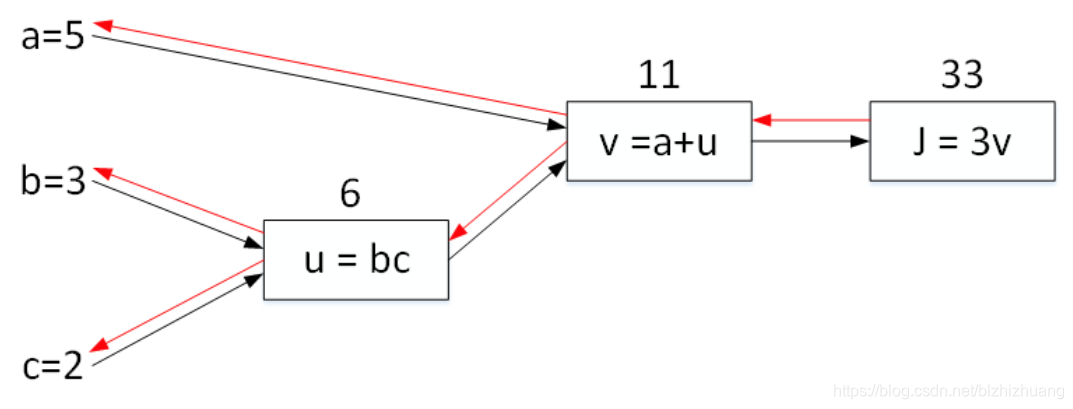

现有函数J(a,b,c)=3(a+bc),设变量u=bc,v=a+u,j=3v,我们可得计算图如下所示

图中自左往右,从输入到输出的计算过程就是正向传播。而颠倒此过程,从右往左,从输出到输入的过程被称为反向传播,仍然以上图的例子为例。

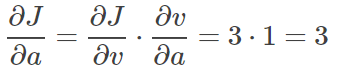

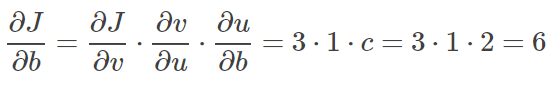

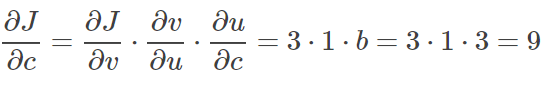

首先从最后一个过程开始,计算J对a的偏导,由链式法则可知

?其它J对bc的偏导同上

这个过程用图像表示为

6 逻辑回归的梯度下降过程?

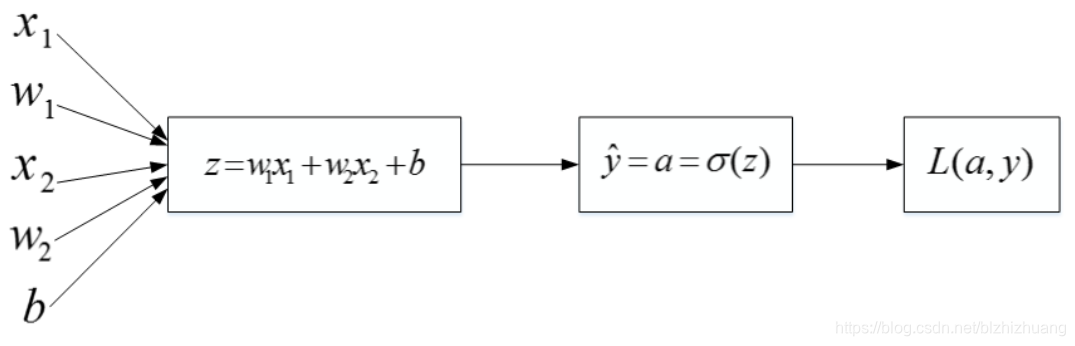

在学习了计算图之后,可以利用计算图对梯度下降过程分析,并计算所需的参数偏导,对于单个样本,逻辑回归的代价函数表达式如下

假设输入特征向量有两个特征?,则

?,由此得计算图如下所示

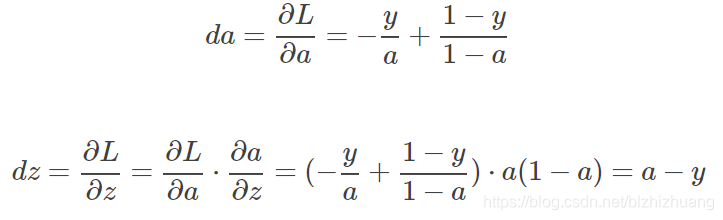

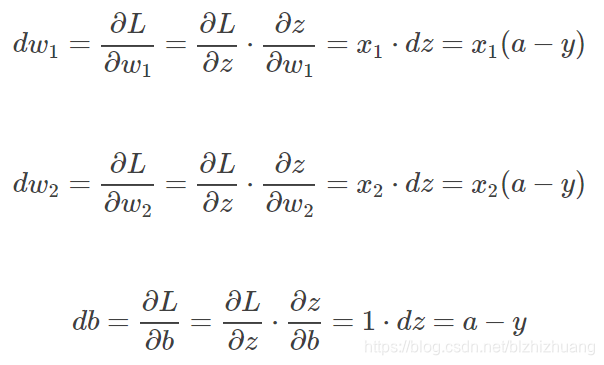

和上面的计算过程一样,利用链式法则可得

在求出偏导后代入梯度下降公式即可得参数的更新表达式

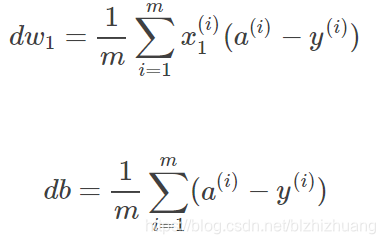

对于m个样本的训练集而言,偏导数表达式可以写成所有偏导数和的均值形式

?