卷积神经网络(CNN)

1. 卷积核(convolutional kernel)----对某个局部的加权求和

- 一般为奇数大小

- 厚度对应通道数(channel),对应后一层的feature maps数

- –11卷积核降维(example:当输入为661,通过111卷积核,输出仍为661矩阵。若输入6632(多通道),卷积核仍然为111,输出就变为66*1,实现降维)【发生在卷积核个数小于输入channel时,输出通道数等于卷积核个数】

- —1*1卷积核(只会改变输出的通道数,不会影响输出特征高和宽)【实现了通道间的信息交互】

2. 池化(pooling)—对局部特征进行聚合寻找全局特征-----升维或降维

3. 全连接层(FC)—全连接层每一个结点都与上一层所有节点相连,将上一层的多维特征图转化成固定长度的特征向量,丢失位置信息,但组合了最具特征的图像特征,用于后续的softmax分类【将前面所有提取到的特征综合起来,参数是网络参数中最多的】【需要固定尺寸的输入】需要固定尺寸的输入

对于前层是全连接层的全连接层,转化为11的卷积

对于前层是卷积层的全连接层,转化为hw的卷积(h、w为前层卷积结果的高和宽)

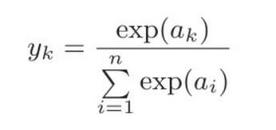

4.softmax函数

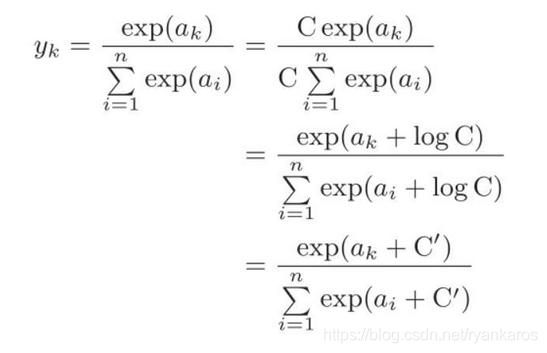

yk=第k个神经元的输出 ak=第k个神经元的输入指数 ai=所有输入信号指数和

加入常数C,放入指数项中logC,可以防止指数爆炸,出现溢出(一般C为输入信号最大值)

softmax输出为0-1间的实数,总和为1,使用输出值最大的神经元对应的类别作为识别结果

输出神经元的数量为需要分类的类别数

5. 为什么使用卷积?

A: 对于大量的输入数据,使用卷积可以有效地减少CNN中参数的数量

6. 为什么要用多个小卷积核,而不是使用一个大的卷积核?

A: 可以获得相同范围的感受野,且较小卷积核计算量小。更多的核需要使用更多的滤波器,使用更多的激活函数,使得CNN获得更有区分性的映射函数

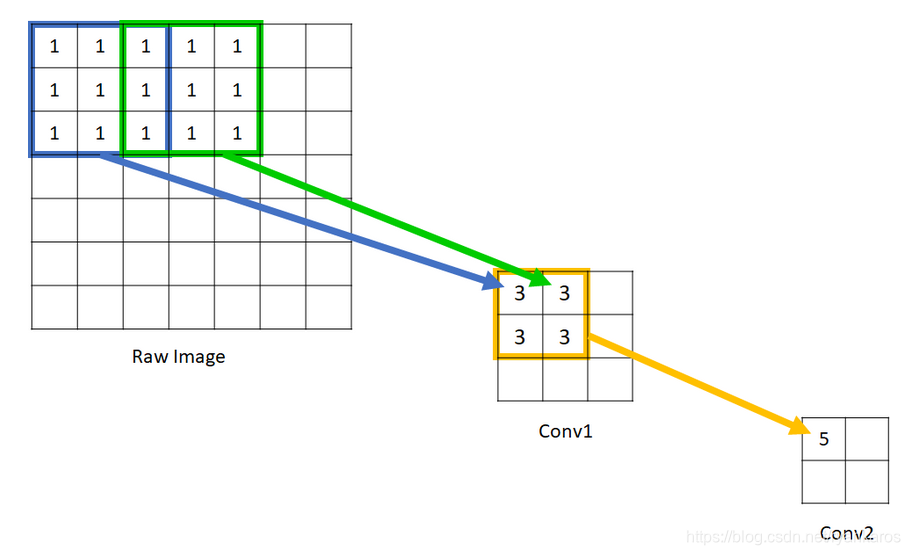

(感受野receptive field):表示网络内部不同位置的神经元对原图像的感受范围大小,感受野越大,能接触到原始图像的范围越大,越有全局和语义信息。感受野越小,趋向局部和细节。【每一层输出的feature map上的像素点在原图上的映射区域大小】

7. Dropout(防止过拟合的技术)

- 一种正则化方法(在损失函数上加入某种规则,缩小解空间,减少出现过拟合可能性)

- 方法:随即删除一些神经元,在不同批量上训练不同的神经网络架构。暂时丢弃部分神经元及其连接,可以防止过拟合,被丢弃概率为1-keep_prob,隐藏层丢弃概率为0.5。每次丢弃之后,改变了原始模型的结构,使得每次迭代都能训练一个不同的架构。【防止过拟合,提高了算法的学习速度】【仅在训练时删除神经元,测试时需要激活所有神经元】