原文链接:https://blog.csdn.net/cdlwhm1217096231/article/details/95060636

这里写目录标题

1.Attention机制基础知识

用X = [ x1 , ? ? , xN ] 表示N组输入信息,其中每个向量xi , i ∈ [ 1 , N ] 都表示一组输入信息。为了节省计算资源,不需要将所有的信息都输入到神经网络中,只需要从X中选择一些和任务相关的信息。注意力机制的计算可以分为两步:

- 在所有输入信息上计算注意力分布;

- 根据注意力分布来计算输入信息的加权平均

1.1注意力分布

- 为了从N个输入向量[ x1 , ? ? , xN ]中选择出与某个特定任务相关的信息,需要引入一个和任务相关的表示,称为查询向量q,并通过一个打分函数来计算每个输入向量和查询向量之间的相关性。

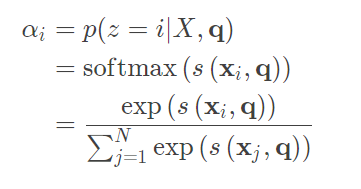

- 给定一个和任务相关的查询向量q,用注意力变量z ∈ [ 1 , N ] 来表示被选择信息的索引位置,即z=i表示选择了第i个输入向量。为了方便计算,下面首先介绍Soft Attention注意力机制。首先计算在给定q和X下,选择第i个输入向量的概率αi

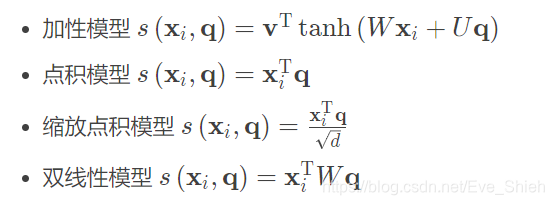

其中αi 称为注意力分布,S ( x i , q ) 是注意力打分函数,可以使用下面的几种方法来计算:

- 上式中W、U、v是可学习的参数,d是输入向量的维度。理论上,加性模型和点积模型的复杂度差不多,但是点积模型在实现上可以更好地利用矩阵乘积,从而计算效率更高。但当输入向量的维度d比较高,点积模型的值通常有较大的方差,从而导致softmax函数的梯度比较小。因此,缩放点积模型可以很好地解决这个问题。双线性模型可以看做是一种泛化的点积模型。相比点积模型,双线性模型在计算相似度时引入了非对称性。

1.2 加权平均

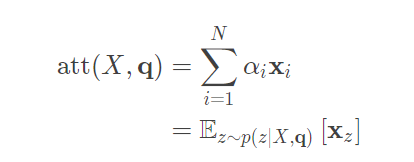

- 注意力分布α i 可以解释为在给定任务相关的查询q时,第i个输入向量受注意的程度。下面采用一种软性的信息选择机制对输入信息进行汇总。

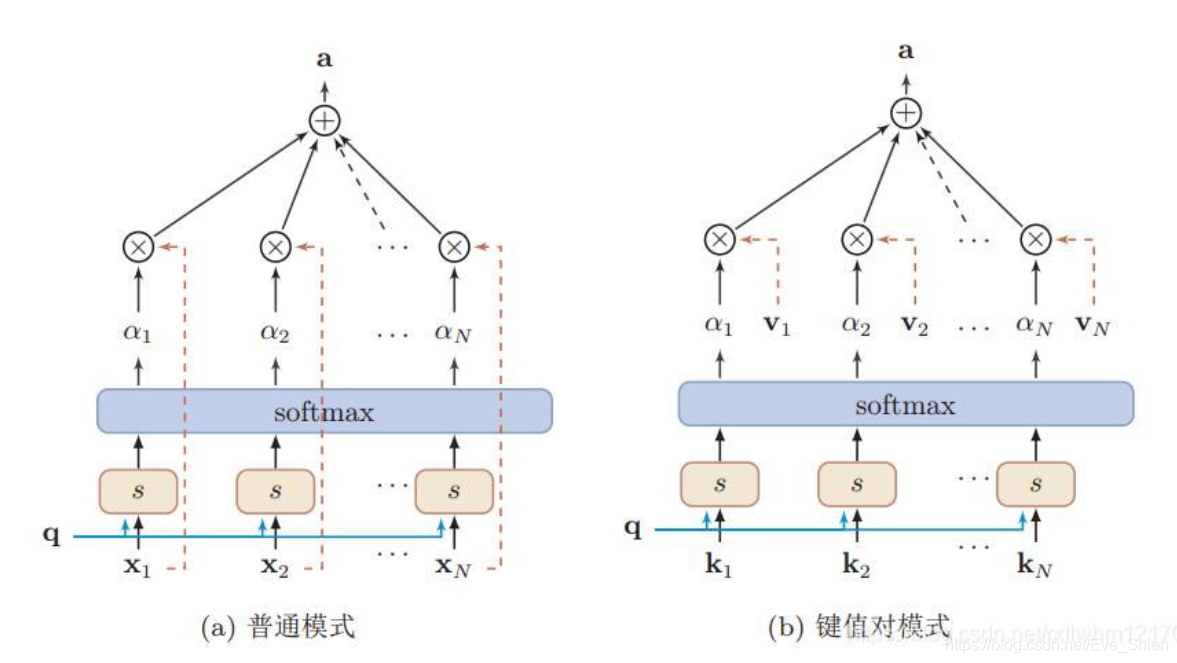

上式称为软注意力机制(Soft Attention Mechanism)。下图给出了软注意力机制的示例图:

2.其他类型的注意力机制

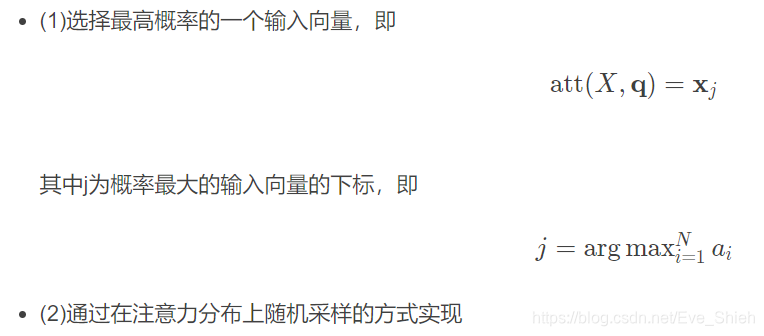

2.1 硬注意力机制

- 上面的公式E z ~ p ( z ∣ X , q ) [ x z ] 提到的是软注意力机制,其选择的信息是所有输入向量在注意力分布下的期望。此外还有一种注意力是只关注到某一个输入向量,叫做硬注意力机制(Hard Attention Mechanism)。硬注意力机制有两种方法可以实现:

- 硬注意力的一个缺点是基于最大采样或随机采样的方式来选择信息。因此最终的损失函数与注意力分布之间的函数关系不可导,因此无法使用反向传播算法进行训练。为了使用反向传播算法进行训练,一般使用软注意力机制。

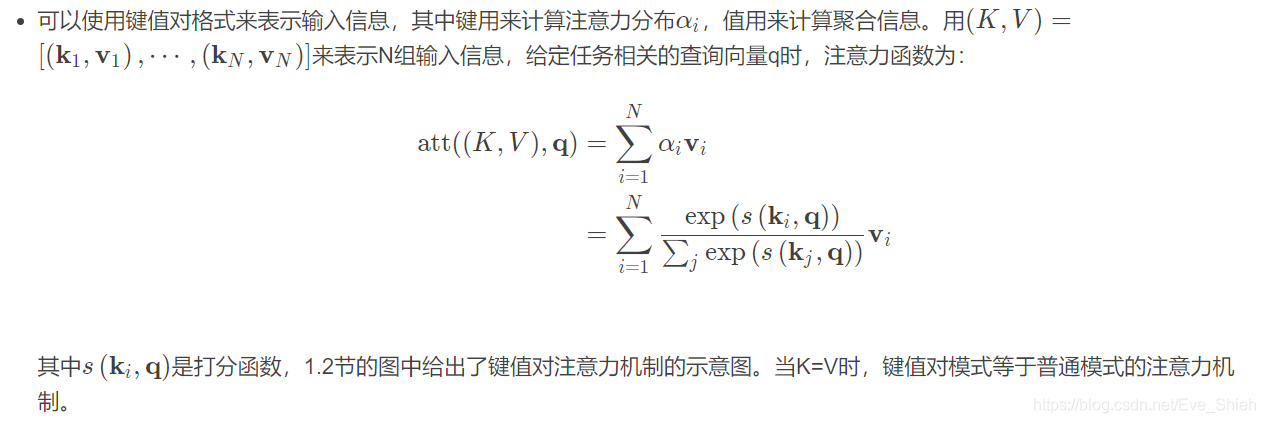

2.2 键值对注意力

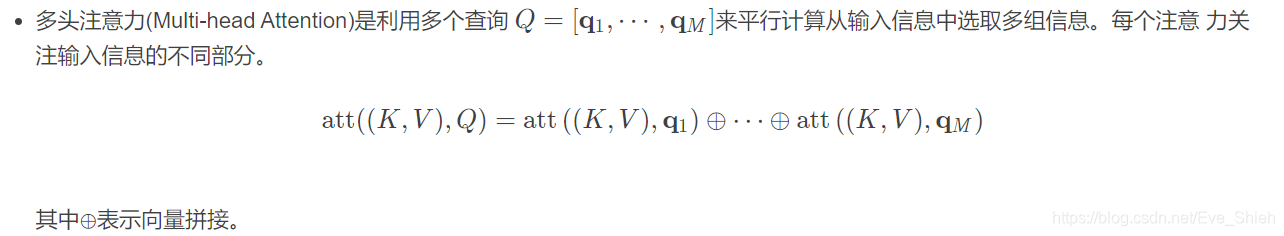

2.3 多头注意力

2.4 自注意力模型(Self Attention)

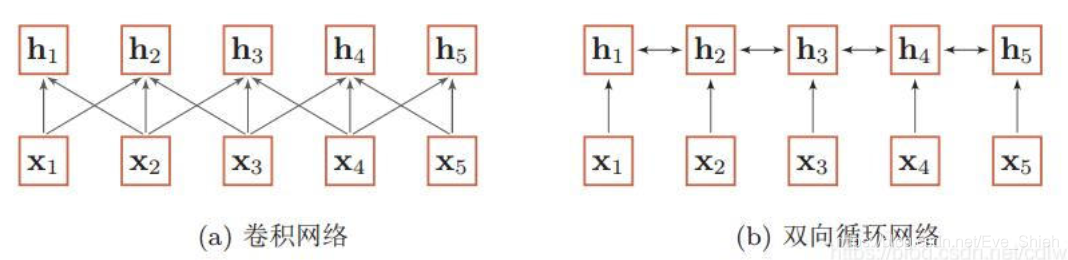

- 当使用神经网络来处理一个变化长度的向量序列时,通过可以使用卷积网络或循环网络进行编码来得到一个相同长度的输出向量序列,如下图所示:

- 基于卷积或循环网络的序列编码都是可以看做是一种局部的编码方式,只建模了输入信息的局部依赖关系。虽然循环网络理论上可以建立长距离依赖关系,但是由于信息传递的容量以及梯度消失问题,实际上也只能建立短距离依赖关系。

- 如果要建立输入序列之间的长距离依赖关系,可以使用以下两种方法:一种方法是增加网络的层数,通过一个深层网络来获取远距离的信息交互;另一种方法是使用全连接网络。全连接网络是一种非常直接的建模远距离依赖的模型,但是无法处理变长的输入序列。不同的输入长度,其连接权重的大小也是不同的。这时,就可以利用注意力机制来“动态”地生成不同连接的权重,这就是自注意力模型(Self-Attention Model)。

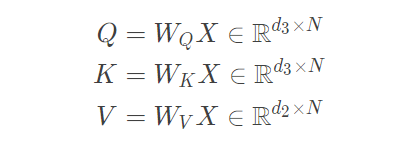

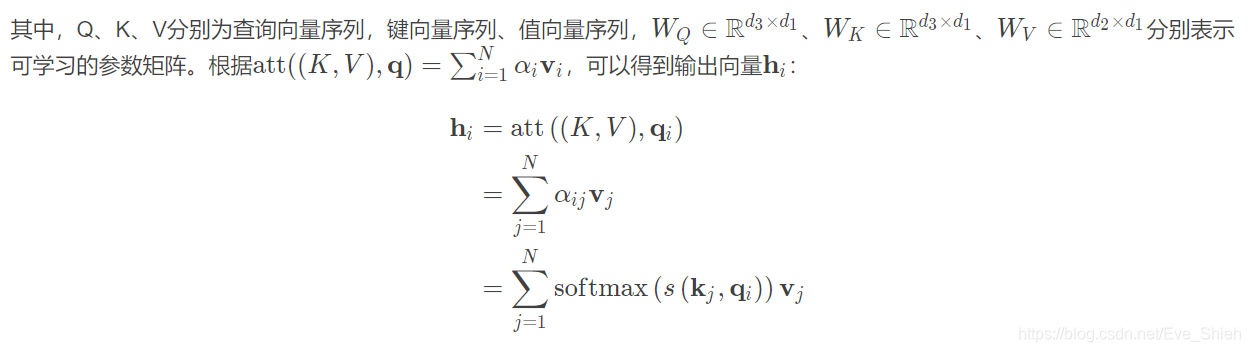

- 假设输入序列为X = [ x 1 , ? ? , x N ] ∈ R d 1 × N ,输出序列为H = [ h 1 , ? ? , h N ] ∈ R d 2 × N,则可以通过线性变换得到三组向量序列:

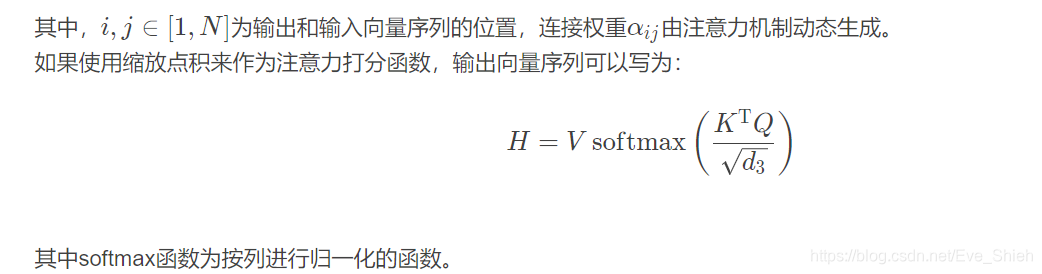

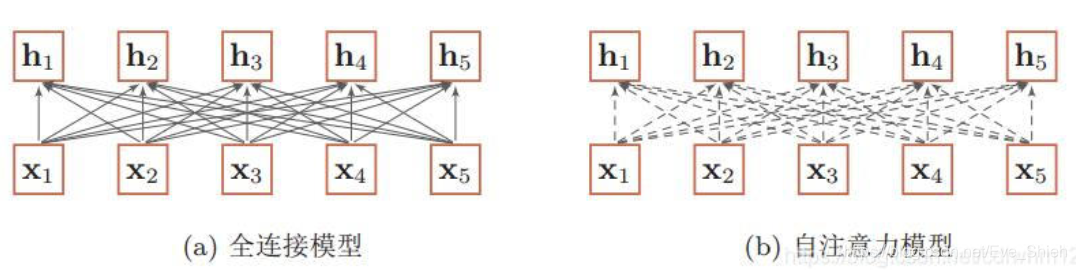

- 下图给出了全连接模型和自注意力模型的对比,其中实线表示可学习的权重,虚线表示动态生成的权重。由于自注意力模型的权重是动态生成的,因此可以处理变长的信息序列。

- 自注意力模型可以作为神经网络中的一层来使用,既可以用来替换卷积层和循环层,也可以和它们一起交替使用(例如输入向量X可以是卷积层或循环层的输出)。自注意模型计算的权重α i j 只依赖于qi的相关性,从而忽略了输入信息的位置信息。因此,在单独使用时,自注意模型一般需要加入位置编码信息来进行修正。

3.实战------以Seq2Seq网络进行法语到英语的翻译为例进行说明

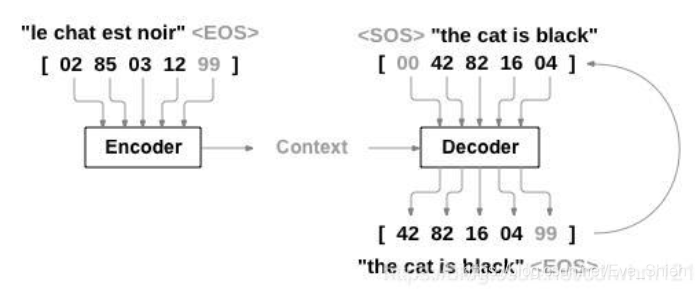

- 利用机器翻译中的经典网络结构Seq2Seq(具体结构见参考资料中的文献),其中包含Encoder编码网络将输入的法语句子进行编码,然后输入到Decoder解码网络进行解码,输出期望得到的英文句子。整个网络的结构如下: