1.视频to图像

video2img.sh脚本

待师弟填坑

2.proposal自动生成

行为识别 <–> 人的行为 ==> 框person

利用目标检测算法,将图像帧中person识别出来,并导出box信息。

参数说明:

--input ../../Datasets/Interaction/images/train/*/*.jpg 需要生成 proposal.json 文件的图片路径

--output --output ../../Datasets/Interaction/anno 生成 proposal.json 文件的保存路径

--det-config ./mywork/faster_rcnn_0_fpn_2x_coco.py person检测模型配置文件

--det-checkpoint ../../Checkpoints/mmdetection/faster_rcnn_r50_fpn_2x_coco_bbox_mAP-0.384_20200504_210434-a5d8aa15.pth person检测模型权重文件

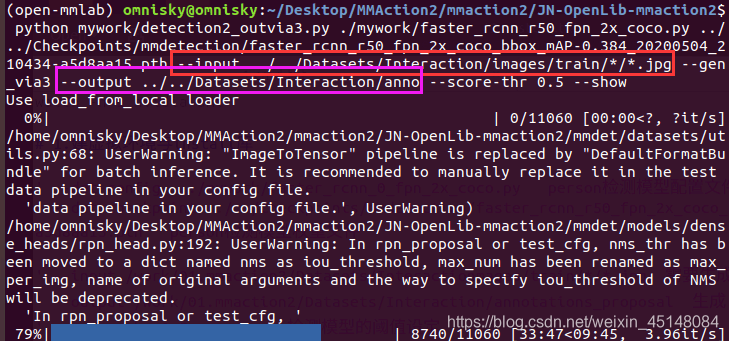

使用脚本detection2_outvia3.py,执行如下命令:

python mywork/detection2_outvia3.py ./mywork/faster_rcnn_0_fpn_2x_coco.py ../../Checkpoints/mmdetection/faster_rcnn_r50_fpn_2x_coco_bbox_mAP-0.384_20200504_210434-a5d8aa15.pth --input ../../Datasets/Interaction/images/train/*/*.jpg --gen_via3 --output ../../Datasets/Interaction/anno --score-thr 0.5 --show

如果有报错,注意输入输出的路径!!!

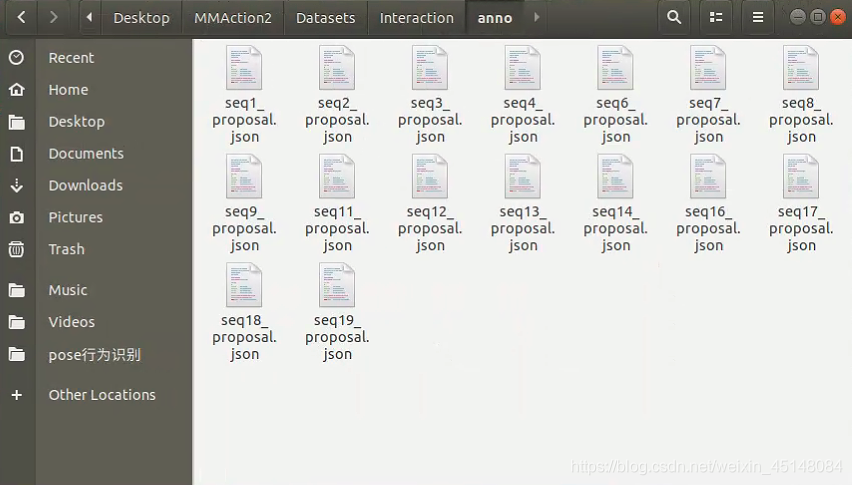

完成后,可以在Datasets/Interaction/anno文件夹中查看到如下文件

3.via标注工具下载与使用

3.1 下载

官网:https://www.robots.ox.ac.uk/~vgg/software/via/

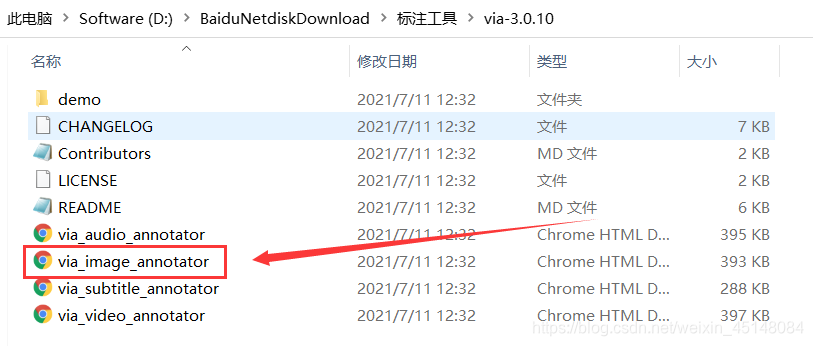

3.2 解压

解压后如下图所示,打开via_image_annotator.html文件

3.3 使用

由于AVA数据十分庞大,硬盘和GPU都十分吃力,立即推 ~ 坚决不放弃

我们采用mini版的Interaction数据集:http://cvrc.ece.utexas.edu/SDHA2010/Human_Interaction.html

数据集格式如下:

└── Interaction

├── annotations

| ├── train/seq1.joson+seq1_proposal.json

| ├── test/seq5.joson+seq5_proposal.json

└── images

├── train/seq1/seq1_00003.jpg

├── test/seq5/seq5_00003.jpg

待完善~