文章目录

棋盘效应

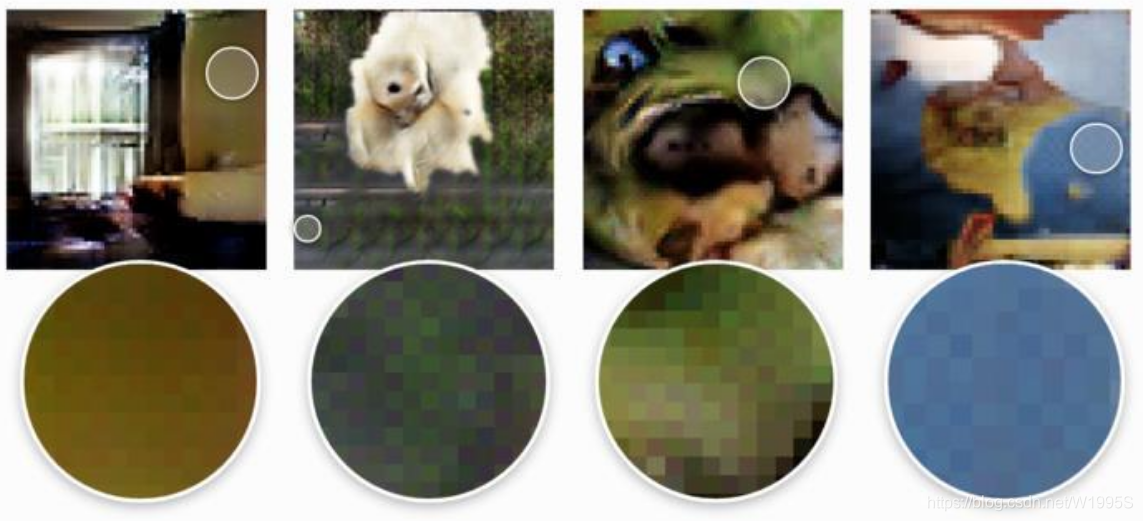

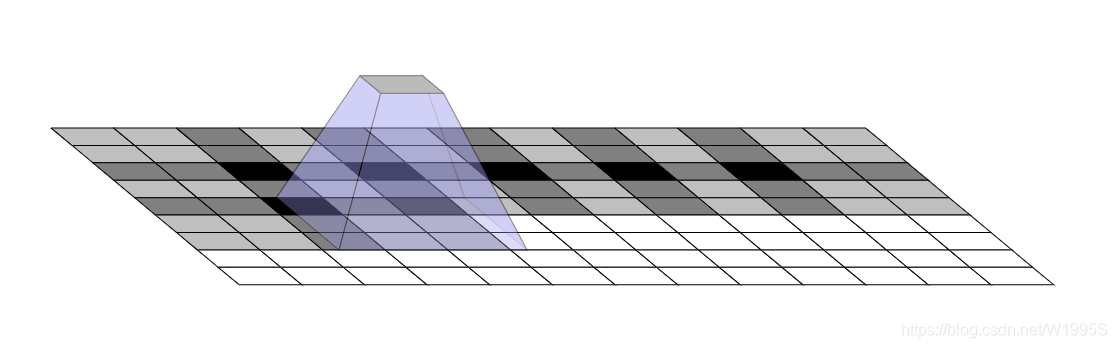

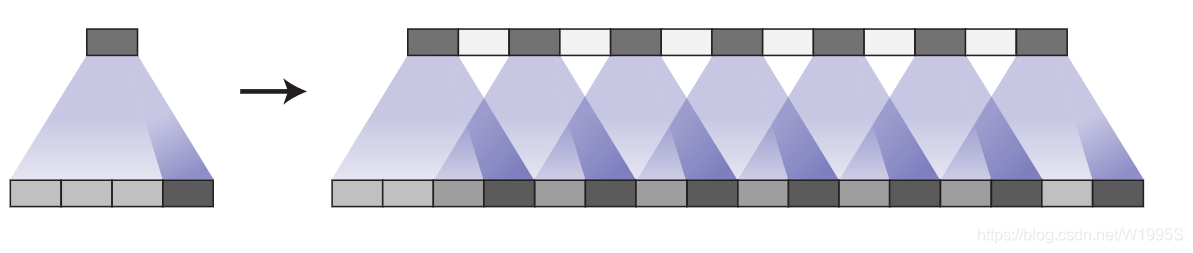

当我们要用到深度学习来生成图像的时候,是往往是基于一个低分辨率且具有高层语义的特征图。这会使得深度学习来对这种低分辨率特征图进行填充细节。一般来说,为了执行从低分辨率特征图到高分辨率图像之间的转换,我们往往要进行deconvolution。简单来说,deconvolution layer可以允许模型通过每一个点进行绘制高分辨率图像上的一个方块,这种情况的产生与deconvolution的stride、kernel size有关。但不幸的是,当卷积核大小不能被步长整除的时候,会出现棋盘现象。

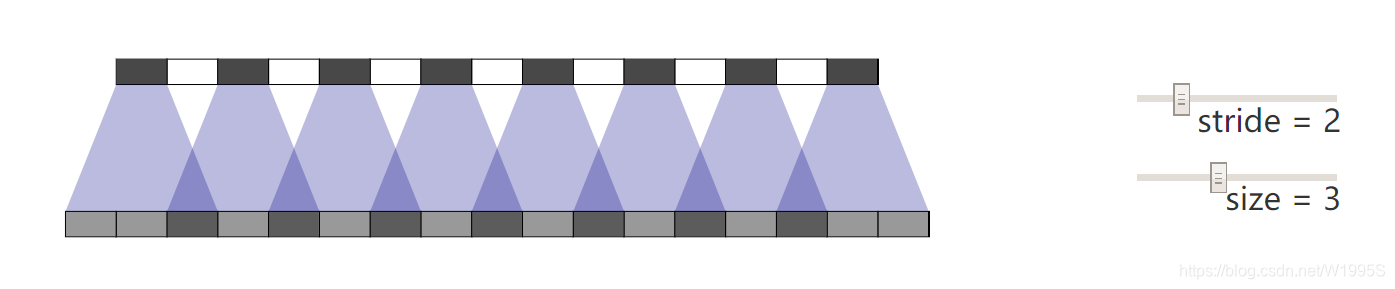

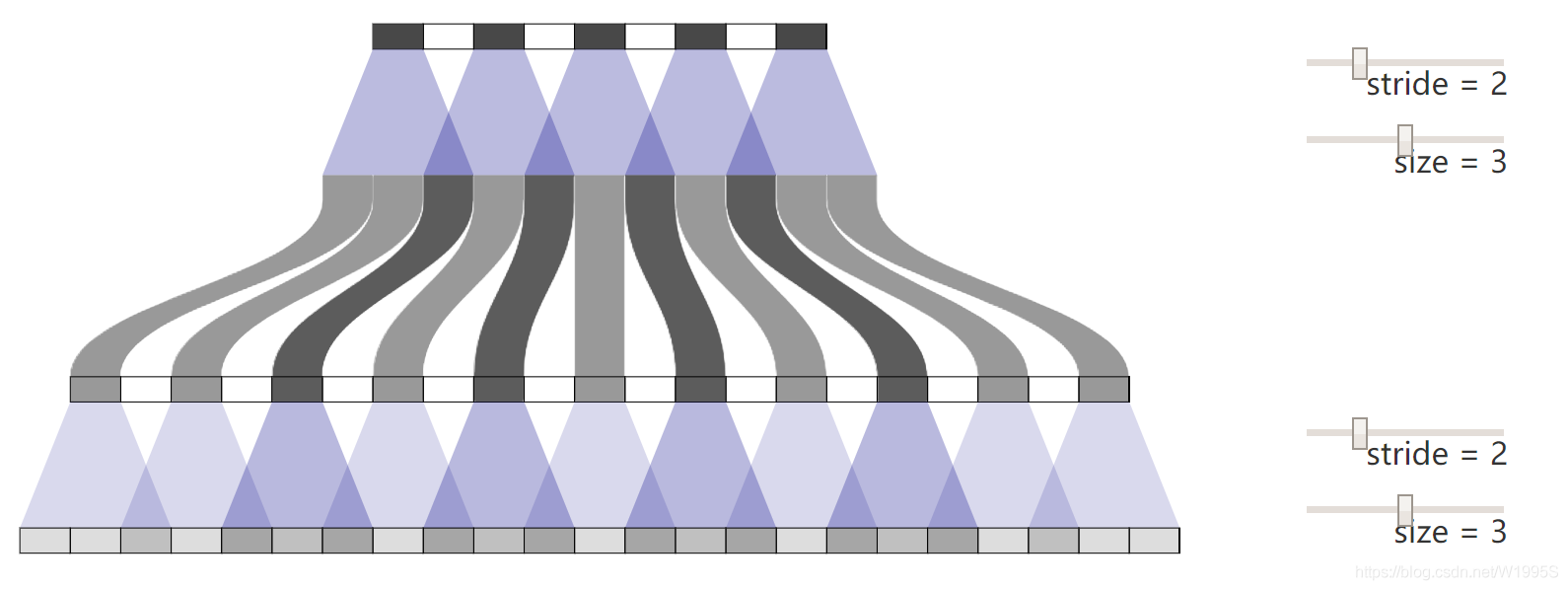

问题产生:kernel size无法被stride整除

stride为2,kernel size为3,这导致了重复上采样绘图的部分不均匀(图深色部分)

并且在二维图片上,情况会更加严重:

方法尝试1:多层重复转置卷积

现在,神经网络在创建图像时通常使用多层反卷积,从一系列较低分辨率的描述中迭代地构建较大的图像。虽然这些堆叠的去卷积可能会消除伪影,但它们通常会复合,从而在各种尺度上产生伪影。重复的结构使得棋盘更加复杂。

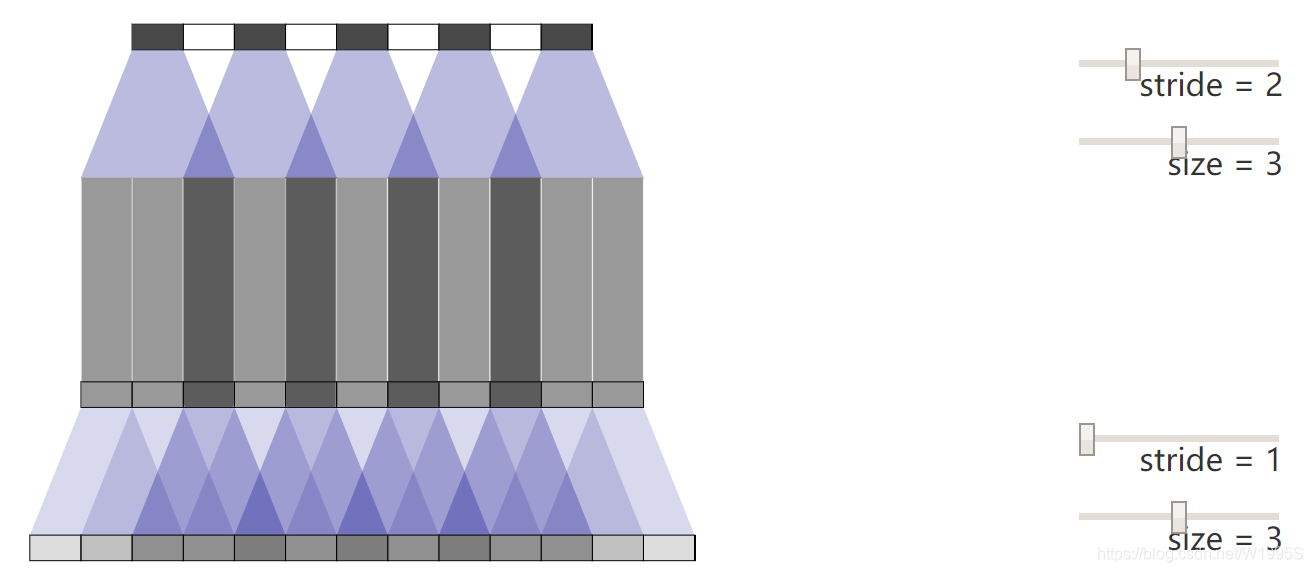

方法尝试2:stride为1的转置卷积

在反卷积后面,再接一个步长为1的卷积,效果有限

方法尝试3:调整kernel权重分布

调整卷积核的权重,适当加大重叠部分少的权重,虽然理论有效,但在实际操作中,不仅有困难也会减弱模型的表达力

更好的上采样

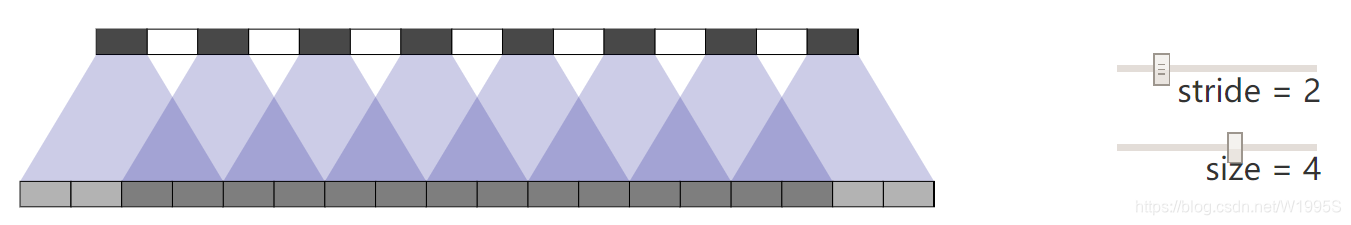

方法一:采取可以被stride整除的kernel size

该方案较好的应对了棋盘效应问题,但是仍不够圆满,因为一旦我们的kernel学习不均匀,仍然会产生棋盘效应,(下图为步长为2,核大小为4所产生的现象)

在上图中,我们的weight并不够平衡,这直接导致了输出的棋盘效应。

即便如此,采用这个思路去设计网络仍然是必要的。

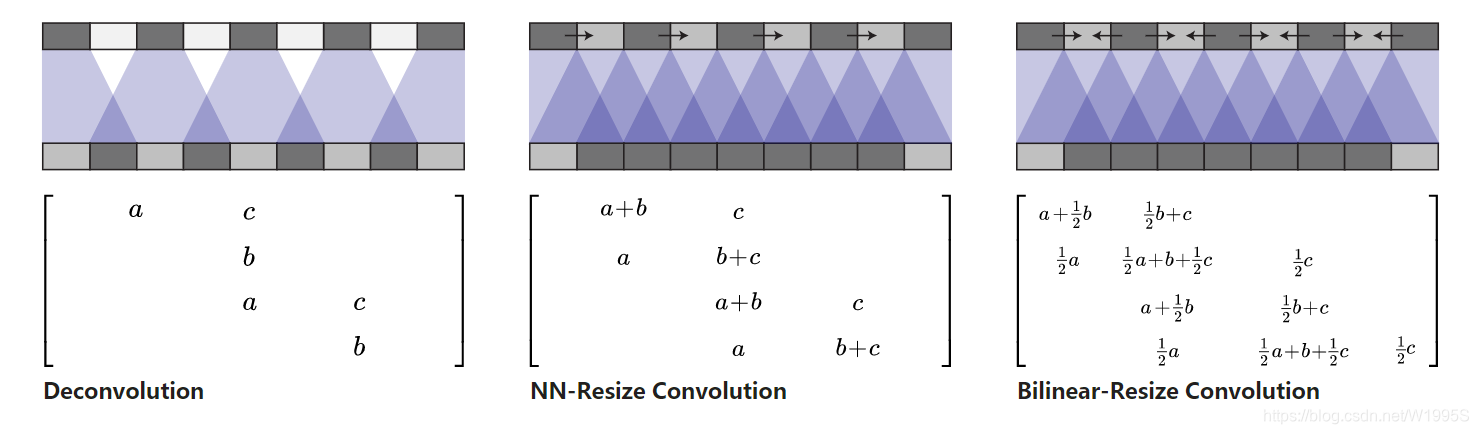

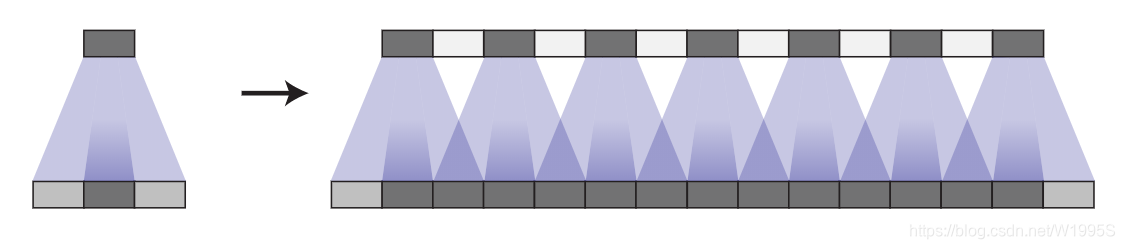

方法二:插值

调整图像大小(使用最近邻插值或双线性插值),然后执行卷积图层。这似乎是一种自然的方法,大致相似的方法在图像超分辨率方面表现良好