目录

论文阅读准备

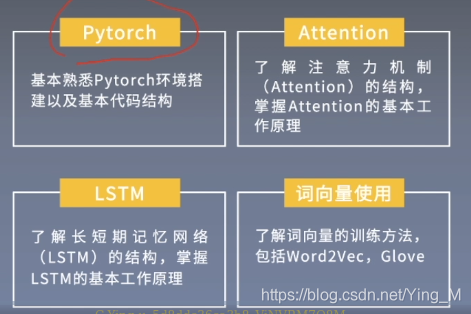

前期知识储备

学习目标

论文导读

论文研究背景、成果及意义

粗粒度的情感分类问题,左边是一个个句子,右边是句子多对应的积极或消极。

传统的情感分析(SA)主要是面向文档或句子,也就是文档层面的情感分类(document-level sentiment classification),这种粗粒度的分类只考虑文档整体的情感倾向性(sentiment polarity),在现实应用中是不够用的。

Aspect和Target

Aspect level task,认为句子中包含更加细粒度的aspect,这些aspect里面包含不同句子的属性。例如:

这件衣服款式挺漂亮的,但是尺码也太小了吧!

方面词可能会出现在句子里面,也有可能不出现在句子里面,Target是一定出现在句子里面。

SemEval-2014数据集

http://alt.qcri.org/semeval2014/task4

- 1.aspect抽取(aspect term extraction);

- 2.判断aspect上的情感倾向(aspect term polarity);

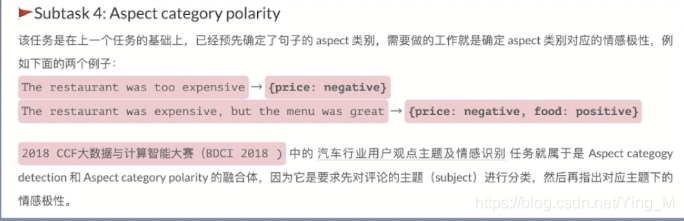

- 3.判断aspect所属的范畴(aspect category detection);

- 4.判断aspect category上的情感倾向

句子+此句子确定的属性类别,判断情感极性。

Attention种类

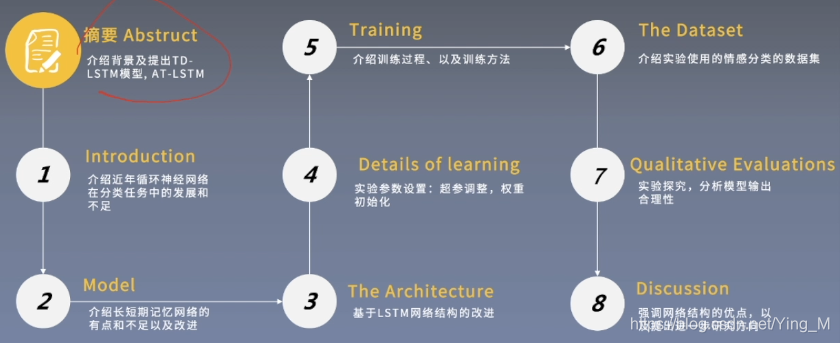

论文泛读

论文结构

摘要—AT-LSTM

本文将attention与lstm结合在一起,通过attention去获取对不同aspect更重要的上下文信息,来解决aspect level情感分析问题,SemEval 2014数据集进行了实验,结果表明模型在aspect-level 的情感分类上达到了最先进的性能。

摘要—TD-LSTM

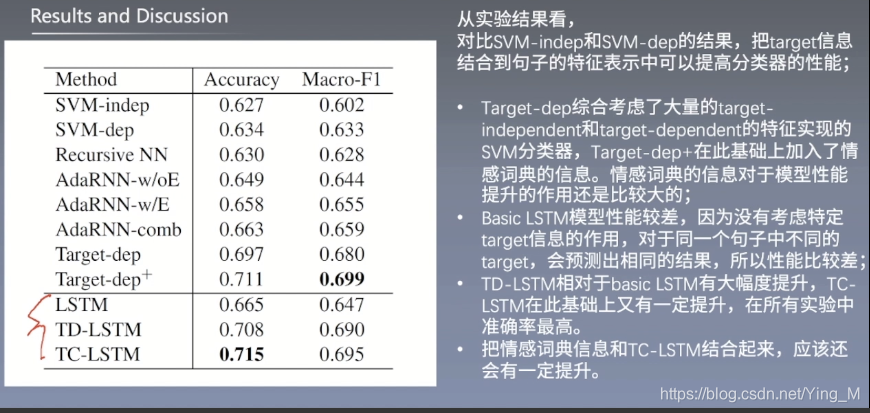

- 文章主要针对依赖于目标的情感分类问题,在标准LSTM的基础上,提出Target-Dependent Long Short-Term Memory (TD-LSTM)和Target-Connection Long Short-Term Memory(TC-LSTM)两个模型,实验结果表明这两种模型相对basic lstm都有较大提升,后者提升更多;

- 与aspect level 情感分析类似,对于target-dependent情感分析来说,主要问题就是将target-dependent和相应的context words的语义信息结合起来,由此推断不同上下文对判断不同的target的情感倾向的影响,以分析相应target的情感倾向。

论文精读

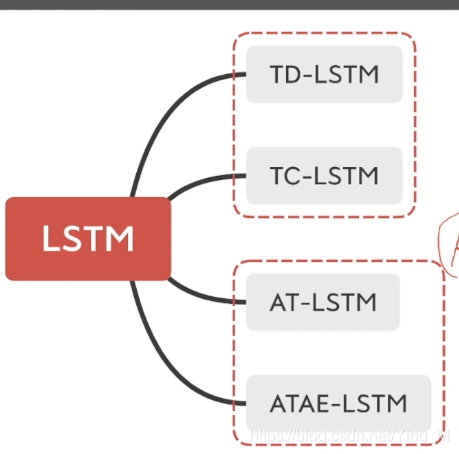

论文算法模型总览

LSTM

target words在数据集中已经标注好,lstm不区分target words,和其他词一样,都输入到lstm中。

论文算法模型细节

论文一

TD-LSTM

【例】

target words之间的内容既经过了前向的特征提取以及后向的特征提取,在语义信息提取上比其他的地方会更多一些。作者在论文中提到将target设为lstm的最后一个时刻的输入,能更充分的利用target的语义信息。

TC-LSTM

【例】

将target words的上下文信息利用起来,并且还将target words的信息也利用起来。

论文二

aspect-level与target是比较相似的,target是在句子中肯定会出现的,它相当于是aspect-level的一个子集,aspect-level有的会在句子中出现,有的不会在句子中出现。

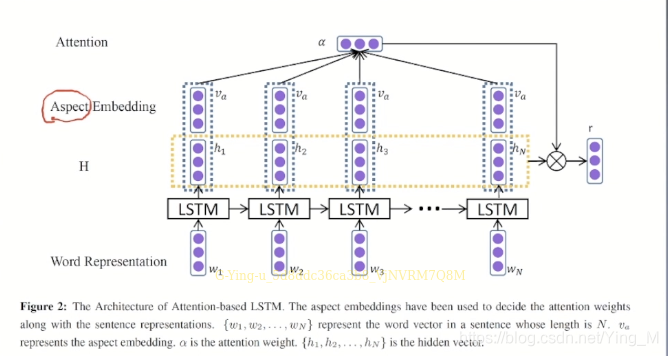

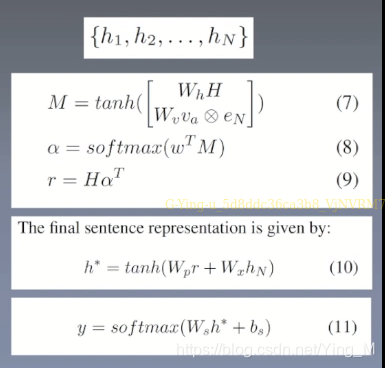

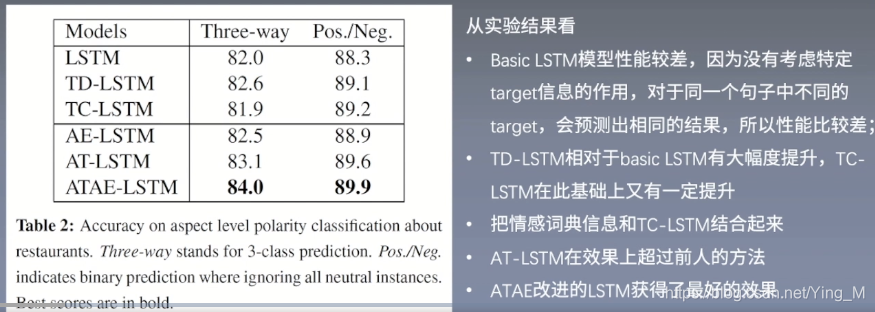

AT-LSTM

AspectEmbedding没有经过lstm,而是加在了hidden上面,其实AspectEmbedding没有顺序的关系,因此直接加到上面是没有太大影响的。

公式如下图:

ATAE-LSTM

Aspect Embedding重复利用了两遍,LSTM是具有顺序的关系,下面的Aspect Embedding输入到lstm是有一定的顺序的关系,会提取到顺序的信息,但不一定有意义,下面的Aspect Embedding经过lstm后可能会有一部分的信息会丢失,因此在上面又拼接了Aspect Embedding,有点像残差网络。

为了利用好句子中的目标词的信息,两篇论文的作者在模型上做了改进,TD-LSTM直接按照target将句子进行切分,将句子重复利用,传统的lstm只是单向的获取特征;TC-LSTM将target信息作为输入,并从前面和后面分别提取特征,进行融合。

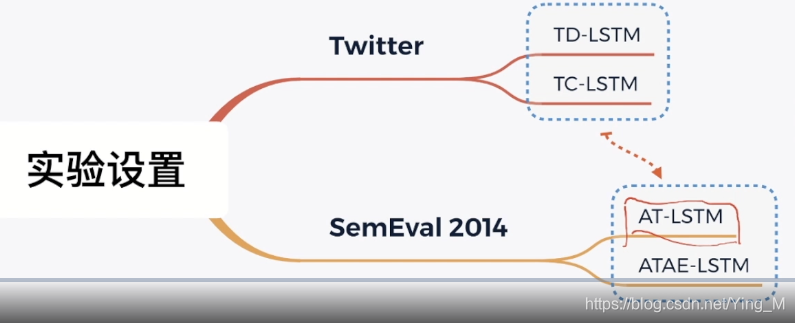

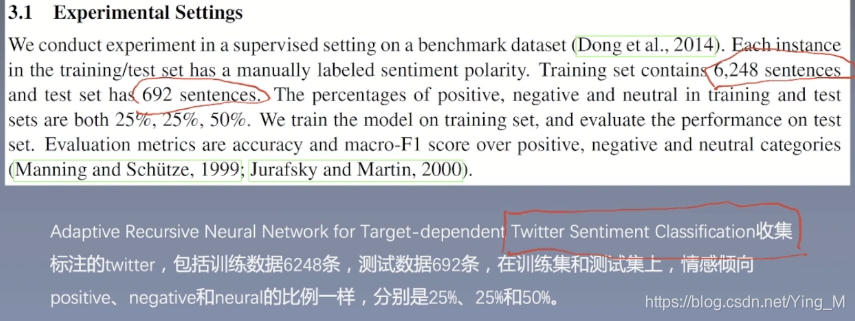

实验设置及结果分析

实验数据

数据集

实验结果及分析

论文一

论文二

论文总结

论文一

论文二

根据输入数据的格式,可以将模型改造成适合输入数据的一种结构,更加充分的利用语义上的信息;

基于数据对模型做出的结构上的改进。