文章目录

介绍

文章摘自:https://ml.berkeley.edu/blog/posts/clip-art/

如果觉得文档晦涩难懂,可以看我的视频操作教程。

扫码或者B站搜索“有只小新”

最近几个月,人工智能生成的艺术场景出现了一些爆炸式增长。

自从 OpenAI 发布了他们的 CLIP 模型的权重和代码以来,各种黑客、艺术家、研究人员和深度学习爱好者已经想出了如何利用 CLIP 作为各种生成模型的有效“自然语言方向盘”,让艺术家能够创造只需向其中一个模型输入一些文本(标题、诗歌、歌词、单词)即可获得各种有趣的视觉艺术。

例如,输入“夜间城市景观”会产生一些城市灯光的酷炫、抽象的描绘:

输入“魔法童话屋”:

需要的条件

- Google账户

- 合理的上网方式

- 一点点时间和耐心

个人作品

-

Small bridge, flowing water

The Big Sleep:

-

In me the tiger sniffs the rose

VQ-GAN+CLIP (z+quantize)

-

The vast starry sky

The Big Sleep:

-

The girl in the forest

The Big Sleep:

操作地址

The Big Sleep

Aleph2Image

Deep Daze

VQ-GAN+CLIP (codebook sampling)

VQ-GAN+CLIP (z+quantize)

VQ-GAN+CLIP (EleutherAI)

工作原理

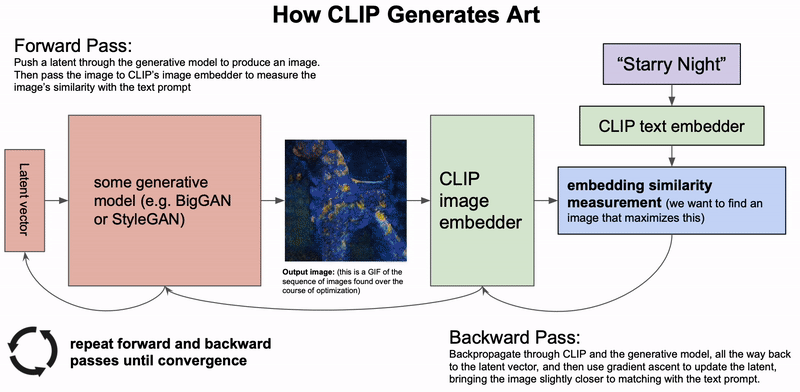

2021 年 1 月 5 日,OpenAI 发布了CLIP的模型权重和代码:经过训练的模型可以确定一组字幕中的哪个字幕最适合给定图像。以这种方式从数亿张图像中学习后,CLIP 不仅非常擅长为给定图像挑选最佳标题,而且还学习了一些令人惊讶的抽象和一般视觉表示。

各种黑客、研究人员和艺术家(最著名的是Twitter 上的@advadnoun和@quasimondo)只花了一天的时间就发现,通过一个简单的技巧,CLIP 实际上可以用来指导现有的图像生成模型(如 GAN、自动编码器)或隐式神经表示(如 SIREN)以生成适合给定标题的原始图像。

几种不同的方法

The Big Sleep: Humble Beginnings

在短短几周内,就有了突破。@advadnoun发布了 The Big Sleep 的代码:一种基于 CLIP 的文本到图像技术,它使用Big GAN作为生成模型。

Big Sleep 以其独特的方式大致满足了文本到图像的承诺。它几乎可以渲染任何你可以用语言表达的东西:“日落”、“像 MC Escher 画的脸”、“当风吹来时”、“3d 中的大峡谷”。

当然,The Big Sleep 的输出可能不是每个人都喜欢的。它们奇怪而抽象,虽然它们通常是全局一致的,但有时它们没有多大意义。The Big Sleep的作品绝对有一种独特的风格,我个人觉得它在审美上是令人愉悦的。

VQ-GAN: New Generative Superpowers

2020 年 12 月 17 日,海德堡大学的研究人员(Esser 等人)在 Arxiv 上发布了他们的论文“Taming Transformers for High-Resolution Image Synthesis”。他们提出了一种称为 VQ-GAN 的新型 GAN 架构,该架构将 conv-nets 与 Transformer 相结合,以最佳方式利用 conv-nets 的局部归纳偏差和transformer 的全局注意力,形成一个特别强大的生成模型。

大约 4月初,@ advadnoun和@RiversHaveWings开始做一些结合 VQ-GAN 和 CLIP 的实验,从文本提示生成图像。在高层次上,他们使用的方法与 The Big Sleep 大致相同。主要区别实际上只是该系统使用 VQ-GAN 而不是使用 Big-GAN 作为生成模型。

参考

CLIP blog post

CLIP paper

Big-GAN paper

VQ-GAN paper

The Big Sleep blog post

DeepDream blog post

DALL-E blog post

Multimodal Neurons Distill