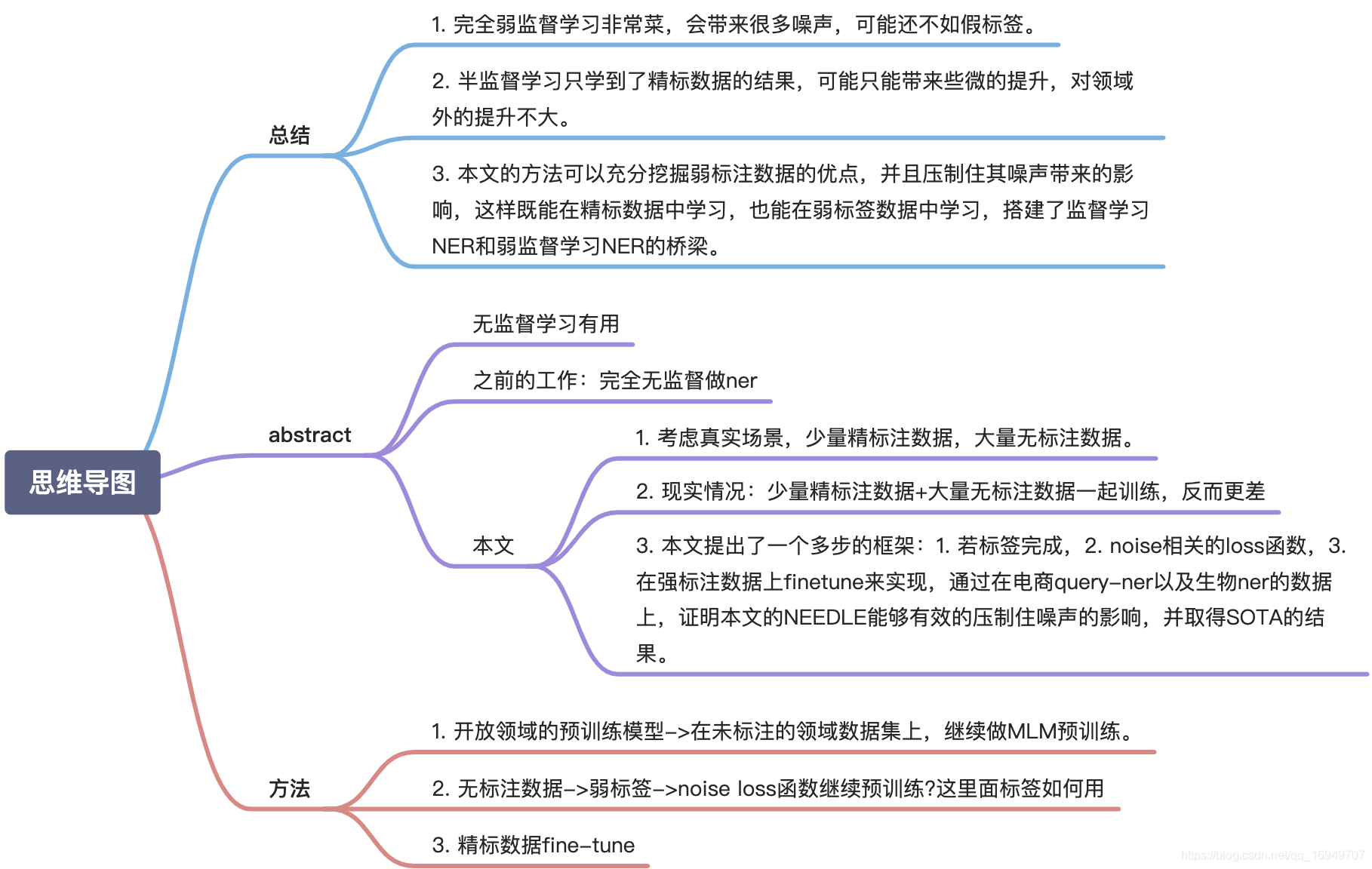

Abstract

- 无监督学习对nlp任务例如ner任务结果有促进作用

- 之前的工作只focuses在无监督做ner模型,没有任何标注,证明了能取得好的表现,但是效果还是比完全监督学习来做ner差。

- 本文更考虑一个实际的场景,少量强标注数据&大量弱标注数据,但是发现,弱标注数据没啥用,反而可能使模型更恶化。

- 为了解决这个问题,本文提出了一个多步的框架:1. 若标签完成,2. noise相关的loss函数,3. 在强标注数据上finetune来实现,通过在电商query-ner以及生物ner的数据上,证明本文的NEEDLE能够有效的压制住噪声的影响,并取得SOTA的结果。

1 Introduction

- ner数据标注比较难,是瓶颈。

- 如何利用大量的未标注数据?

- pre-trained model,领域相关的训练。

- 弱监督学习自动生成label(医疗词典)

- 能不能同时利用少量精标数据+大量弱标注数据来提高模型表现?

- 压制噪声的影响

- 不完整,漏标

- bias,错标

- 数据量比精标数据大很多

- 结合预训练模型,可能噪声的影响会非常大,导致很容易过拟合,恶化模型的表现

- 压制噪声的影响

- 方案:

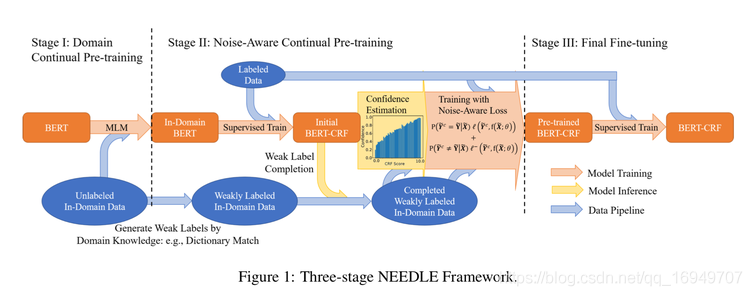

- 利用大量的未标注的数据,进行领域继续预训练

- 将领域无标签数据转化为弱标签数据

- 结合我们提出的弱标签完成过程和噪声感知损失函数,继续预训练(精标数据+弱标签数据)

- 在精标数据上finetune

2 Preliminaries

2.1 NER知识

NER是啥

监督NER

弱监督NER

2.2 无监督预训练

BERT、RoBERTa、ALBERT、T5

BERT:110 million 参数,书籍+英文wiki百科

2.3 Method

- 开放领域的预训练模型->在未标注的领域数据集上,继续做MLM预训练。

- 无标注数据->弱标签->noise loss函数继续预训练?这里面标签如何用

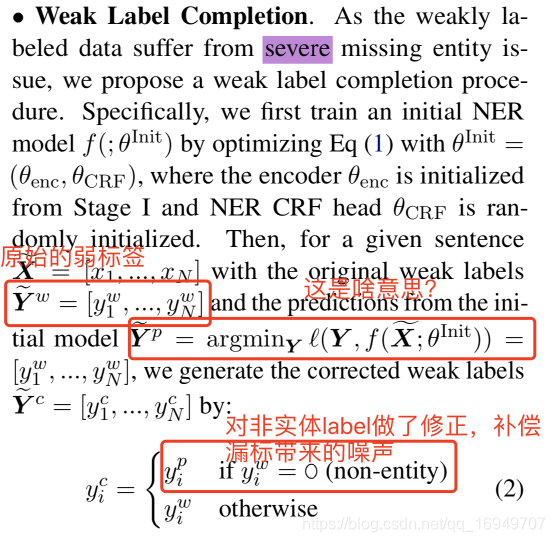

- weak label completion:弱标签数据有严重的实体缺失问题,用weak label completion来完善

- weak label completion:弱标签数据有严重的实体缺失问题,用weak label completion来完善

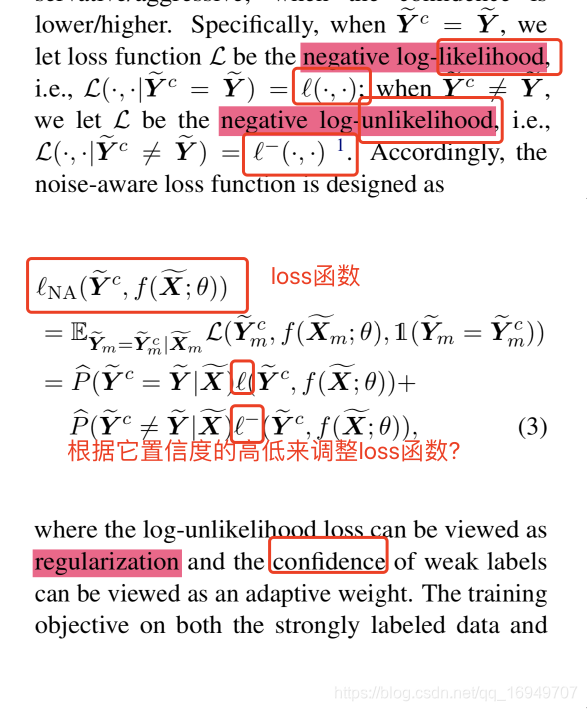

b. Noise-Aware Loss Function:对错标的数据也进行补偿:根据置信度和直方图来调整。

精标数据fine-tune

Experiments

4.1 训练参数:

BIO

144

gird search

epochs=[1,2,3,4,5,10,15,20,25,30,50]

batch_size=[64,144,192]

Lr=[1,2,5]*10e5

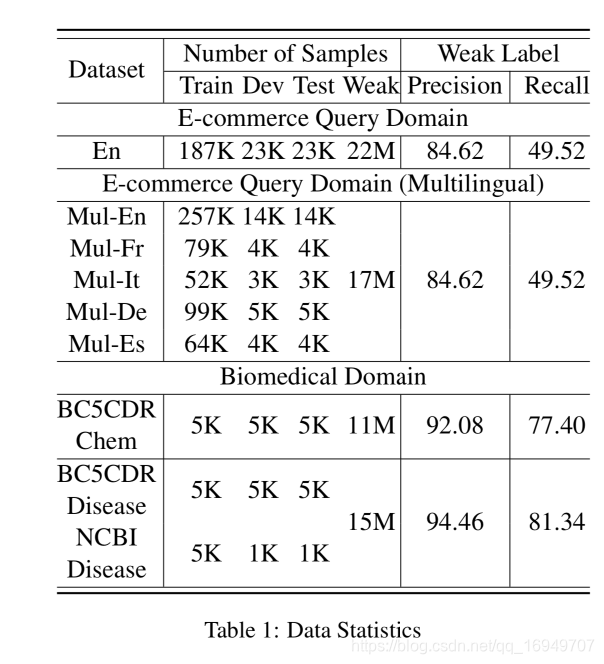

4.2 数据数量

4.3 Baseline

- 监督学习

- E-commerce query-mBERT-CRF

- Biomedical-NER BioBERT-CRF

- 半监督学习

- SST,监督学习,生成假标签,半监督学习

- Mean-Teacher & VAT

- 弱监督学习WSL

- 合并精标数据和弱标签数据

- 加权弱监督学习Weighted WSL:固定权重

- Robust WSL:利用均方误差,适应噪声,但是不兼容CRF

- partial WSL:非实体弱标签

- BOND:弱监督学习的一个自学习框架

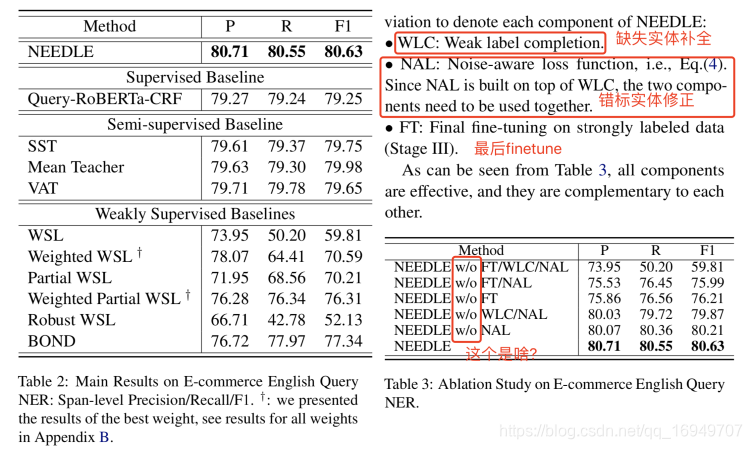

4.3.1 主要结论

NEEDLE:效果最好

WSB:都导致了比监督学习差的效果,和之前的分析也一致

Semi-supervised:比监督学习和弱监督学习WSB好,说明如果没处理好噪音,假标签的结果可能比弱监督学习的label好。

4.4 Biomedical NER

NEEDLE模型最好

4.5 分析

- 分析弱标注数据大小的影响

- 随机采样数据,发现西欧昂对于其他方法(SST和WSL),NEEDLE能够从数据中获得更多的收益。

- 两轮二阶段训练

- 精标数据大小

- 调整精标数据大小,发现只需要30-50%的精标数据,就能拿到全量精标数据的大小,数据越小,收益越大。

5 讨论和总结

- 完全弱监督学习非常菜,会带来很多噪声,可能还不如假标签。

- 半监督学习只学到了精标数据的结果,可能只能带来些微的提升,对领域外的提升不大。

- 本文的方法可以充分挖掘弱标注数据的优点,并且压制住其噪声带来的影响,这样既能在精标数据中学习,也能在弱标签数据中学习,搭建了监督学习NER和弱监督学习NER的桥梁。

英语

simultaneously 同步的

Preliminaries 初步的

conservative/aggressive 保守/激进

Ablation study 消融实验

slight 微不足道的

marginally 稍微的,有限的