SIGIR2021

Paper-1: Hierarchical Cross-Modal Graph Consistency Learning for Video-Text Retrieval 视频文本检索的层次交叉模态图结构一致性学习

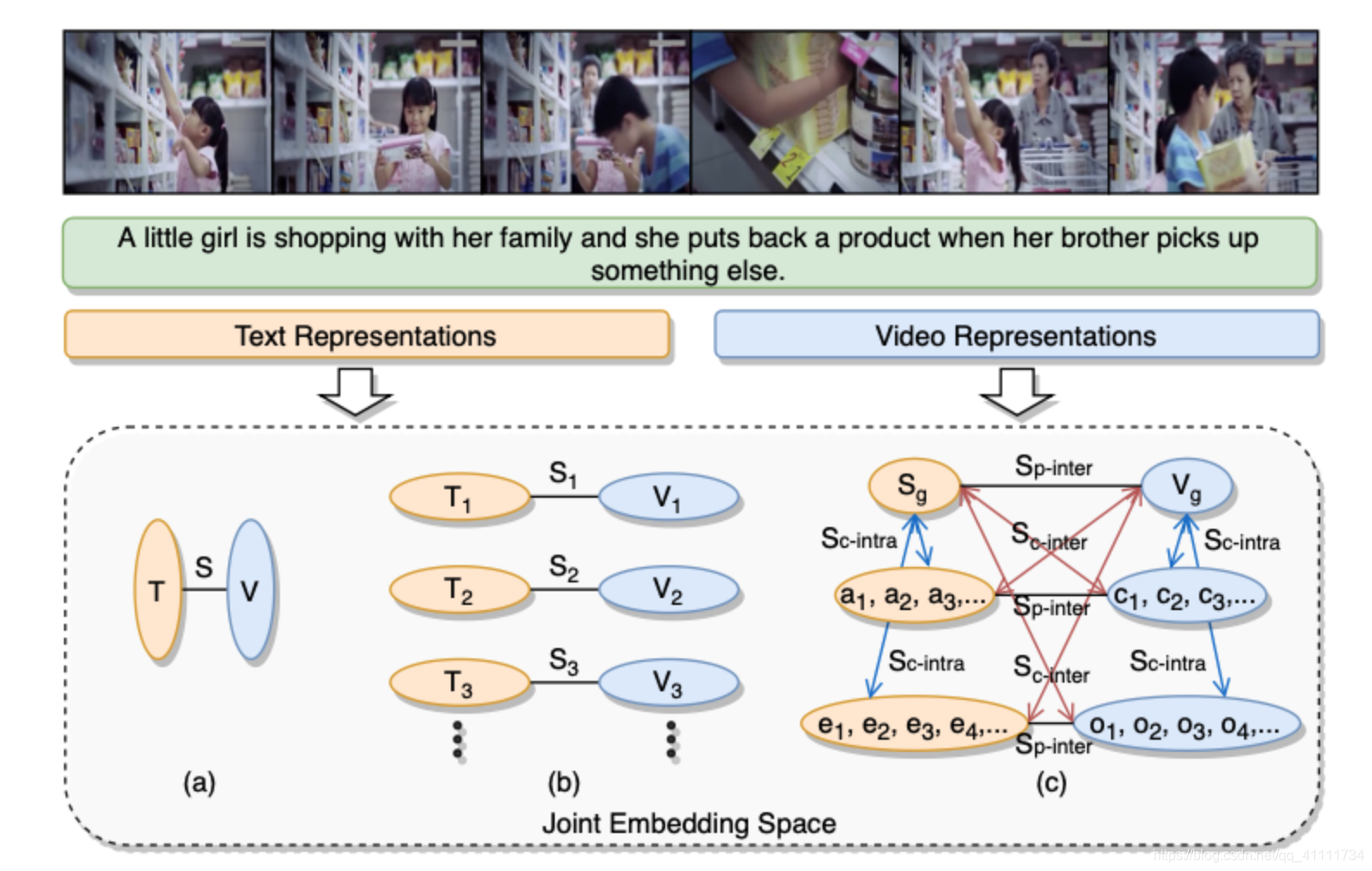

论文首先展示说明了两种图文检索策略,然后提出了论文里面的方案。最常规的图文检索是下图a中直接根据视频文本的特征向量的相似度进行匹配,b中是一个常规的多水平结构特征匹配策略。而c就是本论文提出的层次交叉模态图一致性学习策略。

它的图结构主要分为三个部分,图间并行一致性、图间交叉一致性和图内交叉一致性。

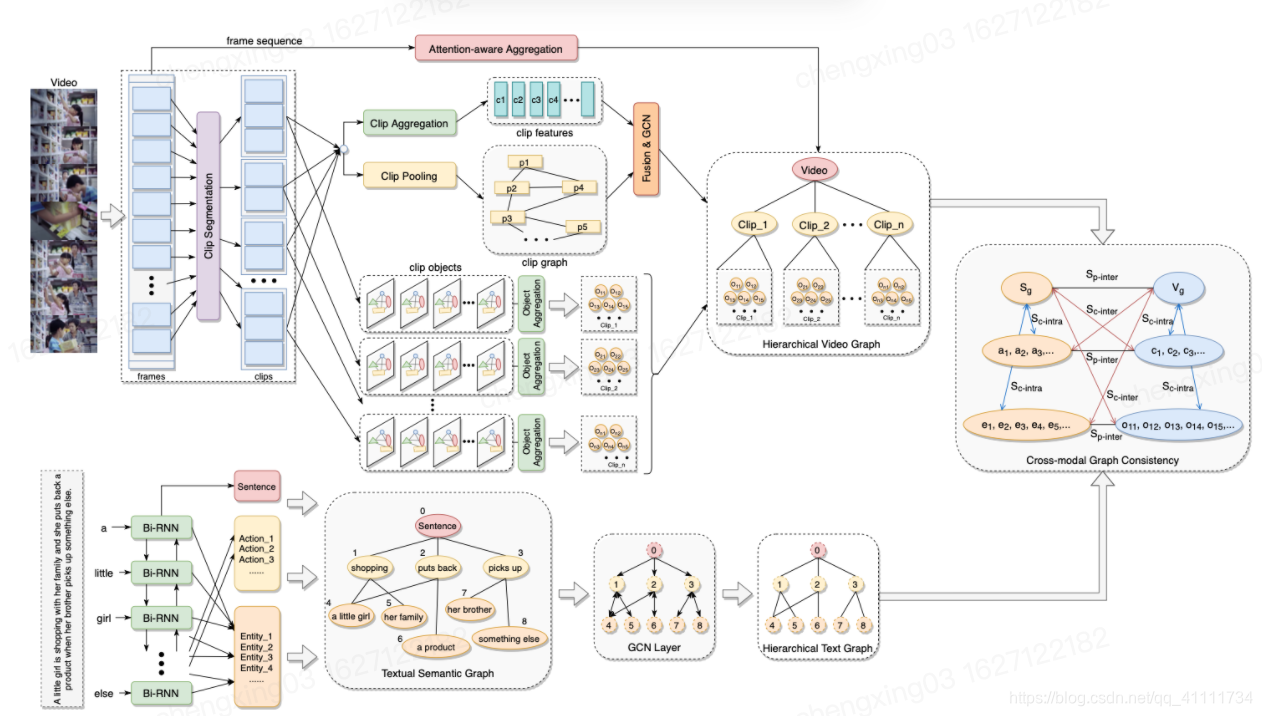

整个模型架构如下:

对于文本模态,在三个层次抽取embedding:全局事件级别,动作级别,实体级别。每一个对应的embedding代表一个节点

对于视频模态,也是抽取三个层次的embedding:全局视频层、剪辑层和对象层。

最后对每一个节点进行交叉计算相似度然后计算loss

从结果上看:

相比之前方法有较大的提升。实际效果有待验证。

Dynamic Modality Interaction Modeling for Image-Text Retrieval 图像-文本检索的动态模态交互建模

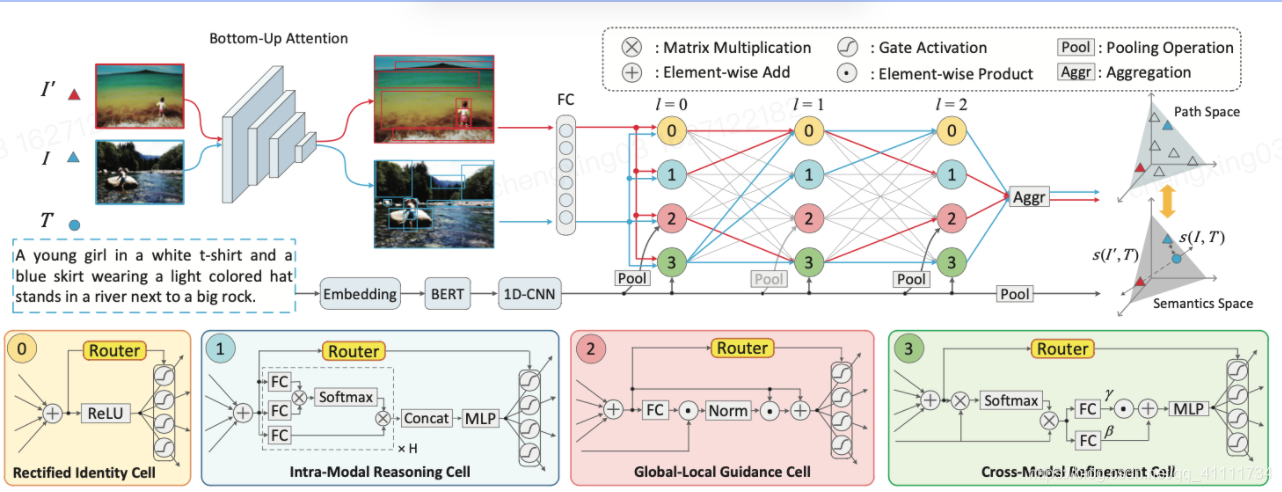

其框架如下:

主要来说是它吸取的集成学习的思想,在特征融合阶段,用了很多个并行的attention单元。

图像经过一个目标检测网络,对预测出来的R个anchor提取d纬图像特征。文本模态特征直接用bert提取。四个attention单元基于不同的attention方式和目的组成,第一个是不同对象的特征之间的se-attention,注重通道选择,忽略掉不重要的对象。第二个是不同对象之间的multihead-attention。第三个是加上了全局图像特征的se-attention,第四个是加上了文本模态的交叉模态单元。

实验结果如下:

消融实验部分可以看到每一个细胞单元所起的作用:

可以看到四个细胞单元的结果确实是最高的,而se-attention单元的影响最小,有图像模态的attention单元影响最大。

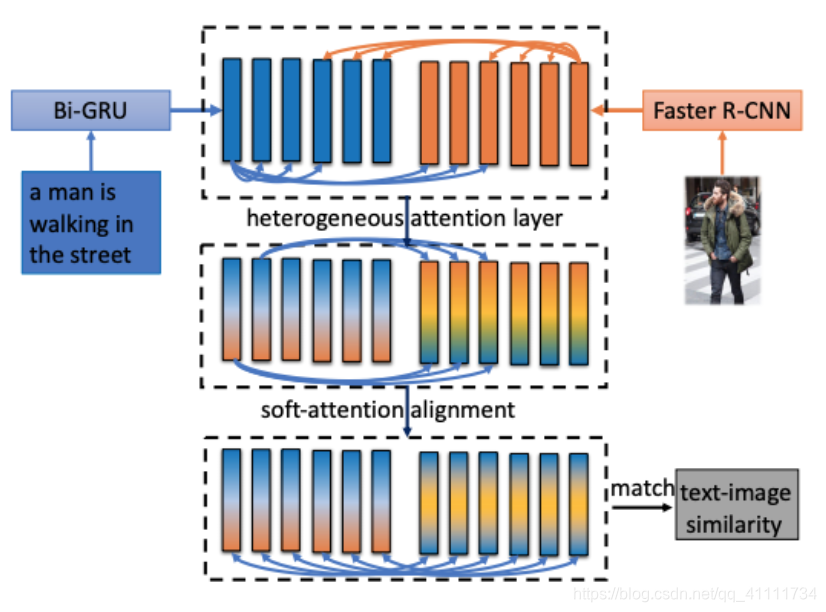

Heterogeneous Attention Network for Effective and Efficient Cross-modal Retrieval

模型的整体架构比较简单:

文本方面用Bi-GRU提取每一个单词的特征,图像方面用faster r-cnn提取每一个置信度高的预测box的特征。然后进行跨模态跨通道的attention计算。attention方式是transformer的self-attention。loss计算是通用的hinge-based triplet loss:

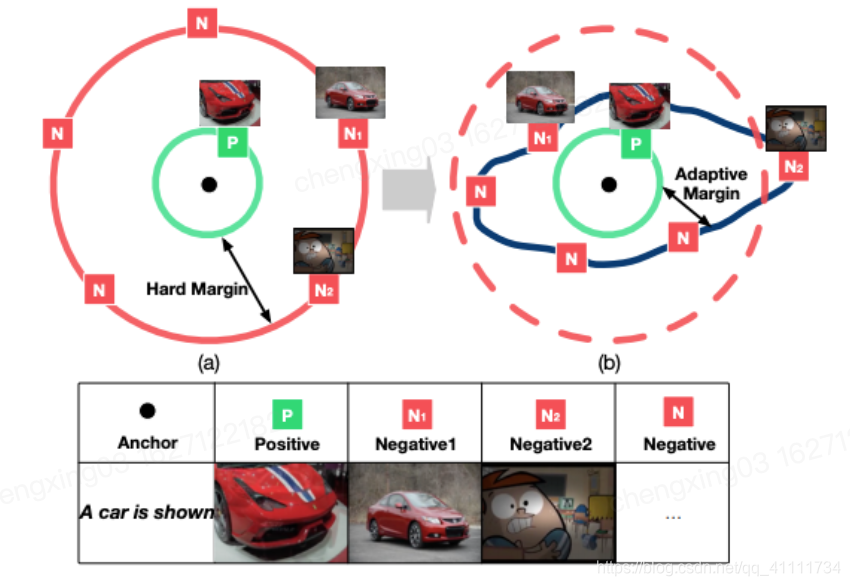

结果如下:

可以与本文档之前介绍的论文结果比较,看起来效果不是很好。

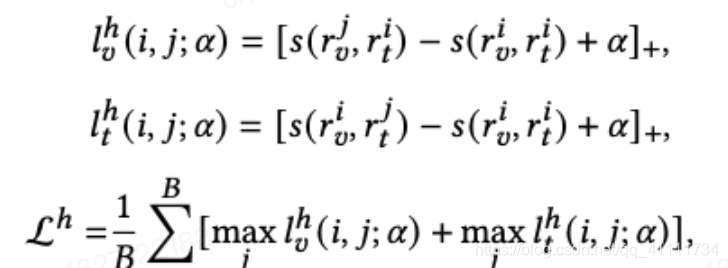

Improving Video Retrieval by Adaptive Margin

这篇论文的思路比较直接,在视频文本检索领域,常用的是hinge-based triplet loss。

主要的目的是想让随机采样得到的负样本与正样本的距离要大于一个固定的margin,这样对margin这个超参的设定要求较高。而且不同的正负样本可能不应该设定一样的margin,比如有些视频尽管是负样本但是可能他们的视觉特征本来就应该是比较符合文本特征的。

所以本论文提出了一种可以自适应变化超参margin的loss。主要思路是将原来的网络视为一个静态监督expert,然后设置一个动态expert来得到最合适的margin,用来得到对应的loss。

获取自适应margin的过程首先假设负样本的分布遵从正态分布:

对于i和j的margin,先计算i和j在视觉文本模态上的相似度,然后基于正态分布的假设归一化到对应的margin。

从实验结果上看带来了一定的提升

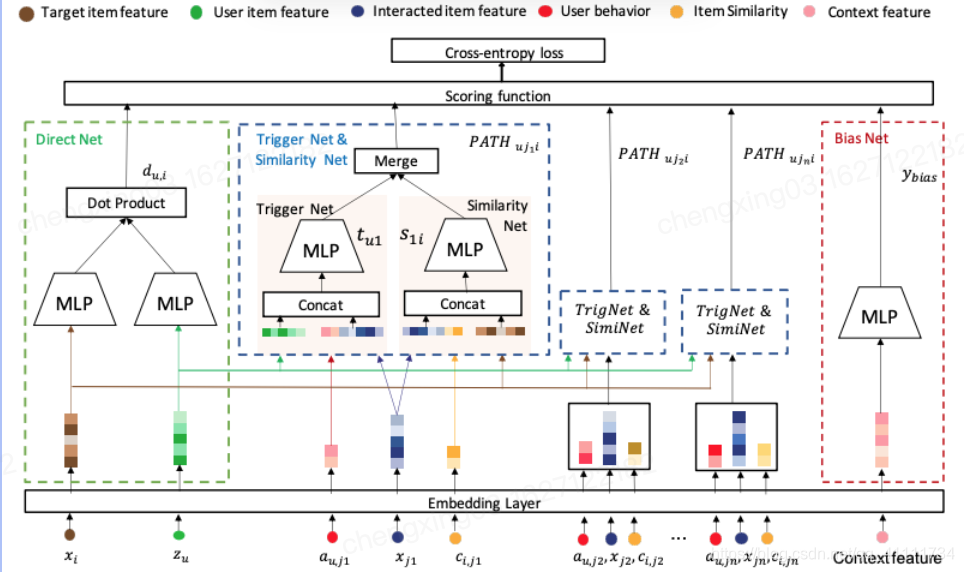

Path-based Deep Network for Candidate Item Matching in Recommenders

本文提出了一种新的基于路径的深度网络(PDN)匹配体系结构,通过融合个性化和多样性来提高匹配性能。具体来说,PDN由两个模块组成:触发网(Trigger Net)和相似网(Similarity Net)。PDN利用触发器网来捕获用户对他/她的每个交互项目的兴趣。相似度网络是基于每个交互物品的外形特征和CF信息来评价它们与目标物品之间的相似度。

网络结构如下:主要由不同的特征经过几个不同的交互网络构成

直接网络,直接计算用户和目标商品的特征相似度的网络

触发网络concat用户特征,用户行为,物品特征进行MLP

相似度网络concat目标物品特征,物品特征,物品共现概率空明显哦美好mlp

相似度网络用到了上下文特征,主要是为了消除点击目标的上下文的影响。

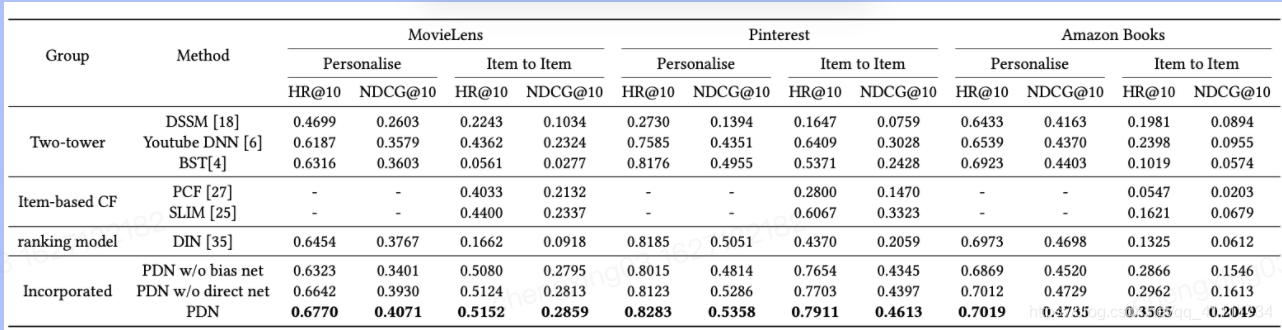

实验结果如下: