基础知识详见机器学习1,2,3,4,5,6

1、预测的结果好与不好,要看两个因素:bias和variance,如果bias大,variance小,欠拟合;如果bias小,variance大,过拟合;最好结果是bias和variance都小。

2、梯度下降注意三点:

(1)调整学习率

(2)随机的梯度下降

(3)特征缩放

3、优化器

批量梯度下降法(Batch Gradient Descent,简称BGD)是梯度下降法最原始的形式,它的具体思路是在更新每一参数时都使用所有的样本来进行更新。优点:全局最优解;易于并行实现;缺点:当样本数目很多时,训练过程会很慢。

随机梯度下降法(Stochastic Gradient Descent,简称SGD)正是为了解决批量梯度下降法这一弊端而提出的。利用每个样本的损失函数对求偏导得到对应的梯度,随机梯度下降是通过每个样本来迭代更新一次,如果样本量很大的情况(例如几十万),那么可能只用其中几万条或者几千条的样本,就已经将theta迭代到最优解了,对比上面的批量梯度下降,迭代一次需要用到十几万训练样本,一次迭代不可能最优,如果迭代10次的话就需要遍历训练样本10次。但是,SGD伴随的一个问题是噪音较BGD要多,使得SGD并不是每次迭代都向着整体最优化方向。优点:训练速度快;缺点:准确度下降,并不是全局最优;不易于并行实现。

原文链接:https://blog.csdn.net/boon_228/article/details/51721835

小批量梯度下降法(Mini-batch Gradient Descent,简称MBGD)的初衷:算法的训练过程比较快,而且也要保证最终参数训练的准确率。SGDM相比SGD优势明显,加入了动量机制,参数更新可以保持之前更新趋势,而不会卡在当前梯度较小的点。美中不足的是,SGDM没有考虑对学习率进行自适应更新,故学习率的选择很关键。

Adagrad自适应梯度下降利用迭代次数和累积梯度,对学习率进行自动衰减,从而使得刚开始迭代时,学习率较大,可以快速收敛。而后来则逐渐减小,精调参数,使得模型可以稳定找到最优点。Adagrad有个致命问题,就是没有考虑迭代衰减。极端情况,如果刚开始的梯度特别大,而后面的比较小,则学习率基本不会变化了,也就谈不上自适应学习率了。这个问题在RMSProp中得到了修正。

RMSProp它与Adagrad基本类似,只是加入了迭代衰减。

Adam是SGDM和RMSProp的结合,它基本解决了之前提到的梯度下降的一系列问题,比如随机小样本、自适应学习率、容易卡在梯度较小点等问题。

AMSGrad对Adam的改进在于,学习率衰减Vt变为了取max,优点为学习率可以随迭代次数单调递减,不会在某些迭代突然变大;去掉了没什么信息含量的梯度,也就是较小的梯度。

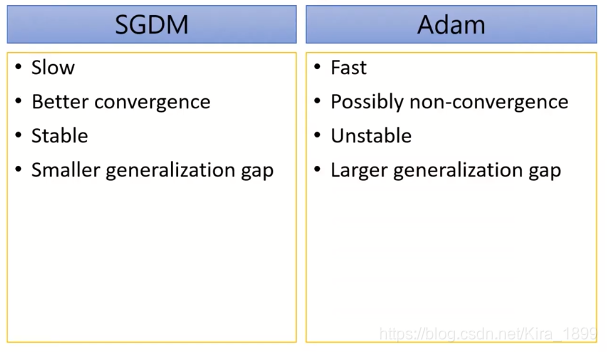

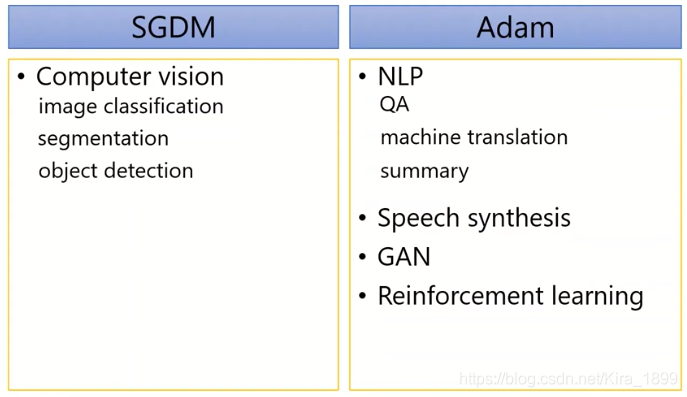

五大优化器其实分为两类,SGD、SGDM,和Adagrad、RMSProp、Adam、AMSGrad、AdaBound、Learning rate scheduling、RAdam、Nadam。使用比较多的是SGDM和Adam。SGDM在CV里面应用较多,而Adam则基本横扫NLP、RL、GAN、语音合成等领域。所以我们基本按照所属领域来使用就好了。比如NLP领域,Transformer、BERT这些经典模型均使用的Adam,及其变种AdamW。

SWATS结合了SGDM和Adam,刚开始使用Adam,使得模型快速收敛。然后使用SGDM,使模型收敛稳定。

Lookahead参数迭代n步后,再退回来一步。以新的起点重新开始迭代,这样可以增加收敛稳定性,防止跑飞。

optimizer优化主要有四种方法

让模型探索更多的可能,包括dropout、加入Gradient noise、样本shuffle等

让模型站在巨人肩膀上,包括warn-up、curriculum learning、fine-tune等

归一化 normalization,包括batch-norm和layer-norm等

正则化,惩罚模型的复杂度

原文链接:https://blog.csdn.net/u013510838/article/details/108268525