detach()方法? 得到一个和源张量共享内存,但没有梯度信息的张量,不参与计算图的梯度计算

clone()方法? ? 开辟新内存空间,其值和源张量一样,参与计算图中梯度计算并可将梯度信息传递到源张量进行累积,但通过clone方法得到的张量其只是一个中间值,梯度为None

import torch

a=torch.tensor(2.0,requires_grad=True)

b=a.clone() #参与计算图梯度计算,但是和a不是同一内存,改变b值不影响a值

c=a.detach() #不参与计算图的计算,和a是同一内存引用,改变c值影响a值

c+=1.0

b =b**2 + 3*b

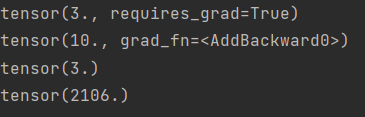

print(a) #a和c共享内存,a=3.

print(b) #b单独开辟空间,b=10.,同时引入计算图:

# b= b**2+3*b = (a_clone)** 2+ 3*(a_clone) (这里b是对值为2.的tensor a 的拷贝)

print(c) #c=3.

z= a **2 + b **3 + c**4; #z=a^2+b^3+c^4,在计算关于a的导数的时候,c不参与梯度计算

z.backward()

print(a.grad)结果:

?过程如下,只要记住clone得到的只是一个中间张量,并且关于其求导会累积到原张量中就行

另:

pytorch中为了提高效率,一些操作都是浅拷贝,即指向相同的内存空间,不另外开辟内存,常见浅拷贝操作比如tensor和nparray,list转换,detach,视图,切片和索引等?

深拷贝是指另外开辟内存空间的,类的构造方法Tensor(),工厂方法tensor(),clone等

参考链接: