笔记

- AlphaGo围棋规则

AlphaGo围棋有必胜策略的证明

AlphaGo围棋有必胜策略的证明

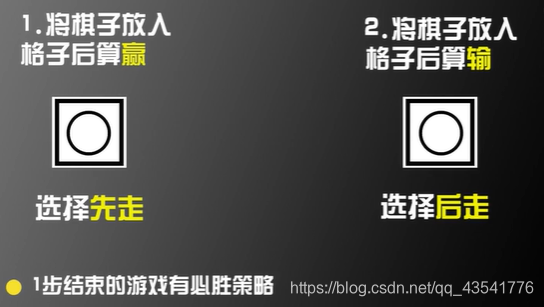

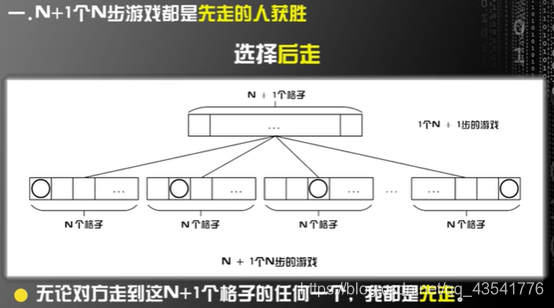

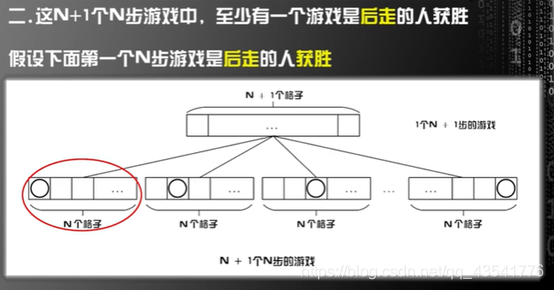

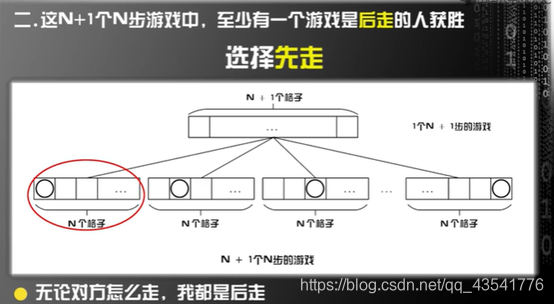

博弈论(Game Theory)中提到:任意有限步结束的零和博弈有必胜策略

用数学归纳法证明:

围棋是有限步结束的游戏吗?

- 强化学习(Q-Learning和epsilon-greedy算法)

强化学习与监督学习之间的区别,监督学习中训练数据和标签一一对应。强化学习中训练数据中没有标签,只有一个奖励函数reward function。

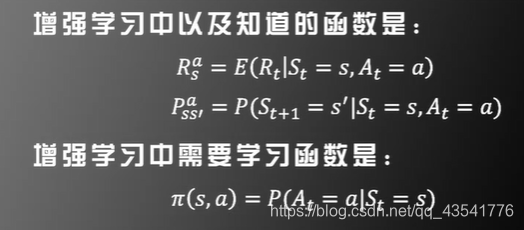

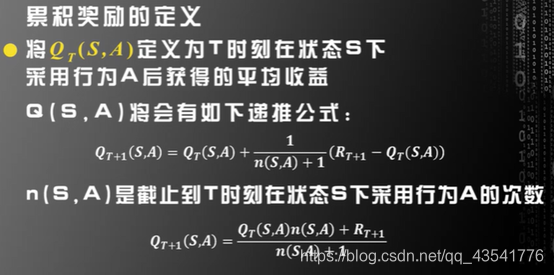

一些定义:

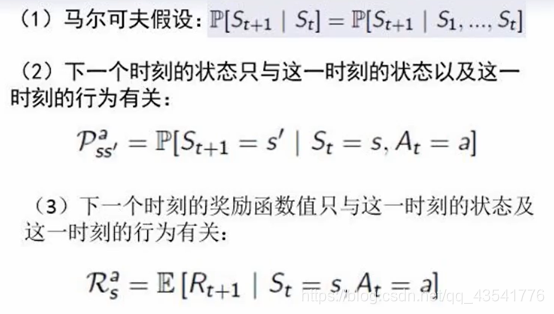

并且假设t+1时刻的状态只与t时刻有关,与之前都无关。这是在内部的情况,如有有外部因素的话也要考虑在内。

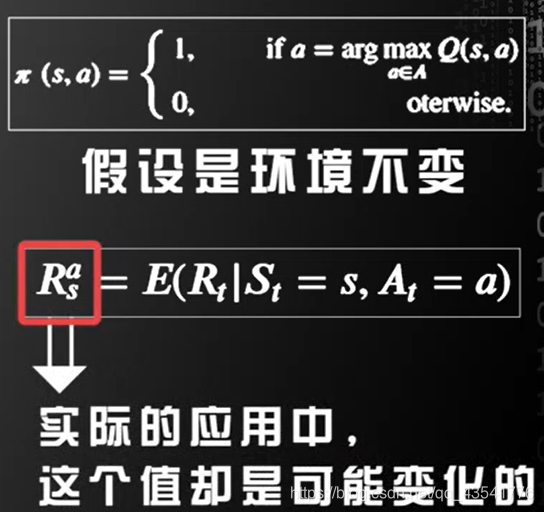

一些假设:

以概率1到达下一个状态。

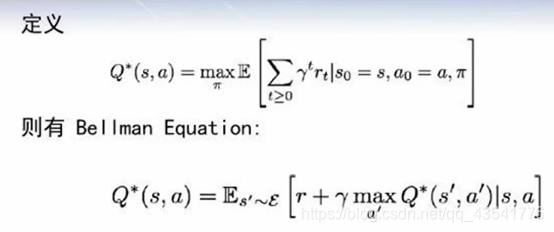

我们要学习这个函数

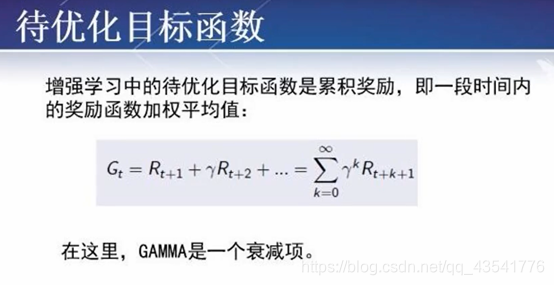

即Bellman Equation

对于不确定性,需要在Q-Learning算法中加入探索和利用(EXPLORATION AND EXPLOITATION)机制。

探索:稍微偏离目前的最好策略,以便达到搜索更好策略的目的。

利用:运用目前的最好策略获取较高的奖赏(Reward)。

基于探索和利用的epsilon-greedy算法是最常用的算法之一,概括的说,对于每一步以概率epsilon做探索,以概率1-epsilon做利用。

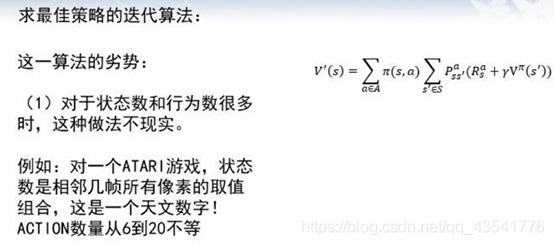

当状态数和行为数很多时,Q-Learning算法和EXPLORATION AND EXPLOITATION算法将会遇到困难。

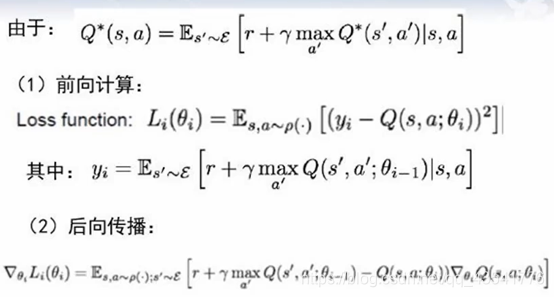

深度强化学习方向DEEP REINFORCEMENT LEARNING

Deep Q-Network(DQN)

其中θ是代估计的量

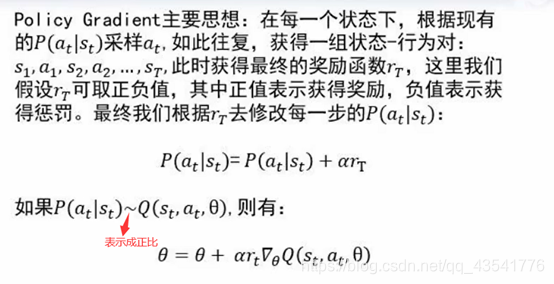

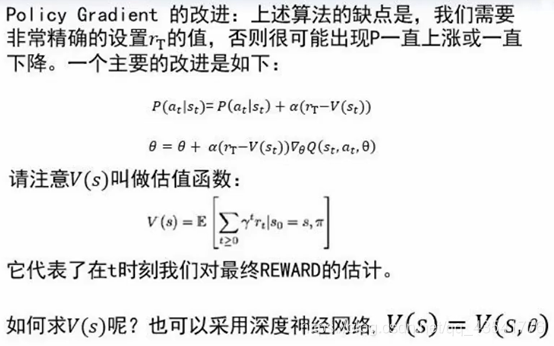

- policy gradient和actor-critic算法

即actor-critic算法,其主要思想是同时优化收益函数Q(s,a)和估值函数V(s)

Q是演员,V是评论家。Actor-Critic是一个演员和评论家互相促进,共同进步的算法。

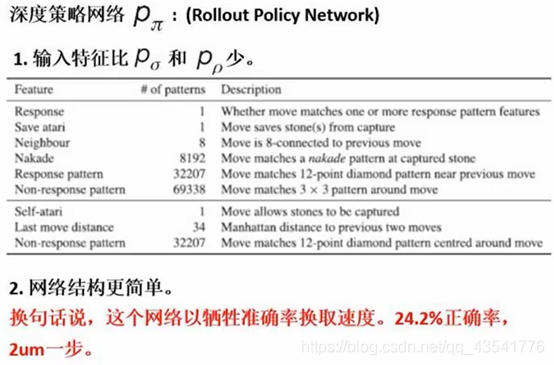

- 增强学习(AlphaGo)

为了避免对局的网络过于相似而出现的过拟合,应用了如下策略:

测验

1单选

在强化学习的过程中,学习率越大,说明使用新的尝试得到的结果比例越(),保留的旧的结果比例越()

A.小,小

B.小,大

C.大,大

D.大,小

正确答案:D

2单选

在强化学习的过程中,()在稍微偏离目前最好的策略的基础上,能够尝试更多种的策略。()是指运用目前最好的策略,获取更高的奖赏。

A.探索,利用

B.利用,输出

C.探索,输出

D.利用,探索

正确答案:A

3单选

?在epsilon-greedy算法中,epsilon的值越大,采用随机动作的概率越(),采用当前Q函数值代表的最大动作概率越()

A.小,大

B.小,小

C.大,小

D.大,大

正确答案:C

4多选

?强化学习包含的元素有()

A. Action

B. State

C. Agent

D.Reward

正确答案:A、B、C、D

5多选

?AlphaGo算法中,深度策略网络为了避免对局的网络过于相似出现的过拟合,采用下列那些策略()

A.每500次迭代就复制当前网络参数到对手池中

B.将当前版本网络与之前随即版本对局,得到输赢结果

C.将监督学习的网络复制作为增强学习的初始网络

D.利用reinforce算法更新参数最大化结果

正确答案:A、B、C、D

咋说呢,这一章光听b站的课是有些难懂的,本身原理有些难懂再加之涉及到很多其他方面知识,还有就是画面和PPT不太统一,看起来特别散,所以结合了mooc上的PPT。想搞懂的话估计还是要看这方面的书。