目录

数据集的获取途径

通常,数据来源于各个比赛平台,如百度AI Studio ,Kaggle、天池、讯飞等平台,或者是Github。

1.1 Kaggle有趣比较火热的数据集

House Prices-Advanced Regression Techniques ???? 预测销售价格

Cat and Dog ??? ???? ???? ???????? 猫狗分类

Machine Learning from Disaster ??????? ???? 预测泰坦尼克号的生存情况并熟悉机器学习基础知识

1.2 天池

Barley Remote Sensing Dataset大麦遥感检测数据集 ? ?遥感影像分割

耶鲁人脸数据库 ???? ???? ? ? ? ? ? ? ?? 目标检测任务(人脸检测)

1.3 DataFountain

花卉分类数据集 ????????? ??? ? ? ? ?? 图像分类

1.4 其他常用的数据集官网

数据处理与标注

2.1 官方数据处理成VOC或者COCO

2.1.1COCO2017数据集介绍

?? COCO数据集是Microsoft制作收集用于Detection + Segmentation + Localization + Captioning的数据集,作者收集了其2017年的版本,一共有25G左右的图片和600M左右的标签文件。

COCO数据集共有小类80个,分别为:

[‘person’, ‘bicycle’, ‘car’, ‘motorcycle’, ‘airplane’, ‘bus’, ‘train’, ‘truck’, ‘boat’, ‘traffic light’, ‘fire hydrant’, ‘stop sign’, ‘parking meter’, ‘bench’, ‘bird’, ‘cat’, ‘dog’, ‘horse’, ‘sheep’, ‘cow’, ‘elephant’, ‘bear’, ‘zebra’, ‘giraffe’, ‘backpack’, ‘umbrella’, ‘handbag’, ‘tie’, ‘suitcase’, ‘frisbee’, ‘skis’, ‘snowboard’, ‘sports ball’, ‘kite’, ‘baseball bat’, ‘baseball glove’, ‘skateboard’, ‘surfboard’, ‘tennis racket’, ‘bottle’, ‘wine glass’, ‘cup’, ‘fork’, ‘knife’, ‘spoon’, ‘bowl’, ‘banana’, ‘apple’, ‘sandwich’, ‘orange’, ‘broccoli’, ‘carrot’, ‘hot dog’, ‘pizza’, ‘donut’, ‘cake’, ‘chair’, ‘couch’, ‘potted plant’, ‘bed’, ‘dining table’, ‘toilet’, ‘tv’, ‘laptop’, ‘mouse’, ‘remote’, ‘keyboard’, ‘cell phone’, ‘microwave’, ‘oven’, ‘toaster’, ‘sink’, ‘refrigerator’, ‘book’, ‘clock’, ‘vase’, ‘scissors’, ‘teddy bear’, ‘hair drier’, ‘toothbrush’]

大类12个,分别为

[‘appliance’, ‘food’, ‘indoor’, ‘accessory’, ‘electronic’, ‘furniture’, ‘vehicle’, ‘sports’, ‘animal’, ‘kitchen’, ‘person’, ‘outdoor’]

COCO格式,文件夹路径样式:

COCO_2017/

├── val2017 # 总的验证集

├── train2017 # 总的训练集

├── annotations # COCO标注

│ ├── instances_train2017.json # object instances(目标实例) ---目标实例的训练集标注

│ ├── instances_val2017.json # object instances(目标实例) ---目标实例的验证集标注

│ ├── person_keypoints_train2017.json # object keypoints(目标上的关键点) ---关键点检测的训练集标注

│ ├── person_keypoints_val2017.json # object keypoints(目标上的关键点) ---关键点检测的验证集标注

│ ├── captions_train2017.json # image captions(看图说话) ---看图说话的训练集标注

│ ├── captions_val2017.json # image captions(看图说话) ---看图说话的验证集标注

VOC格式,文件夹路径样式:

VOC_2017/

├── Annotations # 每张图片相关的标注信息,xml格式

├── ImageSets

│ ├── Main # 各个类别所在图片的文件名

├── JPEGImages # 包括训练验证测试用到的所有图片

├── label_list.txt # 标签的类别数

├── train_val.txt #训练集

├── val.txt # 验证集

2.1.2 Object Keypoint 类型的标注格式

{

"info": info,

"licenses": [license],

"images": [image],

"annotations": [annotation],

"categories": [category]

}

?? 其中,info、licenses、images这三个结构体/类型,在不同的JSON文件中这三个类型是一样的,定义是共享的(object instances(目标实例), object keypoints(目标上的关键点), image captions(看图说话))。不共享的是annotation和category这两种结构体,他们在不同类型的JSON文件中是不一样的。 新增的keypoints是一个长度为3 X k的数组,其中k是category中keypoints的总数量。每一个keypoint是一个长度为3的数组,第一和第二个元素分别是x和y坐标值,第三个元素是个标志位v,v为0时表示这个关键点没有标注(这种情况下x=y=v=0),v为1时表示这个关键点标注了但是不可见(被遮挡了),v为2时表示这个关键点标注了同时也可见。

um_keypoints表示这个目标上被标注的关键点的数量(v>0),比较小的目标上可能就无法标注关键点。

annotation{

"keypoints": [x1,y1,v1,...],

"num_keypoints": int,

"id": int,

"image_id": int,

"category_id": int,

"segmentation": RLE or [polygon],

"area": float,

"bbox": [x,y,width,height],

"iscrowd": 0 or 1,

}

示例:

{

"segmentation": [[125.12,539.69,140.94,522.43,100.67,496.54,84.85,469.21,73.35,450.52,104.99,342.65,168.27,290.88,179.78,288,189.84,286.56,191.28,260.67,202.79,240.54,221.48,237.66,248.81,243.42,257.44,256.36,253.12,262.11,253.12,275.06,299.15,233.35,329.35,207.46,355.24,206.02,363.87,206.02,365.3,210.34,373.93,221.84,363.87,226.16,363.87,237.66,350.92,237.66,332.22,234.79,314.97,249.17,271.82,313.89,253.12,326.83,227.24,352.72,214.29,357.03,212.85,372.85,208.54,395.87,228.67,414.56,245.93,421.75,266.07,424.63,276.13,437.57,266.07,450.52,284.76,464.9,286.2,479.28,291.96,489.35,310.65,512.36,284.76,549.75,244.49,522.43,215.73,546.88,199.91,558.38,204.22,565.57,189.84,568.45,184.09,575.64,172.58,578.52,145.26,567.01,117.93,551.19,133.75,532.49]],

"num_keypoints": 10,

"area": 47803.27955,

"iscrowd": 0,

"keypoints": [0,0,0,0,0,0,0,0,0,0,0,0,0,0,0,142,309,1,177,320,2,191,398,2,237,317,2,233,426,2,306,233,2,92,452,2,123,468,2,0,0,0,251,469,2,0,0,0,162,551,2],

"image_id": 425226,"bbox": [73.35,206.02,300.58,372.5],"category_id": 1,

"id": 183126},

2.1.3 categories字段

?? 最后,对于每一个category结构体,相比Object Instance中的category新增了2个额外的字段,keypoints是一个长度为k的数组,包含了每个关键点的名字;skeleton定义了各个关键点之间的连接性(比如人的左手腕和左肘就是连接的,但是左手腕和右手腕就不是)。

目前,COCO的keypoints只标注了person category (分类为人)。

{

"id": int,

"name": str,

"supercategory": str,

"keypoints": [str],

"skeleton": [edge]

}

示例:

{

"supercategory": "person",

"id": 1,

"name": "person",

"keypoints": ["nose","left_eye","right_eye","left_ear","right_ear","left_shoulder","right_shoulder","left_elbow","right_elbow","left_wrist","right_wrist","left_hip","right_hip","left_knee","right_knee","left_ankle","right_ankle"],

"skeleton": [[16,14],[14,12],[17,15],[15,13],[12,13],[6,12],[7,13],[6,7],[6,8],[7,9],[8,10],[9,11],[2,3],[1,2],[1,3],[2,4],[3,5],[4,6],[5,7]]

}

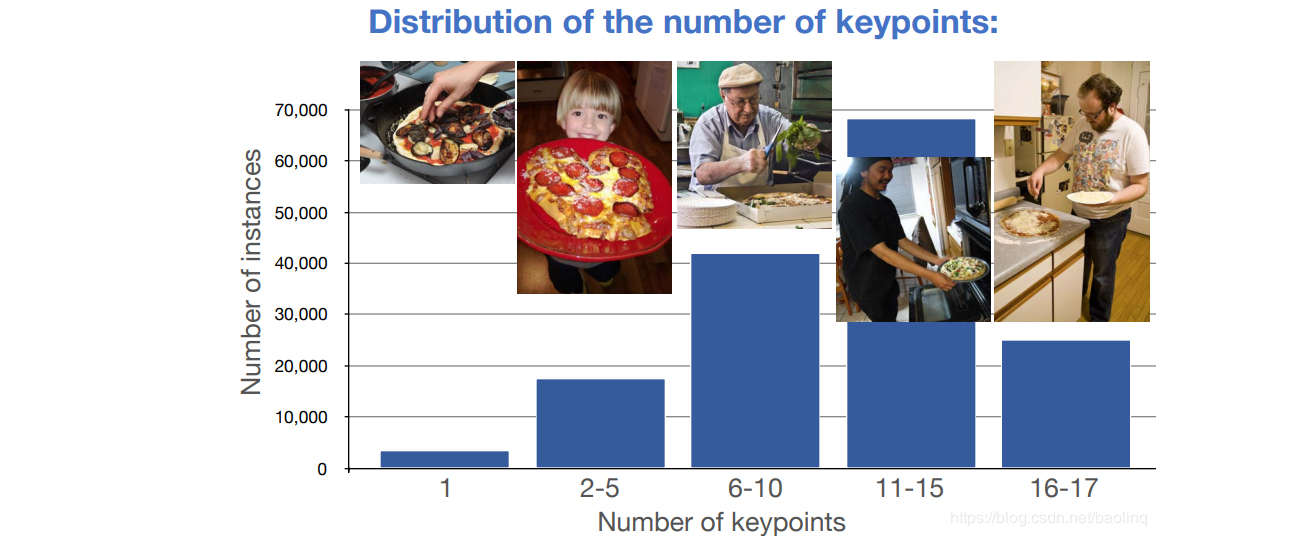

2.1.4 数据集统计信息

?? 人体关键点标注,每个人体关键点个数的分布情况,其中11-15这个范围的人体是最多的,有接近70000人,6-10其次,超过40000人,后面依次为16-17,2-5,…

2.2 自定义数据集训练

2.2.1 常见标注工具

??对于图像分类任务,我们只要将对应的图片是哪个类别划分好即可。对于检测任务和分割任务,目前比较流行的数据标注工具是labelimg、labelme,分别用于检测任务与分割任务的标注。

标注工具Github地址:

??????????labelimg

??????????labelme

??????????PPOCRLabel

2.2.2 制作VOC格式与CoCo格式数据集并划分

数据预处理方法

图像增强:

RGB->BGR/Gray, resize, 锐化, 亮度变换, 提高对比度, rotate, 注入噪声等

模型训练评估

mAP:

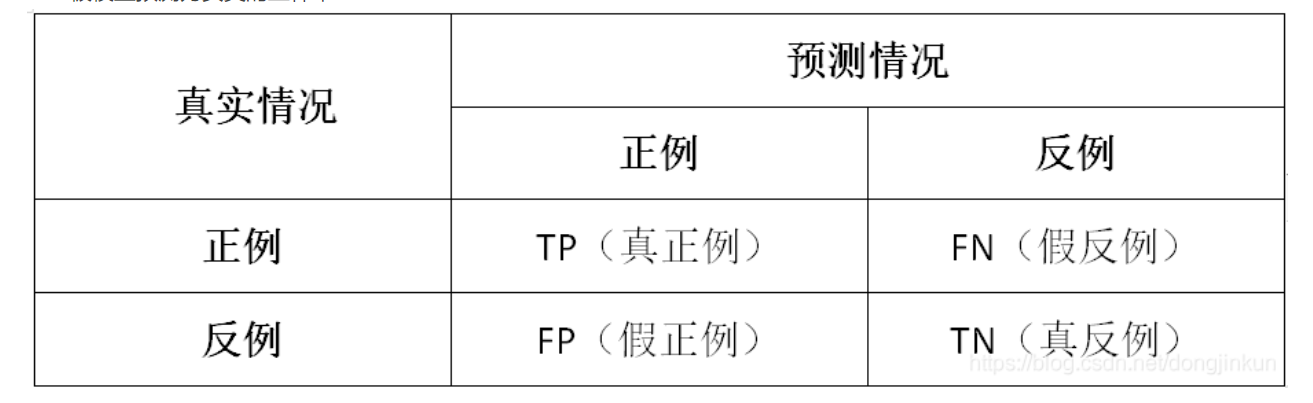

在机器学习领域中,用于评价一个模型的性能有多种指标,其中几项就是FP、FN、TP、TN、精确率(Precision)、召回率(Recall)、准确率(Accuracy)。

mean Average Precision, 即各类别AP的平均值,是AP:PR 曲线下面积。

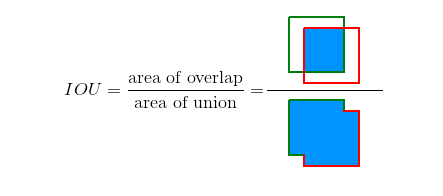

此前先了解一下IOU评判标准:

TP、FP、FN、TN

常见的评判方式,第一位的T,F代表正确或者错误。第二位的P和N代表判断的正确或者错误

-

True Positive (TP): I o U > I O U threshold? \mathrm{IoU}>I O U_{\text {threshold }} IoU>IOUthreshold?? (IOU的阈值一般取0.5)的所有检测框数量(同一Ground Truth只计算一次),可以理解为真实框,或者标准答案

-

False Positive (FP): I o U < I O U threshold? \mathrm{IoU}<I O U_{\text {threshold }} IoU<IOUthreshold?? 的所有检测框数量

-

False Negative (FN): 没有检测到的 GT 的数量

-

True Negative (TN): mAP中无用到

查准率(Precision): Precision = T P T P + F P = T P ?all?detections? =\frac{T P}{T P+F P}=\frac{T P}{\text { all detections }} =TP+FPTP?=?all?detections?TP?

查全率(Recall): Recall = T P T P + F N = T P ?all?ground?truths? =\frac{T P}{T P+F N}=\frac{T P}{\text { all ground truths }} =TP+FNTP?=?all?ground?truths?TP?

二者绘制的曲线称为 P-R 曲线:

查准率:P 为纵轴y 查全率:R 为横轴x轴,如下图

mAP值即为,PR曲线下的面积。