介绍

目标检测背景

目标检测结构

目标检测框架

目标检测可以分为两种类型 :

特定实例的检测

特定类别的检测

第一种类型的目标是检测特定目标的实例,而第二种类型的目标是检测不同的预定义目标类别的实例(例如人类、汽车、自行车和狗.

2012年,Krizhevsky等人提出了一个叫做AlexNet的深度卷积神经网络(DCNN),它在大规模的视觉识别挑战(ILSRVC)[179]中实现了破纪录的图像分类精度

特定目标检测:例如行人检测[51、60、48]人脸检测[226、232],车辆检测{196}和文本检测

2.1目标检测的问题

2.2 Main Challenges

检测精度

1.类内变化的巨大范围

内在因素

影像学条件

2.大量的目标对象类别

demands great discrimination power from the detector to distinguish between subtly different interclass variations

检测效率

计算能力和存储空间有限

效率取决于定位和识别

2.3过去二十年取得的进展

早期:基于模板匹配技术和简单的基于零件的模型

1990前:基于几何表示,

随后:统计分类器(如神经网络,SVM和Adaboost ),基于外观

DCNNs的成功应用在图像分类被转移到目标检测

DCNN介绍:

DCNN优势:

大规模标记数据集的可用性和具有极高计算能力的gpu

DCNN不足:

1)对标记训练数据的极度需求和昂贵的计算资源的需求

2)选择合适的学习参数和网络架构仍然需要相当的技能和经验。

3)对退化缺乏鲁棒性

4)许多dcnn存在严重的攻击漏洞

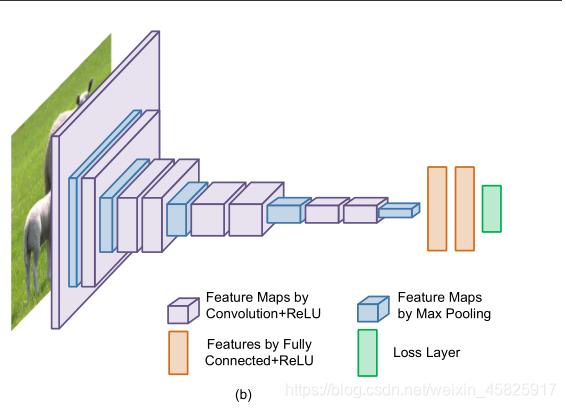

AlexNet是第一个现代深度卷积网络模型,首次使用了许多现代深度卷积网络的技术方法,AlexNet是在LeNet的基础上加深了网络的结构,学习更丰富更高维的图像特征。

AlexNet网络结构在整体上类似于LeNet,都是先卷积然后在全连接。但在细节上有很大不同。AlexNet更为复杂。AlexNet有60 million个参数和65000个 神经元,五层卷积,三层全连接网络,最终的输出层是1000通道的softmax。AlexNet利用了两块GPU进行计算,大大提高了运算效率。

AlexNet的特点:

1)更深的网络结构

2)使用层叠的卷积层,即卷积层+卷积层+池化层来提取图像的特征

3)使用Dropout抑制过拟合

4)使用数据增强Data Augmentation抑制过拟合

神经网络由于训练的参数多,表能能力强,所以需要比较多的数据量,不然很容易过拟合。当训练数据有限时,可以通过一些变换从已有的训练数据集中生成一些新的数据,以快速地扩充训练数据。对于图像数据集来说,可以对图像进行一些形变操作

5)使用Relu替换之前的sigmoid的作为激活函数

6)多GPU训练

Dropout工作原理:

引入Dropout主要是为了防止过拟合。在神经网络中Dropout通过修改神经网络本身结构来实现,对于某一层的神经元,通过定义的概率将神经元置为0,这个神经元就不参与前向和后向传播,就如同在网络中被删除了一样,同时保持输入层与输出层神经元的个数不变,然后按照神经网络的学习方法进行参数更新。在下一次迭代中,又重新随机删除一些神经元(置为0),直至训练结束。

4.** Datasets**

PASCAL VOC ( fallen out of fashion)

ImageNet (atypical of real-world scenarios)

MS COCO(包含了复杂的日常场景和自然环境中的普通物体,更接近真实生活) the standard for object detection

Open Images(only the object instances of human-

confirmed positive labels are annotated)仅标注正面标签的对象实例

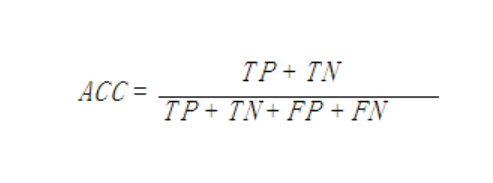

Evaluation Criteria:

1) detection speed in Frames Per Second (FPS)

FPS用来评估目标检测的速度。即每秒内可以处理的图片数量

2)precision

准确率是我们最常见的评价指标,而且很容易理解,就是被分对的样本数除以所有的样本数,通常来说,正确率越高,分类器越好

3)recall

召回率是覆盖面的度量,度量有多个正例被分为正例,recall=TP/(TP+FN)=TP/P=sensitive,

most commonly used metric:Average Precision (AP)

True Positive(真正,TP):将正类预测为正类数

True Negative(真负,TN):将负类预测为负类数

False Positive(假正,FP):将负类预测为正类数误报 (Type I error)

False Negative(假负,FN):将正类预测为负类数→漏报 (Type II error)

mAP

TP: IoU>0.5的检测框数量(同一 Ground Truth 只计算一次)

FP: IoU<=0.5的检测框,或者是检测到同一个 GT 的多余检测框的数量

FN: 没有检测到的GT的数量

GT:ground truth box:标准数据

Precision: TP / (TP + FP)

Recall: TP / (TP + FN)

PR曲线: Precision-Recall曲线

AP: PR曲线下的面积,综合考量了 recall 和 precision 的影响,反映了模型对某个类别识别的好坏。

mAP: mean Average Precision, 即各类别AP的平均值,衡量的是在所有类别上的平均好坏程度。

3. 目标检测的结构