Pre-training is a Hot Topic: Contextualized Document Embeddings

Improve Topic Coherence

基本信息

-

题目: Pre-training is a Hot Topic: Contextualized Document Embeddings Improve Topic Coherence

-

作者: Federico Bianchi Bocconi University

-

期刊: ACL

-

时间: 2021

摘要

主题模型从文档中提取单词组,将其解释为主题有望更好地理解数据。然而,由此产生的词组往往不连贯,使它们更难解释。最近,神经主题模型在整体一致性方面有了改善。与此同时,上下文嵌入也在总体上推进了神经模型的发展。在本文中,我们将情境化表示与神经主题模型相结合。我们发现,我们的方法比传统的袋词产生了更有意义和连贯的主题词语。我们的研究结果表明,未来语言模型的改进将转化为更好的主题模型。

研究动机&解决的问题

主题模型往往是基于词袋模型表示为文章的输入,词袋模型往往会忽略词句之间的语法以及语义。而且Bow模型本事就不是一种连贯的输入,本文提出将NLP中的预训练模型引入主题模型可以显著的提高主题的连贯性。

方法

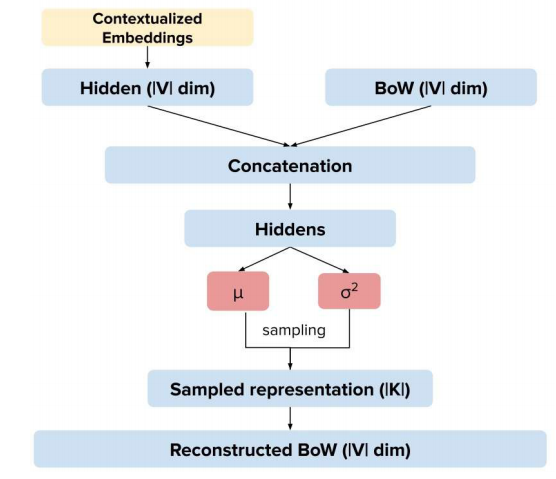

主要有两部分组成:

-

Neural Topic Model使用ProdLDA

-

使用SBERT的embed表示

模型的架构如上图表示,其中从Context Vector从Embedding映射到 ∣ V ∣ |V| ∣V∣维的向量,最后和Bow向量进行拼接。

实验结果

1、 主题定性衡量:

三个指标:NMPI ( τ \tau τ)、External word embeddings topic coherence( α \alpha α考察在Word Embedding上主题词之间的相似性 计算词向量的余弦相似度)和Inversed Rank-Biased Overlap(不同主题的相似性)

- 使用不同的预训练模型:Ours-R : SBERT Ours-B:Bert 用SBERT比较好

创新点在哪里

用预训练模型解决了神经主题模型文档使用词袋向量的不足。实验结果表明加入预训练的文档表示确实对提升主题模型的连贯程度有很大的帮助。

结论

文章讲了什么?有哪些不足?有什么创新?…

重要的文献

文章引用的文献可为今后科研写作提供参考的、有价值的参考文献。

-

Auto encoding variational inference for topic models

-

Sentence-BERT: Sentence embeddings using Siamese BERT-networks