论文:High-frequency Component Helps Explain the Generalization of Convolutional Neural Networks

核心:论文注意到CNN具备捕获人类无法感知的高频成分能力,

2020年CVPR 顶会

实验一:

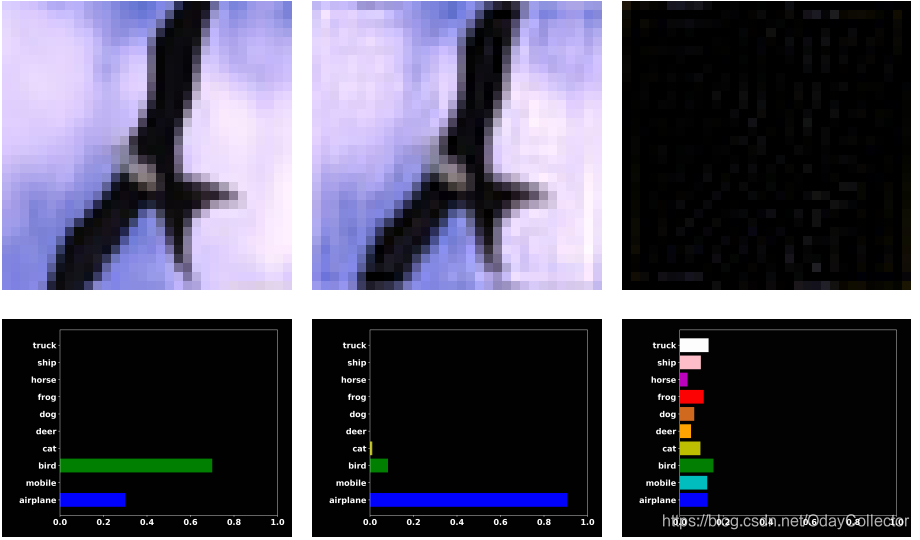

发现了一些非常奇怪的事情:模型对人眼看上去和原图差不多的低频图错误预测,反而正确预测了全黑的高频图

(左边是原始图片,中间是低频图片 ,右边是高频图片)

就这个现象作者提出了合理假设:人类只能感知低频,CNN对低频高频都有感知;

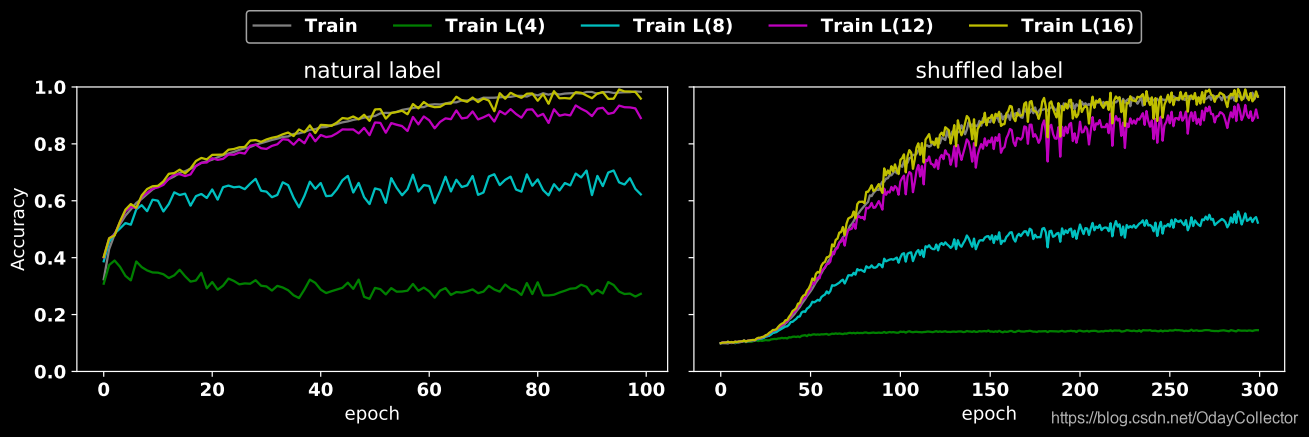

实验二

可以观察3点:

- 右边震荡强:

- 起点不同

- n增大 acc随之增大

4.epoch

分析:

第一点:震荡可能跟泛化性有关,

第二点:左图比右图起点高40%的acc,

作者推导:CNN在训练早期会先利用语义信息或低频信息进行训练,当loss不能再下降时会额外引入高频成分进一步降低loss,右图因为shuffle了无法利用低频语义信息,则出现了刚开始acc为0的现象,但是后期因为利用了高频成分,故最终还是能够完全拟合数据。

第三点:随着半径变大,高频保留的成分越来越多,CNN能利用的高频成分也越来越多,所以loss可以不断下降

第四点:epoch差不少,

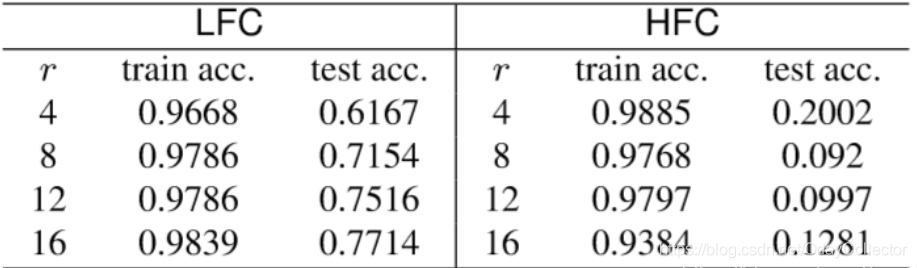

实验三:分别用低频和高频图片重新训练Model,用测试集进行测试,结果如下:

结果可以看出,低频训练的泛化能力高于高频训练的。

泛化性:指根据有限样本得到的网络模型对其他变量域也有良好的预测能力。