题目

Deep Neural Network Based Relation Extraction: An Overview

单位:University of Electronic Science and Technology of China

内容

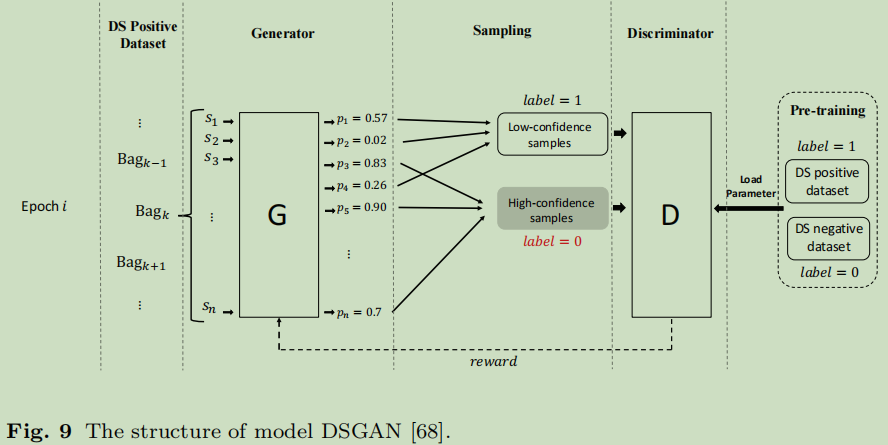

1. 框架

分为四个部分:数据集,句子表示,特征抽取,分类器

这个框架是比加传统的关系抽取方法了。

2. 相关概念

Neural Networks:Convolutional Neural Networks (CNNs),Recurrent Neural Networks (RNNs), Recursive Neural Networks, Graph Neural Networks (GNNs)

Word Embedding :把词信息编码成低维,转入模型中,例如word2vec

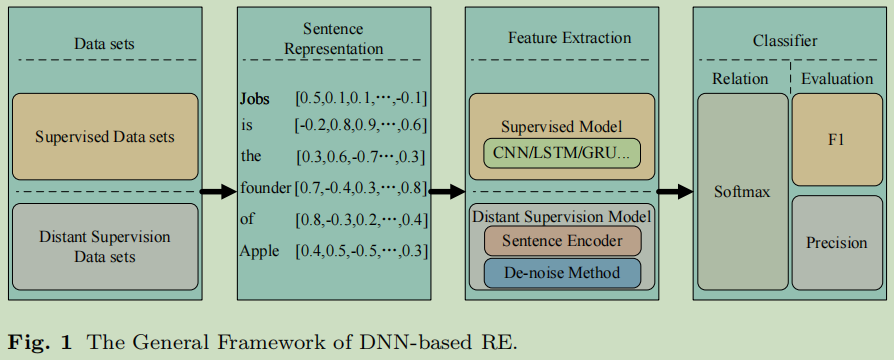

Position Embedding:把实体的相对位置编码,输入到模型中;

Shortest Dependency Path (SDP) :一种单词级去噪方法,源自语法依赖树,该树掩盖了句子中实体流动中不相关单词的关系。

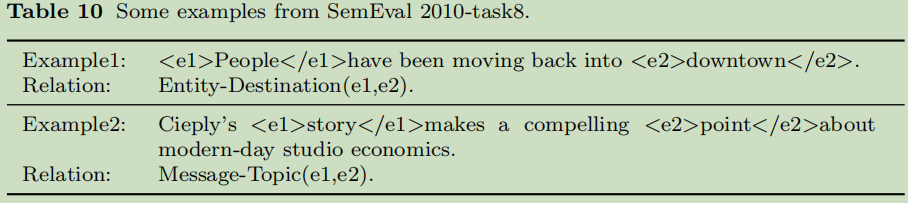

例如*<e1>People</e1>have been moving back into <e2>downtown</e2>*.

依赖树之后:[P eople]_e1→moving→into→[downtown]_e2

SDP捕捉了谓语参数序列句子。

3. 传统方法

方法分类:手工构建的模式方法(hand-built pattern methods)、半监督方法( semi-supervised methods)、监督方法( supervised methods)、无监督方法( unsupervised methods)和远程监督方法(distant supervision methods)。

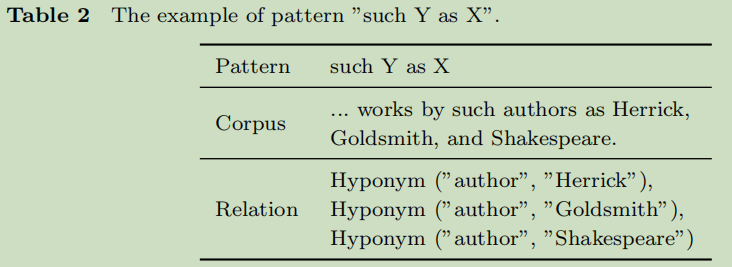

3.1 手工构建的模式方法

专家介入,制定模式,然后进行匹配。

这种方法太枆人力成本了,也对人工要求很高。

3.2 半监督方法

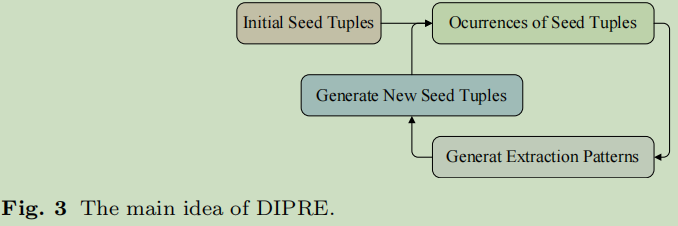

半监督方法本质上是基于模式的方法, 是一个循环提升的方法;

首先初始化一个三元组集合,然后使用这些三元组去生成抽取Patterns, 接着用这些Patterns去生成三元组,接下来又一开始新一轮的循环。具体:

这种方法,在某些工程样本抽取时,还是很适用的,不过噪音比较大的。

工具:Snowball, KnowItAll, TextRunner ,还有个《Ranking-based automatic seed selection and noise reduction for weakly supervised relation extraction》

这个思想好像也弱监督是不谋如合。可是人工来定义相关的关系也是一个很大的工作量咯。

3.3 监督方法

一般看成是多分类任务,其实也有看成是二分类任务的。

分成两类:feature-based , kernel-based

基于特征的方法: lexical,syntactical, semantic

基于核的方法: 设计核函数;

这里的无论是特征还是核都是让人工去做的事情。

3.4 无监督方法

无监督方法采用自下而上的信息提取策略:具有相同语义关系的不同实体对的上下文信息相对相似。

这个相对于手动规则那个,这个方法是让机器去抽取patterns,而这些patterns人类可能不可理解的,不可读的。

例如:Hasegawa et al. [39]分三步,第一步,抽取出实体对与上下文;第二步,根据上下文来聚类实体对;第三步,标签这些聚类结果;2004年的方法,显然有点旧了。

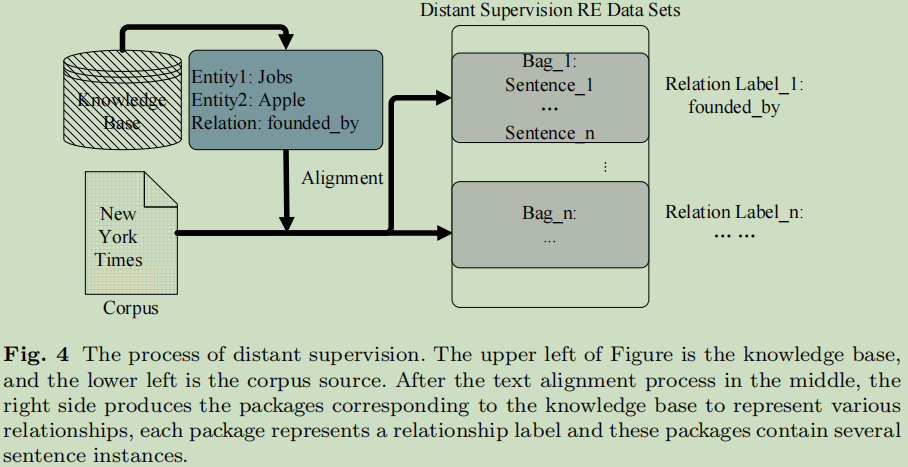

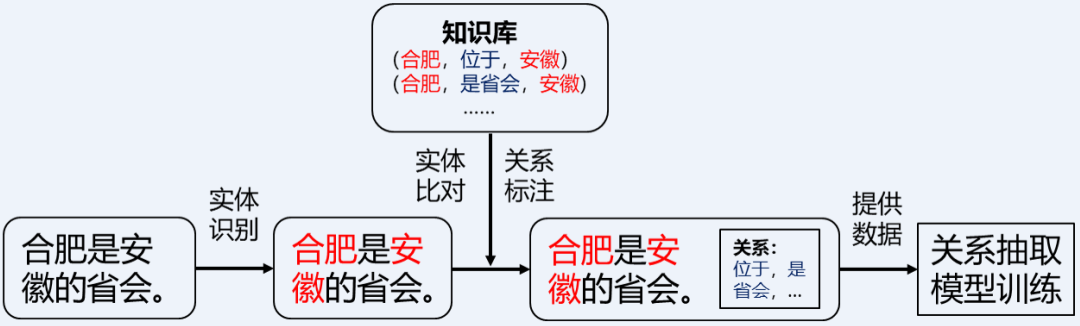

3.5 远程监督方法

远程监督方法是一种提出的基于知识或弱监督的方法;

如果两个实体有某种相关关系,所有提到这两个实体的句子都可以表达这种关系。

可以自动标注了,可是会带来标签错误、精度低的问题。

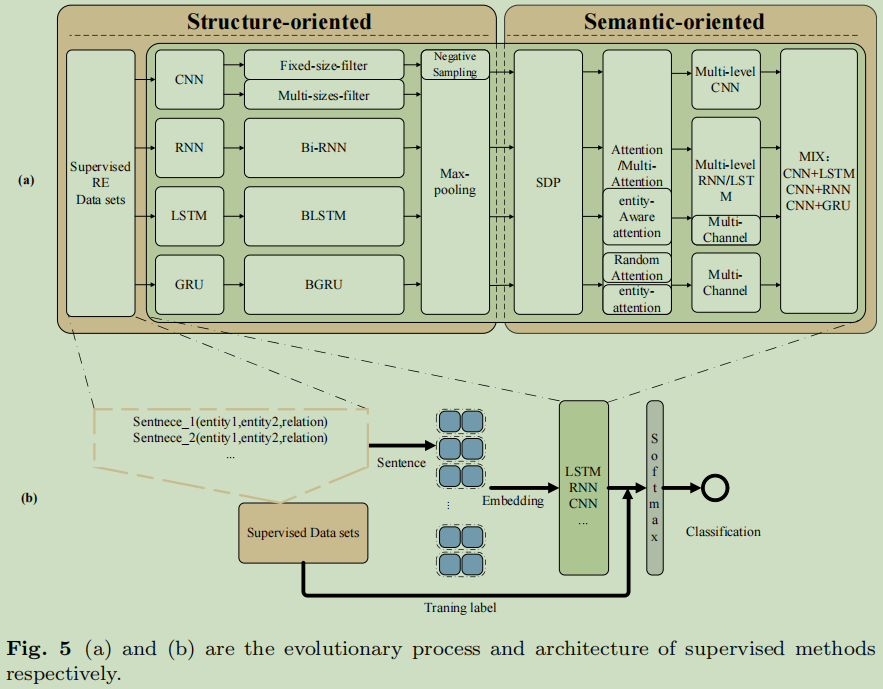

4. 基于DNN的监督RE

进化过程(面向结构型和面向语义型)与监督学习框架。

面向结构的类通过改变模型的结构来提高特征提取的能力; — 这里说的结构指的是神经网络的结构,侧重点在特征提取上;

面向语义的类通过挖掘文本的内部关联来提高语义表示的能力;— 侧重点在语义表达上;

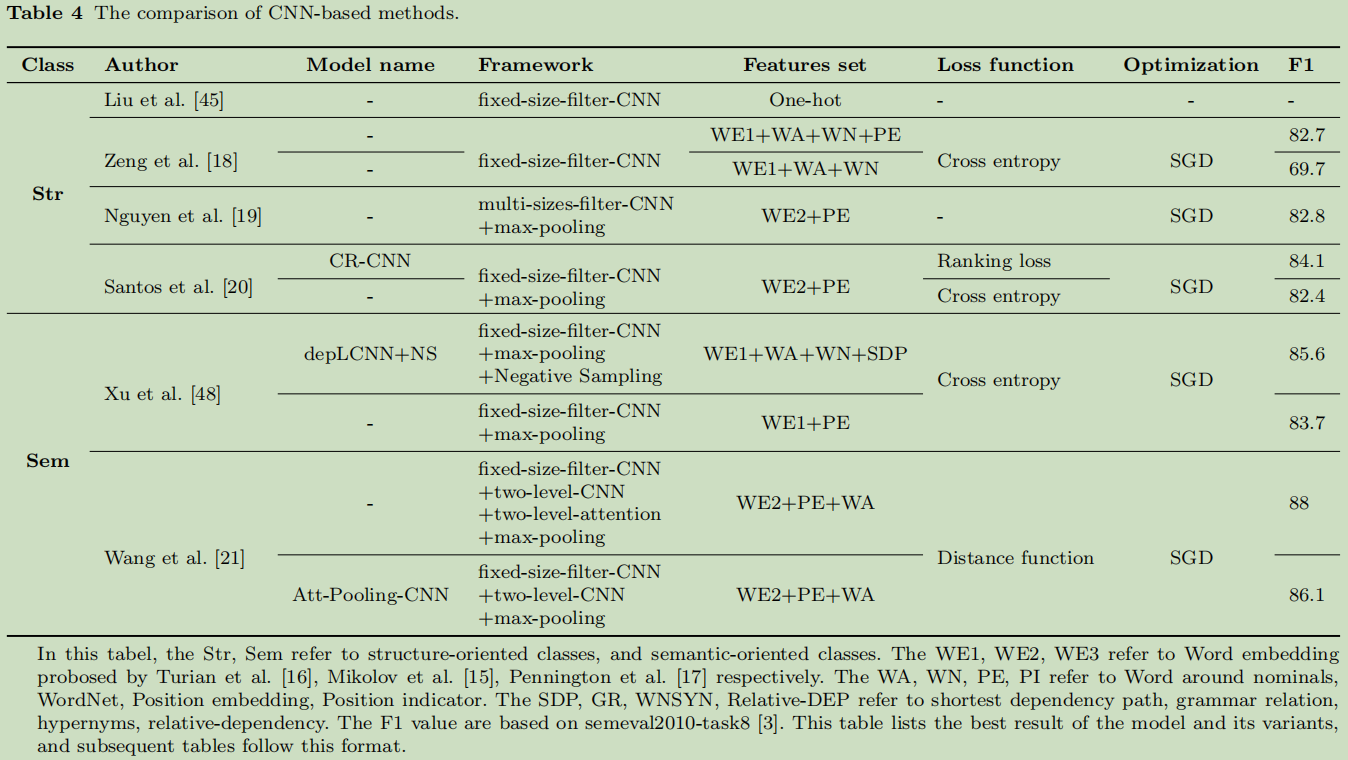

4.1 基于CNN的方法

在神经网络的结构优化方面(Str):

Liu et al. [45](2013)Convolution neural network for relation extraction,在RE问题提出使用CNN—一次尝试;

Kim [46](2014) Convolutional neural networks for sentence classifification,对CNN引入multiple fifilters 与 max-pooling 模块,来解决文本分类任务;

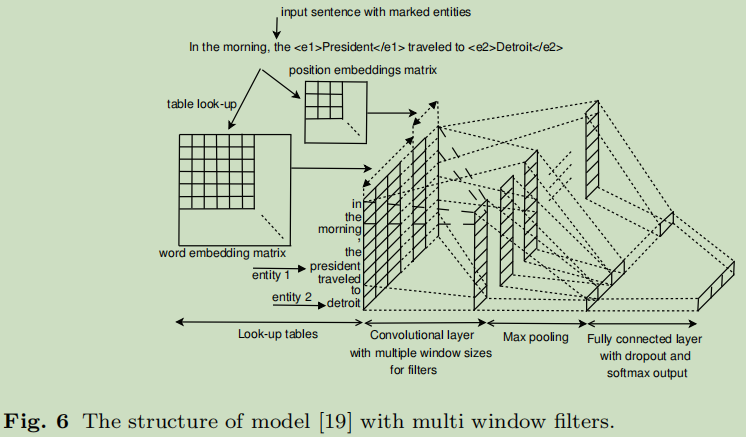

Zeng et al. [18] (2014) Relation classifification via convolutional deep neural network,引入了实体间的PE概念,大大解决了预处理问题;

Nguyen et al. [19],(2015) Relation extraction: Perspective from convolutional neural networks. 对于PE提出多窗口大小的过滤器;

Santos et al. [20], (2015) Classifying relations by ranking with convolutional neural networks. 改进了loss函数,采用了ranking loss function;

在句子的语义方面的优化(Sem):

Xu etal. [48], (2015) Semantic relation classifification via convolutional neural networks with simple negative sampling , 使用SDP的CNN.该模型主要以句子的主体为对象作为输入,通过简单的负样本,删除与关系识别不相关的单词。

Wang et al. [21],(2016) Relation classifification via multilevel attention cnns. 使用两层关注机制;在句子层与词层两层对语义信息的研究。

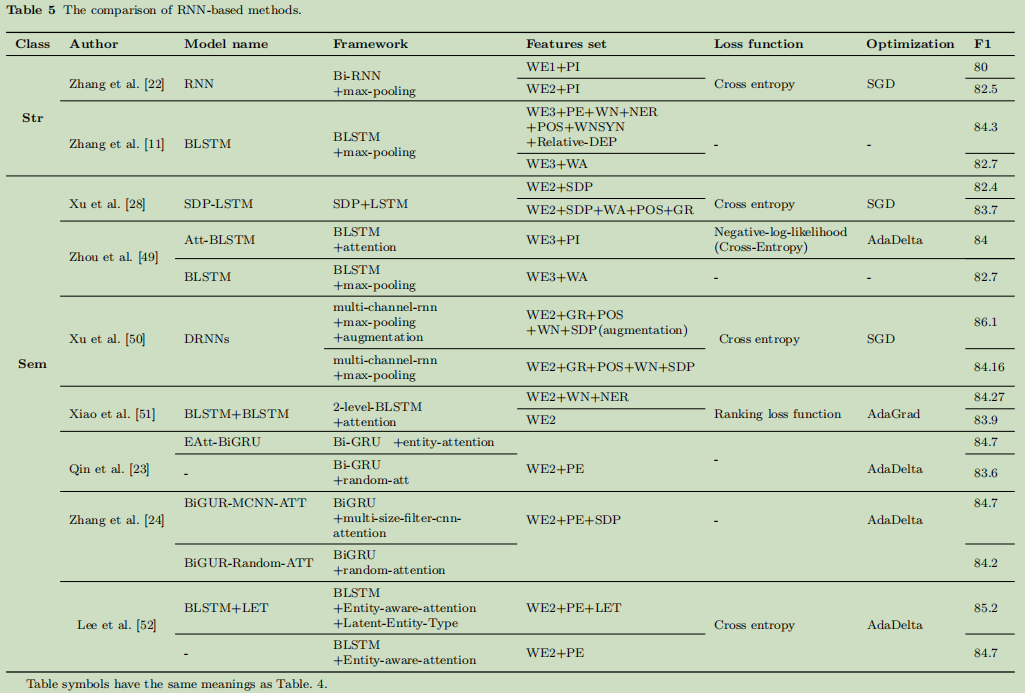

4.2 基于RNN或LSTM的方法

Zhang et al. [22] ,(2015) Relation classifification via recurrent neural network, 使用bi-rnn来解决re问题。这里有梯度爆炸的缺点;

Zhang et al. [11], (2015) Bidirectional long short-term memory networks for relation classifification. 使用了BLSTM;

Xu et al. [28], (2015) Classifying relations via long short term memory networks along shortest dependency paths,lstm与SDP相结合;输入四种信息 Word vectors, POS tags, Grammatical relations, and WordNet hypernyms

Xu et al. [50] , (2016) Improved relation classifification by deep recurrent neural networks with data augmentation,解决浅层网络问题;

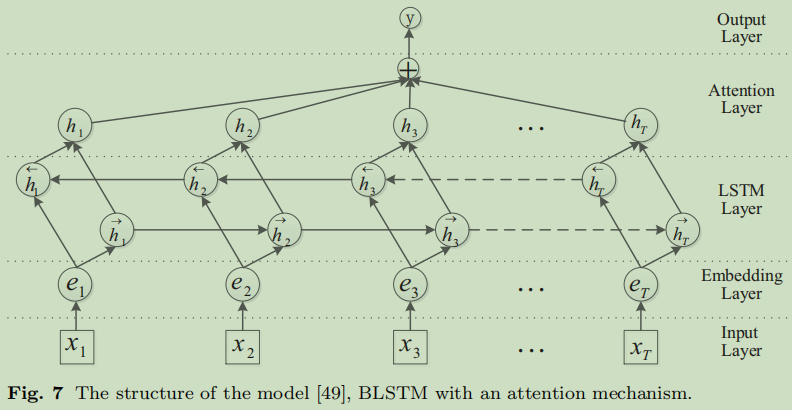

Zhou et al. [49], (2016) Attention-based bidirectional long short-term memory networks for relation classifification,因为SDP只是过滤输入的文本,但不能过滤提取的特性,这里使用了关注力层来解决这个问题。

Xiao et al. [51] , (2016) Semantic relation classifification via hierarchical recurrent neural network with attention,提出两层带有关注力的BLSTM结构

Qin et al.[23], (2017) Designing an adaptive attention mechanism for relation classifification ,

Zhang et al. [24] , (2019)Multi-gram cnn-based self-attention model for relation classifification

Lee et al. [52] , (2019) Semantic relation classifification via bidirectional lstm networks with entity-aware attention using latent entity typing

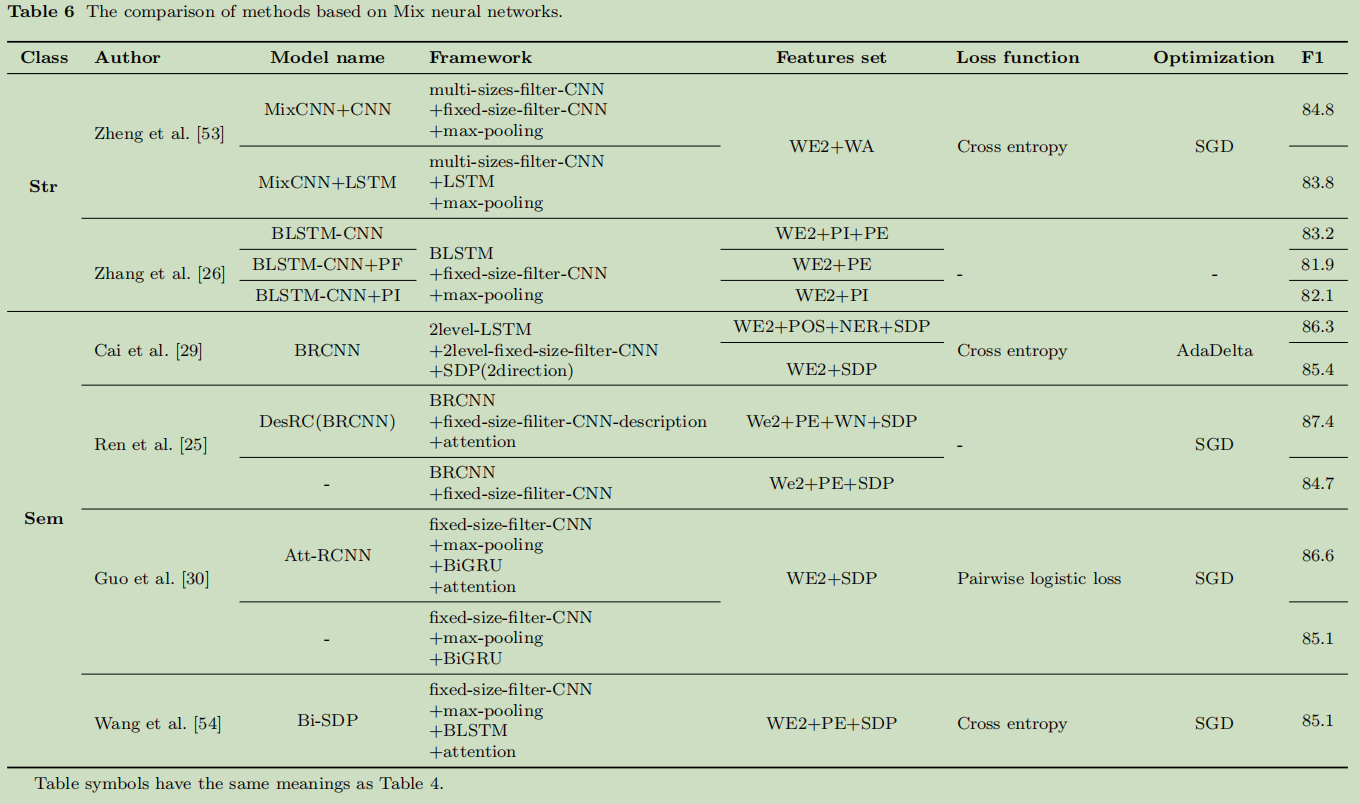

4.3 基于混合结构的方法

Zheng et al. [53],(2016) A neural network framework for relation extraction: Learning entity semantic and relation pattern

Zhang et al. [26], (2018) Relation classifification via bilstm-cnn.

Cai et al. [29], (2016) Bidirectional recurrent convolutional neural network for relation classifification

Ren et al. [25], (2018) Neural relation classifification with text descriptions

Guo et al. [30], (2019) A single attention-based combination of cnn and rnn for relation classifification

Wang et al. [54] , (2020) Direction-sensitive relation extraction using bi-sdp attention model

小结:从表4、5和6中可以看出,面向语义的模型比面向结构的模型更有效。认为围绕SDP的方法,提供了外部的语义信息的输入,提供了人类层面思维和认知。

5. 基于DNN的远程监督RE

它的提出主要是为了解决语料问题的。2009

不过远程监督天生就有一个致命的弱点,就是会带有噪音数据,然后降噪就成为了这个研究方向考虑的一个点。

三个假设:

Assumption 1: If two entities participate in a relation, all sentences that mention these two entities express that relation. – [43]

Assumption 2: If two entities participate in a relation, at least one sentence that mentions these two entities might express that relation. – [6] ”one sentence from one bag”.“at-least-once assumption假设”

Assumption 3: A relation holding between two entities can be either expressed explicitly or inferred implicitly from all sentences that mention these

two entities. – [58]

假设1:如果两个实体中存在一种关系,那么所有包含这两个实体的句子都表达了这种关系。–基础,原始

假设2:如果两个实体中存在一种关系,那么包含这两个实体的句子中至少有一个句子可能表达这种关系。

即是把所有句子打包,每次选择一个正确的句子出来训练,这里涉及到是否选择出正确句子问题,也是一个研究点。论文也写了一个方法。

图片参考自:https://blog.csdn.net/qq_27590277/article/details/109302630

假设3:两个实体之间的关系既可以显式地表达出来,也可以从所有提到这两个实体的句子中隐式地推断出来。—[58]

[58]解决的问题

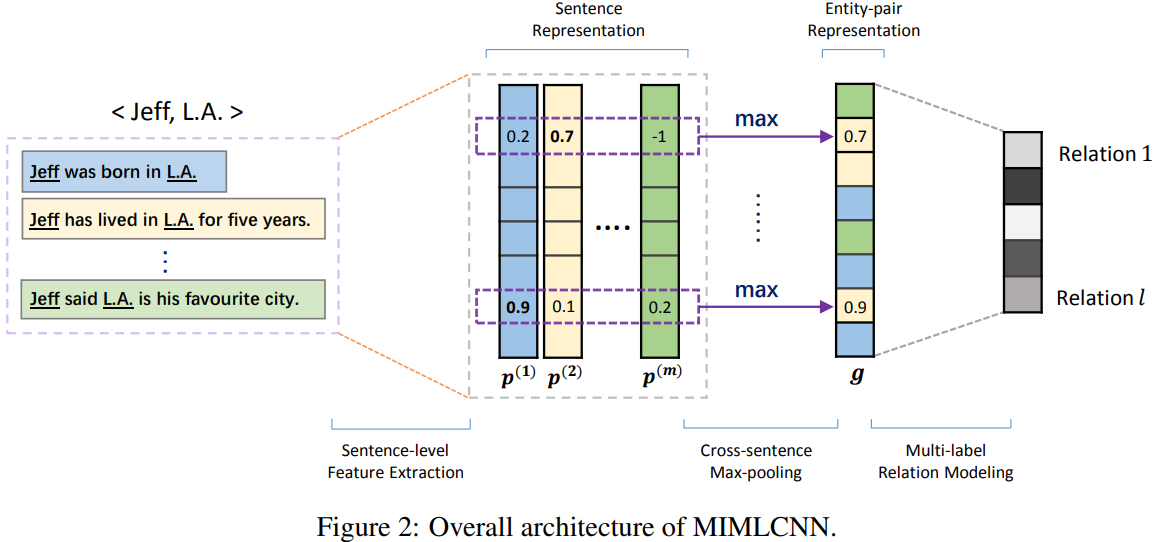

认为at-least-once assumption假设太强;仅仅选取每个bag中的一个句子会丢失很多信息;解决方案是对bag内所有的sentence之间做max-pooling操作,可以提取出instance之间的隐藏关联;认为single-label learning problem:在数据集中有大约18.3%的样本包含多种relation信息,设计了一种多标签损失函数,即使用sigmoid计算每一个类别的概率,然后判断该bag是否可能包含该类别。

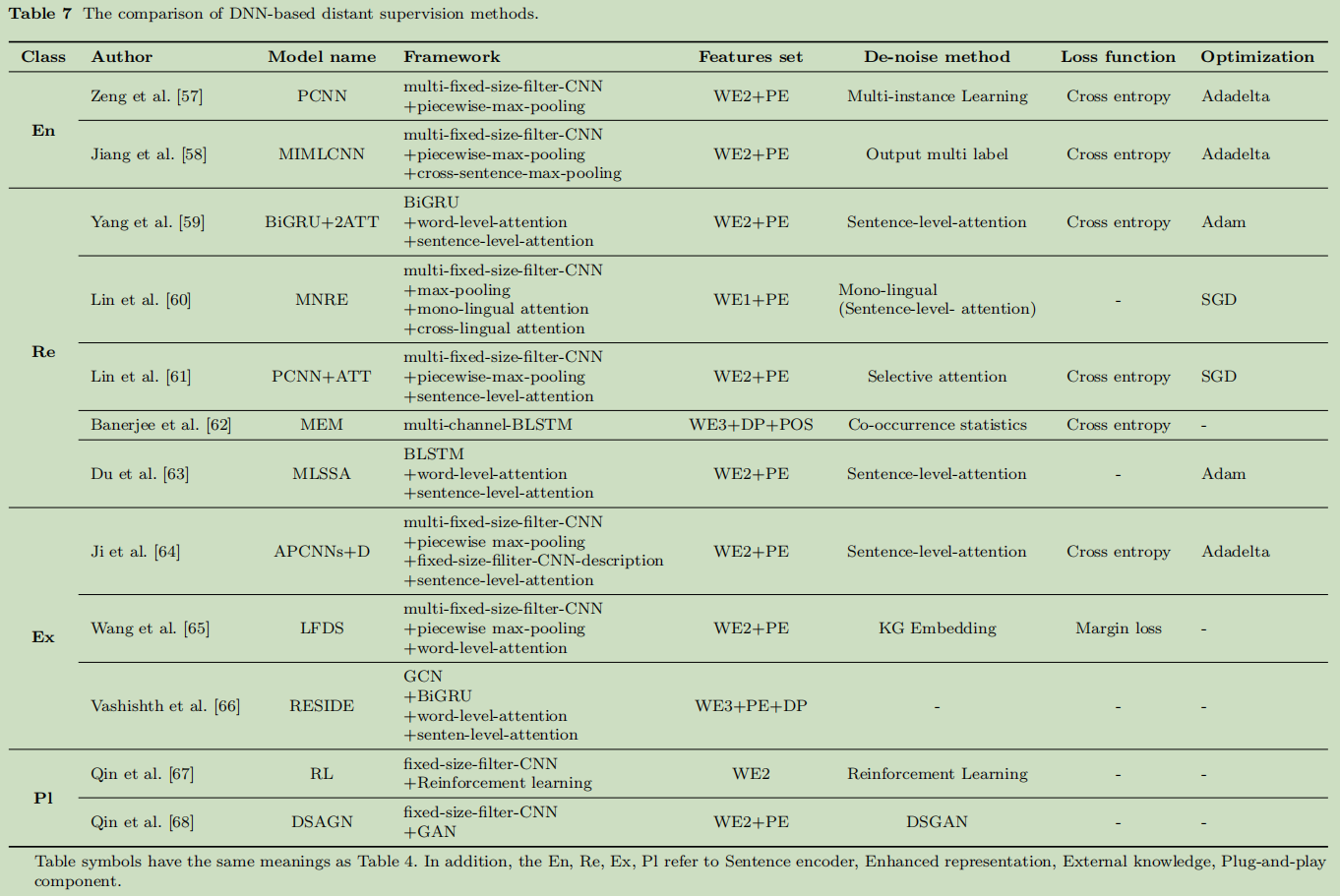

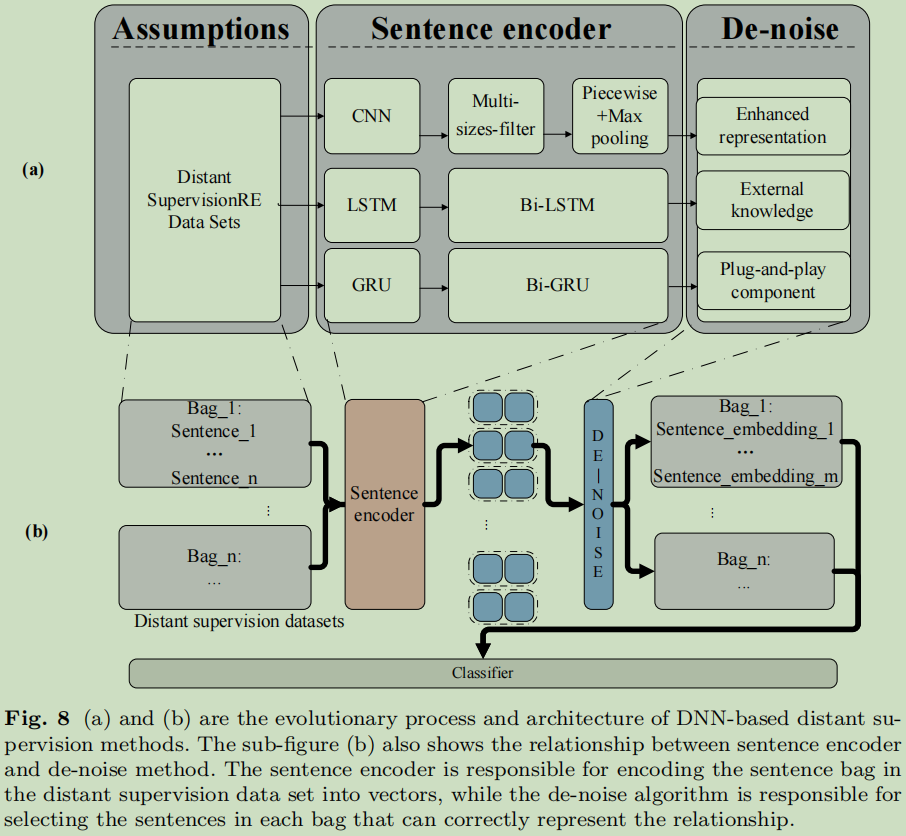

基于这三个假设,监督学习分为两个方向:Sentence Encoder,De-noise Algorithm;

句子编码器优化了模型和RE的性能;

==去噪算法提高了数据集的质量;==分为三个主要方法:enhancing representation,external knowledge,plug-and-play component

各种方法的对比:

发展过程与DNN框架

5.1 基于编码器的方法

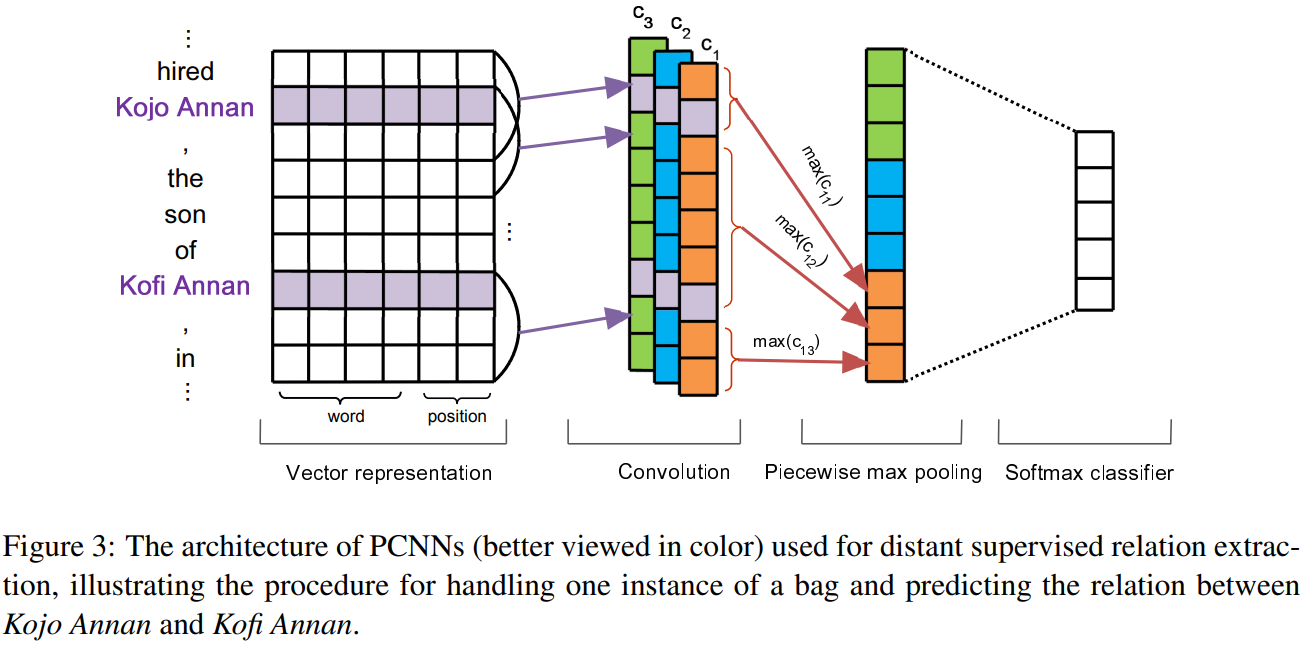

PCNN (Piecewise CNN)–,max-pooling–最大池化,multi-instance learning (MIL)–多实例学习

PCNN+MIL: 由两个实体分成三段来处理。

Zeng et al. [18]. (2014) Relation classifification via convolutional deep neural network:

Zeng et al. [57], (2015) Distant supervision for relation extraction via piecewise convolutional neural networks:

[57]解决的问题:

远程监督的方法由于约束较低,所以导致会产生大量的噪声数据;解决方案为采用多示例学习缓解噪声;

特征抽取方法没有充分考虑两个实体间的位置信息;解决方法为提出PCNNs网络;

MIMLCNN: Jiang et al. [58]

5.2 基于表示的方法

加入关注力机制,加强表达。

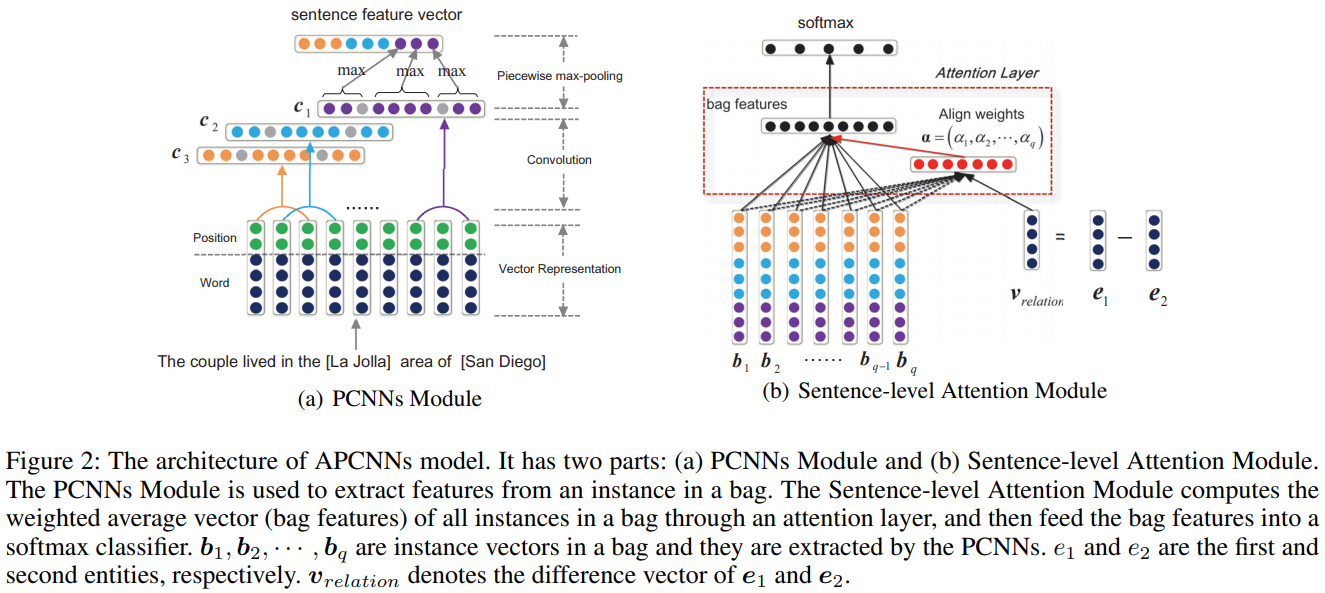

Lin et al. [60, 61], (2016) Neural relation extraction with selective attention over instances;

(2017) Neural relation extraction with multi-lingual attention,介绍了两个关注力模型。首先使用注意机制的权重来标记一个袋子中的所有实例,然后应用所有句子的向量加权和来表示一个袋子。

Yang et al. [59] and Du et al.’s [63],(2017) Multi-level attention-based neural networks for distant supervised relation extraction; (2018) Multi-level structured self attentions for distantly supervised relation extraction,都使用两种不同的注意机制(两级)来提取特征。

5.3 基于知识的方法

加入外部知识来进行关系抽取。

Ji et al.’s [64] (2017) Distant supervision for relation extraction with sentence-level attention and entity descriptions, 选择用PCNN模型去获取句子特征向量,可是在数据处理那一步上加入了知识的关系数据(r=e1-e2);利用新的向量进行权重相加;

(1)提出了一种句子级注意力模型APCNNs来选取有效实例,充分利用知识库中的监督信息。

(2)从Freebase和Wikipedia抽取实体描述来增补背景知识,这些背景知识可以为关系预测提供更多信息,还可以在注意力模型中帮助进行更好的实体表征。经过实验验证,本文提出的方法的关系抽取效果相对baseline有明显提升。

Wang et al. [65],(2018) Label-free distant supervision for relation extraction via knowledge graph embedding. 也引入了外部关系向量(r=e1-e2)

Vashishth et al.’s [66] ,(2018)Reside: Improving distantly-supervised neural relation extraction using side information,用GCN去编码。

5.4 基于Plug-and-play方法

关于Plug-and-play的理解,这种技术是独立于关系抽取模型的,可应用于任何一个现有的远程监督关系抽取模型,它不隶属于某远程监督关系抽取模型,它是独立的个体模块;

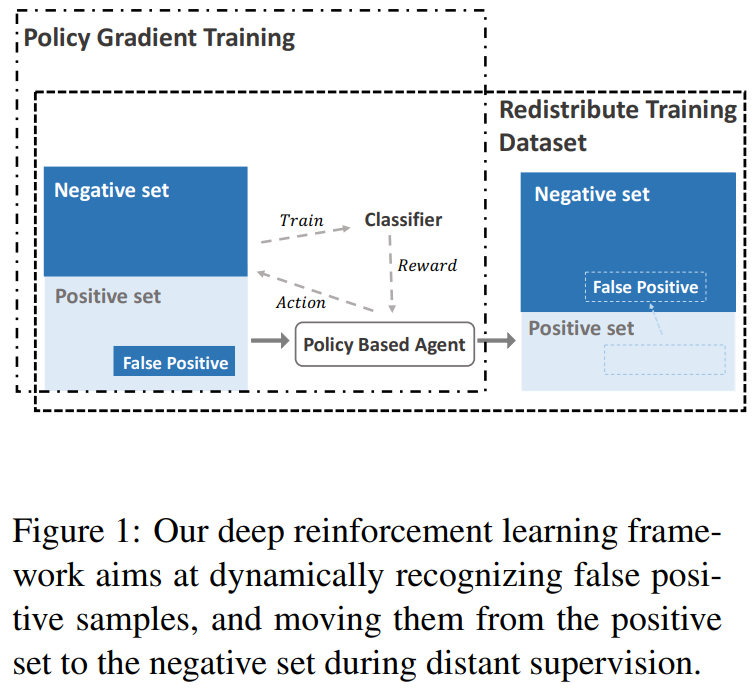

Qin et al. [67],(2018) Robust distant supervision relation extraction via deep reinforcement learning,针对远程监督的强化学习框架来解决假阳性案例问题

[67]针对的主要问题:假阳性问题仍然是性能的关键瓶颈; 认为那些错误标记的候选句子必须用一个确定性的决策来对待,而不是使用注意力权重去处理.

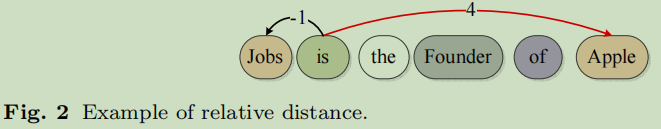

Qin et al. [68], (2018) Dsgan: Generative adversarial training for distant supervision relation extraction. 利用GAN的想法获得一个生成器,从远程监督中对袋子中的阳性和阴性样本进行分类, 这是一种对抗学习策略;

因此,”reinforcement learning framework”和DSGAN都可以被视为远程监督中的一个即插即用组件。

6. 其它方法

Zhang et al. [71] (2018) Attention based capsule networks with dynamic routing for relation extraction,解决一对实体的多关系问题;

joint extraction methods [72–76],实体与关系联合抽取;

7. 数据集

SemEval 2010-task8

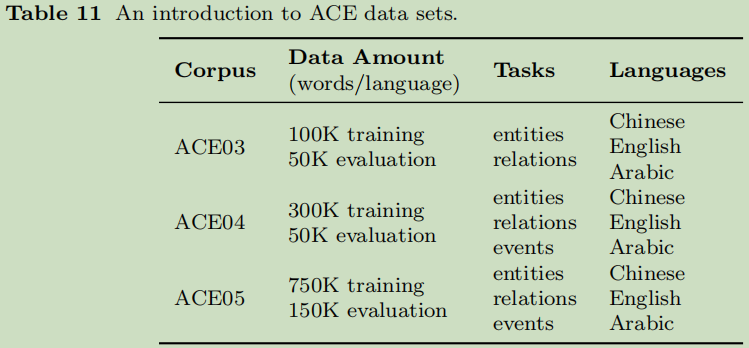

ACE2003-2005 Series

NYT+Freebase : New York times + Freebase

Other Data sets include SemEval2017-task10 [77], SemEval2018-task7[78], TACRED [79], KBP37 [22], DDIExtraction2011 [80], DDIExtraction2013

[81], FewRel [4], FewRel2 [5].

8. 总结

存在问题:Transfer learning,Relationship Reasoning,Relationship Framework,Cross-sentence RE

主要总结了监督与远程监督的方法,提了一下联合训练。