Pytorch 基础

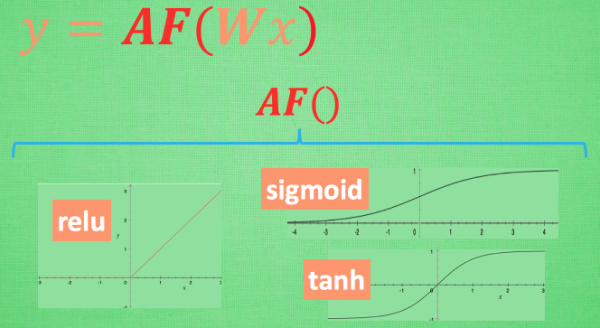

Activation Function (激励函数)

假设神经网络为一个式子:y=Wx,其中y为神经网络输出值,W为神经网络参数,x为神经网络输入值;可知y为线性方程

设激励函数为AF,AF可以将y激励成为一个非线性方程,且AF必须要满足可微分才能进行反向传递。则神经网络的输出可以表示为 y=(AF)Wx。比如使用了 relu 激励函数, 如果此时 Wx 的结果是1, y 还将是1, 不过 Wx 为-1的时候, y 不再是-1, 而会是0.

常用的激励函数有:relu(),sigmoid(),tanh等

'''

torch中的激励函数:relu、sigmoid、tanh、softplus

'''

import torch

import torch.nn.functional as F #激励函数包 nn神经网络模块

from torch.autograd import Variable

import matplotlib.pyplot as plt

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

#fake data

x = torch.linspace(-5, 5, 200) # x data (tensor), shape=(100, 1)

x = Variable(x)

x_np = x.data.numpy()# 换成 numpy array, 出图时用

#激励函数的激活值

y_relu = F.relu(x).data.numpy()

y_sigmoid = F.sigmoid(x).data.numpy()

y_tanh = F.tanh(x).data.numpy()

y_softplus = F.softplus(x).data.numpy() #softmax 比较特殊, 不能直接显示, 不过他是关于概率的, 用于分类

#画图

plt.figure(1, figsize=(8,8))

plt.subplot(221)

plt.plot(x_np,y_relu,c='red',label='relu')

plt.ylim((-1, 5))

plt.legend(loc='best')

plt.subplot(222)

plt.plot(x_np,y_sigmoid,c='black',label='sigmoid')

plt.ylim((-0.2, 1.2))

plt.legend(loc='best')

plt.subplot(223)

plt.plot(x_np,y_tanh,c='yellow',label='tanh')

plt.ylim((-1.2, 1.2))

plt.legend(loc='best')

plt.subplot(224)

plt.plot(x_np,y_softplus,c='blue',label='softmax')

plt.ylim((-0.2, 6))

plt.legend(loc='best')

plt.show()

Pytorc 快速搭建神经网络

class Net(torch.nn.Module):

def __init__(self, n_feature, n_hidden, n_output):

super(Net, self).__init__()

self.hidden = torch.nn.Linear(n_feature, n_hidden)

self.predict = torch.nn.Linear(n_hidden, n_output)

def forward(self, x):

x = F.relu(self.hidden(x))

x = self.predict(x)

return x

net1 = Net(1, 10, 1) # 这是我们用这种方式搭建的 net1

net2 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1)

)

print(net1)

"""

Net (

(hidden): Linear (1 -> 10)

(predict): Linear (10 -> 1)

)

"""

print(net2)

"""

Sequential (

(0): Linear (1 -> 10)

(1): ReLU ()

(2): Linear (10 -> 1)

)

"""

Pytorch模型的保存和提取

#用回归的神经网络举例实现保存提取

import torch

from torch.autograd import Variable

import matplotlib.pyplot as plt

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

#data

x = torch.unsqueeze(torch.linspace(-1, 1, 100), dim=1) # x data (tensor), shape=(100, 1)

y = x.pow(2) + 0.2*torch.rand(x.size()) # noisy y data (tensor), shape=(100, 1)

x,y = Variable(x, requires_grad=False), Variable(y, requires_grad=False)

def save():

# save net1

net1 = torch.nn.Sequential(

torch.nn.Linear(1,10),

torch.nn.ReLU(),

torch.nn.Linear(10,1)

)

optimizer = torch.optim.SGD(net1.parameters(), lr=0.5)

loss_func = torch.nn.MSELoss()

#train net1

for t in range(100):

prediction = net1(x)

loss = loss_func(prediction, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

torch.save(net1, 'net1.pkl') # 保存整个神经网络

torch.save(net1.state_dict(),'net1_params.pkl') # 保存神经网络的所有参数 占内存小、速度快

#可视化

plt.figure(1, figsize=(10,3))

plt.subplot(131)

plt.title('Net1')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(),'r-', lw=5)

#提取net

def restore_net():

net2 = torch.load('net1.pkl')

prediction = net2(x)

#可视化

plt.figure(1, figsize=(10,3))

plt.subplot(132)

plt.title('Net2')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(),'r-', lw=5)

#提取net的参数,首先要建立一个和net1相同的神经网络

def restore_params():

net3 = torch.nn.Sequential(

torch.nn.Linear(1,10),

torch.nn.ReLU(),

torch.nn.Linear(10,1)

)

#net1_params to net3

net3.load_state_dict(torch.load('net1_params.pkl'))

prediction = net3(x)

#可视化

plt.figure(1, figsize=(10,3))

plt.subplot(133)

plt.title('Net3')

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(),'r-', lw=5)

save() #保存net1

restore_net() #提取网络

restore_params() #create net3 and copy net1_params to net3

plt.show()

Pytorch 批训练

Torch 中提供了一种帮你整理你的数据结构的好东西, 叫做 DataLoader, 我们能用它来包装自己的数据, 进行批训练

####批量数据训练

import torch

import torch.utils.data as Data

import os

from torch.utils.data import dataset

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

BATCH_SIZE = 5 #批训练的数据个数

x = torch.linspace(1, 10, 10) # x data (torch tensor)

y = torch.linspace(10, 1, 10) # y data (torch tensor)

#create a torch_dataset 定义torch 可以识别的 数据库

torch_dataset = Data.TensorDataset(x, y) #data_tensor :训练数据 target_tensor:训练目标值

#loader 将数据分为多批 loader 可以定义其数据的属性

loader = Data.DataLoader(

dataset=torch_dataset, #数据库

batch_size=BATCH_SIZE, # 最小批训练数据个数

shuffle=False, #是否打乱数据

num_workers=2, ## 多线程来读数据

)

def show_batch():

for epoch in range(3): # 训练所有!整套!数据 3 次

for step, (bacth_x, bacth_y) in enumerate(loader): #每一步 loader释放一小批数据,每批有BATCH_SIZE个数据 进行学习

print('Epoch: ', epoch, '| Step: ', step, '| batch x: ',

bacth_x.numpy(), '| batch y: ', bacth_y.numpy())

if __name__ == '__main__':

show_batch()

Optimizer优化器

import torch

import torch.utils.data as Data

import torch.nn.functional as F

import matplotlib.pyplot as plt

from torch.autograd import Variable

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

# 超参数

LR = 0.01

BATCH_SIZE = 32

EPOCH = 12

#数据

x = torch.unsqueeze(torch.linspace(-1, 1, 1000), dim=1)

y = x.pow(2) + 0.1*torch.normal(torch.zeros(*x.size()))

# plt.scatter(x.numpy(), y.numpy())

# plt.show()

torch_dataset = Data.TensorDataset(x,y)

loader = Data.DataLoader(dataset=torch_dataset, batch_size=BATCH_SIZE,shuffle=True,num_workers=2,)

#构建神经网络

class Net(torch.nn.Module):

def __init__(self):

super(Net,self).__init__()

self.hidden = torch.nn.Linear(1,20)

self.predict = torch.nn.Linear(20,1)

def forward(self,x):

x = F.relu(self.hidden(x))

x = self.predict(x)

return x

if __name__=='__main__':

#为每一个优化器创建一个网络

net_SGD = Net()

net_Momentum = Net()

net_RMSprop = Net()

net_Adam = Net()

nets = [net_SGD,net_Momentum, net_RMSprop, net_Adam]

#创建优化器

opt_SGD = torch.optim.SGD(net_SGD.parameters(), lr=LR)

opt_Momentum = torch.optim.SGD(net_Momentum.parameters(), lr=LR, momentum=0.8)

opt_RMSprop = torch.optim.RMSprop(net_RMSprop.parameters(), lr=LR, alpha=0.9)

opt_Adam = torch.optim.Adam(net_Adam.parameters(), lr=LR, betas=(0.9,0.99))

optimizers = [opt_SGD, opt_Momentum, opt_RMSprop, opt_Adam]

loss_func = torch.nn.MSELoss()

losses_his = [[], [], [], []] #记录不同神经网络的误差

for epoch in range(EPOCH):

print('Epoch: ', epoch)

for step,(batch_x, batch_y) in enumerate(loader):

b_x = Variable(batch_x)

b_y = Variable(batch_y)

# 对每个优化器, 优化(训练)属于他的神经网络

for net, opt, l_his in zip(nets, optimizers, losses_his):

output = net(b_x)

loss = loss_func(output, b_y)

opt.zero_grad()

loss.backward()

opt.step()

l_his.append(loss.data.numpy())

labels = ['SGD', 'Momentum', 'RMSprop', 'Adam']

for i, l_his in enumerate(losses_his):

plt.plot(l_his, label=labels[i])

plt.legend(loc='best')

plt.xlabel('Steps')

plt.ylabel('Loss')

plt.ylim((0, 0.2))

plt.show()

CNN 手写数字识别

import torch

import torch.nn as nn

from torch.autograd import Variable

import torch.utils.data as Data

import torchvision # 有一些数据库

import matplotlib.pyplot as plt

#Hyper Parameters

EPOCH = 1

BATCH_SIZE = 50

LR = 0.001

DOWLOAD_MINST = False

#数据下载

train_data = torchvision.datasets.MNIST(

root = '/mnist/',

train = True,

transform = torchvision.transforms.ToTensor(), #将原始数据转为 tensor形式 (0,1)

download = DOWLOAD_MINST,

)

# plot one example

# print(train_data.train_data.size()) # (60000, 28, 28)

# print(train_data.train_labels.size())

# plt.imshow(train_data.train_data[0].numpy(), cmap='gray')

# plt.title('%i' % train_data.train_labels[0])

# plt.show() # (60000)

# 批训练 50samples, 1 channel, 28x28 (50, 1, 28, 28)

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE, shuffle=True)

test_data = torchvision.datasets.MNIST(root='/mnist/', train=False)

# 为了节约时间, 我们测试时只测试前2000个

test_x = Variable(torch.unsqueeze(test_data.test_data, dim=1).type(torch.FloatTensor)[:2000]/255.) # shape from (2000, 28, 28) to (2000, 1, 28, 28), value in range(0,1)

test_y = test_data.test_labels[:2000]

# Create CNN net 模型

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

#卷积层 压缩

self.conv1 = nn.Sequential( # input shape (维度:1, 宽:28, 高:28)

nn.Conv2d(

in_channels=1, #input height

out_channels=16, #count of filter

kernel_size=5, #filter size 长宽高为5个像素点

stride=1, #filter movement/step 每隔多少步跳一步

padding=2, #如果想要 con2d 出来的图片长宽没有变化, padding=(kernel_size-1)/2 当 stride=1

), #卷积层函数 相当于过滤器 output shape:(维度:16, 宽:28, 高:28)

nn.ReLU(), #激活函数 input shape and output shape :(维度:16, 宽:28, 高:28)

nn.MaxPool2d(kernel_size=2), #实话层 筛选 ;kernel_size=2:在 2x2 空间里向下采样

# input shape :(维度:16, 宽:28, 高:28) output shape:(维度:16, 宽:14, 高:14)

)

self.conv2 = nn.Sequential(

nn.Conv2d(16, 32, 5, 1, 2), #input shape:(维度:16, 宽:14, 高:14) output shape:(维度:32, 宽:14, 高:14)

nn.ReLU(), # intput shape and out put :(维度:32, 宽:14, 高:14)

nn.MaxPool2d(2), # intput shape:(维度:32, 宽:14, 高:14) output shape:(维度:32 , 宽:7, 高:7)

)

self.out = nn.Linear(32 * 7 * 7, 10) # input shape:(维度:16, 宽:28, 高:28)

#展开

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x) #(batch_size, 32 * 7 * 7)

x = x.view(x.size(0), -1) # 展平多维的卷积图成 (batch_size, 32 * 7 * 7)

output = self.out(x)

return output

cnn = CNN()

# print(cnn)

'''

CNN(

(conv1): Sequential(

(0): Conv2d(1, 16, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(1): ReLU()

(2): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(conv2): Sequential(

(0): Conv2d(16, 32, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(1): ReLU()

(2): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(out): Linear(in_features=1568, out_features=10, bias=True)

)

'''

###train

optimizer = torch.optim.Adam(cnn.parameters(), lr=LR)

loss_func = nn.CrossEntropyLoss()

for epoch in range(EPOCH):

for step, (b_x, b_y) in enumerate(train_loader):

output = cnn(b_x)

loss = loss_func(output, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

if step % 50 == 0:

test_output = cnn(test_x)

pred_y = torch.max(test_output, 1)[1].data.squeeze()

accuracy = sum(pred_y == test_y) / test_y.size(0)

print('Epoch:', epoch, '|| train loss: %.4f' % loss.data.numpy(), '|| test accuracy: %.2f' % accuracy)

#print 10 predictions from test data

test_output = cnn(test_x[:10])

pred_y = torch.max(test_output, 1)[1].data.numpy().squeeze()

print(pred_y, 'prediction number')

print(test_y[:10].numpy(), 'real number')

RNN和LSTM

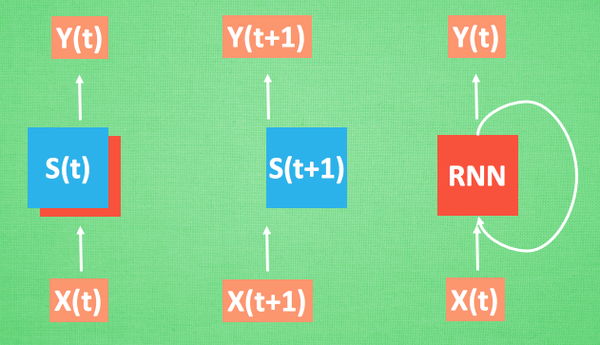

我们想象现在有一组序列数据 data 0,1,2,3. 在当预测 result0 的时候,我们基于的是 data0, 同样在预测其他数据的时候, 我们也都只单单基于单个的数据. 每次使用的神经网络都是同一个 NN. 不过这些数据是有关联 顺序的 , 就像在厨房做菜, 酱料 A要比酱料 B 早放, 不然就串味了. 所以普通的神经网络结构并不能让 NN 了解这些数据之间的关联。

RNN用于处理序列数据直接有关系的数据,每分析一个数据RNN会存储其记忆,用于下一个数据预测,如果继续分析更多的有序数据 , RNN就会把之前的记忆都累积起来, 一起分析。如下图:每次 RNN 运算完之后都会产生一个对于当前状态的描述 , state. 我们用简写 S( t) 代替, 然后这个 RNN开始分析 x(t+1) , 他会根据 x(t+1)产生s(t+1), 不过此时 y(t+1) 是由 s(t) 和 s(t+1) 共同创造的. 所以我们通常看到的 RNN 也可以表达成这种样子

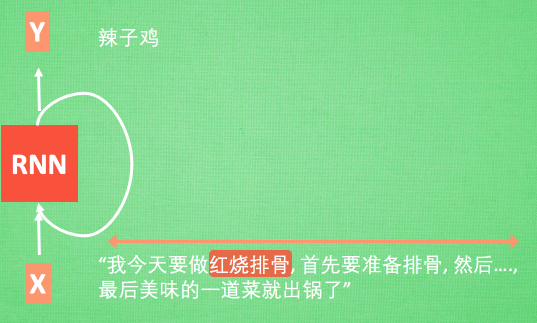

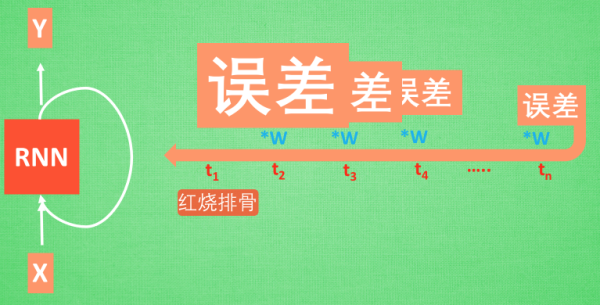

由于RNN“记忆力”较差,会出现判断失误。如下图,输入值是一句话: ‘我今天要做红烧排骨, 首先要准备排骨, 然后…., 最后美味的一道菜就出锅了’, shua ~ 说着说着就流口水了. 现在请 RNN 来分析, 我今天做的到底是什么菜呢. RNN可能会给出“辣子鸡”这个答案. 由于判断失误, RNN就要开始学习 这个长序列 X 和 ‘红烧排骨’ 的关系 , 而RNN需要的关键信息 ”红烧排骨”却出现在句子开头,

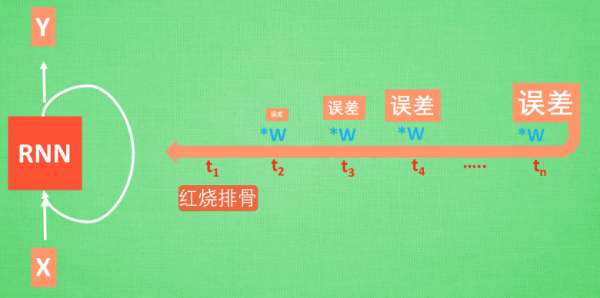

RNN学习过程: 红烧排骨这个信息原的记忆要进过长途跋涉才能抵达最后一个时间点. 然后我们得到误差, 而且在 反向传递 得到的误差的时候, 他在每一步都会 乘以一个自己的参数 W. 如果这个 W 是一个小于1 的数, 比如0.9. 这个0.9 不断乘以误差, 误差传到初始时间点也会是一个接近于零的数, 所以对于初始时刻, 误差相当于就消失了. 我们把这个问题叫做梯度消失或者梯度弥散 Gradient vanishing. 反之如果 W 是一个大于1 的数, 比如1.1 不断累乘, 则到最后变成了无穷大的数, RNN被这无穷大的数撑死了, 这种情况我们叫做剃度爆炸, Gradient exploding. 这就是普通 RNN 没有办法回忆起久远记忆的原因。

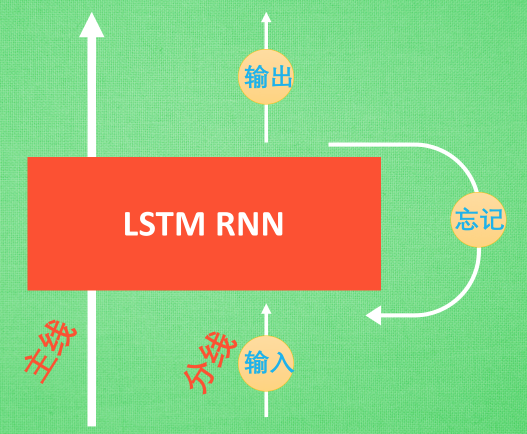

因此引入LSTM,LSTM 和普通 RNN 相比, 多出了三个控制器. (输入控制, 输出控制, 忘记控制).

主线剧情. 而原本的 RNN 体系就是 分线剧情. 三个控制器都是在原始的 RNN 体系上, 我们先看 输入方面 , 如果此时的分线剧情对于剧终结果十分重要, 输入控制就会将这个分线剧情按重要程度 写入主线剧情 进行分析. 再看 忘记方面, 如果此时的分线剧情更改了我们对之前剧情的想法, 那么忘记控制就会将之前的某些主线剧情忘记, 按比例替换成现在的新剧情. 所以 主线剧情的更新就取决于输入 和忘记 控制. 最后的输出方面, 输出控制会基于目前的主线剧情和分线剧情判断要输出的到底是什么.基于这些控制机制, LSTM 就像延缓记忆衰退的良药, 可以带来更好的结果.

RNN识别手写数字代码:

from HigherNet.RNN_Regressor import HIDDEN_SIZE

import torch

from torch.autograd import Variable

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

import matplotlib.pyplot as plt

import torch.utils.data as Data

### Hyper Parameters

EPOCH = 1 # 训练整批数据多少次, 为了节约时间, 我们只训练一次

BATCH_SIZE = 64

TIME_STEP = 28 # rnn 时间步数 / 图片高度

INPUT_SIZE = 28 # rnn 每步输入值 / 图片每行像素

LR = 0.01 # learning rate

DOWNLOAD_MNIST = True # 如果你已经下载好了mnist数据就写上 Fasle

HIDDEN_SIZE = 64

# 倒入手写数字数据

train_data = torchvision.datasets.MNIST(

root = '/mnist/',

train = True,

transform = transforms.ToTensor(),

download = DOWNLOAD_MNIST,

)

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE, shuffle=True)

test_data = torchvision.datasets.MNIST(root='/mnist/', train=False, transform=transforms.ToTensor())

# 为了节约时间, 我们测试时只测试前2000个

test_x = test_data.test_data.type(torch.FloatTensor)[:2000]/255. # shape (2000, 28, 28) value in range(0,1)

test_y = test_data.test_labels.numpy()[:2000] # covert to numpy array

### Create RNN Module

class RNN(nn.Module):

def __init__(self):

super(RNN, self).__init__()

self.rnn = nn.LSTM(

input_size = INPUT_SIZE, #每行的像素点

hidden_size = HIDDEN_SIZE, # rnn hidden unit

num_layers = 1, # 有几层 RNN layers

batch_first = True, # input & output 会是以 batch size 为第一维度的特征集 e.g. (batch, time_step, input_size)

)

self.out = nn.Linear(HIDDEN_SIZE, 10)

def forward(self, x):

# x shape (batch, time_step, input_size)

# r_out shape (batch, time_step, output_size) r_out 每个时间段的结果存入r_out

# h_n shape (n_layers, batch, hidden_size) LSTM 有两个 hidden states, h_n 是分线, h_c 是主线

# h_c shape (n_layers, batch, hidden_size)

r_out, (h_n, h_c) = self.rnn(x, None) # None 表示 hidden state 会用全0的 state

#选取最后一个time 的 r_out 输出

#r_out[:, -1, :]的value 与 h_n的value 相同

out = self.out(r_out[:, -1, :])

return out

rnn = RNN()

# print(rnn)

'''

RNN(

(rnn): LSTM(28, 64, batch_first=True)

(out): Linear(in_features=64, out_features=10, bias=True)

)

'''

#### Train RNN

## 优化器

optimizer = torch.optim.Adam(rnn.parameters(), lr=LR) # optimize all parameters

loss_func = nn.CrossEntropyLoss() # the target label is not one-hotted

## Train and Testing

for epoch in range(EPOCH):

for step, (x,y) in enumerate(train_loader):

b_x = Variable(x.view(-1, 28, 28) ) # reshape x to (batch, time_step, input_size)

b_y = Variable(y)

output = rnn(b_x)

loss = loss_func(output, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

if step % 50 == 0:

test_output = rnn(test_x) # (samples, time_step, input_size)

pred_y = torch.max(test_output, 1)[1].data.numpy()

accuracy = float((pred_y == test_y).astype(int).sum()) / float(test_y.size)

print('Epoch: ', epoch, '| train loss: %.4f' % loss.data.numpy(), '| test accuracy: %.2f' % accuracy)

# print 10 predictions from test data

test_output = rnn(test_x[:10].view(-1, 28, 28))

pred_y = torch.max(test_output, 1)[1].data.numpy()

print(pred_y, 'prediction number')

print(test_y[:10], 'real number')

RNN对函数进行回归代码:

import torch

from torch import nn

import numpy as np

import matplotlib.pyplot as plt

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

# torch.manual_seed(1) # reproducible

'''

用 sin 的曲线预测出 cos 的曲线

'''

### Hyper Parameters

TIME_STEP = 10 # rnn time step / image height

INPUT_SIZE = 1 # rnn input size / image width

LR = 0.02 # learning rate

HIDDEN_SIZE = 32

STEP = 100

### Show data

steps = np.linspace(0, np.pi*2, 100, dtype=np.float32)

x_np = np.sin(steps)

y_np = np.cos(steps)

# plt.plot(steps, y_np, 'r-', label='target(cos)')

# plt.plot(steps, x_np, 'b-', label='input(sin)')

# plt.legend(loc='best')

# plt.show()

'''

对每一个 r_out 都得放到 Linear 中去计算出预测的 output, 所以我们能用一个 for loop 来循环计算.

这点是 Tensorflow 望尘莫及的!

除了这点, 还有一些动态的过程都可以在这个教程中查看, 看看我们的 PyTorch 和 Tensorflow 到底哪家强.

'''

### Crate RNN Module

class RNN(nn.Module):

def __init__(self):

super(RNN, self).__init__()

self.rnn = nn.RNN(

input_size=INPUT_SIZE,

hidden_size=HIDDEN_SIZE,

num_layers=1,

batch_first=True,

)

self.out = nn.Linear(HIDDEN_SIZE, 1)

def forward(self,x,h_state):

# x (batch, time_step, input_size)

# h_state (n_layers, batch, hidden_size)

# r_out (batch, time_step, hidden_size) time_step:纬度

r_out, h_state = self.rnn(x, h_state)

outs = [] #将 r_out中每时刻的结果 转为 一维 放入 outs中

for time_step in range(r_out.size(1)):

outs.append(self.out(r_out[:, time_step, :]))

return torch.stack(outs, dim=1), h_state #torch.stack???

rnn = RNN()

# print(rnn)

'''

RNN(

(rnn): RNN(1, 32, batch_first=True)

(out): Linear(in_features=32, out_features=1, bias=True)

)

'''

#### Train RNN

### 优化器

optimizer = torch.optim.Adam(rnn.parameters(), lr=LR)

loss_func = nn.MSELoss()

h_state = None

plt.figure(1, figsize=(12, 5))

plt.ion() # continuously plot

for step in range(STEP):

start, end = step * np.pi, (step + 1) * np.pi # time range

# use sin predicts cos

steps = np.linspace(start, end, TIME_STEP, dtype=np.float32, endpoint=False)

x_np = np.sin(steps)

y_np = np.cos(steps)

#将数据 增加一个纬度

x = torch.from_numpy(x_np[np.newaxis, :, np.newaxis]) # shape (batch, time_step, input_size)

y = torch.from_numpy(y_np[np.newaxis, :, np.newaxis])

prediction, h_state = rnn(x, h_state) # rnn output

# !! next step is important !!

h_state = h_state.data # repack the hidden state, break the connection from last iteration 将h_state 重新包解隐藏状态,打破上次迭代的连接

loss = loss_func(prediction, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# plotting

plt.plot(steps, y_np.flatten(), 'r-')

plt.plot(steps, prediction.data.numpy().flatten(), 'b-')

plt.draw(); plt.pause(0.05)

plt.ioff()

plt.show()

自编码:

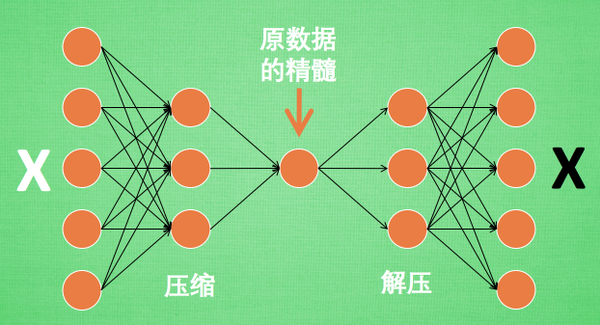

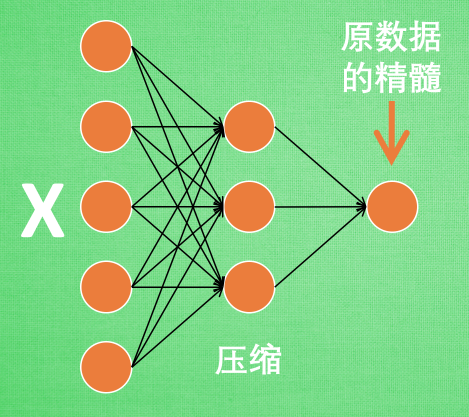

神经网络要接受大量的输入信息, 比如输入信息是高清图片时, 输入信息量可能达到上千万, 让神经网络直接从上千万个信息源中学习是一件很吃力的工作. 所以, 何不压缩一下, 提取出原图片中的最具代表性的信息, 缩减输入信息量, 再把缩减过后的信息放进神经网络学习. 这样学习起来就简单轻松了. 所以, 自编码就能在这时发挥作用. 通过将原数据白色的X 压缩, 解压 成黑色的X, 然后通过对比黑白 X ,求出预测误差, 进行反向传递, 逐步提升自编码的准确性. 训练好的自编码中间这一部分就是能总结原数据的精髓. 可以看出, 从头到尾, 我们只用到了输入数据 X, 并没有用到 X 对应的数据标签, 所以也可以说自编码是一种非监督学习. 到了真正使用自编码的时候. 通常只会用到自编码前半部分.

Encoder 编码器:

Decoder 解码器:

解码器在训练的时候是要将精髓信息解压成原始信息

自编码手写数字识别代码:

'''

自编码:手写数字识别

'''

import torch

import torch.nn as nn

import torch.utils.data as Data

import torchvision

import matplotlib.pyplot as plt

from torch.autograd import Variable

from mpl_toolkits.mplot3d import Axes3D

import numpy as np

from matplotlib import cm

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

#超参数

EPOCH = 10

BATCH_SIZE = 64

LR = 0.0005

DOWLOAD_MNIST = True # 下过数据的话, 就可以设置成 False

N_TEST_IMG = 5 # 到时候显示 5张图片看效果, 如上图一

#定义数据库

train_data = torchvision.datasets.MNIST(

root='/mnist/',

train=True,

transform=torchvision.transforms.ToTensor(),

download=DOWLOAD_MNIST,

)

print(train_data.train_data.size()) # (60000, 28, 28)

print(train_data.train_labels.size()) # (60000)

# plt.imshow(train_data.train_data[1].numpy(), cmap='gray')

# plt.title('%i' % train_data.train_labels[1])

# plt.show()

#定义自编码神经网络

class AutoEncoder(nn.Module):

def __init__(self):

super(AutoEncoder, self).__init__()

self.encoder = nn.Sequential(

nn.Linear(28*28, 128), #28*28像素点 128个隐藏层

nn.Tanh(), #激励函数 隐藏函数

nn.Linear(128, 64), # 将128压缩到 64

nn.Tanh(),

nn.Linear(64, 12),

nn.Tanh(),

nn.Linear(12, 3), # 压缩成3个特征, 进行 3D 图像可视化

)

self.decoder = nn.Sequential(

nn.Linear(3, 12),

nn.Tanh(),

nn.Linear(12, 64),

nn.Tanh(),

nn.Linear(64,128),

nn.Tanh(),

nn.Linear(128, 28*28),

nn.Sigmoid(), # 激励函数让输出值在 (0, 1)

)

def forward(self,x):

encoder = self.encoder(x)

decoder = self.decoder(encoder)

return encoder, decoder

autoencoder = AutoEncoder()

optimizer = torch.optim.Adam(autoencoder.parameters(), lr=LR)

loss_func = nn.MSELoss()

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE, shuffle=True)

# initialize figure

f, a = plt.subplots(2, N_TEST_IMG, figsize=(5, 2))

plt.ion() # continuously plot

# original data (first row) for viewing

view_data = train_data.train_data[:N_TEST_IMG].view(-1, 28*28).type(torch.FloatTensor)/255.

for i in range(N_TEST_IMG):

a[0][i].imshow(np.reshape(view_data.data.numpy()[i], (28, 28)), cmap='gray'); a[0][i].set_xticks(()); a[0][i].set_yticks(())

for epoch in range(EPOCH):

for step, (x, y) in enumerate(train_loader):

b_x = Variable(x.view(-1, 28*28)) #batch_x

b_y = Variable(x.view(-1, 28*28)) #batch_y

b_label = Variable(y) #batch_label

encoded, decoded = autoencoder(b_x)

loss = loss_func(decoded, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

if step % 100 == 0:

print('Epoch: ', epoch, '| train loss: %.4f' % loss.data.numpy())

# plotting decoded image (second row)

_, decoded_data = autoencoder(view_data)

for i in range(N_TEST_IMG):

a[1][i].clear()

a[1][i].imshow(np.reshape(decoded_data.data.numpy()[i], (28, 28)), cmap='gray')

a[1][i].set_xticks(()); a[1][i].set_yticks(())

plt.draw(); plt.pause(0.05)

plt.ioff()

plt.show()

# 要观看的数据

view_data = train_data.train_data[:200].view(-1, 28*28).type(torch.FloatTensor)/255.

encoded_data, _ = autoencoder(view_data) # 提取压缩的特征值

fig = plt.figure(2)

ax = Axes3D(fig) # 3D 图

# x, y, z 的数据值

X = encoded_data.data[:, 0].numpy()

Y = encoded_data.data[:, 1].numpy()

Z = encoded_data.data[:, 2].numpy()

values = train_data.train_labels[:200].numpy() # 标签值

for x, y, z, s in zip(X, Y, Z, values):

c = cm.rainbow(int(255*s/9)) # 上色

ax.text(x, y, z, s, backgroundcolor=c) # 标位子

ax.set_xlim(X.min(), X.max())

ax.set_ylim(Y.min(), Y.max())

ax.set_zlim(Z.min(), Z.max())

plt.show()

Pytorch 强化学习( 建立 DQN)

import torch

import torch.nn as nn

import torch.nn.functional as F

import numpy as np

import gym

from torch.autograd import Variable

#hyper params

BATCH_SIZE = 32

LR = 0.1

EPSILON = 0.9 #greedy policy

GAMMA = 0.9 #reward discount

TARGET_REPLACE_ITER = 100 #targe update frequency 更新频率

MEMORY_CAPACITY = 2000 # 记忆库大小

env = gym.make('CartPole-v0') # 立杆子游戏

env = env.unwrapped

N_ACTIONS = env.action_space.n # 杆子能做的动作

N_STATES = env.observation_space.shape[0] # 杆子能获取的环境信息数

ENV_A_SHAPE = 0 if isinstance(env.action_space.sample(), int) else env.action_space.sample().shape # to confirm the shape

#建立DQN神经网络 建立两个神经网络, 一个是现实网络 (Target Net), 一个是估计网络 (Eval Net) 两个网络除了参数值不同其他都相同

class Net(nn.Module):

def __init__(self):

super(Net,self).__init__()

self.fc1 = nn.Linear(N_STATES, 10)

self.fc1.weight.data.normal_(0, 0.1) # initialization 随机生成初始参数

self.out = nn.Linear(10, N_ACTIONS)

self.out.weight.data.normal_(0, 0.1) # initialization

def forward(self,x):

x = self.fc1(x)

x = F.relu(x)

actions_value = self.out(x)

return actions_value #返回每个动作的价值

#建立DQN体系

class DQN(object):

def __init__(self):

self.eval_net = Net()

self.target_net = Net()

self.learn_step_counter = 0 # 用于 target 更新计时

self.memory_counter = MEMORY_CAPACITY

self.memory = np.zeros((MEMORY_CAPACITY, N_STATES *2 + 2))

self.optimizer = torch.optim.Adam(self.eval_net.parameters(), lr=LR) # torch 的优化器

self.loss_func = nn.MSELoss()

def choose_action(self,x):

x = Variable(torch.unsqueeze(torch.FloatTensor(x), 0))

if np.random.uniform() < EPSILON: #greedy

actions_value = self.eval_net.forward(x)

action = torch.max(actions_value, 1)[1].data.numpy()

action = action[0] if ENV_A_SHAPE == 0 else action.reshape(ENV_A_SHAPE) # return the argmax index

else: # random

action = np.random.randint(0, N_ACTIONS)

action = action if ENV_A_SHAPE == 0 else action.reshape(ENV_A_SHAPE)

return action

def store_transition(self, s, a, r, s_):

transition = np.hstack((s, [a, r], s_))

#如果记忆库满了 覆盖老数据

index = self.memory_counter % MEMORY_CAPACITY

self.memory[index, :] = transition

self.memory_counter += 1

def learn(self):

#target 参数更新

if self.learn_step_counter % TARGET_REPLACE_ITER == 0:

self.target_net.load_state_dict(self.eval_net.state_dict())

self.learn_step_counter += 1

#eval 参数更新

#抽取记忆库中的数据进行批训练

sample_nidex = np.random.choice(MEMORY_CAPACITY, BATCH_SIZE) #随机选取记忆库的数据

b_memory = self.memory[sample_nidex, :] # 将其赋值到 b_memory

b_s = torch.FloatTensor(b_memory[:, :N_STATES])

b_a = torch.LongTensor(b_memory[:, N_STATES:N_STATES+1].astype(int))

b_r = torch.FloatTensor(b_memory[:, N_STATES+1:N_STATES+2])

b_s_ = torch.FloatTensor(b_memory[:, -N_STATES:])

#将抽取到的数据 对做过的动作b_a, 来选 q_eval 的值, (q_eval 原本有所有动作的值)

q_eval = self.eval_net(b_s).gather(1, b_a) # shape (batch, 1)

q_next = self.target_net(b_s_).detach() # q_next 不进行反向传递误差, 所以 detach

q_target = b_r + GAMMA * q_next.max(1)[0]

loss = self.loss_func(q_eval, q_target) #计算误差

#优化 eval_net

self.optimizer.zero_grad()

loss.backward()

self.optimizer.step()

###训练

dqn = DQN()

print('\n Collecting experience...')

for i_episode in range(100):

s = env.reset()

ep_r = 0

while True:

env.render()

a = dqn.choose_action(s)

#choose action get reward

s_, r, done, info = env.step(a)

#update reward, make dqn learn

x, x_dot, theta, theta_s = s_

r1 = (env.x_threshold - abs(x)) / env.x_threshold - 0.8

r2 = (env.theta_threshold_radians - abs(theta)) / env.theta_threshold_radians - 0.5

r = r1 + r2

#store memory

dqn.store_transition(s, a, r, s_)

ep_r += r

if dqn.memory_counter > MEMORY_CAPACITY:

dqn.learn()

if done:

print('Ep: ', i_episode,

'| Ep_r: ', round(ep_r, 2))

if done:

break

s = s_

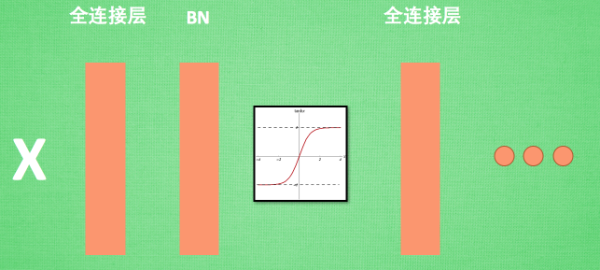

Batch Normalization

在神经网络中, 数据分布对训练会产生影响. 比如某个神经元 x 的值为1, 某个 Weights 的初始值为 0.1, 这样后一层神经元计算结果就是 Wx = 0.1; 又或者 x = 20, 这样 Wx 的结果就为 2. 现在还不能看出什么问题, 但是, 当我们加上一层激励函数, 激活这个 Wx 值的时候, 问题就来了. 如果使用 像 tanh 的激励函数, Wx 的激活值就变成了 ~0.1 和 ~1, 接近于 1 的部已经处在了 激励函数的饱和阶段, 也就是如果 x 无论再怎么扩大, tanh 激励函数输出值也还是 接近1. 换句话说, 神经网络在初始阶段已经不对那些比较大的 x 特征范围 敏感了. 这样很糟糕, 想象我轻轻拍自己的感觉和重重打自己的感觉居然没什么差别, 这就证明我的感官系统失效了. 当然我们是可以用之前提到的对数据做 normalization 预处理, 使得输入的 x 变化范围不会太大, 让输入值经过激励函数的敏感部分. 但刚刚这个不敏感问题不仅仅发生在神经网络的输入层, 而且在隐藏层中也经常会发生.

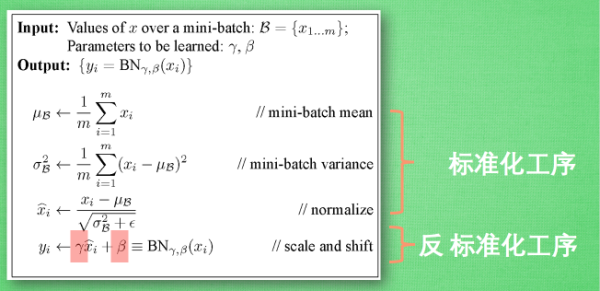

Batch normalization 的 batch 是批数据, 把数据分成小批小批进行 stochastic gradient descent. 而且在每批数据进行前向传递 forward propagation 的时候, 对每一层都进行 normalization 的处理

BN 算法:

代码:

import torch

from torch import nn

from torch.nn import init

import torch.utils.data as Data

import torch.nn.functional as F

import matplotlib.pyplot as plt

import numpy as np

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

### Hyper params

N_SAMPLES = 2000

BATCH_SIZE = 64

EPOCH = 12

LR = 0.03

N_HIDDEN = 8

ACTIVATION = F.tanh # 你可以换 relu 试试

B_INIT = -0.2 # 模拟不好的 参数初始化

## train data

x = np.linspace(-7, 10, N_SAMPLES)[:, np.newaxis]

noise = np.random.normal(0, 2, x.shape)

y = np.square(x) - 5 + noise

# test data

test_x = np.linspace(-7, 10, 200)[:, np.newaxis]

noise = np.random.normal(0, 2, test_x.shape)

test_y = np.square(test_x) - 5 + noise

train_x, train_y = torch.from_numpy(x).float(), torch.from_numpy(y).float()

test_x = torch.from_numpy(test_x).float()

test_y = torch.from_numpy(test_y).float()

train_dataset = Data.TensorDataset(train_x, train_y)

train_loader = Data.DataLoader(dataset=train_dataset, batch_size=BATCH_SIZE, shuffle=True, num_workers=2,)

# show data

# plt.scatter(train_x.numpy(), train_y.numpy(), c='#FF9359', s=50, alpha=0.2, label='train')

# plt.legend(loc='upper left')

# plt.show()

### Crate Net

class Net(nn.Module):

def __init__(self, batch_normalization=False):

super(Net, self).__init__()

self.do_bn = batch_normalization

self.fns = [] # 太多层了, 我们用 for loop 建立

self.bns = []

self.bn_input = nn.BatchNorm1d(1, momentum=0.5) # input 的 BN

for i in range(N_HIDDEN): # 建层

input_size = 1 if i == 0 else 10

fc = nn.Linear(input_size, 10)

setattr(self, 'fc%i' % i, fc) # 注意! pytorch 一定要你将层信息变成 class 的属性! 我在这里花了2天时间发现了这个 bug

self._set_init(fc) # 参数初始化

self.fns.append(fc)

if self.do_bn:

bn = nn.BatchNorm1d(10, momentum=0.5)

setattr(self, 'bn%i' % i, bn)

self.bns.append(bn)

self.predict = nn.Linear(10 ,1) # output layer

self._set_init(self.predict) # 参数初始化

def _set_init(self, layer): # 参数初始化 随机设置 weight bias

init.normal(layer.weight, mean=0, std=.1)

init.constant(layer.bias, B_INIT)

def forward(self, x):

pre_activation = [x] #

if self.do_bn: x = self.bn_input(x)

layer_input = [x]

for i in range(N_HIDDEN):

x = self.fns[i](x)

pre_activation.append(x)

if self.do_bn:x = self.bns[i](x)

x = ACTIVATION(x)

layer_input.append(x)

out = self.predict(x)

return out, layer_input, pre_activation

### 建立两个 net 一个有 BN 一个没有

nets = [Net(batch_normalization=False), Net(batch_normalization=True)]

### 训练

opts = [torch.optim.Adam(net.parameters(), lr=LR) for net in nets]

loss_func = torch.nn.MSELoss()

def plot_histogram(l_in, l_in_bn, pre_ac, pre_ac_bn):

for i, (ax_pa, ax_pa_bn, ax, ax_bn) in enumerate(zip(axs[0, :], axs[1, :], axs[2, :], axs[3, :])):

[a.clear() for a in [ax_pa, ax_pa_bn, ax, ax_bn]]

if i == 0:

p_range = (-7, 10);the_range = (-7, 10)

else:

p_range = (-4, 4);the_range = (-1, 1)

ax_pa.set_title('L' + str(i))

ax_pa.hist(pre_ac[i].data.numpy().ravel(), bins=10, range=p_range, color='#FF9359', alpha=0.5);ax_pa_bn.hist(pre_ac_bn[i].data.numpy().ravel(), bins=10, range=p_range, color='#74BCFF', alpha=0.5)

ax.hist(l_in[i].data.numpy().ravel(), bins=10, range=the_range, color='#FF9359');ax_bn.hist(l_in_bn[i].data.numpy().ravel(), bins=10, range=the_range, color='#74BCFF')

for a in [ax_pa, ax, ax_pa_bn, ax_bn]: a.set_yticks(());a.set_xticks(())

ax_pa_bn.set_xticks(p_range);ax_bn.set_xticks(the_range)

axs[0, 0].set_ylabel('PreAct');axs[1, 0].set_ylabel('BN PreAct');axs[2, 0].set_ylabel('Act');axs[3, 0].set_ylabel('BN Act')

plt.pause(0.01)

if __name__ == "__main__":

f, axs = plt.subplots(4, N_HIDDEN + 1, figsize=(10, 5))

plt.ion() # something about plotting

plt.show()

losses = [[], []] #每个网络用一个list记录误差

for epoch in range(EPOCH):

print('Epoch:', epoch)

layer_inputs, pre_acts = [], []

for net, l in zip(nets, losses):

net.eval() # set eval mode to fix moving_mean and moving_var

pred, layer_input, pre_act = net(test_x)

l.append(loss_func(pred, test_y).data.item())

layer_inputs.append(layer_input)

pre_acts.append(pre_act)

net.train() # free moving_mean and moving_var

plot_histogram(*layer_inputs, *pre_acts) # plot histogram

for step, (b_x, b_y) in enumerate(train_loader):

for net, opt in zip(nets, opts):

pred, _, _ = net(b_x)

loss = loss_func(pred, b_y)

opt.zero_grad()

loss.backward()

opt.step()

plt.ioff()

# plot training loss

plt.figure(2)

plt.plot(losses[0], c='#FF9359', lw=3, label='Original')

plt.plot(losses[1], c='#74BCFF', lw=3, label='Batch Normalization')

plt.xlabel('step');plt.ylabel('test loss');plt.ylim((0, 2000));plt.legend(loc='best')

# evaluation

# set net to eval mode to freeze the parameters in batch normalization layers

[net.eval() for net in nets] # set eval mode to fix moving_mean and moving_var

preds = [net(test_x)[0] for net in nets]

plt.figure(3)

plt.plot(test_x.data.numpy(), preds[0].data.numpy(), c='#FF9359', lw=4, label='Original')

plt.plot(test_x.data.numpy(), preds[1].data.numpy(), c='#74BCFF', lw=4, label='Batch Normalization')

plt.scatter(test_x.data.numpy(), test_y.data.numpy(), c='r', s=50, alpha=0.2, label='train')

plt.legend(loc='best')

plt.show()

Dropout解决过拟合

代码:

'''

Dropout 解决过拟合

'''

import torch

import matplotlib.pyplot as plt

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

N_SAMPLES = 20

N_HIDDEN = 300

# training data

x = torch.unsqueeze(torch.linspace(-1, 1, N_SAMPLES), 1)

y = x + 0.3*torch.normal(torch.zeros(N_SAMPLES, 1), torch.ones(N_SAMPLES, 1))

# test data

test_x = torch.unsqueeze(torch.linspace(-1, 1, N_SAMPLES), 1)

test_y = test_x + 0.3*torch.normal(torch.zeros(N_SAMPLES, 1), torch.ones(N_SAMPLES, 1))

# show data

# plt.scatter(x.data.numpy(), y.data.numpy(), c='magenta', s=50, alpha=0.5, label='train')

# plt.scatter(test_x.data.numpy(), test_y.data.numpy(), c='cyan', s=50, alpha=0.5, label='test')

# plt.legend(loc='upper left')

# plt.ylim((-2.5, 2.5))

# plt.show()

### Crate Net1 产生过拟合

net_overfitting = torch.nn.Sequential(

torch.nn.Linear(1, N_HIDDEN),

torch.nn.ReLU(),

torch.nn.Linear(N_HIDDEN, N_HIDDEN),

torch.nn.ReLU(),

torch.nn.Linear(N_HIDDEN, 1),

)

### Crate Net2 Dropout解决过拟合

net_dropped = torch.nn.Sequential(

torch.nn.Linear(1, N_HIDDEN),

torch.nn.Dropout(0.5), # 0.5 指的是随机有 50% 的神经元会被关闭/丢弃.

torch.nn.ReLU(),

torch.nn.Linear(N_HIDDEN, N_HIDDEN),

torch.nn.Dropout(0.5), # 0.5 指的是随机有 50% 的神经元会被关闭/丢弃.

torch.nn.ReLU(),

torch.nn.Linear(N_HIDDEN, 1),

)

print(net_overfitting)

print(net_dropped)

'''

Sequential(

(0): Linear(in_features=1, out_features=300, bias=True)

(1): ReLU()

(2): Linear(in_features=300, out_features=300, bias=True)

(3): ReLU()

(4): Linear(in_features=300, out_features=1, bias=True)

)

Sequential(

(0): Linear(in_features=1, out_features=300, bias=True)

(1): Dropout(p=0.5, inplace=False)

(2): ReLU()

(3): Linear(in_features=300, out_features=300, bias=True)

(4): Dropout(p=0.5, inplace=False)

(5): ReLU()

(6): Linear(in_features=300, out_features=1, bias=True)

)

'''

### Train 2 net

optimizer_ofit = torch.optim.Adam(net_overfitting.parameters(), lr=0.01)

optimizer_drop = torch.optim.Adam(net_dropped.parameters(), lr=0.01)

loss_func = torch.nn.MSELoss()

for t in range(500):

pred_ofit = net_overfitting(x)

pred_drop = net_dropped(x)

loss_ofit = loss_func(pred_ofit, y)

loss_drop = loss_func(pred_drop, y)

optimizer_ofit.zero_grad()

optimizer_drop.zero_grad()

loss_ofit.backward()

loss_drop.backward()

optimizer_ofit.step()

optimizer_drop.step()

if t % 10 == 0:

# change to eval mode in order to fix drop out effect

net_overfitting.eval()

net_dropped.eval() # parameters for dropout differ from train mode

# plotting

plt.cla()

test_pred_ofit = net_overfitting(test_x)

test_pred_drop = net_dropped(test_x)

plt.scatter(x.data.numpy(), y.data.numpy(), c='magenta', s=50, alpha=0.3, label='train')

plt.scatter(test_x.data.numpy(), test_y.data.numpy(), c='cyan', s=50, alpha=0.3, label='test')

plt.plot(test_x.data.numpy(), test_pred_ofit.data.numpy(), 'r-', lw=3, label='overfitting')

plt.plot(test_x.data.numpy(), test_pred_drop.data.numpy(), 'b--', lw=3, label='dropout(50%)')

plt.text(0, -1.2, 'overfitting loss=%.4f' % loss_func(test_pred_ofit, test_y).data.numpy(), fontdict={'size': 20, 'color': 'red'})

plt.text(0, -1.5, 'dropout loss=%.4f' % loss_func(test_pred_drop, test_y).data.numpy(), fontdict={'size': 20, 'color': 'blue'})

plt.legend(loc='upper left'); plt.ylim((-2.5, 2.5));plt.pause(0.1)

# change back to train mode

net_overfitting.train()

net_dropped.train()

plt.ioff()

plt.show()

0:

# change to eval mode in order to fix drop out effect

net_overfitting.eval()

net_dropped.eval() # parameters for dropout differ from train mode

# plotting

plt.cla()

test_pred_ofit = net_overfitting(test_x)

test_pred_drop = net_dropped(test_x)

plt.scatter(x.data.numpy(), y.data.numpy(), c='magenta', s=50, alpha=0.3, label='train')

plt.scatter(test_x.data.numpy(), test_y.data.numpy(), c='cyan', s=50, alpha=0.3, label='test')

plt.plot(test_x.data.numpy(), test_pred_ofit.data.numpy(), 'r-', lw=3, label='overfitting')

plt.plot(test_x.data.numpy(), test_pred_drop.data.numpy(), 'b--', lw=3, label='dropout(50%)')

plt.text(0, -1.2, 'overfitting loss=%.4f' % loss_func(test_pred_ofit, test_y).data.numpy(), fontdict={'size': 20, 'color': 'red'})

plt.text(0, -1.5, 'dropout loss=%.4f' % loss_func(test_pred_drop, test_y).data.numpy(), fontdict={'size': 20, 'color': 'blue'})

plt.legend(loc='upper left'); plt.ylim((-2.5, 2.5));plt.pause(0.1)

# change back to train mode

net_overfitting.train()

net_dropped.train()

plt.ioff()

plt.show()