动手学深度学习Pytorch版

2.3 线性代数

#2.3.1 标量

仅包含一个数值的叫标量(scalar),标量由仅有一个元素的张量表示。

import torch

x = torch.tensor([3.0])

y = torch.tensor([2.0])

print(x+y,x*y,x/y,x**y)

------

tensor([5.]) tensor([6.]) tensor([1.5000]) tensor([9.])

#2.3.2 向量

标量值组成的列表为向量,通过一维张量处理向量。

x = torch.arange(4)

print(x)

print(x[3]) #通过索引访问元素

print(len(x)) #长度

print(x.shape) #维度和形状

------

tensor([0, 1, 2, 3])

tensor(3)

4

torch.Size([4])

向量或轴的维度=长度=元素数量

张量的维度=张量具有的轴数

#2.3.2矩阵

A = torch.arange(20).reshape(5,4)

print(A)

print(A.T)

------

tensor([[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11],

[12, 13, 14, 15],

[16, 17, 18, 19]])

tensor([[ 0, 4, 8, 12, 16],

[ 1, 5, 9, 13, 17],

[ 2, 6, 10, 14, 18],

[ 3, 7, 11, 15, 19]])

对称矩阵等于其转置。

B = torch.tensor([[1,2,3],[2,0,4],[3,4,5]])

print(B==B.T)

------

tensor([[True, True, True],

[True, True, True],

[True, True, True]])

#2.3.4 张量

张量(本小节中指代数对象)提供描述具有任意数量轴的n维数组的通用方法。

X = torch.arange(24).reshape(2,3,4)

print(X)

------

tensor([[[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11]],

[[12, 13, 14, 15],

[16, 17, 18, 19],

[20, 21, 22, 23]]])

处理图象时,图像以n维数组形式出现,3个轴对应高度,宽度,和通道。

#2.3.5 张量算法的基本性质

A = torch.arange(20,dtype=torch.float32).reshape(5,4)

B = A.clone() #分配新内存

print(A,A+B)

------

tensor([[ 0., 1., 2., 3.],

[ 4., 5., 6., 7.],

[ 8., 9., 10., 11.],

[12., 13., 14., 15.],

[16., 17., 18., 19.]])

tensor([[ 0., 2., 4., 6.],

[ 8., 10., 12., 14.],

[16., 18., 20., 22.],

[24., 26., 28., 30.],

[32., 34., 36., 38.]])

哈达玛积(Hadamard product):矩阵按元素乘法。

print(A * B)

------

tensor([[ 0., 1., 4., 9.],

[ 16., 25., 36., 49.],

[ 64., 81., 100., 121.],

[144., 169., 196., 225.],

[256., 289., 324., 361.]])

张量加or乘标量不改变张量形状,每个元素与标量相加or相乘。

a = 2

X = torch.arange(24).reshape(2,3,4)

print((a + X),(a * X).shape)

------

tensor([[[ 2, 3, 4, 5],

[ 6, 7, 8, 9],

[10, 11, 12, 13]],

[[14, 15, 16, 17],

[18, 19, 20, 21],

[22, 23, 24, 25]]])

torch.Size([2, 3, 4])

#2.3.6 降维

1.求和

x = torch.arange(4,dtype = torch.float32)

print(x,x.sum())

------

tensor([0., 1., 2., 3.]) tensor(6.)

2.使用求和函数降低张量的维度

axis=0,行降维。

axis=1,列降维

A = torch.arange(20).reshape(5,4)

print(A)

A_sum_axis0 = A.sum(axis=0)

print(A_sum_axis0, A_sum_axis0.shape)

A_sum_axis0 = A.sum(axis=1)

print(A_sum_axis0, A_sum_axis0.shape)

------

tensor([[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11],

[12, 13, 14, 15],

[16, 17, 18, 19]])

tensor([40, 45, 50, 55])

torch.Size([4])

tensor([ 6, 22, 38, 54, 70])

torch.Size([5])

沿着行和列对矩阵求和=对矩阵所有元素求和

print(A.sum(axis=[0,1]))

------

tensor(190)

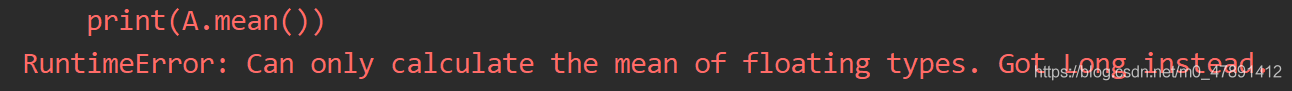

3.平均值

print(A.mean(),A.sum()/A.numel())

------

tensor(9.5000) tensor(9.5000)

注意类型,否则报错。

沿指定轴降低张量的维度。

A = torch.arange(20,dtype = torch.float32).reshape(5,4)

print(A)

print(A.mean(axis=0),A.sum(axis=0)/A.shape[0])

------

tensor([[ 0., 1., 2., 3.],

[ 4., 5., 6., 7.],

[ 8., 9., 10., 11.],

[12., 13., 14., 15.],

[16., 17., 18., 19.]])

tensor([ 8., 9., 10., 11.])

tensor([ 8., 9., 10., 11.])

4.非降维求和

列降维求和,保持轴数不变。

sum_A=A.sum(axis=1,keepdims=True)

print(sum_A)

------

tensor([[ 6.],

[22.],

[38.],

[54.],

[70.]])

广播机制

print(A / sum_A)

------

tensor([[0.0000, 0.1667, 0.3333, 0.5000],

[0.1818, 0.2273, 0.2727, 0.3182],

[0.2105, 0.2368, 0.2632, 0.2895],

[0.2222, 0.2407, 0.2593, 0.2778],

[0.2286, 0.2429, 0.2571, 0.2714]])

cumsum函数不沿任何轴降低输入张量的维度。

print(A.cumsum(axis=0))

------

tensor([[ 0., 1., 2., 3.],

[ 4., 6., 8., 10.],

[12., 15., 18., 21.],

[24., 28., 32., 36.],

[40., 45., 50., 55.]])

上述张量中的元素为A在行维度的阶段性累和结果。

#2.3.7 点积(Dot Product)

点积:相同位置的按元素乘积的和。

x = torch.arange(4,dtype=torch.float32)

y = torch.ones(4,dtype=torch.float32)

print(x,y, torch.dot(x, y))

------

tensor([0., 1., 2., 3.]) tensor([1., 1., 1., 1.]) tensor(6.)

点积=按元素乘法+求和

print(torch.sum(x*y))

------

tensor(6.)

#2.3.8 矩阵-向量积

A = torch.arange(20,dtype = torch.float32).reshape(5,4)

x = torch.arange(4,dtype=torch.float32)

print(A.shape,x.shape,torch.mv(A,x))

------

torch.Size([5, 4]) torch.Size([4]) tensor([ 14., 38., 62., 86., 110.])

#2.3.9 矩阵-矩阵乘法

A = torch.arange(20,dtype = torch.float32).reshape(5,4)

B = torch.ones(4,3)

print(torch.mm(A,B))

------

tensor([[ 6., 6., 6.],

[22., 22., 22.],

[38., 38., 38.],

[54., 54., 54.],

[70., 70., 70.]])

#2.3.10 范数

范数(norms):一个向量的范数告诉我们一个向量有多大,指分量的大小,范数非负。

线性代数中,向量范数是将向量映射到标量的函数f。

1.L1范数:绝对值函数和按元素求和组合起来,受异常值影响较小。

print(torch.abs(u).sum())

------

tensor(7.)

2.L2范数:向量元素平方和的平方根。

u = torch.tensor([3.0,-4.0])

print(torch.norm(u))

------

tensor(5.)

3.弗罗贝尼乌斯范数(Frobenius norm):矩阵元素平方和的平方根。

print(torch.norm(torch.ones((4,9))))

------

tensor(6.)

小结:

? 标量、向量、矩阵和张量是线性代数中的基本数学对象。

? 向量泛化?标量,矩阵泛化?向量。

? 标量、向量、矩阵和张量分别具有零、?、?和任意数量的轴。

? ?个张量可以通过sum和mean沿指定的轴降低维度。

? 两个矩阵的按元素乘法被称为他们的哈达玛积。它与矩阵乘法不同。

? 在深度学习中,我们经常使?范数,如L1范数、L2范数和弗罗?尼乌斯范数。

? 我们可以对标量、向量、矩阵和张量执?各种操作。