文章目录

论文地址:https://arxiv.org/pdf/2008.12283.pdf

摘要

1.引入实体引导序列作为eg:BERT的输入。

2.使用内部注意力概率作为evidence预测的附加特征来指导预训练语言模型的微调。

实体entity, evidence 支撑实体的句子。

一、介绍

面临问题:预训练语言模型在所有标记上给出的注意力值对于RE较为统一,限制了模型从文档到相关令牌提取信息的能力,限制了预训练LM 的有效性。

解决方法:对于文档中的每个实体,将实体附加到文档的开头来生成一个新的输入序列。(Ne个实体,就有Ne个新序列 for training)来对LM进行微调。

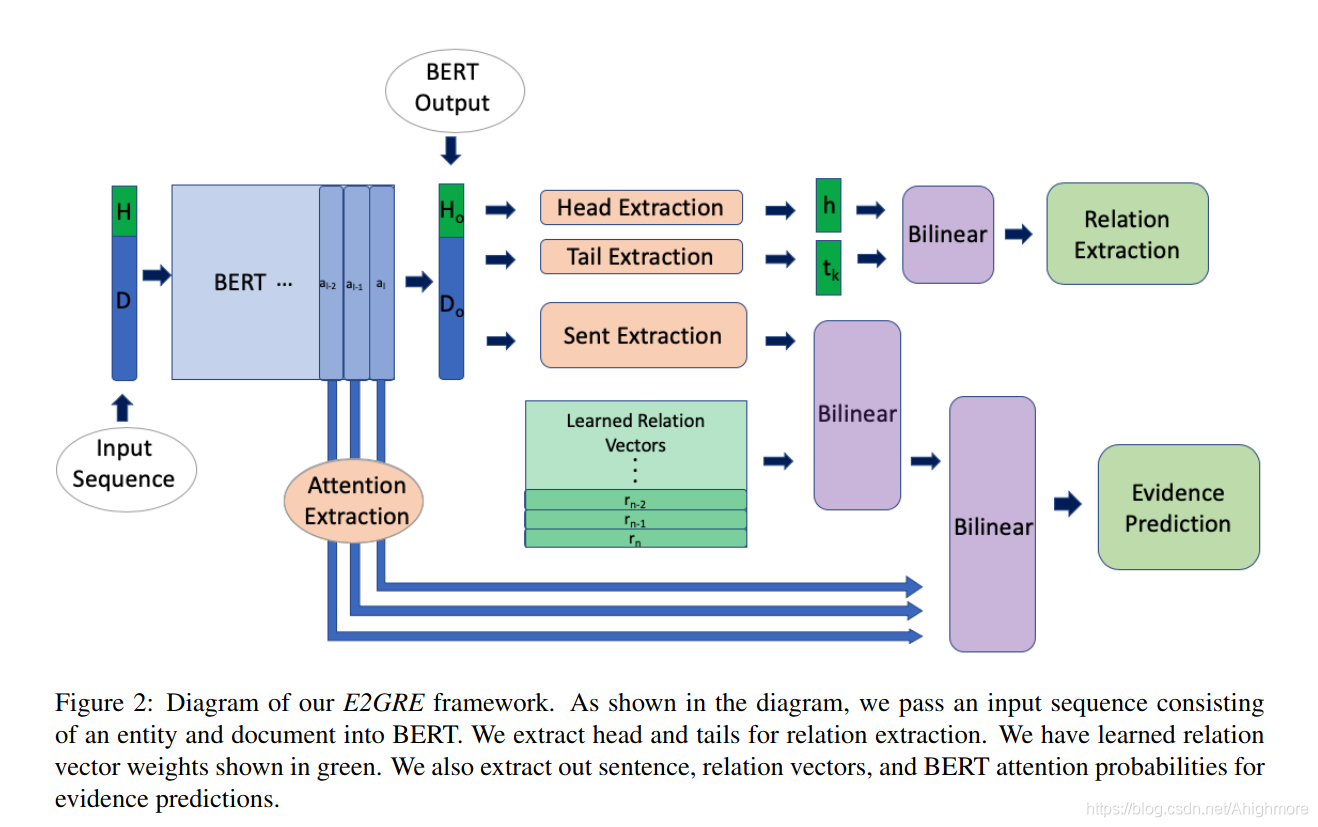

二、方法

1.如何生成实体引导的输入

H表示(连接头实体)D文档标记 [CLS]表征向量C用于后续的分类任务;[SEP]分开两个输入句子。

形成输入序列embedding:“[CLS]”“+H+”[SEP]”“+D+”[SEP]”

2.实体引导的RE

average后得到实体的embedding h

k-th tail entity embedding tk

h 和tk的关系的概率

微调BERT后的多标签交叉熵的loss:

3.entity and evidence-guided joint training for RE

1)Evidence Prediction

ri 表示第i类关系的relation embedding;Ns 为文档中的句子数,对s中的word的所有嵌入求平均获得嵌入s。

predict the probability j- th 句子sj 是是第i类关系的evidence

在 i-th relation 下evidence预测的loss:

2)Evidence-guided Fine-tuning with BERT Attention Probabilities

Bert的内部注意力值高的区域通常就是证据支持句,有助于证据预测,他反向来用原本的att来找evidence。bert 的最后三层行证据预测。

attention probabilities ask

句子和关系的联合嵌入:

loss of evidence prediction under a given i-th relation :

3)Joint Training with Evidence Prediction

关系抽取和证据预测两个任务,作为多任务学习来训练,loss是:

三、ablation study

实体:2.5%

evidence:1.7%