目录

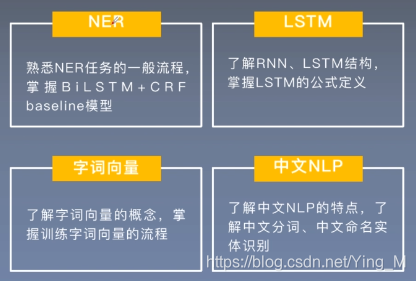

前期知识储备

学习目标

论文导读

论文研究背景、成果及意义

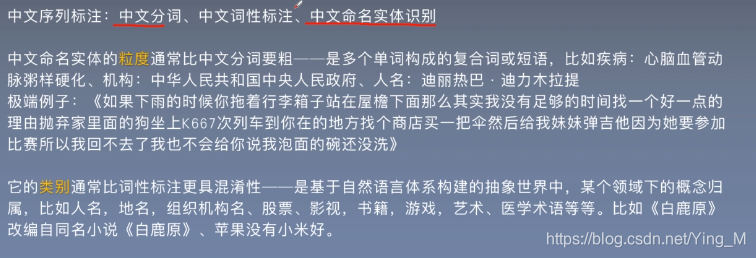

中文命名实体识别特点

中文命名实体识别难点(一):命名命名实体

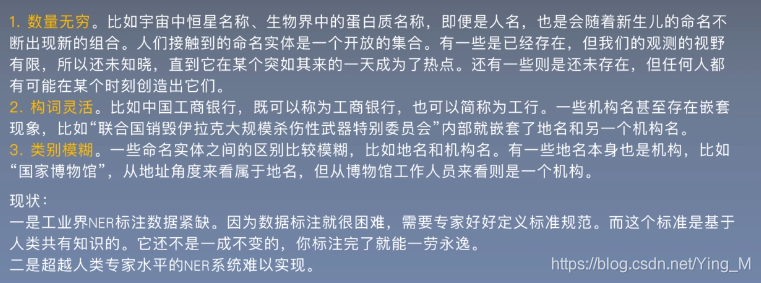

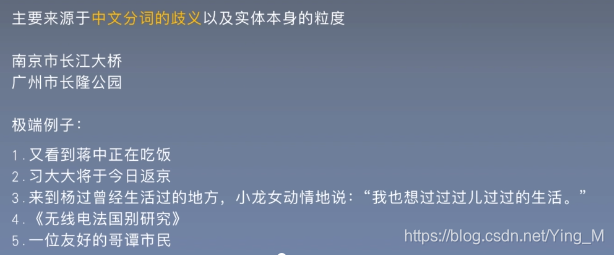

中文命名实体识别难点(二):实体的无穷

中文命名实体识别难点(三):实体边界划分难以学习

本文idea提出原因

如何利用现有词典,引入所有可能词的边界信息呢?

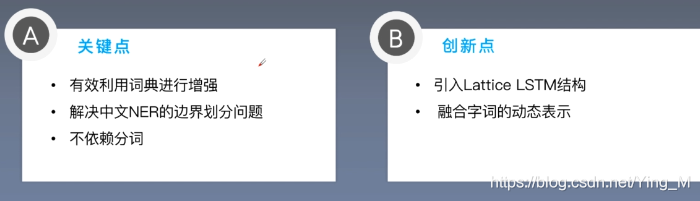

研究成果

研究意义

论文泛读

摘要核心

论文精读

论文模型总览

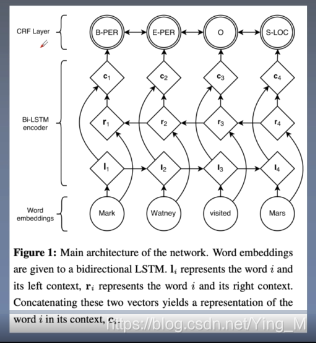

BiLSTM-CRF模型

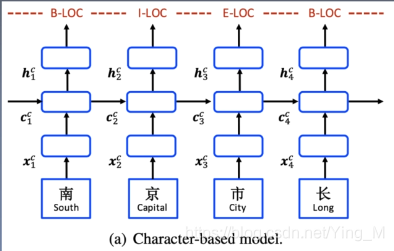

字或词

基于词的结构会引入分词错误,错误会累积,进而会影响中文NER的效果。

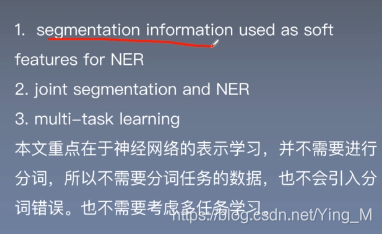

利用词信息

对于"南"字来说,不仅取"南"的embedding,还取其分词特征,即加入soft features;

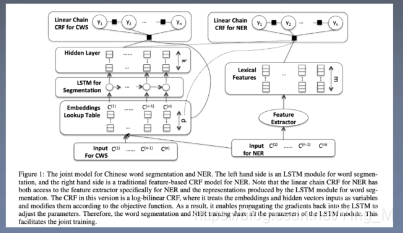

先分词再进行ner,每个字取其Embedding,然后输入lstm中提取特征,然后输入hidden layer进行分词任务,hidden layer相当于包含了分词的信息,即分词的发射分数,如何应用到ner中呢?右边ner中,对于每个字,提取一些特征,如基于词典的一些特征,将其放到最终的解码层,将每个字对应的Embedding以及分词最终的hidden layer融合到一起,来做最终的ner任务。

外部资源信息

本文利用引入自动分词后已训练的词向量做词汇的增强。

树结构的循环神经网络

模型细节一:融合字符与词级别特征

1.基于字符级别的特征

将每个字作为每个时间步的输入,基于字符级别这里分成了三种:

在char+bichar中,eb(cj,cj+1)相当于是一个词,两个字组成的词;

es(seg(cj)),softword为segment information,它是一个词的begin、inner、end。

2.基于词级别的模型

重点在于分词,分词后将词语作为每个时间步上的输入

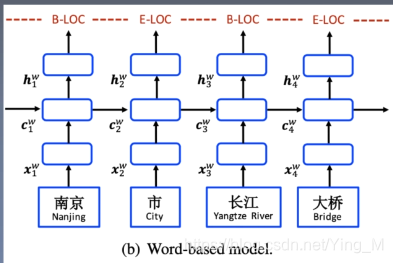

3.融合字、词级别特征的模型

- word + char LSTM

- word + char LSTM’

- word + char CNN

char LSTM是说把每个单词单独输入到一个lstm中去提取最终的lstm输出做它的Embedding,每个单词都是互相独立, 都会做这样的lstm,然后和词的Embedding拼到一起,做上下文特征抽取;

char LSTM‘的做法如上图所示,讲一句话看做成一个字符序列。

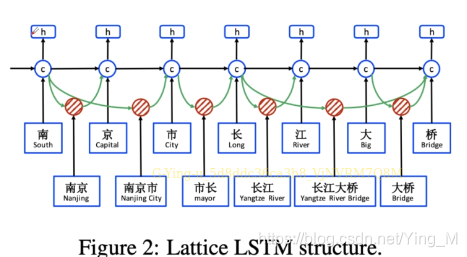

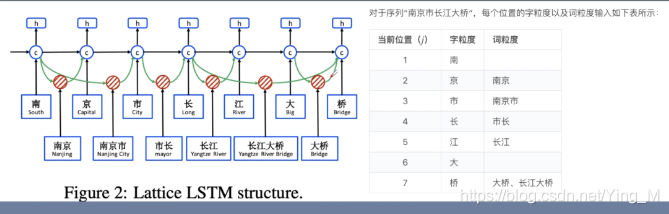

LatticeLSTM

latticeLSTM是如何融合字与词的信息而不引入分词错误呢?

不是将一种分词加进来,而是将所有可能的分词都加进来。

具体的例子:

为了图示简洁: - 没有展示gate cell

- 只展示了单向

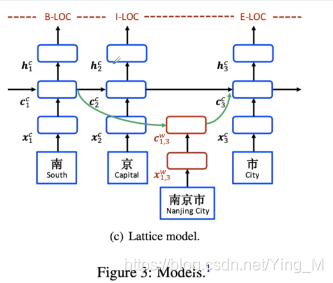

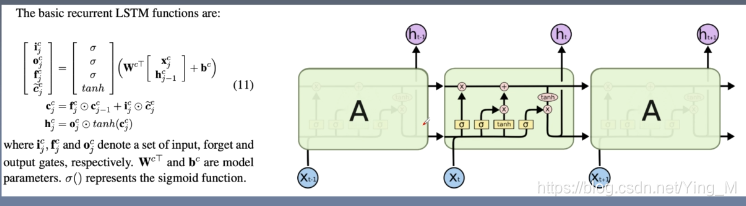

模型细节二:从LSTM到LatticeLSTM

basic LSTM

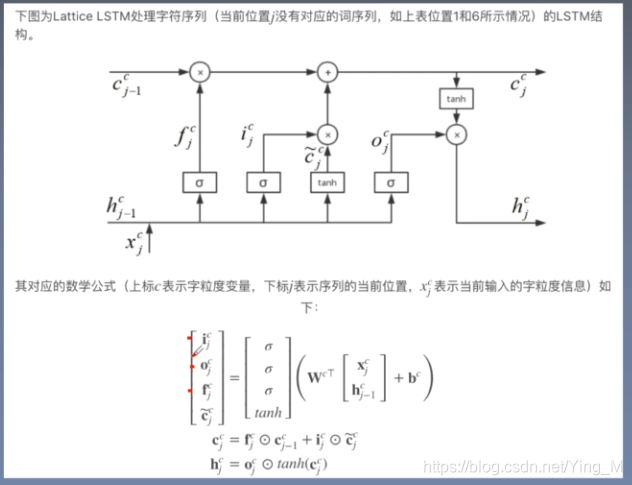

LatticeLSTM公式详解

- 1.在字词融合的路径上尝试了很多配置,发现这种配置在初步实验中提供了最佳效果;

- 2.这里排除单字符的单词;集成单字符单词后,最终性能会有所下降。

字粒度输入

词粒度输入

字词融合

每个词对应于一个额外的门

LatticeLSTM

以字符为基础的,更关注的是如何增强表示层

实验设置及结果分析

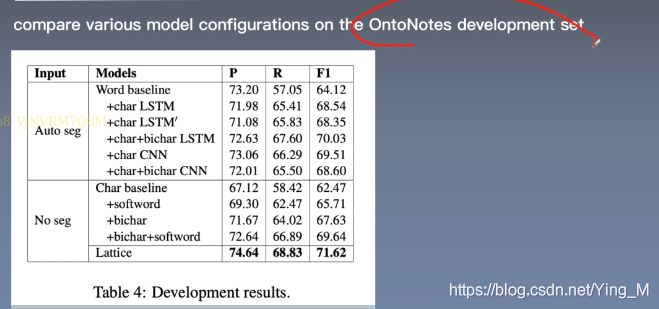

实验结果及分析

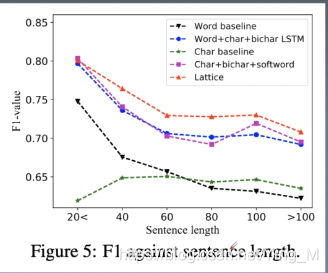

F1与句子长度之间的关系

Lattice LSTM随着句子长度的增加,F1值降低较少,证明模型效果在句子长度方面的鲁棒性。

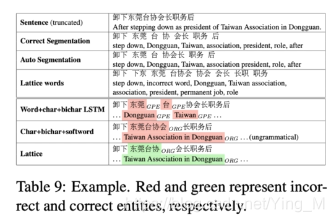

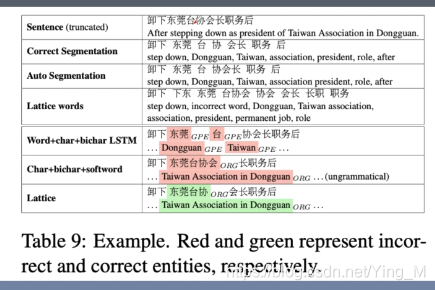

Case Study

Lattice LSTM模型边界划分更准确

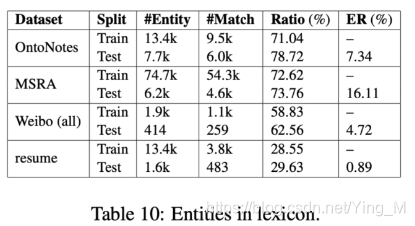

词典中实体的覆盖度

Lattice LSTM能更好的利用词典信息

ER表示错误降低百分比

论文总结

因为分词会有歧义、会出错,所以我们不应该依赖分词,但是词典是有先验信息的,能知道我们的NER边界划分,应把这些信息利用起来,如何既能避免分词错误,又能利用词典信息,那就是网格的结构,让模型自己去选。

Lattice LSTM 模型缺陷

不具有迁移性,只能用lstm来做这些事情,lstm也有自己天然的一些缺点,比如不能并行化,依赖有限制;