基于因果嵌入的用户兴趣分离与推荐一致性

摘要

推荐模型通常是基于观测交互数据训练的。然而,观察性交互数据可能来自用户对流行项目的从众,这纠缠了用户的真正兴趣。现有的方法跟踪这个问题,消除流行偏差,例如,通过重新加权训练样本或利用小部分无偏数据。然而,这些方法忽略了用户一致性的多样性,并且交互的不同原因被捆绑在一起作为统一的表示,因此当潜在原因发生变化时,健壮性和可解释性不能得到保证。在本文中,我们提出了DICE,一个通用的框架,它学习表示,其中兴趣和一致性在结构上是分离的,并且各种主干推荐模型可以被平滑地集成。我们为用户和项目分配了兴趣和一致性的独立嵌入,并通过使用根据因果推理的碰撞效应获得的特定原因数据进行训练,使每个嵌入只捕获一个原因。我们提出的方法在各种主干模型之上的两个真实数据集上有显著的改进,优于最先进的基线。我们进一步证明了学习的嵌入成功地捕获了期望的原因,并表明DICE保证了推荐的健壮性和可解释性。

CCS CONCEPTS

Information systems(信息系统) ? \longrightarrow ??? Collaborative filtering(协同过滤)。

KEYWORDS

Recommender systems(推荐系统), popularity bias(流行偏差), causal embedding(因果嵌入)。

ACM Reference Format:(自动呼叫管理参考格式:)

1 INTRODUCTION

近年来,推荐系统取得了巨大的成功,它通过从观察到的交互数据中挖掘用户偏好来为用户提供个性化内容[36]。然而,观察性交互数据表现出强烈的流行偏见[12],这困扰着用户的真正兴趣。用户可能仅仅因为许多其他用户点击了某个项目就点击了该项目,例如在电子商务平台中,项目通常显示有其销售值。事实上,这些互动主要是由用户的从众心理驱动的,而不是真正的兴趣。从众是决策的一个关键因素,它描述了用户如何倾向于跟随其他人。同时,不同的用户对某个项目的认同度也不同。为了捕捉独立于从众的用户的纯粹兴趣,现有的方法将这个问题跟踪为消除流行偏差,这是一个从项目角度来看的静态和全局术语,而忽略了用户从众的多样性。例如,一个运动爱好者购买了一辆具有高销售价值的自行车,这是因为他对特定特征(例如轮胎尺寸或速度容量)的独特品味,而一个办公室工作人员购买同一辆自行车可能只是因为它的高销量。使用统一的流行度偏差无法区分这两个用户的不同一致性,因为一个项目的流行度分数对于所有用户都是相同的。因此,理清用户兴趣和从众心理是提高推荐质量的关键。

在这项工作中,我们从用户的角度采取了不同的方法。我们建议将观察到的交互分解为用户方的两个因素,兴趣和从众,并为它们学习区分的表示,而不是从项目的角度消除流行偏见。把这两个因素分开是具有挑战性的,还没有得到很好的探索。具体来说,我们面临三个关键挑战。

首先,一致性取决于用户和项目。一个用户对不同项目的符合程度不同,不同用户对一个项目的符合程度也不同。因此,现有算法采用的用户或项目的标量偏差项是不够的[4]。

第二,学习解开表象本质上是困难的,尤其是当只有观察交互数据可用的时候。换句话说,我们只能获得结果,而不能获得原因,因为兴趣和从众没有贴上标签的基础真理价值。

第三,点击互动可以来自兴趣和从众的一个或两个原因。因此,需要精心设计,将这两个原因进行聚合和平衡。

尽管这是一项具有挑战性的任务,但是与只学习用户或项目的统一嵌入的方法相比,学习兴趣和从众心理的分离表示有两个主要优势:

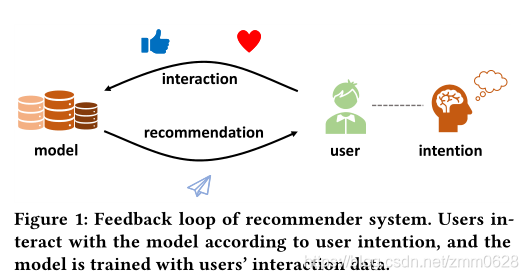

图一:推荐系统的反馈回路。根据用户意图用户与模型进行交互,并用用户的交互数据对模型进行训练。

(1)稳健性:现实世界的推荐系统通常使用实时用户交互来训练和持续更新,这形成了如图1所示的反馈回路,训练数据和测试数据不是独立且同分布的(IID) [13]。对结果(点击)和原因(兴趣和从众)的因果建模可以产生更稳健的模型,具有更强的泛化能力,尤其是在潜在原因正在变化的非IID情况下[41]。

(2)可解释性:可解释推荐对推荐系统的用户和平台都有好处,因为它提高了用户友好性,并促进了算法开发。通过解开潜在原因,每个推荐分数被分解为兴趣分数和从众跟风分数的集合。因此,根据相应的分数可以很容易地对这两个原因做出解释。

在本文中,我们提出了一个用因果嵌入(DICE)来解开兴趣和一致性的一般框架。

Disentangling Interest and Conformity with Causal Embedding (DICE)

为了捕捉整合的多样性,我们建议为整合单独学习综合嵌入,它与用户兴趣无关。我们不是使用简单的标量流行值作为现有的方法,而是开发特定的方法来学习兴趣和从众跟风的分开理清表示。具体来说,我们描述了每个交互数据是如何生成的因果模型。基于因果模型,我们基于因果推理的碰撞效应提出了特定原因的特定负采样策略[37,38],并学习了兴趣的独立嵌入和与特定原因数据的一致性。同时,我们增加了对嵌入的两个部分之间的解纠缠的直接监督。为了在考虑用户兴趣和一致性的情况下生成最终推荐,我们采用了多任务和课程学习,成功地平衡了这两种原因。

我们在从实际应用中收集的两个大规模基准数据集上评估了所提出的方法。实验结果表明,DICE在Recall和NDCG方面都优于最先进的基线,提高了15%以上。为了研究DICE的稳健性,我们通过对符合性进行干预,提取带有训练数据的non-IID测试数据。我们证明,在non-IID情况下,DICE始终优于基线方法。此外,我们提供了关于学习嵌入质量的分析结果,这说明了所提出的方法的卓越的可解释性。

总之,本文的主要贡献如下:

- 据我们所知,这是第一个为推荐系统解决用户兴趣和从众心理问题的工作。我们从用户的角度来处理因果推荐问题,并表明从鲁棒性和可解释性方面来说,分开这两个因素对于推荐系统是必不可少的。

- 我们提出了一个总体框架来理清兴趣和从众跟风。采用单独的嵌入来捕获两个原因,并用特定于原因的数据训练不同的嵌入,强制只捕获一个期望的原因。此外,我们利用多任务学习和课程学习来平衡这两个原因。

- 在真实推荐系统的两个大规模数据集上进行了大量实验。结果表明,与最先进的基线模型相比,DICE取得了显著的改进。进一步的分析表明,DICE在非IID环境下表现出很强的鲁棒性,并且在DICE中学习到的嵌入具有很高的可解释性。

本文的其余部分如下。我们首先在第2节介绍动机并阐述问题。然后,我们在第3节详细阐述了提议的DICE框架。我们在第4节进行实验,然后在第5节讨论相关的工作。最后,我们在第6节总结了本文。

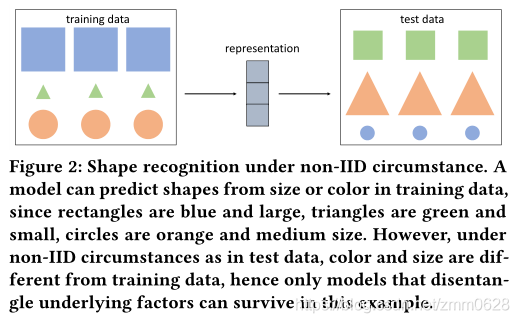

图二:non-IID环境下的形状识别。模型可以根据训练数据中的大小或颜色预测形状,因为矩形是蓝色和大的,三角形是绿色和小的,圆形是橙色和中等大小。然而,在非IID环境下,如在测试数据中,颜色和大小不同于训练数据,因此只有解开潜在因素的模型才能在这个例子中存活。

2 动机和问题概述 MOTIV ATION AND PROBLEM OVERVIEW

Motivation动机.解开底层语义的算法比纠缠方法具有更好的泛化能力。这里我们关注的是泛化能力的一种具体形式,它不是从同一个分布中的一个数据点到另一个数据点,而是从一个分布到另一个分布。图2显示了一个形状识别的例子,它遵循训练数据和测试数据的non-IID条件。假设我们正在开发一个形状识别模型,在该模型中,我们从原始图片中学习表示,并基于所学习的表示预测它们的形状。这似乎是一个正常的任务,但是其中有陷阱。事实上,模型很容易被训练数据误导,因为矩形是蓝色和大的,三角形是绿色和小的,圆形是橙色和中等大小。因此,模型可以根据颜色或大小预测形状,而不是轮廓。此外,如果测试数据是从相同的分布中生成的(即带有训练数据的IID),那么注重颜色或大小的坏模型在测试集上会表现良好,我们甚至可能不会注意到哪里出了问题。幸运的是,我们强制训练数据和测试数据不是IID,如图2所示,其中颜色和大小与训练数据完全不同,并评估我们的模型在这种干预环境下是否健壮。那么只有那些解开底层语义(形状、颜色和尺寸)的模型才能在我们的测试中存活。

关于推荐系统,点击交互可以由用户的真实兴趣或者他们对流行项目的一致性来触发。在IID的情况下,模型没有必要区分用户的兴趣和从众,因此模型倾向于根据它们的流行度值来推荐项目,因为它们的训练实例量较大。然而,用户在训练时间和服务时间的一致性是不同的,因为推荐系统是一个如图1所示的实时交互系统。因此,在这种non-IID的情况下,推荐算法必须是健壮的,尤其是当潜在原因不同时。在这项工作中,我们扩展了传统的因果推荐算法,该算法从有偏差的数据中执行无偏学习[26],并提出解开用户兴趣和从中跟风。

基于因果推荐[9,30]的最新进展,我们用训练数据和测试数据构建数据集,而不是IID。我们将提议的方法与最先进的基线方法进行了比较,并特别通过干预研究了它们在non-IID环境下的稳健性。

问题表述.在这里,我们提出了解开用户兴趣和从众跟风的问题。假设数据集 O \mathcal{O} O 是由 ( u , i , p ) (u,i,p) (u,i,p) 的 N N N 个实例组成,其中 p p p是项目 i i i的受欢迎程度,即项目 i i i 上的交互次数.p的分布是一致性分布的代表。我们首先构建干预测试集 O t e s t O_{test} Otest? 和正常训练集 O t r a i n O_{train} Otrain? ,这里的 D p O t e s t D_{p}^{O_{test}} DpOtest?? 测试集中的项目流行度p的分布不同于训练集中的项目流行度p的分布, D p O t r a i n D_{p}^{O_{train}} DpOtrain?? .我们的目标是最大化推荐性能 R \mathcal{R} R ,像recall和NDCG,在12 O t e s t O_{test} Otest? ,在 O t e s t O_{test} Otest?不是IID的 O t r a i n O_{train} Otrain??上训练的模型:

Input: 观测相互作用数据 O \mathcal{O} O ,其被分成 O t e s t O_{test} Otest? 和 O t r a i n O_{train} Otrain? ,具有非IID条件流行度分布 D p O t r a i n D_{p}^{O_{train}} DpOtrain?? 和 D p O t e s t D_{p}^{O_{test}} DpOtest??。

Output: 一种预测模型,用于估计用户是否会在考虑兴趣和大众性心理的情况下点击某个项目。

###3 DICE: THE PROPOSED APPROACH

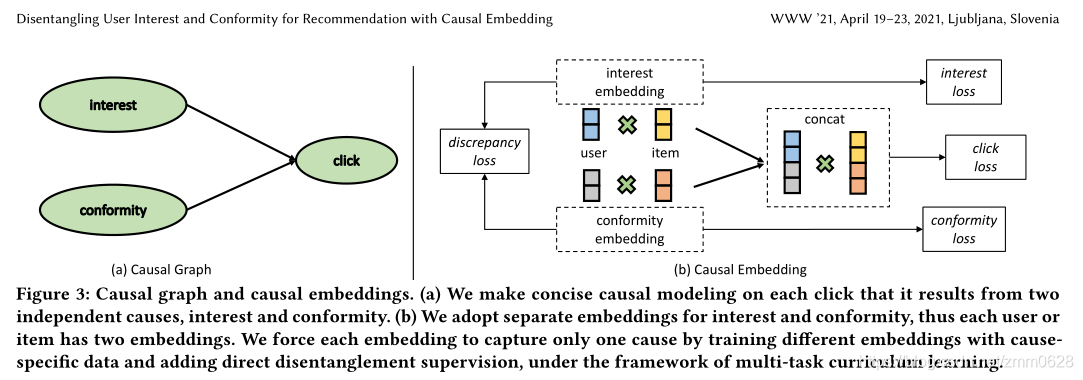

我们提出了一个通用的框架,叫做DICE,来学习兴趣和一致性的解纠结表示。图3展示了DICE的整体设计。为了应对前面介绍的三个挑战,我们提出的框架由以下三个阶段组成:

- Causal Embedding :我们建议利用独立嵌入代替标量值来表示兴趣和一致性,以解决不同一致性的问题。

- Disentangled Representation Learning 解开表征学习:为了学习兴趣和一致性的分开表示,我们将训练数据分成特定原因部分,并用特定原因数据训练不同的嵌入。增加了对嵌入分布的直接监督,以加强理清。

- Multi-task Curriculum Learning多任务课程学习:最后,我们开发了一个由易到难的培训策略,并利用课程学习来聚合和平衡兴趣和一致性。

图三:因果图和因果嵌入。(a)我们对每一次点击进行简洁的因果建模,它是由两个独立的原因引起的,即兴趣和一致性。(b)我们对兴趣和从众采用单独的嵌入,因此每个用户或项目有两个嵌入。在多b任务课程学习的框架下,我们通过用原因特定的数据训练不同的嵌入,并增加直接的防纠缠监督,迫使每个嵌入只捕获一个原因。

####3.1 Causal Embedding

在本节中,我们首先描述每个交互数据是如何从兴趣和一致性中生成的因果模型。然后,我们为点击、兴趣和从众提供了**结构因果模型structural causal model (SCM)**和因果图,在此基础上,我们提出利用独立的嵌入来实现兴趣和从众,解决了第一个挑战——不同的从众。

每个交互数据是如何生成的? 用户对一个项目的点击记录主要反映两个方面:(1)用户对物品特征的兴趣,(2)用户对项目受欢迎程度的认同。点击可以来自两个方面中的一个或两个方面。我们提出了一个加法模型来描述每个点击记录是如何从兴趣和一致性中产生的。形式上,给定用户

u

u

u 和项目

i

i

i 的匹配分数如下获得:

S

u

i

=

S

u

i

i

n

t

e

r

e

s

t

+

S

u

i

c

o

n

f

o

r

m

i

t

y

S_{ui}=S_{ui}^{interest}+S_{ui}^{conformity}

Sui?=Suiinterest?+Suiconformity?

这里的

S

u

i

S_{ui}

Sui? 表示总体匹配分数,这里的

S

u

i

i

n

t

e

r

e

s

t

S_{ui}^{interest}

Suiinterest? 和

S

u

i

c

o

n

f

o

r

m

i

t

y

S_{ui}^{conformity}

Suiconformity?代表特定的因素.这种加性模型是合理的,因为用户在与推荐系统交互时倾向于既有特殊性又有一致性[31]。同时,加性模型在因果推理中被广泛采用,并在一系列应用中显示出有效性[38]。此外,相关文献[49]也采用了乘法模型,将点击概率分解为曝光概率和给定曝光的条件点击概率的乘积。然而,这种乘法模型从用户的角度纠缠了兴趣和从众,因为用户的从众在暴露的项目下仍然有效。值得注意的是,除了兴趣或从众之外,可能还有其他原因导致点击交互,但我们建议抓住这两个主要因素。同时,所提出的方法是一个通用框架,可以扩展到具有多种原因的场景。

SCM and causal graph for click, interest and conformity. 基于我们在(1)中提出的因果模型,我们现在提供我们提议的DICE框架的配置管理,

ζ

D

I

C

E

\zeta_{DICE}

ζDICE? ?, 连同图3(a)中的因果图:

X

u

i

i

n

t

:

=

f

1

(

u

,

i

,

N

i

n

t

)

,

X

u

i

c

o

n

:

=

f

2

(

u

,

i

,

N

c

o

n

)

,

Y

u

i

c

l

i

c

k

:

=

f

3

(

X

u

i

i

n

t

,

X

u

i

c

o

n

,

N

c

l

i

c

k

)

,

X_{ui}^{int} := f_{1}(u,i,N^{int}), \\X_{ui}^{con} :=f_{2}(u,i,N^{con}), \\Y_{ui}^{click} :=f_{3}(X_{ui}^{int},X_{ui}^{con},N^{click}),

Xuiint?:=f1?(u,i,Nint),Xuicon?:=f2?(u,i,Ncon),Yuiclick?:=f3?(Xuiint?,Xuicon?,Nclick),

这里的

N

i

n

t

,

N

c

o

n

,

N

c

l

i

c

k

N^{int},N^{con},N^{click}

Nint,Ncon,Nclick 是独立的噪声,SCM

ζ

D

I

C

E

\zeta_{DICE}

ζDICE? 表示了兴趣,一致性,点击的因果关系,

f

1

,

f

2

,

f

3

f_{1},f_{2},f_{3}

f1?,f2?,f3?分别地是兴趣,一致性和点击

X

i

n

t

,

X

c

o

n

,

Y

c

l

i

c

k

X^{int},X^{con},Y^{click}

Xint,Xcon,Yclick的潜在因果机制。实际上,这些因果机制是通过在给定的函数族[38]中进行优化来决定的,例如深度神经网络。当我们考虑对用户从众的干预时,我们简单地用预先指定的值替换

X

u

i

c

o

n

X_{ui}^{con}

Xuicon? 。

SCM ζ D I C E \zeta_{DICE} ζDICE? 在(2)中解释了如何从原因(兴趣和一致性)中产生效果(点击)的逻辑。然而,f1、f2和f3中函数族的具体形式仍有待确定。如前所述,不同用户对同一项目的一致性是不同的,同一用户对不同项目的一致性也是不同的。换句话说,从众既取决于用户和物品,也取决于兴趣。因此,f1和f2的函数族应该更好地支持这种兴趣和一致性的灵活性。我们现在介绍我们提出的使用独立嵌入的设计。

Separate embeddings for interest and conformity兴趣和一致性的独立嵌入 :在提出的DICE框架中,我们采用两组嵌入来分别捕获兴趣和从众,而不是像现有方法[4]那样使用标量流行度值,因为标量值不足以捕获用户从众的多样性。如图3(b)所示,每个用户都有一个兴趣嵌入

u

i

n

t

u^{int}

uint 和一个一致性嵌入

u

c

o

n

u^{con}

ucon ,每个项目也有两个原因的

i

i

n

t

i^{int}

iint 和

i

c

o

n

i^{con}

icon 。我们使用内积来计算两种原因的匹配分数。基于等式(1)中的加法因果模型,我们将来自相应原因的两个匹配分数相加,以总分数来估计用户是否会点击某个项目。因此,用户

u

u

u 和项目

i

i

i 的推荐分数公式为:

s

u

i

i

n

t

=

<

u

(

i

n

t

)

,

i

(

i

n

t

)

>

,

s

u

i

c

o

n

=

<

u

(

c

o

n

)

,

i

(

c

o

n

)

>

,

s

u

i

c

l

i

c

k

=

s

u

i

i

n

t

+

s

u

i

c

o

n

,

s_{ui}^{int} = <u^{(int)},i^{(int)}>, s_{ui}^{con} = <u^{(con)},i^{(con)}>, \\s_{ui}^{click} = s_{ui}^{int}+s_{ui}^{con},

suiint?=<u(int),i(int)>,suicon?=<u(con),i(con)>,suiclick?=suiint?+suicon?,

这里的

<

.

,

.

>

<.,.>

<.,.> 意味着两个嵌入的内积。图3(b)展示了兴趣嵌入和一致性嵌入的解纠结设计。从SCM的角度出发,我们将f1和f2的函数族限制为两组可学习嵌入之间的内积,并将f3设置为实践中常用的简洁加法模型[38]。通过在两个高维空间中进行优化,而不是像现有解决方案那样在一维空间中找到最佳标量值,在所提出的DICE框架中可以自动捕获用户一致性的多样性,因此我们解决了第一个挑战。

3.2 Disentangled Representation Learning 区分表征学习

在这一部分,我们详细阐述了我们的设计,以解开兴趣和从众这两个因果嵌入。我们建议用特定原因数据训练不同的嵌入,并将问题分解为一致性建模、兴趣建模、点击率估计和额外差异任务四个任务。

Mining Cause-specific Data挖掘特定于原因的数据。兴趣嵌入和从众嵌入的分离意味着每个嵌入只捕获一个因素,将第二个因素挤出到另一个嵌入中。为了实现这样的目标,一个普遍而合理的想法是用特定原因的数据来训练不同的嵌入。然而,我们只能获得效果,即观察性点击数据,但我们几乎不知道点击是由兴趣还是从众引起的。换句话说,等式(1)不足以恢复兴趣和一致性,因为当两个加数没有基本真理,只有求和可用时,它有无限的解。因此,我们从观察到的相互作用中进行探索,并发现特定原因的数据,这意味着这些相互作用很可能来源于个别原因。特定原因的数据为解开兴趣和从众这两个根本原因铺平了道路。

我们首先介绍几种符号。我们用

M

I

M^{I}

MI表示所有用户和项目的兴趣匹配分数矩阵,用

M

C

M^{C}

MC表示一致性匹配分数。

M

I

M^{I}

MI 和

M

C

M^{C}

MC 在

R

M

×

N

\mathbb{R^{M\times N}}

RM×N 之中,其中 M 和 N 是 用户和项目的数量。在图3(a)的因果图中,三个节点形成了一个不是我们期望的结果,点击是兴趣和一致性的碰撞体[37,38]。事实上,对撞机的两个原因是独立的变量。然而,如果我们把条件放在对撞机上,这两个原因就会相互关联,我们称之为对撞效应。例如,一个男人是否受欢迎既取决于他的外表,也取决于他的脾气。外表和脾气通常是独立的,受欢迎是外表和脾气的对撞机(外表→受欢迎←脾气)。给一个长得不好看的受欢迎的男,那么他脾气好的概率很大。同样,不受欢迎但长得好看的男人很可能脾气不好。因此,在我们解开兴趣和一致性的任务中,可以利用碰撞效应来获得大多数是由一个原因导致的样本。具体来说,我们强调

M

I

M^{I}

MI 和

M

C

M^{C}

MC 中的两种特殊情况,它们是特定于原因的:案例1:如果用户u点击热门商品a,而没有点击冷门商品b,那么我们不确定用户对a的兴趣是否强于b,因为用户对热门商品有从众心理。换句话说,点击可能来自第二个原因(从众)。同时,我们还可以得出结论,a的两个原因的总得分大于b。因此,在这种情况下,我们有两个不等式:

M

u

a

C

>

M

u

b

C

M

u

a

I

+

M

u

a

C

>

M

u

b

I

+

M

u

b

C

M_{ua}^{C}>M_{ub}^{C} \\M_{ua}^{I}+M_{ua}^{C}>M_{ub}^{I}+M_{ub}^{C}

MuaC?>MubC?MuaI?+MuaC?>MubI?+MubC?

案例2:negative item 比positive item 更受欢迎。然而,如果用户点击了不受欢迎的项目c,而没有点击受欢迎的项目d,那么碰撞效果可以带来更多的信息。因为c没有d那么受欢迎,d是从众的合理代表,所以点击c主要是因为用户的兴趣。因此,在这种情况下,我们有三个不等式,与前一种情况相比,在兴趣上有一个额外的不等式:

M

u

c

I

>

M

u

d

I

,

M

u

c

C

<

M

u

d

C

,

M

u

c

I

+

M

u

c

C

>

M

u

d

I

+

M

u

d

C

M_{uc}^{I}>M_{ud}^{I},M_{uc}^{C}<M_{ud}^{C}, \\M_{uc}^{I}+M_{uc}^{C}>M_{ud}^{I}+M_{ud}^{C}

MucI?>MudI?,MucC?<MudC?,MucI?+MucC?>MudI?+MudC?

我们用O表示所有的训练实例,分为O1和O2。具体来说,O1表示negative样本不如positive样本受欢迎的情况,O2表示相反的情况。相应地,O1包含案例1中不等式(4)成立的数据,因此O1可以用来学习一致性和点击。O2包含符合案例2的数据,因此可以利用它来学习兴趣、一致性和点击。

通过将一个等式推广到多个不等式,我们将问题从学习绝对值转化为学习相对关系,使得理清兴趣和一致性的任务得以解决。具体来说,基于这些导出的不等式,我们获得了主要由一个特定原因导致的用户-项目交互,并利用这些交互来优化相应的嵌入。以著名的推荐矩阵分解算法为例,通常我们优化一个用户嵌入矩阵和一个项目嵌入矩阵来最好地回归原始交互矩阵,比如 M c l i c k M^{click} Mclick .这种经典方法将所有可能的原因统一为一个用户或项目的捆绑表示,因此不同的原因纠缠在一起,导致在non-IID环境下鲁棒性和可解释性较差,这在推荐系统中很常见。

此外,像IPS这样的debias算法不能完全解决这个问题,因为它们仍然采用统一的表示。与现有方法相反,我们首先将原始点击矩阵 M c l i c k M^{click} Mclick 分解为两个特定原因矩阵, M I M^{I} MI 和 M C M^{C} MC ,分别用于兴趣和一致性。然后采用两组嵌入,分别捕捉兴趣和从众,并进一步组合回归点击。不同的原因因此被解开,这在干预下实现了更好的鲁棒性。我们现在介绍我们的因果学习方法。

利用特定原因数据集O1和O2,将兴趣和一致性分开建模是可能的。同时,我们提出结合两个原因来估计点击行为,这是推荐的主要任务。此外,我们进一步增加了一个差异任务,以使两组嵌入相互独立,这增强了解纠缠。因此,我们将兴趣和一致性问题分解为一致性建模、兴趣建模、点击率估计和差异任务四个任务。我们利用BPR [39]来模拟(4)和(5)中的成对数量关系。每个positive样本与一定数量的negative样本配对,每个训练实例是包含用户ID、positive项目ID和negative项目ID的三元组 ( u , I , j ) (u,I,j) (u,I,j) 。我们现在按顺序介绍这四项任务。

Conformity Modeling 对于O1和O2中的实例,我们有一致性建模的不等式,这是

M

C

M^{C}

MC 的不等式。注意,在这两种情况下,不等式的方向是不同的。我们使用这些特定于一致性的数据来优化一致性嵌入。利用BPR损失函数对具有一致性嵌入的

M

C

M^{C}

MC 进 行回归。因此,一致性建模的损失函数公式如下:

L

c

o

n

f

o

r

m

i

t

y

O

1

=

∑

(

u

,

i

,

j

)

∈

O

1

B

P

R

(

<

u

(

c

o

n

)

,

i

(

c

o

n

)

>

,

<

u

(

c

o

n

)

,

j

(

c

o

n

)

>

)

,

L

c

o

n

f

o

r

m

i

t

y

O

2

=

∑

(

u

,

i

,

j

)

∈

O

2

?

B

P

R

(

<

u

(

c

o

n

)

,

i

(

c

o

n

)

>

,

<

u

(

c

o

n

)

,

j

(

c

o

n

)

>

)

,

L

c

o

n

f

o

r

m

i

t

y

O

1

+

O

2

=

L

c

o

n

f

o

r

m

i

t

y

O

1

+

L

c

o

n

f

o

r

m

i

t

y

O

2

L_{conformity}^{O_{1}} = \sum_{(u,i,j)\in O_{1}}BPR(<u^{(con)},i^{(con)}>,<u^{(con)},j^{(con)}>), \\L_{conformity}^{O_{2}} = \sum_{(u,i,j)\in O_{2}}-BPR(<u^{(con)},i^{(con)}>,<u^{(con)},j^{(con)}>), \\L_{conformity}^{O_{1}+{O_{2}}} = L_{conformity}^{O_{1}}+L_{conformity}^{O_{2}}

LconformityO1??=(u,i,j)∈O1?∑?BPR(<u(con),i(con)>,<u(con),j(con)>),LconformityO2??=(u,i,j)∈O2?∑??BPR(<u(con),i(con)>,<u(con),j(con)>),LconformityO1?+O2??=LconformityO1??+LconformityO2??

Interest Modeling 在O2中,negative项目比positive面项目更受欢迎,这些互动很大程度上是由于用户的兴趣。这些数据是特定于兴趣的,我们有兴趣建模的不等式。我们还使用BPR来优化兴趣嵌入,以学习这种成对偏好,从而回归

M

I

M^{I}

MI .损失函数仅在O2情况下生效:

L

i

n

t

e

r

e

s

t

O

2

?

=

?

∑

(

u

,

i

,

j

)

∈

O

2

?

B

P

R

(

<

u

(

i

n

t

)

,

i

(

i

n

t

)

>

,

<

u

(

i

n

t

)

,

j

(

i

n

t

)

>

)

L_{interest}^{O_{2}}\ =\ \sum_{(u,i,j)\in O_{2}}\ BPR(<u^{(int)},i^{(int)}>,<u^{(int)},j^{(int)}>)

LinterestO2???=?(u,i,j)∈O2?∑??BPR(<u(int),i(int)>,<u(int),j(int)>)

Estimating Clicks点击估计 这是推荐系统的主要目标,我们结合(3)中介绍的两个原因来估计点击量,并使用一个简洁的加法模型。对于训练集O中的每个实例,即O1和O2的并集,我们使用BPR来最大化positive项和negative项得分之间的差值,从而回归

M

c

l

i

c

k

M^{click}

Mclick 。因此,点击估计的损失函数公式如下:

L

c

l

i

c

k

O

1

+

O

2

=

∑

(

u

,

i

,

j

)

∈

O

B

P

R

(

<

u

t

,

i

t

>

,

<

u

t

,

j

t

>

)

L_{click}^{O_{1}+O_{2}}=\sum_{(u,i,j)\in O}BPR(<u^{t},i^{t}>,<u^{t},j^{t}>)

LclickO1?+O2??=(u,i,j)∈O∑?BPR(<ut,it>,<ut,jt>)

u

t

u^{t}

ut?、

i

t

i^{t}

it?和

j

t

j^{t}

jt??是用户和项目的兴趣嵌入和一致性嵌入的串联:

u

t

=

u

(

i

n

t

)

∣

∣

u

(

c

o

n

)

,

i

t

=

i

(

i

n

t

)

∣

∣

i

(

c

o

n

)

,

j

t

=

j

(

i

n

t

)

∣

∣

j

(

c

o

n

)

u^{t}=u^{(int)}||u^{(con)},i^{t}=i^{(int)}||i^{(con)},j^{t}=j^{(int)}||j^{(con)}

ut=u(int)∣∣u(con),it=i(int)∣∣i(con),jt=j(int)∣∣j(con)

其中 || 表示两个嵌入的连接。为了简单起见,我们在这里使用串联形式,它相当于(3)中的求和形式。BPR的loss推动positive项目I的推荐分数高于negative项目j。兴趣建模和一致性建模通过用不同的原因特定数据训练不同的嵌入来区分开这两个原因。与此同时,估算点击量的主要任务也强化了这种作为一种约束的分离。例如,就negative item j比positivr item I更受欢迎的训练实例(u,I,j)而言,兴趣建模任务迫使两组嵌入学习用户u对I的兴趣大于j,而一致性建模任务迫使他们学习用户u对项I’的从众小于j。与此同时,估算点击量迫使他们了解到I的整体力量大于j。因此,模型真正学到的是,I相对于j在兴趣方面的优势支配着一致性方面的劣势,这可以通过用一个嵌入只捕获一个原因来最好地学习。

Discrepancy Task 差异任务 除了上述三项任务,即通过用特定原因的数据优化不同的嵌入来区分兴趣和一致性,我们还对嵌入分布进行直接监督,以加强这种解开。假设 E ( i n t ) E^{(int)} E(int)和 E ( c o n ) E^{(con)} E(con) 代表所有用户和项目的两组嵌入。我们研究了三个候选的差异损失函数,分别是 L1-inv,L2-inv 和距离相关distance correlation(dCor)。L1-inv和L2-inv分别最大化了 E ( i n t ) E^{(int)} E(int)和 E ( c o n ) E^{(con)} E(con)之间的L1和L2距离。有关dCor的详细信息,请参考[45,46]。从高层次来看,dCor是一个更合理的选择,因为它关注的是兴趣嵌入和一致性嵌入之间成对距离的相关性。差异损失函数的三个选项是

? L 1 ( E ( i n t ) , E ( c o n ) ) -L1(E^{(int)},E^{(con)}) ?L1(E(int),E(con))?? , ? L 2 ( E ( i n t ) , E ( c o n ) ) -L2(E^{(int)},E^{(con)}) ?L2(E(int),E(con))??? and d C o r ( E ( i n t ) , E ( c o n ) ) dCor(E^{(int)},E^{(con)}) dCor(E(int),E(con))? .我们将在实验中比较它们。

图3(b)说明了四个分解的任务,使用了分离的嵌入来实现兴趣和一致性。通过用特定于原因的数据训练不同的嵌入,并对嵌入分布施加直接监督,我们解决了学习解纠缠表示的第二个挑战。

3.3 Multi-task Curriculum Learning

在提出的框架中,我们克服了最后一个挑战,即通过多任务课程学习来聚集兴趣和一致性。具体来说,我们同时用上述四个任务训练因果嵌入,并将这些损失函数组合在一起:

L

=

L

c

l

i

c

k

O

1

+

O

2

+

α

(

L

i

n

t

e

r

e

s

t

O

2

+

L

c

o

n

f

o

r

m

i

t

y

O

1

+

O

2

)

+

β

L

d

i

s

c

r

e

p

a

n

c

y

.

L=L_{click}^{O_{1}+O_{2}}+\alpha(L_{interest}^{O_{2}}+L_{conformity}^{O_{1}+O_{2}})+\beta L_{discrepancy}.

L=LclickO1?+O2??+α(LinterestO2??+LconformityO1?+O2??)+βLdiscrepancy?.

因为估计点击量是推荐的主要任务,所以从直觉上来说,

α

\alpha

α 和

β

\beta

β 应该小于1。同时,差异任务直接影响嵌入的分布,因此过大的

β

\beta

β 会对兴趣和一致性建模产生负面影响。

如前所述,当 negative样本比 positive 样本不受欢迎或更受欢迎时,我们分别得到两个或三个不等式。请注意,当受欢迎程度差距足够大时,这些不等式将会成立。我们使用Margin (PNSM)开发了基于流行度的负抽样来保证这些数量关系。具体来说,如果positive样本的受欢迎程度是 p p p,那么我们将从受欢迎程度大于 p + m u p p +m_{up} p+mup? 或低于 p ? m d o w n p- m_{down} p?mdown? 的项目中抽取负实例,其中 m u p m_{up} mup? 和 m d o w n m_{down} mdown? 是正边距值。通过对具有流行度边际的negative项目进行抽样,我们获得了对因果模型的高度自信。随后的实验表明,基于流行度的负采样对于学习解纠缠和鲁棒的表示是至关重要的。

受到课程学习的启发[7],我们在训练DICE时采用了一种由易到难的策略,即在保证margin值和损失权重上增加衰减。具体来说,当margin 值 m u p m_{up} mup? 和 m d o w n m_{down} mdown? 较大时,我们对兴趣和一致性建模的不等式有很高的信心,这意味着任务更容易,我们为 L i n t e r e s t L_{interest} Linterest? 和 L c o n f o r m i t y L_{conformity} Lconformity? 设置了高损失权重 α \alpha α 。

当我们训练模型时,我们通过衰减margin值以及每个时期后的损失权重a,将难度增加0.9倍。通过课程学习,所提出的方法对于高置信度样本学习更强的解纠缠。此外,这种自适应设计还使得所提出的方法对超参数初始值不敏感。我们将在实验中比较课程学习和正常学习的表现。兴趣和从众通过多任务课程学习完美的聚集在一起,因此最后一个挑战得到了解决。

总之,我们提出了一个关于用户兴趣和从众的加性因果模型。基于SCM ζ D I C E \zeta_{DICE} ζDICE? ,我们为个体原因开发了单独的因果嵌入,它捕捉了从众和兴趣的多样性。从我们的因果模型中导出了一系列不等式,将因果学习任务分解为一致性建模、兴趣建模、点击率估计和差异任务。通过用特定原因的数据训练不同的嵌入,可以获得潜在原因的解纠缠表示。为了获得强有力的推荐,采用了多任务课程学习来汇总这两个原因。同时,我们的因果框架是基于数据是如何生成的,因此它们的模型是独立的。因此,所提出的DICE方法为解开用户兴趣和一致性提供了一个高度通用的框架,可以平滑地集成到现有的推荐模型中。在我们的实验中,我们成功地在基于图卷积网络的最先进推荐系统的基础上开发了DICE。

4 EXPERIMENTS

5 RELATED WORK

6 CONCLUSION AND FUTURE WORK

在这篇文章中,我们提出了一个通用的框架来解开用户兴趣和一致性的因果嵌入推荐。我们开发了一个简洁的可加因果模型,并用因果图和供应链管理来表示这个模型。根据提议的供应链管理,为了兴趣和一致性,采用了单独的嵌入。我们从观察的相互作用中提取特定原因的数据,并用不同的特定原因的数据训练不同的嵌入,以实现兴趣和一致性之间的分离。这两个原因通过多任务课程学习得以聚合和平衡。基于简洁合理的因果模型,DICE的性能始终优于最先进的算法,并有显著的改进。实验表明,与其他基线相比,DICE在non-IID环境下更稳健。对解纠结的分析表明,在两组嵌入中,用户兴趣和整合在很大程度上是独立的。学习嵌入具有高质量和可解释性,这有望利用学习解纠缠表示来探索新的应用。

DICE将每次点击互动分解为两个原因,兴趣和从众。未来工作的一个特别有意义的方向是扩展DICE以包括更精细的原因层次。例如,宏观层面的原因兴趣可以进一步分为微观层面的原因,如对品牌、价格或商品颜色的意向。总的来说,我们认为解开兴趣和整合为理解推荐系统的用户-项目交互打开了新的大门。

ACKNOWLEDGMENTS

本工作得到了国家重点研发计划项目2020AAA0106000、国家自然科学基金项目U1936217、61971267、61972223、61941117、61861136003、U19A2079的部分资助。

探索新的应用。

DICE将每次点击互动分解为两个原因,兴趣和从众。未来工作的一个特别有意义的方向是扩展DICE以包括更精细的原因层次。例如,宏观层面的原因兴趣可以进一步分为微观层面的原因,如对品牌、价格或商品颜色的意向。总的来说,我们认为解开兴趣和整合为理解推荐系统的用户-项目交互打开了新的大门。

ACKNOWLEDGMENTS

本工作得到了国家重点研发计划项目2020AAA0106000、国家自然科学基金项目U1936217、61971267、61972223、61941117、61861136003、U19A2079的部分资助。