组队学习资料:https://github.com/datawhalechina/Learn-NLP-with-Transformers

?

1.1 seq2seq

应用:机器翻译、文本摘要、图像描述生成

论文:

https://papers.nips.cc/paper/2014/file/a14ac55a4f27472c5d894ec1c3c743d2-Paper.pdf

http://emnlp2014.org/papers/pdf/EMNLP2014179.pdf

接收的输入是一个(单词、字母、图像特征)序列,输出是另外一个序列

组成:Encoder & Decoder

过程:input seq -- encoder -- context -- decoder -- output seq (同样适用于机器翻译)

你可以在编写seq2seq模型的时候设置上下文向量的长度。这个长度是基于编码器 RNN 的隐藏层神经元的数量。上图展示了长度为 4 的向量,但在实际应用中,上下文向量的长度可能是 256,512 或者 1024。

如何把每个单词都转化为一个向量呢?我们使用一类称为 "word embedding" 的方法。我们可以使用预训练好的 embeddings,或者在我们的数据集上训练自己的 embedding。通常 embedding 向量大小是 200 或者 300。

回顾RNN模型

RNN 在第 2 个时间步,采用第 1 个时间步的 hidden state(隐藏层状态) 和第 2 个时间步的输入向量,来得到输出。在下文,我们会使用类似这种动画,来描述神经机器翻译模型里的所有向量。

编码器和解码器在每个时间步处理输入,并得到输出。由于编码器和解码器都是 RNN,RNN 会根据当前时间步的输入,和前一个时间步的 hidden state(隐藏层状态),更新当前时间步的 hidden state(隐藏层状态)。

让我们看下编码器的 hidden state(隐藏层状态)。注意,最后一个 hidden state(隐藏层状态)实际上是我们传给解码器的上下文(context)。

1.2 Attention

问题:上下文context向量,长文本挑战

解决论文:

https://arxiv.org/abs/1409.0473

https://arxiv.org/abs/1508.04025

Difference:

编码器会把更多的数据传递给解码器。编码器把所有时间步的 hidden state(隐藏层状态)传递给解码器,而不是只传递最后一个 hidden state(隐藏层状态) ;

注意力模型的解码器在产生输出之前,做了一个额外的处理。为了把注意力集中在与该时间步相关的输入部分。解码器做了如下的处理:

- 查看所有接收到的编码器的 hidden state(隐藏层状态)。其中,编码器中每个 hidden state(隐藏层状态)都对应到输入句子中一个单词。

- 给每个 hidden state(隐藏层状态)一个分数(我们先忽略这个分数的计算过程)。

- 将每个 hidden state(隐藏层状态)乘以经过 softmax 的对应的分数,从而,高分对应的 hidden state(隐藏层状态)会被放大,而低分对应的 hidden state(隐藏层状态)会被缩小

注意力模型的整个过程:

- 注意力模型的解码器 RNN 的输入包括:一个embedding 向量,和一个初始化好的解码器 hidden state(隐藏层状态)。

- RNN 处理上述的 2 个输入,产生一个输出和一个新的 hidden state(隐藏层状态 h4 向量),其中输出会被忽略。

- 注意力的步骤:我们使用编码器的 hidden state(隐藏层状态)和 h4 向量来计算这个时间步的上下文向量(C4)。

- 我们把 h4 和 C4 拼接起来,得到一个向量。

- 我们把这个向量输入一个前馈神经网络(这个网络是和整个模型一起训练的)。

- 前馈神经网络的输出的输出表示这个时间步输出的单词。

- 在下一个时间步重复这个步骤。

2.Transformer

2.1 结构解析

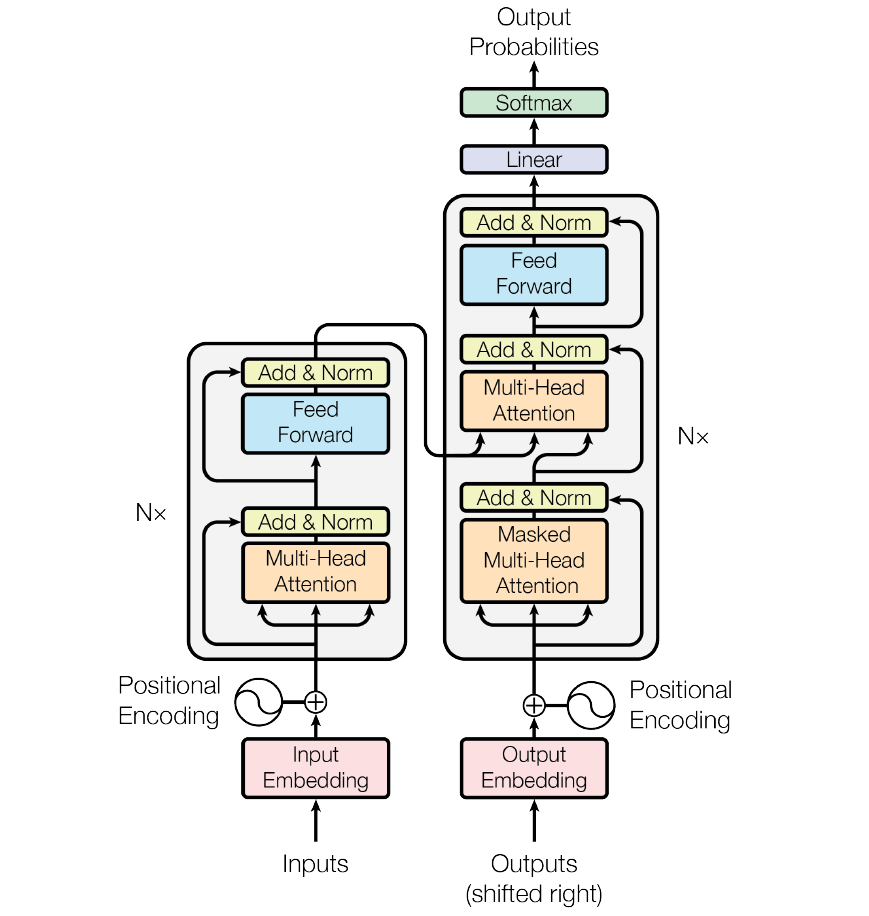

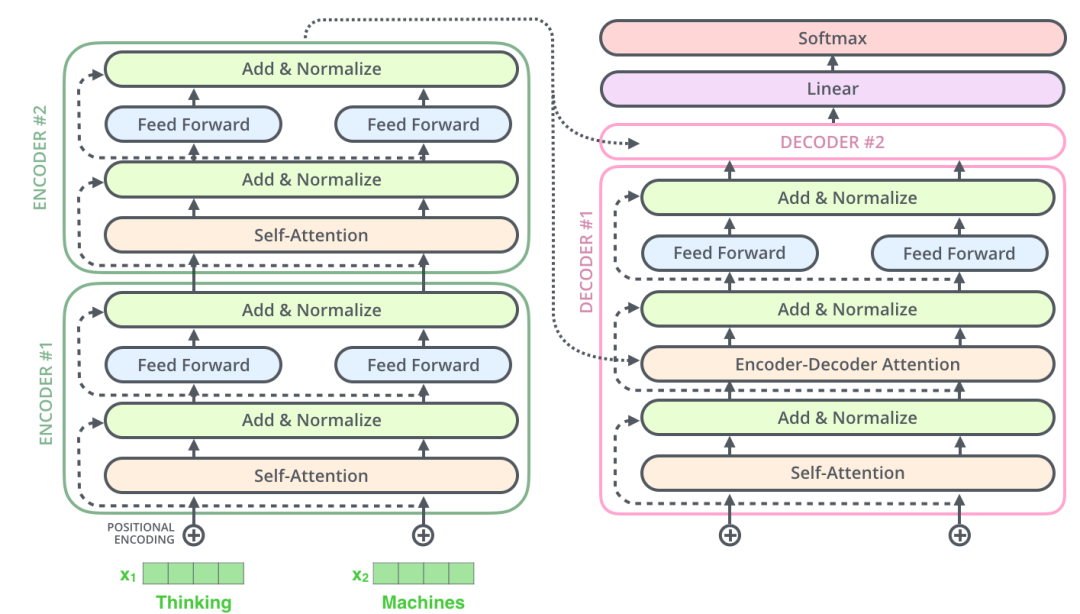

2017 年,Google 提出了 Transformer 模型,用 Self Attention 的结构,取代了以往 NLP 任务中的 RNN 网络结构,在 WMT 2014 Englishto-German 和 WMT 2014 English-to-French两个机器翻译任务上都取得了当时 SOTA 的效果。

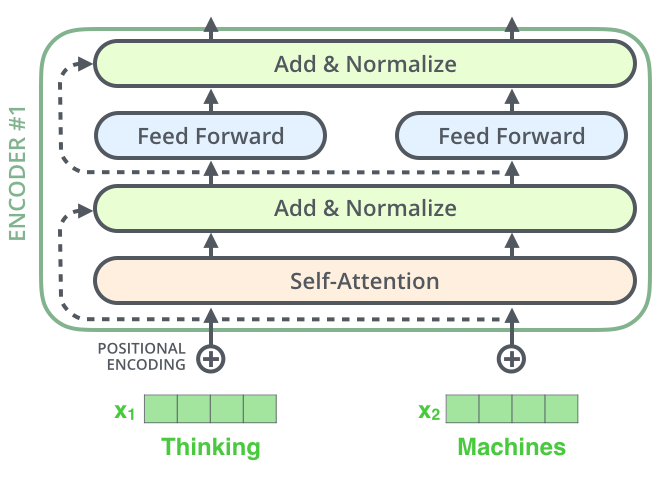

Encoder: 6层编码器(层数是超参,可以修改),每层编码器在结构上都是一样的,但不同层编码器的权重参数是不同的。

每层的结构:

- Self-Attention Layer:这个层处理一个词的时候,不仅会使用这个词本身的信息,也会使用句子中其他词的信息

- Feed Forward Neural Network(前馈神经网络,缩写为 FFNN)

Decoder:6层解码器

每层的结构中间还插入encoder-decoder attention层

2.2 输入

输入:词嵌入算法(embedding algorithm),将每个词转换为一个词向量。实际中向量一般是 256 或者 512 维。在实际中,每个句子的长度不一样,我们会取一个适当的值,作为向量列表的长度。如果一个句子达不到这个长度,那么就填充全为 0 的词向量;如果句子超出这个长度,则做截断。句子长度是一个超参数,通常是训练集中的句子的最大长度,你可以尝试不同长度的效果。

?2.3 self-attention

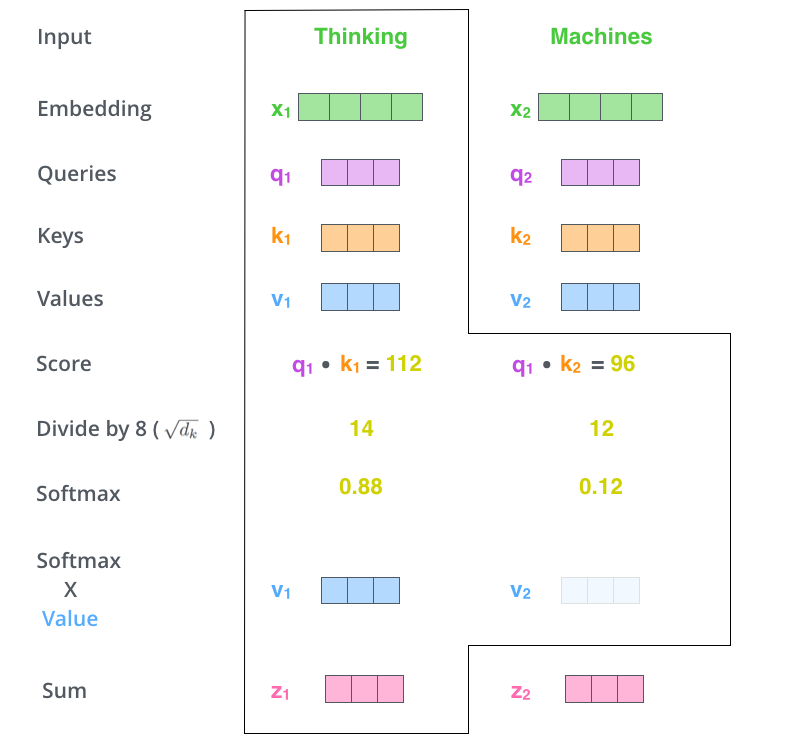

1. 计算Query向量,Key向量,Value向量

对输入编码器的每个词向量,都创建 3 个向量,分别是:Query 向量,Key 向量,Value 向量。这 3 个向量是词向量分别和 3 个矩阵相乘得到的,而这个矩阵是我们要学习的参数。这 3 个新得到的向量一般比原来的词向量的长度更小。

2. 计算Attention Score

单个位置的注意力分数计算,但实际操作上是利用矩阵计算

矩阵计算如下:

2.4 multi-head attention?

一组注意力为一个attention head,多头注意力机制可以进一步完善self attention层,主要在如下两个方面:它扩展了模型关注不同位置的能力。多头注意力机制赋予 attention 层多个“子表示空间”。

2.5?代码实现

Pytorch提供多头注意力集成的包

torch.nn.MultiheadAttention(embed_dim, num_heads, dropout=0.0, bias=True, add_bias_kv=False, add_zero_attn=False, kdim=None, vdim=None)参数说明如下:

-

embed_dim:最终输出的 K、Q、V 矩阵的维度,这个维度需要和词向量的维度一样

-

num_heads:设置多头注意力的数量。如果设置为 1,那么只使用一组注意力。如果设置为其他数值,那么 - - num_heads 的值需要能够被 embed_dim 整除

-

dropout:这个 dropout 加在 attention score 后面

?定义对象后,调用时传入的参数如下:

forward(query, key, value, key_padding_mask=None, need_weights=True, attn_mask=None)?解码步骤:

## nn.MultiheadAttention 输入第0维为length

# batch_size 为 64,有 12 个词,每个词的 Query 向量是 300 维

query = torch.rand(12,64,300)

# batch_size 为 64,有 10 个词,每个词的 Key 向量是 300 维

key = torch.rand(10,64,300)

# batch_size 为 64,有 10 个词,每个词的 Value 向量是 300 维

value= torch.rand(10,64,300)

embed_dim = 299

num_heads = 1

# 输出是 (attn_output, attn_output_weights)

multihead_attn = nn.MultiheadAttention(embed_dim, num_heads)

attn_output = multihead_attn(query, key, value)[0]

# output: torch.Size([12, 64, 300])

# batch_size 为 64,有 12 个词,每个词的向量是 300 维

print(attn_output.shape)2.6 位置编码

为了解决这个问题,Transformer 模型对每个输入的向量都添加了一个向量。这些向量遵循模型学习到的特定模式,有助于确定每个单词的位置,或者句子中不同单词之间的距离。这种做法背后的直觉是:将这些表示位置的向量添加到词向量中,得到了新的向量,这些新向量映射到 Q/K/V,然后计算点积得到 attention 时,可以提供有意义的信息。

2.7 残差链接

编码器结构中有一个需要注意的细节是:编码器的每个子层(Self Attention 层和 FFNN)都有一个残差连接和层标准化(layer-normalization)。

在解码器的子层里面也有层标准化(layer-normalization)。假设一个 Transformer 是由 2 层编码器和两层解码器组成的,如下图所示。

2.8 Decoder

在完成了编码(encoding)阶段之后,我们开始解码(decoding)阶段。解码(decoding )阶段的每一个时间步都输出一个翻译后的单词(这里的例子是英语翻译)。

接下来会重复这个过程,直到输出一个结束符,Transformer 就完成了所有的输出。每一步的输出都会在下一个时间步输入到下面的第一个解码器。Decoder 就像 Encoder 那样,从下往上一层一层地输出结果。正对如编码器的输入所做的处理,我们把解码器的输入向量,也加上位置编码向量,来指示每个词的位置。

解码器中的 Self Attention 层,和编码器中的 Self Attention 层不太一样:在解码器里,Self Attention 层只允许关注到输出序列中早于当前位置之前的单词。具体做法是:在 Self Attention 分数经过 Softmax 层之前,屏蔽当前位置之后的那些位置。

Encoder-Decoder Attention层的原理和多头注意力(multiheaded Self Attention)机制类似,不同之处是:Encoder-Decoder Attention层是使用前一层的输出来构造 Query 矩阵,而 Key 矩阵和 Value 矩阵来自于解码器最终的输出。

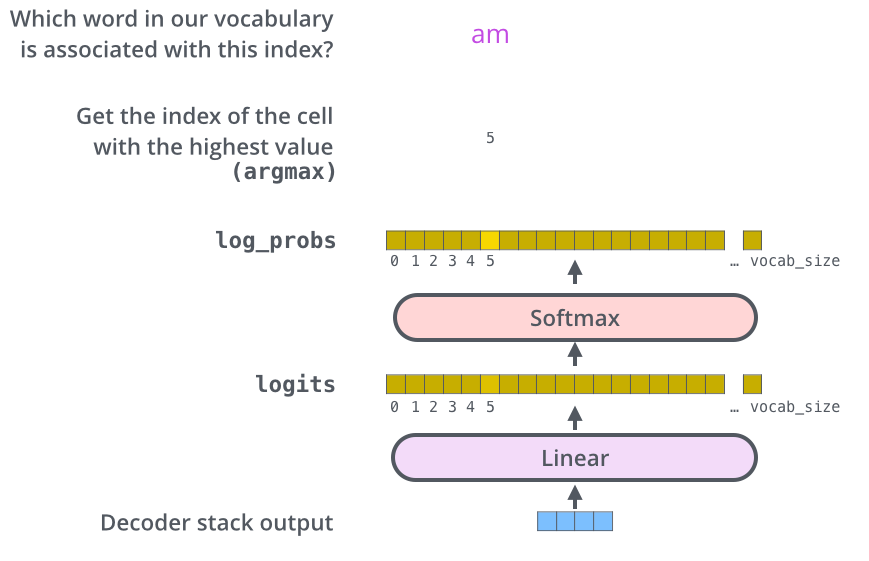

2.9 线性层和Softmax层

Decoder 最终的输出是一个向量,其中每个元素是浮点数。我们怎么把这个向量转换为单词呢?这是由 Softmax 层后面的线性层来完成的。

线性层就是一个普通的全连接神经网络,可以把解码器输出的向量,映射到一个更长的向量,这个向量称为 logits 向量。

现在假设我们的模型有 10000 个英语单词(模型的输出词汇表),这些单词是从训练集中学到的。因此 logits 向量有 10000 个数字,每个数表示一个单词的分数。我们就是这样去理解线性层的输出。

然后,Softmax 层会把这些分数转换为概率(把所有的分数转换为正数,并且加起来等于 1)。然后选择最高概率的那个数字对应的词,就是这个时间步的输出单词。