Combining Word and Entity Embeddings for Entity Linking

论文地址:https://perso.limsi.fr/bg/fichiers/2017/combining-word-entity-eswc2017.pdf (ESWC 2017)

1 Abstract

论文针对 EL 的第二个阶段 candidate selection 提出了新的方法——在同一空间中,联合学习文本中的 word 和知识库 entity 的嵌入表示。 candiadate selection 是从候选实体中选出最优实体

作者提出该方法的优势有以下三点:

- word embedding 更靠谱,因为在训练时它的上下文可能会包含语义向量,而非以往浅层的词语排列

- entity embedding 是在大规模文本语料库上学习的,这比只在知识库上学习 embedding 在训练时,能有更高的出现频率。

- 由于是在同一个空间学习的 embedding,所以可以使用简单的相似度来计算 mention context 和 entity entry 之间的距离

论文的贡献主要有以下几点

- EAT 模型联合学习单词和实体嵌入;

- 一个整合 EAT 模型的全局实体链接 pipeline;

- 使用 TAC 2015 “Entity Discovery and Linking” 对模型进行评估。结果 P ( a l l ) = 0.742 P(all) =0.742 P(all)=0.742 优于 non-EAT baseline。

2 Combining Word and Entity Embedding

2.1 Extended Anchor Text

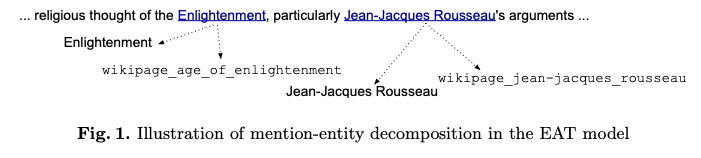

为了将 word embedding 和 entity embedding 包含在同一个空间中,作者引入了扩展锚文本 EAT 的概念。EAT 就是将锚文本 a i = ( w i , e j ) a_i = (w_i, e_j) ai?=(wi?,ej?) 替换成 a i ′ = ( w i ′ , e j ) a_{i}^{'} = (w_{i}^{'}, e_j) ai′?=(wi′?,ej?) 当 w i w_i wi? 不为空时, w i ′ = w i w_{i}^{'} = w_i wi′?=wi? 否则, w i ′ w_{i}^{'} wi′? 就是 e j e_j ej? 中词语构成的集合。句子中的 EAT 示例如下图所示:

2.2 The EAT Model

引入 EAT 模型的目标是:在同一个向量空间中表示 word 和 entity 的嵌入表示, 类似于 word2vec 中的设置,作者定义了语料库中两个元素之间的条件概率,如下式:

p

(

c

o

∣

c

i

)

=

∑

f

o

∈

c

o

∑

f

i

∈

c

i

e

x

p

(

f

o

T

f

i

)

∑

j

=

1

∣

F

∣

e

x

p

(

f

j

T

f

i

)

p(c_o | c_i) = \sum_{f_o \in c_o} \sum_{f_i \in c_i} \frac{exp(f_o^T f_i)}{\sum_{j=1}^{|\mathbb F|}exp(f_j^Tf_i)}

p(co?∣ci?)=fo?∈co?∑?fi?∈ci?∑?∑j=1∣F∣?exp(fjT?fi?)exp(foT?fi?)?

其中,f 表示 word 或 entity 的向量表示; c 表示语料库中的 word 序列或 EAT;

当 c c c 是一个 word 时,上面的式子就与 word2vec 完全相同了,因此通过 EAT 模型进行 word 和 entity 的表示学习只需要调整语料库即可,以下图中的例子说明:

这样在扩展的语料库上,直接用 skip-gram 或 CBOW 就可以进行 word 和 entity 的表示学习了。

3 Entity Linking System

3.1 Generation of Candidate Entities

作者使用了启发式方法 mention 进行扩展,在文档中找到与 mention 相近的变体形式,规则如下:

- 如果 mention 是首字母缩写,那么查找文档中其他的 mention,要求实体类型相同,且首字母与其匹配

- 在文档中查找当前 mention 作为其子串的其他 mention

然后作者使用以下策略生成候选实体:(以下 mention 表示本来的 mention 和上一步得到的变体形式)

- mention 与 entity 形式相同

- mention 与 entity 的变体(翻译、别名)相同

- mention 是 entity name 的子串

- 根据 Levenshtein 距离计算相似度,小于 k (取为 3) 的 entity;为了提高效率,作者使用了 BK-tree

- 使用信息检索模型:tf-idf 特征,Lucene 作为搜索引擎

3.2 Selection of the Best Candidate Entity

该步骤是从 candidate 集合中选出最优的 entity 作为最终的链接目标,作者设计了四种特征,作为candidate 和 mention 的相似度度量,如下所示:

- candidate generation 阶段的特征集合,如简单匹配策略的二元特征、信息检索模型的相似度等

- mention context 和 entity context 之间的两个文本相似度特征(Textual similarity scores)

- Wikipedia 中 mention 和 entity 之间的链接计数(使用 log 归一化)

- EAT embedding 的四个相似度分数(Similarity scores based on EAT embeddings)

Textual similarity scores

mention 记为

q

q

q ; entity candidate 记为

e

e

e ;定义三种文本如下:

q

q

q 出现的文档记为

d

(

q

)

d(q)

d(q),与

e

e

e 对应的 Wikipedia 页面为

w

(

e

)

w(e)

w(e) ,知识库中与

e

e

e 有关系的实体集合

r

(

e

)

r(e)

r(e) ;使用 tf-idf 计算出这三种文本的向量表示,例如:

d

(

q

)

=

(

d

1

,

.

.

.

,

d

n

)

d(q) = (d1, . . . , dn)

d(q)=(d1,...,dn) 其中

d

i

=

t

f

(

t

i

,

d

)

×

i

d

f

(

t

i

)

di =tf(ti,d)×idf(ti)

di=tf(ti,d)×idf(ti) ;文本相似度得分如下:

s

i

m

d

(

q

,

e

)

=

c

o

s

(

d

(

q

)

,

w

(

e

)

)

s

i

m

r

(

q

,

e

)

=

c

o

s

(

d

(

q

)

,

r

(

e

)

)

sim_d(q,e) = cos(d(q), w(e))\\ sim_r(q,e) = cos(d(q), r(e))

simd?(q,e)=cos(d(q),w(e))simr?(q,e)=cos(d(q),r(e))

Similarity scores based on EAT embeddings

E A T 1 ( e , p ( q ) ) = ∑ w i ∈ p ( q ) cos ? ( e , w i ) ∥ p ( q ) ∥ E A T 2 ( e , p ( q ) ) = cos ? ( e , ∑ w i ∈ p ( q ) w i ∥ p ( q ) ∥ ) EAT_{1}(e, p(q))=\frac{\sum_{w_{i} \in p(q)} \cos \left(\boldsymbol{e}, \boldsymbol{w}_{i}\right)}{\|p(q)\|} \quad EAT_{2}(e, p(q))=\cos \left(\boldsymbol{e}, \frac{\sum_{w_{i} \in p(q)} \boldsymbol{w}_{i}}{\|p(q)\|}\right) EAT1?(e,p(q))=∥p(q)∥∑wi?∈p(q)?cos(e,wi?)?EAT2?(e,p(q))=cos(e,∥p(q)∥∑wi?∈p(q)?wi??)

E A T 3 ( e , p ( q ) ) = ∑ argmax ? w i ∈ p ( q ) ; i = 1 … k cos ? ( e , w i ) k E A T 4 ( e , w m ) = cos ? ( e , w m ) EAT_{3}(e, p(q))=\frac{\sum \operatorname{argmax}_{w_{i} \in p(q); i=1 \ldots k} \cos \left(\boldsymbol{e}, \boldsymbol{w}_{i}\right)}{k} \quad E A T_{4}\left(e, w_{m}\right)=\cos \left(\boldsymbol{e}, \boldsymbol{w}_{m}\right) EAT3?(e,p(q))=k∑argmaxwi?∈p(q);i=1…k?cos(e,wi?)?EAT4?(e,wm?)=cos(e,wm?)

其中 p ( q ) p(q) p(q) 指 q q q 的上句、当前句、下句;粗体表示 embedding; E A T 3 EAT_3 EAT3? 表示最相似的前 k 个词语的相似度均值。作者将 k 取为 3。

Classifier trained for candidate selection

训练一个二分类器判断是否为正确的 entity;训练的正样本为 mention-correct entity;训练的负样本为错误 candidate,但是由于正负样本分布很不平衡,所以用下采样的方法将负样本限制为正样本的十倍。

作者将没有 candidate generation和所有 candidate 都被分类器拒绝的mention视为NIL。

作者尝试了几种二分类器,最终选择 Adaboost 结合决策树的模型。