1.解决的问题

Knowing how to grasp is generally more challenging than what to grasp for a robot.

从单视角点云规划抓取的挑战性在于模型需要对RGB-D感知的不精确和不完整进行补偿。

GPD方法在物体CAD模型未知的情况下直接从RGB-D传感信息中检测3DoF或6DoF抓取位姿,取得了很好的效果,而且在未知物体抓取上有很好的泛化性。与GPD抓取任意(any)物体不同的是,本文聚焦于物体操作任务中任务导向(task-specific, goal-oriented)的抓取。为了推理任务需求和满足特定任务约束,一个抓取规划器需要从物体功用属性中提取出抓取策略。

任务约束通常被归结为affordance检测的问题。传统的全局affordance检测需要先进行物体识别,然后再进行6DoF位姿估计,这些方法的局限性在于不能泛化到新物体。affordance也可以指物体的几何形状和表面,但是需要物体3D模型。相反,局部affordance检测通过手工设计的特征或CNN利用物体的patches或parts,CNN方法能端到端进行affordance检测并且能泛化到新物体。

定位和识别相关物体也很关键,同时进行物体检测和affordance检测,避免了affordance检测对正确检测物体的依赖性。采用多任务损失函数联合训练,可避免级联CNN计算效率低下。

论文受文献Affordancenet: an End-To-End Deep Learning Approach for Object Affordance Detection(ICRA2018)启发,不同之处是论文方法采用的是物体分割。

与end-to -end affordance检测的SOTA方法Knowledge Induced Deep Q-Network for Robot Push and Grasp Manipulation Skills Learning(2019 Autonomous Robots)相比,论文不同之处在于将affordance和抓取位姿结合,能保证力闭合和任务约束。

与 PointNetGPD 直接从点云中检测相比,论文方法先检测affordance,再将检测的部分与点云配准,避免了直接对点云3D分割,保证了更高的实时性;网络不依赖于标注的3D分割数据。

与 GPD 方法主要的不同在于):1)论文聚焦于任务约束的抓取,检测物体affordance作为约束,GPD确定最佳抓取;2)GPD使用完整点云训练,论文使用单视角点云。

论文的主要贡献

- 使用Mask-RCNN进行affordance检测,和其他CNN方法相比提高了检测精度

- 改进了GPD,计算局部参考坐标系,提出对位置敏感的全卷积网络进行抓取分类

- 将以上两点结合,实现了单视角点云下受任务约束的抓取

2.相关工作

- Grasp pose detection (GPD):3DoF 和 6DoF

- Task-specific grasping with affordance detection:任务导向的抓取需要考虑特定任务约束,如接触位置,接近方向等。介绍了一些基于特定任务的affordance检测工作…不写了

3.方法

part affordance labels: grasp, cut, scoop, contain, pound, support, wrap-grasp

与抓取相关的part affordance类型:grasp(handle-grasp) 和 warp grasp

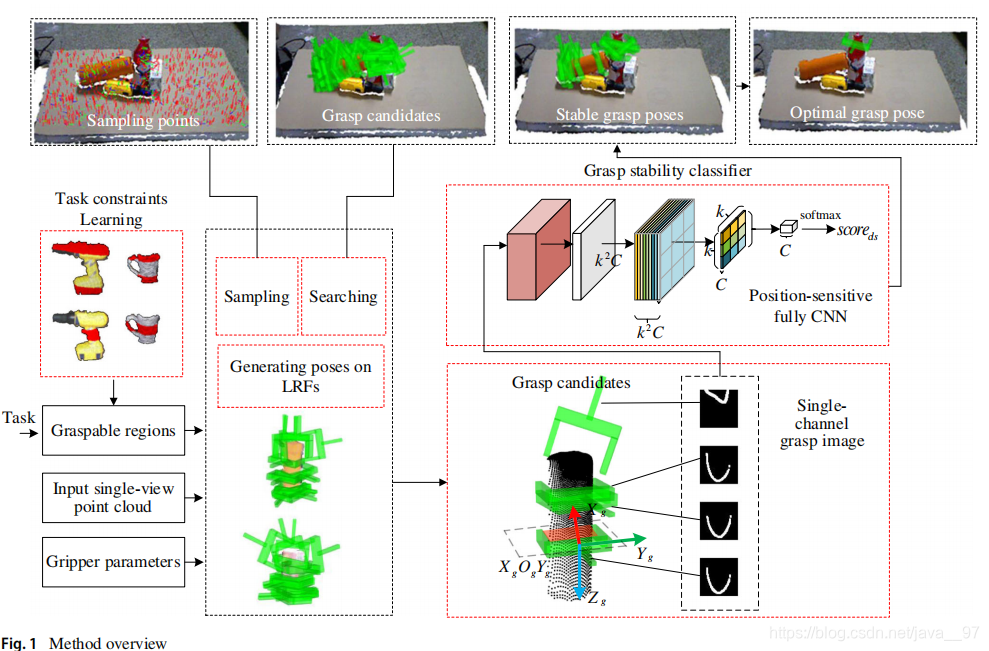

方法概述

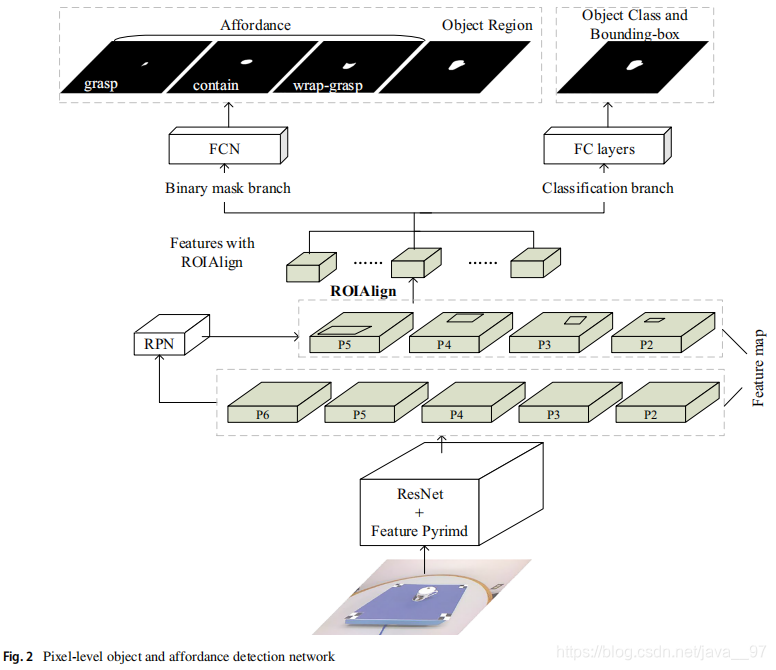

affordance检测

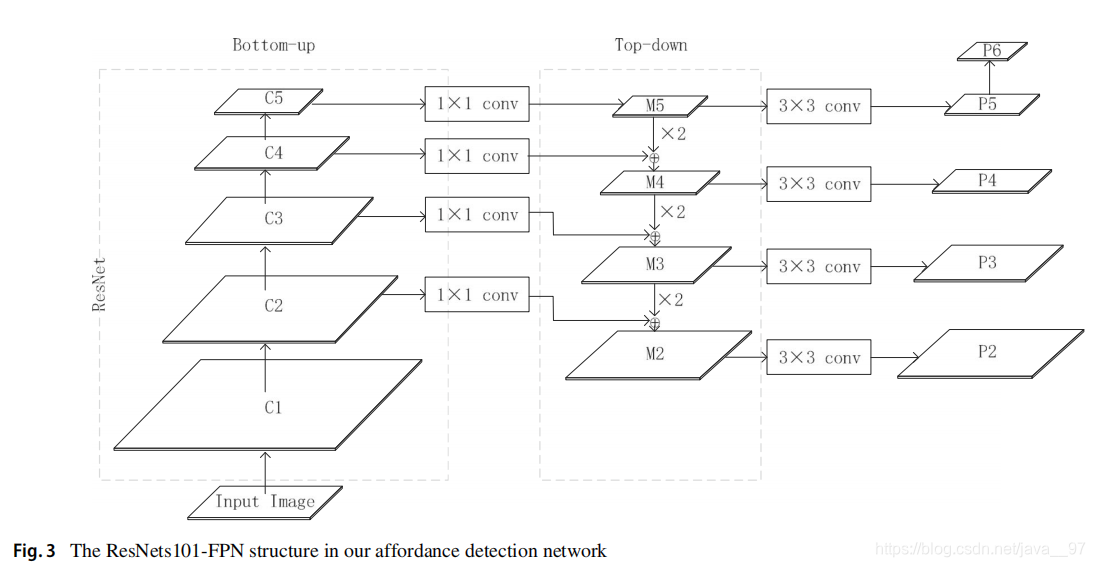

backbone为ResNet01,CNN 同时估计 <object, affordance>

为提升小区域检测能力采用特征金字塔

多任务损失 = 分类损失 + 边界框回归损失 + 掩膜损失

得到 grasp 和 warp grasp affordance后, f : I → C f:I\rightarrow C f:I→C 将像素映射回点云,利用KNN进行外点移除

利用单视角点云确定最佳抓取位姿

这部分主要是针对GPD的一些改进,细节比较多,有一个Weingarten变换还不是很懂,暂时放放,有空来填。