论文翻译 - Human in Events: A Large-Scale Benchmark for Human-centric Video Analysis in Complex Events

论文地址:https://arxiv.org/abs/2005.04490

数据集地址:http://humaninevents.org

ABSTRACT(摘要)

随着现代智慧城市的发展,以人为本的视频分析面临着分析真实场景中各种复杂事件的挑战。复杂事件与密集的人群、反常或集体行为有关。然而,受限于现有视频数据集的规模,很少有人工分析方法报告它们在此类复杂事件上的表现。为此,我们提出了一个新的大规模数据集,名为human -in-Events或HiEve (human -centric video analysis in complex Events),用于理解各种现实事件中的人体运动、姿态和动作,特别是人群和复杂事件。它包含了创纪录的姿势数量(

>

>

> 1M),在复杂事件下最多的动作实例数量(

>

>

> 56k),以及最长时间的轨迹数量之一(平均轨迹长度为

>

>

> 480帧)。基于此数据集,我们提出了一个增强的姿态估计baseline,利用动作信息的潜力来指导更强大的2D姿态特征的学习。我们证明,该方法能够提高现有的姿态估计pipline在我们的HiEve数据集上的性能。此外,我们进行了大量的实验,将最近的视频分析方法与我们的基线方法结合起来进行基准测试,表明HiEve是一个具有挑战性的数据集,用于以人为中心的视频分析。我们期望该数据集将推动以人为中心的分析和复杂事件理解的尖端技术的发展。该数据集可在http://humaninevents.org上获得。

关键词: 复杂事件,以人为中心的分析,数据集

1 INTRODUCTION(介绍)

智慧城市的发展高度依赖于对多媒体的快速、准确的视觉理解。为了实现这一目标,人们提出了许多以人为中心和事件驱动的视觉理解问题,如人体姿态估计[9],行人跟踪[6],动作识别[10],[11]。

最近,一些公共数据集(如MSCOCO [1], PoseTrack [4], UCF-Crime[8])被提出对上述任务进行基准测试。然而,当它们被应用到诸如吃饭、地震逃生、地铁下车和碰撞等复杂事件的真实场景时,就有一些局限性。首先,大多数基准测试集中在正常或相对简单的场景。这些场景要么有很少的遮挡,要么包含许多容易预测的动作和姿势。第二,现有基准的覆盖范围和规模仍然有限。例如,尽管UCFCrime数据集[8]包含具有挑战性的场景,但它只有粗糙的视频级动作标签,这可能不足以进行细粒度动作识别。同样,尽管MSCOCO[1]和PoseTrack[4]中的姿态标签数量对于遮挡有限的简单场景足够大,但这些数据集缺乏包含拥挤场景和复杂事件的真实场景。

为此,我们提出了一个新的大规模的以人为中心的数据集,名为Human-in-Events (HiEve),用于理解各种现实的复杂事件,特别是拥挤和复杂事件中以人为中心的信息(运动、姿势和动作)层次结构。在所有用于现实人群场景的数据集中,HiEve具有相当大的规模和复杂性,并包含创纪录的姿态数量(

>

>

> 1M)、动作标签(

>

>

> 56k)和长轨迹(平均轨迹长度

>

>

> 480帧)。与现有的数据集相比,HiEve在更复杂的场景中包含了更全面、更大规模的注释,更适合开发新的以人为中心的分析技术并在现实场景中进行评估。表1根据HiEve数据集的性质和规模提供了与相关数据集的定量比较。

表 1:HiEve 和现有数据集之间的比较。 “NA”表示不可用。 “~”表示近似值。“traj.”表示轨迹,“avg”表示平均轨迹长度。

我们的HiEve数据集的一个主要特征是人类注释的分层和多样化信息。为了充分利用这一特性,我们提出了一种动作引导的姿态估计算法作为我们的baseline方法,该算法通过附加的动作感知信息指导姿态表示学习。实验证明,这种以行动为导向的设计能够提高HiEve数据集上现有最先进的pipline的性能。

此外,我们还建立了一个在线评估服务器,供整个社区使用,以便对保留的测试视频进行及时和可扩展的评估。我们还评估了现有的最先进的解决方案在HiEve上的性能基准,并分析了相应的oracle模型,证明了HiEve是具有挑战性的,并在推进以人为中心的视频分析方面具有巨大的价值。

2 RELATED WORKS AND COMPARISON(相关工作及比较)

2.1 Multi-object Tracking Datasets(多目标跟踪数据集)

与单目标跟踪不同,多目标跟踪并不仅仅依赖复杂的外观模型来跟踪帧内目标。近年来,出现了提供视频序列多对象边界框和轨迹标注的数据集语料库,促进了该领域的发展。PETS[12]是一个早期提出的多传感器视频数据集,它包括人群人数的注释和人群中个人的跟踪。它的序列都是在同一个场景中拍摄的,所以样本比较简单。KITTI[13]跟踪数据集具有车载摄像头的视频,聚焦于街道场景,它拥有2D &3D边界盒和轨迹标注。同时,它的视频角度种类有限。最受欢迎的跟踪评估数据基准是MOT-Challenge[6],它从各种不同的角度显示行人。然而,随着MOT算法的快速发展,以及MOT challenge数据集的规模和复杂性的限制,它不太适合作为各种方法在现实世界复杂场景下跟踪性能的全面、通用的基准。

2.2 Pose Estimation and Tracking Datasets(姿态估计和跟踪数据集)

在过去的几年里,图像中的人体姿态估计取得了很大的进展。对于单人姿态估计,LSP[14]和FLIC[15]是两个最具代表性的基准,前者关注的是体育场景,而后者收集的是好莱坞热门电影序列。与LSP相比,FLIC只标记了10个上体关节,数据规模较小。WAF[16]首次建立了简化关键点和身体定义的多人姿态估计基准。然后,提出了MPII[2]和MSCOCO[1]数据集,利用它们在人体姿态方面的多样性和难度,进一步推进了多人姿态估计任务。特别是MSCOCO被认为是使用最广泛的大规模数据集,在数百个日常活动中有105698个姿态标注。考虑到跟踪任务,PoseTrack[4]构建了一个新的视频数据集,提供多人姿态估计和关节跟踪标注。与PoseTrack类似,最近提出的大规模CG数据集JAT[17]模拟了真实的城市场景,用于人体姿态估计和跟踪。

2.3 Action Recognition Datasets(动作识别数据集)

目前有两种人类动作视频数据集已经成为动作识别任务的标准基准:HMDB-51[18]和UCF-101[19]。HMDB-51主要从电影序列中收集,包含51个动作类。UCF-101是动作类别(101类)和样本数量最多的数据集之一,显著促进了动作识别任务的发展。为了识别现实中的异常行为,提出了Avenue[7]和UCF-Crime[8]。UCFCrime在真实世界的监控视频中注释了13种异常情况,如打斗、事故和抢劫。近年来,为促进视频分析技术的发展和评价,构建了规模更大、对象信息更详细的Kinetics[20]和AVA[21]数据集。然而,这些视频中的大部分内容要么来自戏剧场景,要么来自不拥挤的场景。

2.4 Comparisons(比较)

上述的相关数据集在社区中服务的很好,但现在它们面临着几个局限性:(1)大多数数据集中在正常或简单的场景(如街道、体育场景、单人运动),遮挡较少,对于运动或姿势的预测相对简单。(2)它们的覆盖范围和尺度对最先进算法的评价作用不大。(3)多个以人为中心的视频分析任务需要在多个基准上学习和评估,而以往数据集的注释只包含人类信息的一个方面(姿态、轨迹或动作)。总的来说,与这些数据集相比,我们的数据集具有以下独特的特点:

- HiEve数据集涵盖了广泛的以人为中心的理解任务,包括运动、姿势和动作,而之前的数据集只关注我们任务的一个子集。

- HiEve数据集具有相当大的数据规模,包括目前最大的姿态数量( > > > 1M),最大数量的复杂事件动作标签( > > > 56k),以及最大数量的长期轨迹(平均轨迹长度 > > > 480)。

- HiEve数据集中于各种拥挤复杂事件下的具有挑战性的场景(如用餐、地震逃生、地铁下车、碰撞等),而之前的数据集中大多与正常或相对简单的场景相关。

简而言之,我们的HiEve在各种复杂事件场景中包含了更全面、更大规模的注释,使其更有能力评估现实场景中以人为中心的分析技术。

图1:来自我们的训练集和测试集的不同动作的样本。

图2:街道场景的HiEve数据集的收集工作流示例;每个场景都包含了在不同地点拍摄的不同类型的事件。

图3:(a)关键点定义(b)来自数据集的示例姿态和边界框注释。

THE HIEVE DATASET(HiEve数据集)

3.1 Collection and Annotation(收集和注释)

收集。 我们首先选择几个拥挤的地方,有复杂和多样化的活动来收集视频。总共,我们的视频序列收集了9个不同的场景:机场,餐厅,室内,监狱,商场,广场,学校,车站和街道。图6显示了不同场景在HiEve中的帧数。这些视频大多是从我们自己收集的序列中挑选出来的,包含了人与人之间复杂的互动。如图2中的工作流所示,对于每个场景,我们保留在不同地点和不同类型的事件发生的几个视频,以确保场景的多样性。另外,通过人工检查避免了数据冗余。最后,在不同的场景中收集了32个真实的视频序列,每个序列包含一个或多个复杂的事件。这些视频序列被分割为19个和13个视频的训练和测试集,以便两个集覆盖所有场景,但使用不同的摄像机角度或地点。

注释。 在我们的数据集中,边界框、基于关键点的姿势、人类身份和人类动作都是手工标注的。注释过程如下:

首先,我们为整个视频中的每个人标注姿势。与PoseTrack和COCO不同,我们为每个身体标注的姿势包含14个关键点(图3a):鼻子、胸部、肩膀、肘部、手腕、臀部、膝盖、脚踝。特别地,我们跳过了属于以下任何情况的姿态标注:(1)严重遮挡(2)边界框面积小于500像素。图3b给出了一些姿态和边界框注释示例。

其次,我们在一个视频中每20帧注释所有人的动作。对于组操作,我们将操作标签分配给参与该组活动的每个组成员。我们总共定义了14个动作类别:独自行走、一起行走、独自奔跑、一起奔跑、骑马、坐着交谈、独自坐着、排队、独自站立、聚集、打斗、摔倒、上下楼梯行走、蹲伏鞠躬。图1显示了HiEve中不同操作的一些示例。最后,对所有注释进行双重检查,以确保其质量。

3.2 HiEve Statistics(HiEve统计)

我们的数据集包含32个视频序列,大部分长度超过900帧。它们的总长度是33分18秒。表1显示了我们的HiEve数据集的基本统计数据:它有49820帧,1,302,481个bounding-box annotation, 2,687个track annotation, 1,099,357个human pose annotation, 56,643个action annotation,是我们所知规模最大的以人为中心的数据集。

为了进一步说明我们的数据集的特征,我们进行以下统计分析。

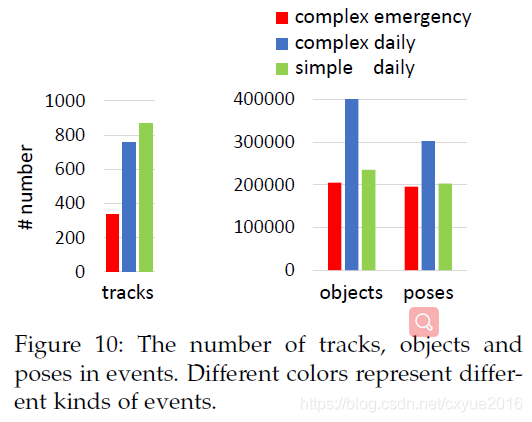

首先,我们分析了不同事件的一些统计信息。在视频内容方面,我们可以将我们的视频序列分成11个事件:打架、争吵、事故、抢劫、放学、购物、下车、吃饭、散步、玩耍、等待。每个事件包含不同数量的参与者和动作类型。然后,根据这些事件的复杂性,我们进一步将这些事件分为三类:复杂的紧急事件、复杂的日常事件和简单的日常事件。类别、事件和动作之间的层次关系如图4所示。我们在图10中展示了上述3个事件的姿态、对象和轨迹的数量,这证明了我们定义的复杂事件具有更以人为中心的信息。此外,图5显示了每个事件的平均帧数,表明我们的HiEve数据集是由复杂事件主导的。

其次,我们在图7中展示了我们的数据集中每帧的人数,这表明我们的视频序列中的场景比MOT17和Pose- Track[4]的人数更多,这使得我们的跟踪任务更加困难。虽然mot - 20[6]收集了一些视频序列与更多的人(多达141人),它只涵盖有限的场景和人类的行动。

第三,我们采用Crowdpose[3]中定义的人群指数来衡量我们数据集的拥挤程度。对于给定的帧,其人群指数(CI)计算为

C

I

=

1

n

∑

i

=

1

n

N

i

b

N

i

a

CI =\frac{1}{n}\sum^n_{i=1}\frac{N^b_i}{N^a_i}

CI=n1?∑i=1n?Nia?Nib??

其中n是这个坐标系中的总人数。

N

i

a

N^a_i

Nia?为来自第i个人类实例的关节数,

N

i

b

N^b_i

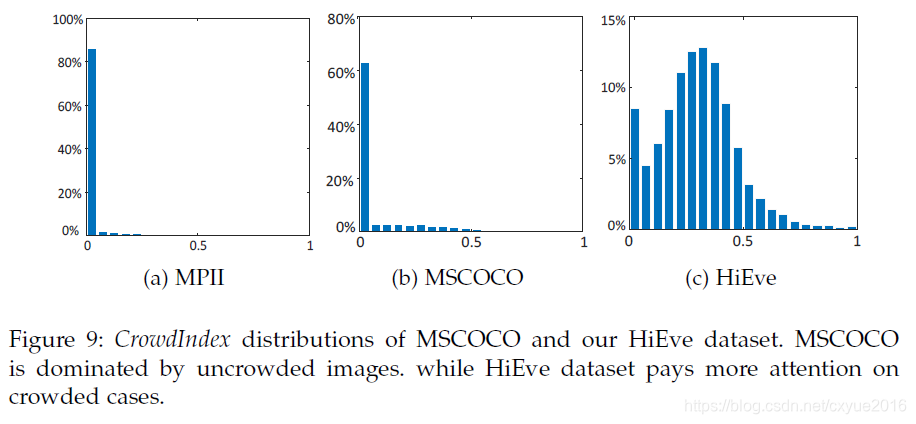

Nib?为位于第i个人类实例边界箱内但不属于第i个人类实例的关节数。我们评估了我们的HiEve数据集和广泛使用的姿态数据集MSCOCO[1]和MPII[2]的人群指数分布。图9显示,我们的HiEve数据集更关注拥挤的场景,而其他基准测试主要是不拥挤的场景。这一特点使得我们的数据集上的最先进的方法既可以覆盖简单的情况,也可以忽略拥挤的情况。

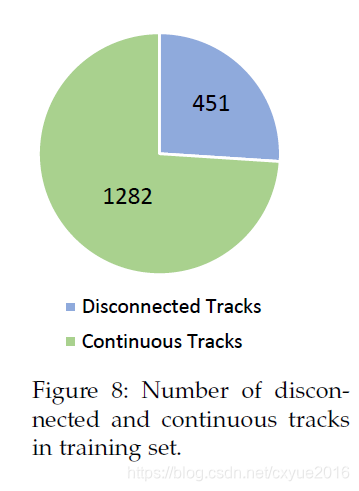

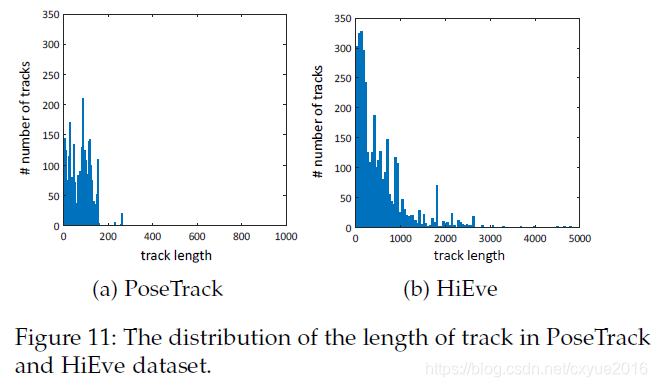

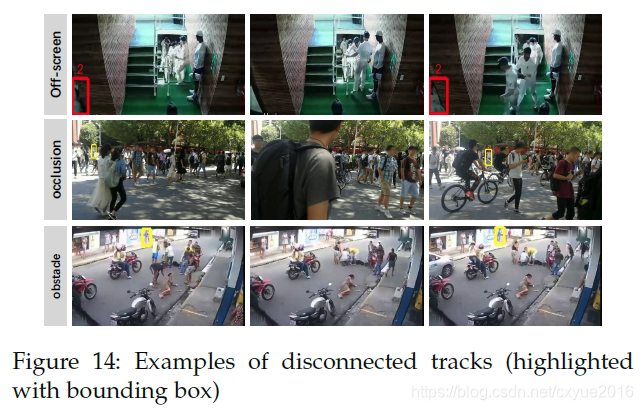

第四,我们分析了数据集中没有联系的人类轨迹的比例。没有联系的人体轨迹被定义为由于以下原因在某些帧上边界框不可用的轨迹标注:(1)一个物体暂时离开摄像机视图并在稍后返回。(2)一个对象长期被前景对象或某些障碍严重遮挡,注释者无法给它分配一个近似的边界框(如图14所示)。值得注意的是,这样的数据集PoseTrack[4],一个个人的再现场景中被认为是一个新的轨道的开始而不是原始的延续追踪消失之前,以这种方式这些数据集将包含更多的跟踪耐力较短(反映在图11)。相比之下,在HiEve中,我们用相同的ID分配消失前后的轨迹,以鼓励能够适当处理长期重新识别的算法。图8中报告了训练集中的断开和连续轨迹的数量。统计结果表明,不连通轨道的比例是不可忽略的支持算法,能够处理复杂情况和拥挤场景。

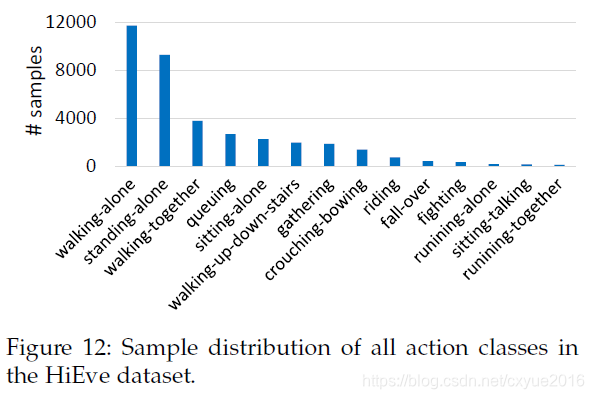

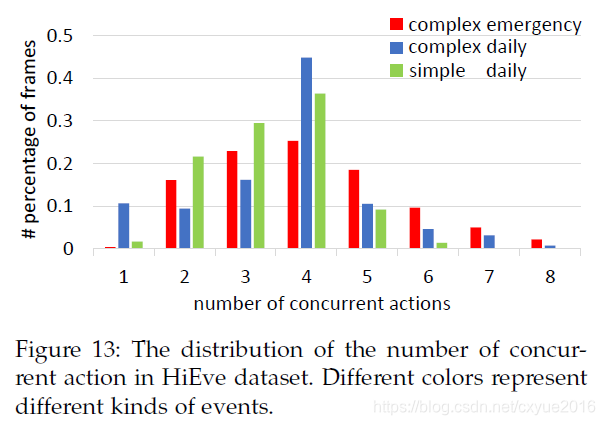

最后,数据集中所有操作类的分布如图12所示,可以将其视为长尾样本分布。图13显示了我们数据集中的复杂事件有更多的并发事件,这意味着在此类场景中识别行为的复杂性和难度将会增加。

总的来说,这些统计数据进一步证明了HiEve是一个由复杂事件主导的大规模且具有挑战性的数据集。

4 TASK AND METRIC(任务和指标)

根据收集到的视频数据和可用的注释,HiEve提出了四个任务来评估视频分析算法。

多人运动跟踪。 该任务提出在整个视频中估计每个身份的位置和相应的轨迹。特别地,我们提供了两个子轨道:

- Public:在本子轨道中,所有参与者只能使用我们提供的公共目标检测结果,该结果通过Faster-RCNN[22]获得。

- Private:此子轨道的参与者能够通过任何方法生成自己的检测边界框。

人群姿态估计。 该任务要求参与者估计人体骨骼上的特定关键点。与MPII Pose和MSCOCO关键点相比,我们的数据集涉及了更多复杂事件中的真实场景姿态模式。

人群姿态跟踪。 这个任务需要为视频中所有可见的人提供暂时一致的姿势。与PoseTrack相比,我们的数据集规模更大,包含更频繁的遮挡。

Person-level动作识别。 动作识别任务要求参与者同时检测出特定的个体,并在每个采样帧上为其分配正确的动作标签。与AVA挑战[23]相比,我们的动作识别轨迹不仅包含原子级别的动作定义,还涉及更多的交互和个体间的遮挡,使得识别更加困难。

我们在不同的挑战轨道中采用了一些广泛使用的参数,同时我们也设计了一些新的参数去衡量拥挤和复杂场景中的表现。

4.1 Multi-person tracking(多人跟踪)

- MOTA和MOTP[5]:它们是评价视频序列中目标跟踪性能的标准度量。MOTA测量假阳性、目标缺失和身份切换的比率。MOTP测量的是预测结果与地面真实之间的轨迹相似性。该测量方法用于多人跟踪和多人姿态估计与跟踪的跟踪。

- w-MOTA:为了评估算法在无连接部分的轨道上的表现,我们设计了加权MOTA度量(w-MOTA)。这个度量以类似于MOTA的方式计算,除了我们将更高的权重分配给发生在断开轨道上的ID切换情况,因此度量可以表述为

w ? M O T A = 1 ? ( N f p + N f n + N s w + ( γ ? 1 ) N s w ? d t ) / N g t w-MOTA=1-(N_{fp}+N_{fn}+N_{sw}+(\gamma-1)N_{sw-dt})/N_{gt} w?MOTA=1?(Nfp?+Nfn?+Nsw?+(γ?1)Nsw?dt?)/Ngt?

其中, N f p N_{fp} Nfp?和 N f n N_{fn} Nfn?为假阳性和假阴性的次数, N s w N_{sw} Nsw?为ID切换的总次数, N s w ? d t N_{sw-dt} Nsw?dt?为断开轨道中发生ID切换的次数, N g t N_{gt} Ngt?为标注中包围盒的数量。 - ID F1 Score[24]:正确识别的检测与地面真实和计算检测的平均数量的比值。

- ID Sw[24]:标识交换机总数。

- ID Sw-DT:在断开的轨道上发生的标识开关的总数。

4.2 Multi-person pose estimation(多人姿态估计)

- AP@我们采用平均精度(AP)测量多人姿势精度。评估协议类似于DeepCut[25]:首先,如果一个姿势预测PCKh最高[2](head-normalized比例正确的要点,是距离阈值,以确定是否发现关键点匹配一个带注释的关键点)与某种真实,那么它可以分配给地面真理(GT)。未指定的预测被视为假阳性。最后,根据精度查全曲线下的面积计算平均精度(AP)。

- w-AP@

α

\alpha

α 为了进一步避免只关注简单情况下数据集中不拥挤场景的方法(尽管图 9 显示我们的数据集包含大量拥挤和复杂的场景),我们将在评估过程中为测试图像分配更大的权重-如果它拥有:(1) 较高的克劳德指数 (2) 异常行为(例如打架、摔倒、蹲伏)。具体来说,一个视频序列中第 t 帧的权重可以表示为:

w t P = c 1 e C I t + c 2 N t w^P_t=c_1e^{CI_t}+c_2N_t wtP?=c1?eCIt?+c2?Nt?

其中 C I t CI_t CIt?为通过公式1计算出的第 t t t帧人群指数, N t N_t Nt?为异常行为的类别数。在我们计算的过程中,系数 c 1 , c 2 c_1,c_2 c1?,c2?分别设置为2,1。通过分配权重计算的AP值称为加权AP (w-AP)。 - AP@avg我们取AP@0.5、AP@0.75和AP@0.9的平均值作为关键点估计结果的总体度量,其中0.5、0.75和0.9是计算PCKh的特定距离阈值。

- w-AP@avg取w-AP@0.5、w-AP@0.75和w-AP@0.9的平均值作为加权视频帧关键点估计结果的总体度量,其中0.5、0.75和0.9是计算PCKh的特定距离阈值。

4.3 Pose tracking(姿态跟踪)

- 跟踪任务中的 MOTA和MOTP 也采用姿态跟踪进行评估。

- 我们用与多人姿态估计相同的方法计算姿态跟踪评估。

4.4 Action recognition(姿态识别)

- 帧映射(f-mAP)是在单个帧上评估空间动作检测精度的常用度量。具体来说,每个预测由一个边界框和一个预测动作标签组成。如果与同一标签的不匹配的ground-truth盒子重叠大于某一阈值,则认为为真正;否则就是假阳性。此外,为了避免对视觉上模糊或无法分辨行为的对象进行评估,我们从测试集中的注释中过滤掉了尺寸极小或被他人严重遮挡的边界框。因此,只有36%的注释框被用来评估性能。

- 考虑到行动类别在数据集中的分布不平衡,属于主导类别的测试样本的权重较小是合适的。此外,我们为拥挤和闭塞场景下的帧分配了更大的权重,以鼓励模型在复杂场景中表现得更好。与加权的mAP类似,用这些分配的权值计算的帧mAP值称为加权的frame-mAP(简称wf-mAP)。

- f-mAP@avg我们报告f-AP@0.5, f-AP@0.6和f- AP@0.75,其中0.5,0.6和0.75是确定真/假阳性的特定IOU阈值,然后将它们的平均值作为f- map的总体测量值,我们表示此测量为f-mAP@avg。

- wf-mAP@avg同样,我们报告wf-AP@0.5、wf-AP@0.6和wf-AP@0.75,然后取它们的平均值作为wf- map的总体测量值,我们表示这个测量值为wf-mAP@avg。

5 ACTION-GUIDED POSE ESTIMATION(ACTION-GUIDED姿势估计)

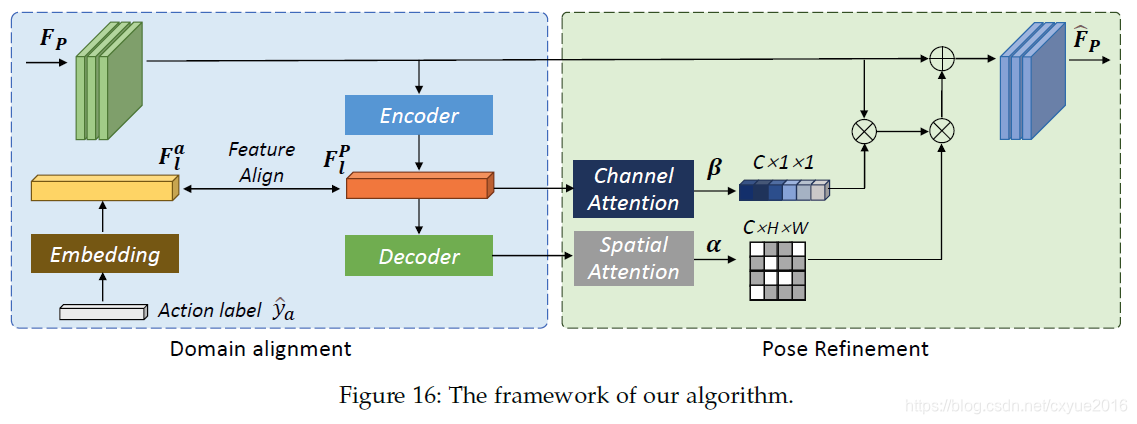

基于骨架的视频动作识别技术[26]、[27]近年来得到了较好的发展。相比之下,很少有人注意到动作信息在增强二维姿态特征学习中的潜力。得益于我们数据集丰富和全面的注释,我们通过使用动作类型的知识指导姿态估计过程,为HiEve基准构建了一个增强的基线方法。与之前的方法不同,它将动作信息引入到特征学习和细化中。如图16所示,算法主要包括两个模块:动作引导的域对齐模块(ADAM)和位姿细化模块(PRM), ADAM对动作域和位姿域之间的特征表示进行对齐,而PRM利用对齐后的特征对位姿估计结果进行细化。

5.1 Action-guided domain alignment(Action-guided域对齐)

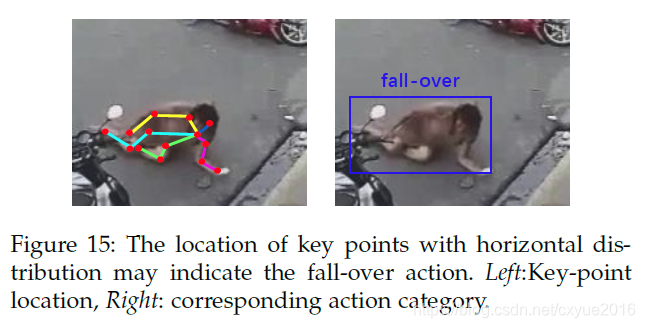

人体关键点之间某些特殊的位置关系往往预示着某种异常行为。例如,如图15所示,一个产生密集和水平关键点分布的人体骨架通常与摔倒动作相关联。反之,动作类别可以提供可靠的关键点位置先验知识。此外,这些知识还可以修正不正确的关键点位置。根据这一观察,我们提出了一个动作引导域对齐模块(ADAM),其中我们将姿态和动作视为来自两个不同域的信息。ADAM的目的是建立它们之间的映射,使两个域在特征空间上接近。

采用自顶向下的姿态估计框架,利用基卷积网络提取了个人的姿态特征

F

p

F_p

Fp?。然后,编码器E通过一系列下采样操作将位姿特征压缩并编码为维数为n的潜在特征

f

l

p

f^p_l

flp?。为了提取动作信息,我们用一个热点向量

y

^

a

\hat{y}_a

y^?a?表示同一个人的动作类别,通过线性变换T将热点动作向量进一步嵌入到一个潜在特征

f

l

a

f^a_l

fla?中,嵌入的特征维数与f p l相同。上述过程可以表述为

f

l

p

=

E

(

F

p

)

,

f

l

a

=

T

(

y

^

a

)

,

f

l

p

,

f

l

a

∈

R

1

×

N

f^p_l=E(F_p), f^a_l=T(\hat{y}_a), f^p_l, f^a_l\in R^{1\times N}

flp?=E(Fp?),fla?=T(y^?a?),flp?,fla?∈R1×N

其中

T

(

?

)

=

W

t

2

(

W

t

1

(

?

)

)

,

W

t

2

∈

和

W

t

1

T(\bullet)=W^2_t(W^1_t(\bullet)), W^2_t\in 和 W^1_t

T(?)=Wt2?(Wt1?(?)),Wt2?∈和Wt1?是两个全连接层的参数。

最后,计算了两个域的潜在特征之间的对齐损失,旨在通过最小化潜在空间中的欧氏距离来促进特征之间的一致性。

L

a

l

i

g

n

=

M

S

E

(

f

l

p

,

f

l

a

)

L_{align}=MSE(f^p_l,f^a_l)

Lalign?=MSE(flp?,fla?)

5.2 Pose refinement(姿态优化)

为了进一步提高姿态估计的质量,我们设计了一个基于潜在姿态特征的细化模块,该模块包括两个头部结构:空间细化头部和通道细化头部。

在姿态估计中,关键点的位置是通过空间特征图的局部响应来反映的。因此,SR希望通过强调特定的骨架位置和抑制不准确的关键点响应来重新加权空间特征图。与ADAM中的编码器相对应,SR应用一个译码器,该译码器由一系列上采样操作组成,从

f

p

f_p

fp?输出一个注意掩码

α

\alpha

α:

α

=

σ

(

W

s

1

(

D

(

f

l

p

)

)

)

\alpha = \sigma(W^1_s(D(f^p_l)))

α=σ(Ws1?(D(flp?)))

其中

W

S

1

∈

R

N

×

N

W^1_S\in R^{N\times N}

WS1?∈RN×N是深度可分离 9x9 卷积的参数,输出注意力图

α

\alpha

α隐含地包含来自特定动作知识的先验关键点。另一方面,受 SENet [28] 的启发,CRaims 在全局意义上执行通道特征重新校准,其中每通道汇总统计用于选择性地强调信息特征图并抑制无用的特征图.具体来说,潜在特征通过两个全连接层和一个 sigmoid 激活以获得每个通道的注意力向量

β

\beta

β

β

=

σ

(

W

c

2

?

δ

(

W

c

1

f

l

p

)

)

\beta=\sigma(W^2_c\bullet \delta(W^1_cf^p_l))

β=σ(Wc2??δ(Wc1?flp?))

其中,

σ

(

?

)

\sigma(\bullet)

σ(?)和

δ

\delta

δ分别代表sigmoid和ReLU函数,

W

C

1

∈

R

d

×

N

W^1_C\in R^{d\times N}

WC1?∈Rd×N和

W

C

1

∈

R

N

×

N

W^1_C\in R^{N\times N}

WC1?∈RN×N指的是两个全连接层。

然后应用通道和空间注意引导来细化姿态特征为

F

^

p

=

F

p

?

(

1

+

β

?

α

)

\hat{F}_p=F_p\bigotimes(1+\beta \bigotimes \alpha)

F^p?=Fp??(1+β?α)

5.3 Implementation Details(实施细节)

选择在COCO上预先训练的HRNet[29]作为姿态特征提取训练的骨干。建议的模块是在HRNet的最后阶段之后添加的。我们的编码器和解码器分别采用了U-Net中相应的下采样和上采样架构。对于训练,整个网络在HiEve训练集上进行训练。为了进行公平的比较,与我们在6.2中描述的一样,我们将YOLO v3作为人员检测器。由于动作在HiEve中每20帧被标注一次,我们利用插值为每帧中的所有个体创建动作类别标签。我们为骨干HRNet和我们提出的模块设置了不同的学习速率,分别是1e-4和1e-3。在我们的实验中,我们将展示我们的模型获得挖掘潜在动作信息的能力,以细化姿态。在培训阶段,培训的总损失定义为

L

=

L

r

e

g

+

L

a

l

i

g

n

L=L_{reg}+L_{align}

L=Lreg?+Lalign?

其中

L

r

e

g

L_{reg}

Lreg?是传统的热图回归L2损失。在推理过程中,去掉动作标签的嵌入过程,将所提出的模块与HRNet最后一阶段的输出相连接。