微调

- 标注一个数据集很贵

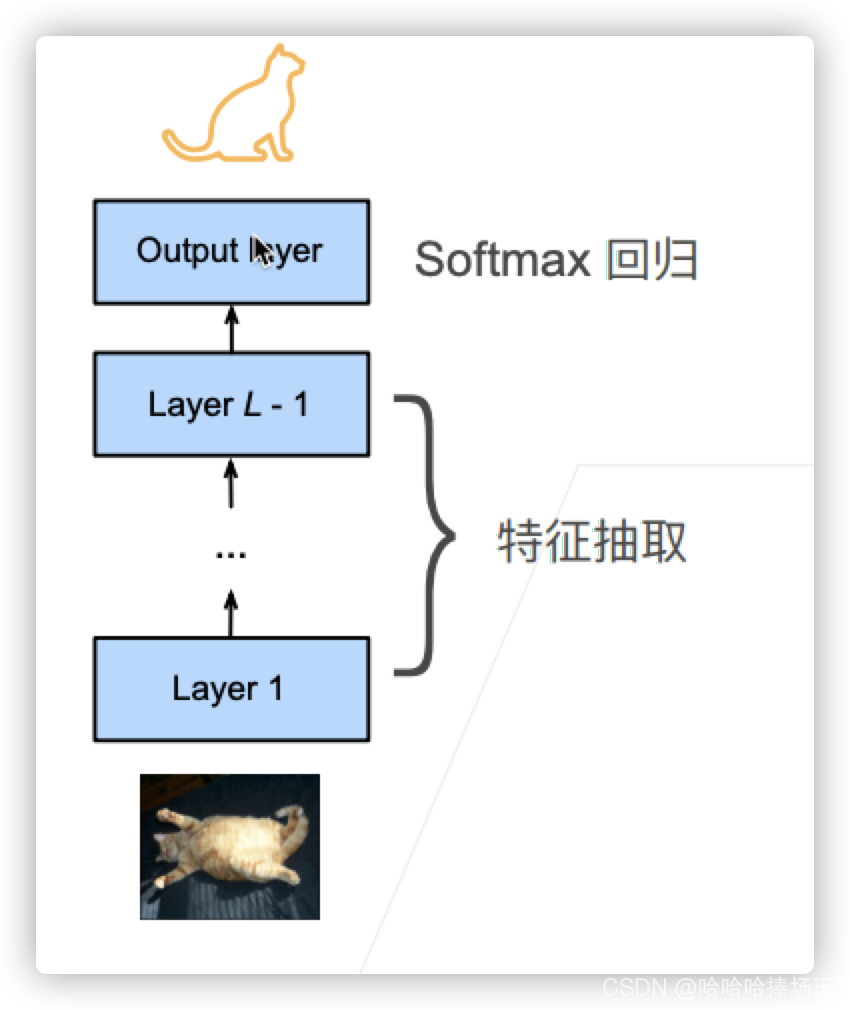

网络架构

- 一个神经网络一般可以分为两块

- 特征抽取将原始像素变成容易线性分割的特征。意思就是将原始的像素变换为很容易分割的线性特征

- 线性分类器来做分类

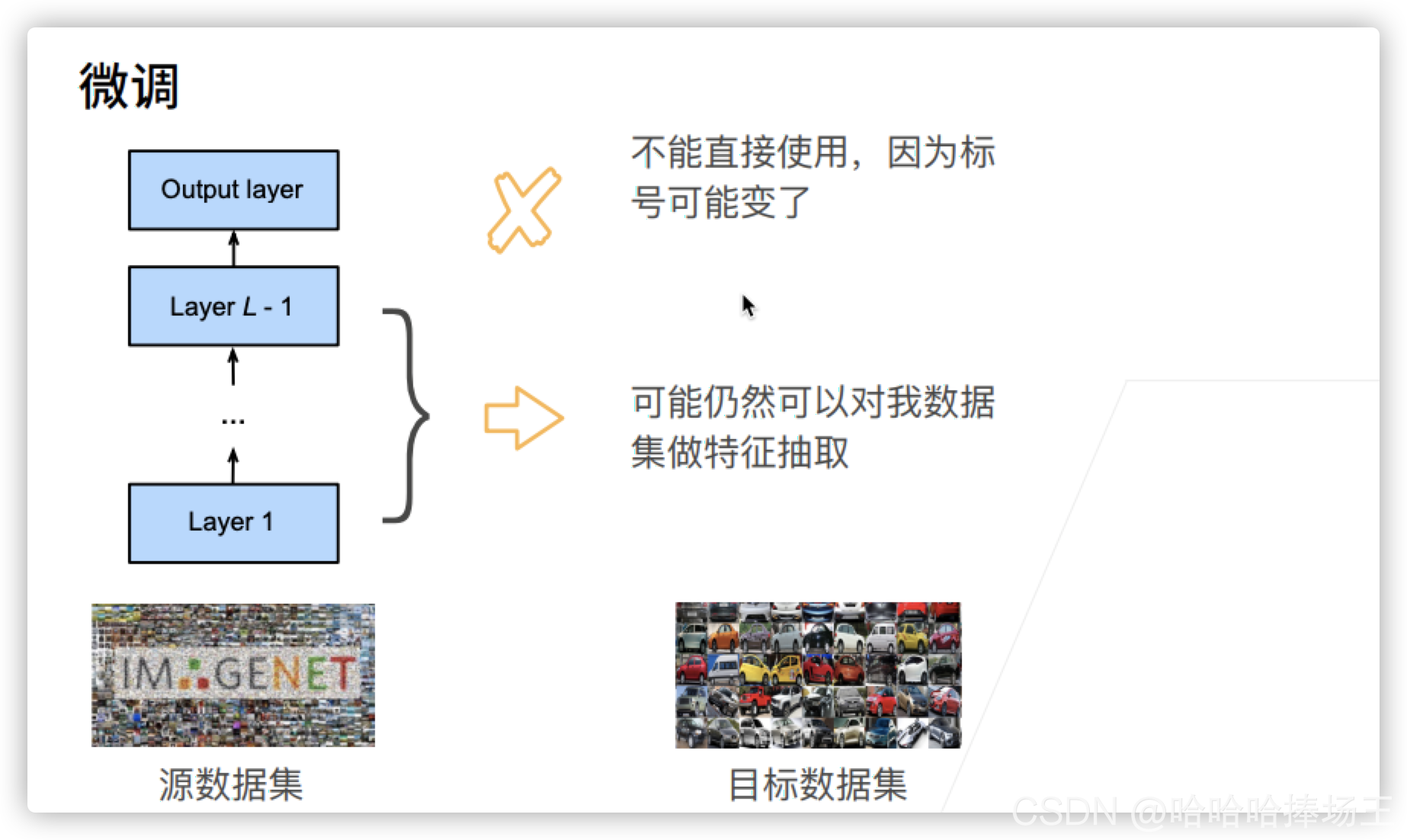

微调

- 微调的意思就是在源数据集上,已经训练好了一个模型。假设这个模型确实是按照我们想的来进行的(先做特征提取,然后做分类),那么我们可以认为,我们在你的数据集上面可以进行比较的好的特征提取,那么他在我们的数据集上也可以做一个比较好的特征提取。但是分类器我们不能直接使用。

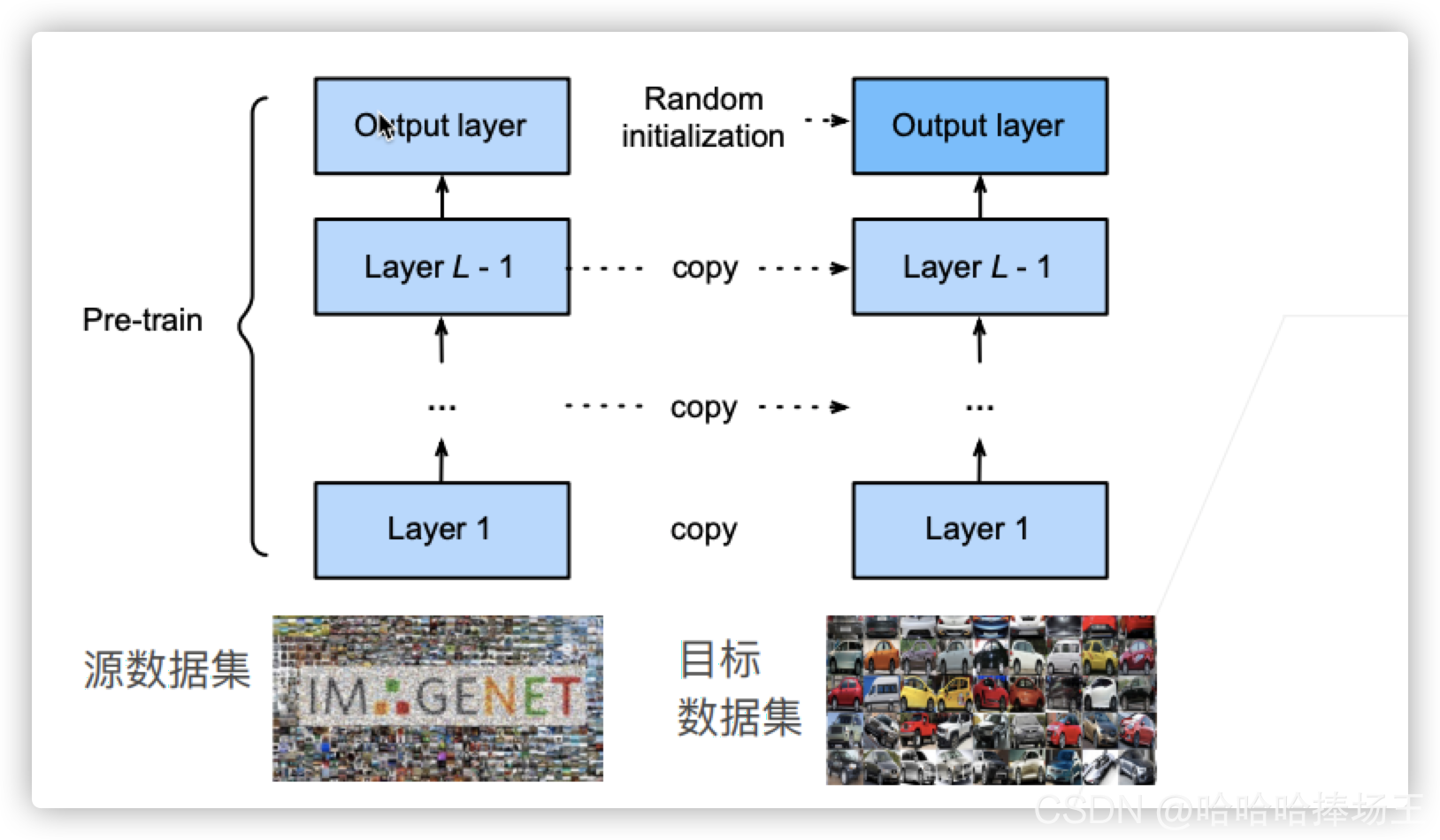

微调中的权重初始化

- 假设我们在源数据集训练好了一个模型,一般称为Pre-train,然后我们在我们自己的模型我们使用与Pre-train一样的架构的模型,我们模型的初始化不再是随机初始化,我们直接将Pre-train好的参数copy过来使用,这样我们这个模型一开始就可以获得一个还可以的效果。当然最后一层可以随机的初始化

训练

- 是一个目标数据集上的正常训练任务,但使用更强的正则化

- 使用更小的学习率

- 使用更少的数据迭代

- 源数据集远复杂于目标数据,通常微调效果更好

重用分类器权重

- 源数据集中可能也有目标数据中的部分标号

- 可以使用预训练好模型分类器中对应标号对应的向量来做初始化

固定一些层

- 神经网络通畅学习有层次的特征表示

- 低层次的特征更加通用

- 高层次的特征则更跟数据集相关

- 可以固定底部一些层的参数,不参与更新

- 更强的正则

总结

代码实现

%matplotlib inline

import os

import torch

import torchvision

from torch import nn

from d2l import torch as d2l

d2l.DATA_HUB['hotdog'] = (d2l.DATA_URL + 'hotdog.zip', 'fba480ffa8aa7e0febbb511d181409f899b9baa5')

data_dir = d2l.download_extract('hotdog')

train_imgs = torchvision.datasets.ImageFolder(os.path.join(data_dir, 'train'))

test_imgs = torchvision.datasets.ImageFolder(os.path.join(data_dir, 'test'))

Downloading ../data/hotdog.zip from http://d2l-data.s3-accelerate.amazonaws.com/hotdog.zip...

# 图像的大小和纵横比各有不同

hotdogs = [train_imgs[i][0] for i in range(8)]

not_hotdogs = [train_imgs[-i - 1][0] for i in range(8)]

d2l.show_images(hotdogs + not_hotdogs, 2, 8, scale=1.4);

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aQJJ2npC-1629872905362)(output_3_0.png)]

# 数据增广

# 将RGB的通道

normalize = torchvision.transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225]) # 这里就是相当于做了一个批量的归一化,如果我们的网络结构中有就不需要这个

train_augs = torchvision.transforms.Compose([

torchvision.transforms.RandomResizedCrop(224),

torchvision.transforms.RandomHorizontalFlip(),

torchvision.transforms.ToTensor(), normalize])

test_augs = torchvision.transforms.Compose([

torchvision.transforms.Resize(256),

torchvision.transforms.CenterCrop(224),

torchvision.transforms.ToTensor(), normalize])

# 定义和初始化模型

pretrained_net = torchvision.models.resnet18(pretrained=True) #这一行代码的意思就是

pretrained_net.fc # fc的意思就是fully connect也就是全连接,也就是最后一层

Downloading: "https://download.pytorch.org/models/resnet18-f37072fd.pth" to /Users/tiger/.cache/torch/hub/checkpoints/resnet18-f37072fd.pth

100.0%

Linear(in_features=512, out_features=1000, bias=True)

finetune_net = torchvision.models.resnet18(pretrained=True) # 这里和前面一样将我们模型下载下来

finetune_net.fc = nn.Linear(finetune_net.fc.in_features, 2) # 这里就是将最后fully connect层随机初始化为一个线性层,input为512,输出为2

nn.init.xavier_normal_(finetune_net.fc.weight); # 这里对上面的fully connect层的参数做了一个随机初始化

# 模型微调

def train_fine_tuning(net, learning_rate, batch_size=128, num_epochs=5,

param_group=True):

train_iter = torch.utils.data.DataLoader(

torchvision.datasets.ImageFolder(os.path.join(data_dir, 'train'),

transform=train_augs),

batch_size=batch_size, shuffle=True)

test_iter = torch.utils.data.DataLoader(

torchvision.datasets.ImageFolder(os.path.join(data_dir, 'test'),

transform=test_augs),

batch_size=batch_size)

devices = d2l.try_all_gpus()

loss = nn.CrossEntropyLoss(reduction="none")

if param_group:

params_1x = [

param for name, param in net.named_parameters()

if name not in ["fc.weight", "fc.bias"]] # 这里将不是最后一层的所有层的参数都都拿出来

trainer = torch.optim.SGD([{

'params': params_1x}, { # 这里表示不是最后一层的参数,学习率使用默认的学习率

'params': net.fc.parameters(), # 最后一层的参数,最后一层的学习率使用的是10倍

'lr': learning_rate * 10}], lr=learning_rate,

weight_decay=0.001)

else:

trainer = torch.optim.SGD(net.parameters(), lr=learning_rate,

weight_decay=0.001)

d2l.train_ch13(net, train_iter, test_iter, loss, trainer, num_epochs,

devices)

# 使用较小的学习率

train_fine_tuning(finetune_net, 5e-5) # finetune_net就是我们之前定义的最后一层是随机的,其他的层都是我们copy的参数

# 不用pretrain

scratch_net = torchvision.models.resnet18() # 这里就是将模型结构拷贝过来,所有的参数都是随机初始化的

scratch_net.fc = nn.Linear(scratch_net.fc.in_features, 2)

train_fine_tuning(scratch_net, 5e-4, param_group=False)