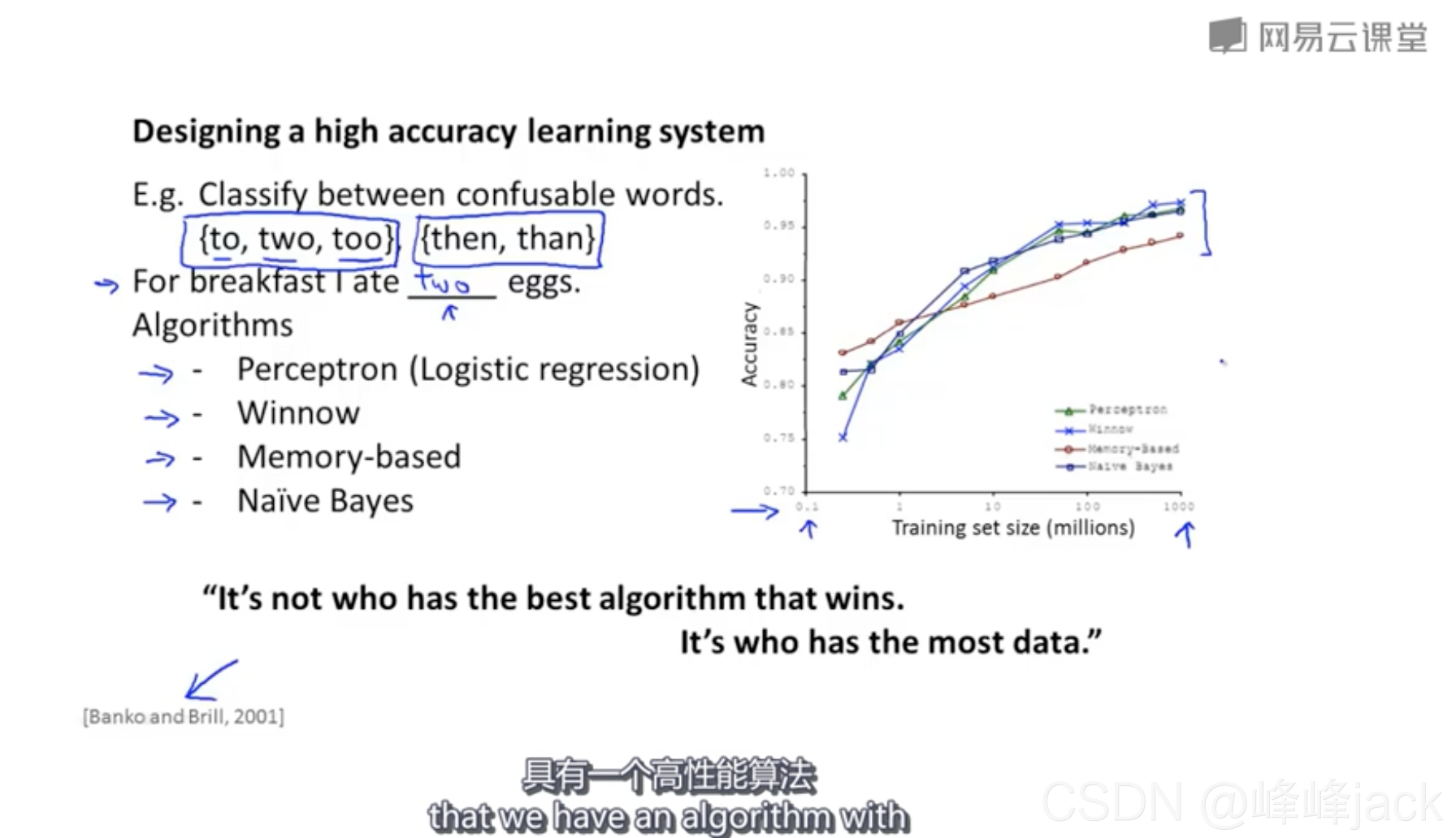

训练数据量决定效果上限:有的时候,使用什么算法并无关紧要,关键是使用了多大的数据量进行训练。如下图所示的nlp预测场景,四种算法随着训练数据量的增加,其准确率相应增加。而不同算法尽管有一些差异,但远没有数据量的影响那么大。

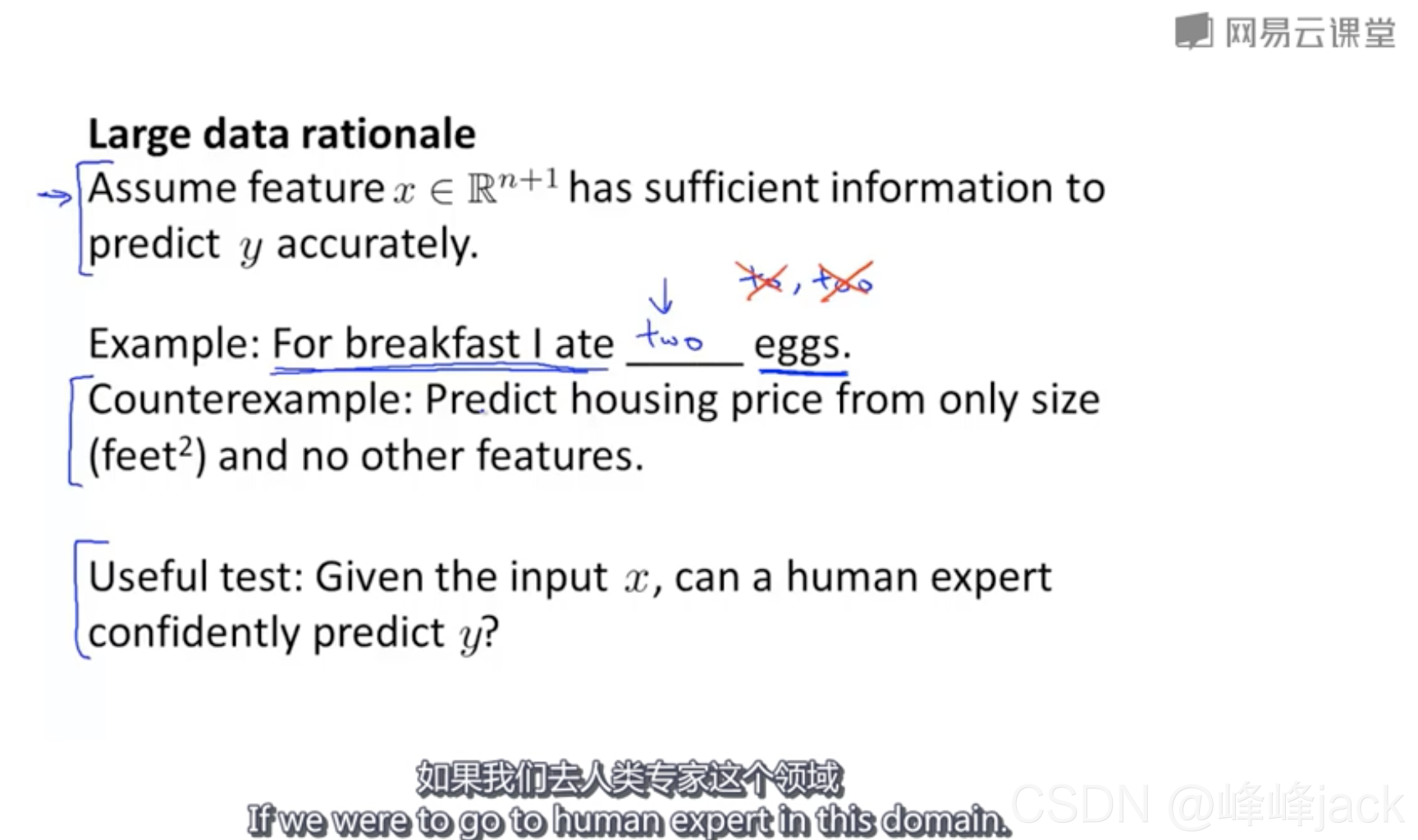

除了训练数据量是否足够,另一个重要方面是特征信息是否充分。

一个有用的测试是:在给定的特征之下,人类专家能否有信心给出正确的预测?如果可以,那说明我们提供的特征信息足够充分;否则,说明我们提供的特征数据不够。特征信息充分,模型才可能做出正确预测;不充分,人类都无法做出正确预测,则大概率模型也不可能做出正确预测。

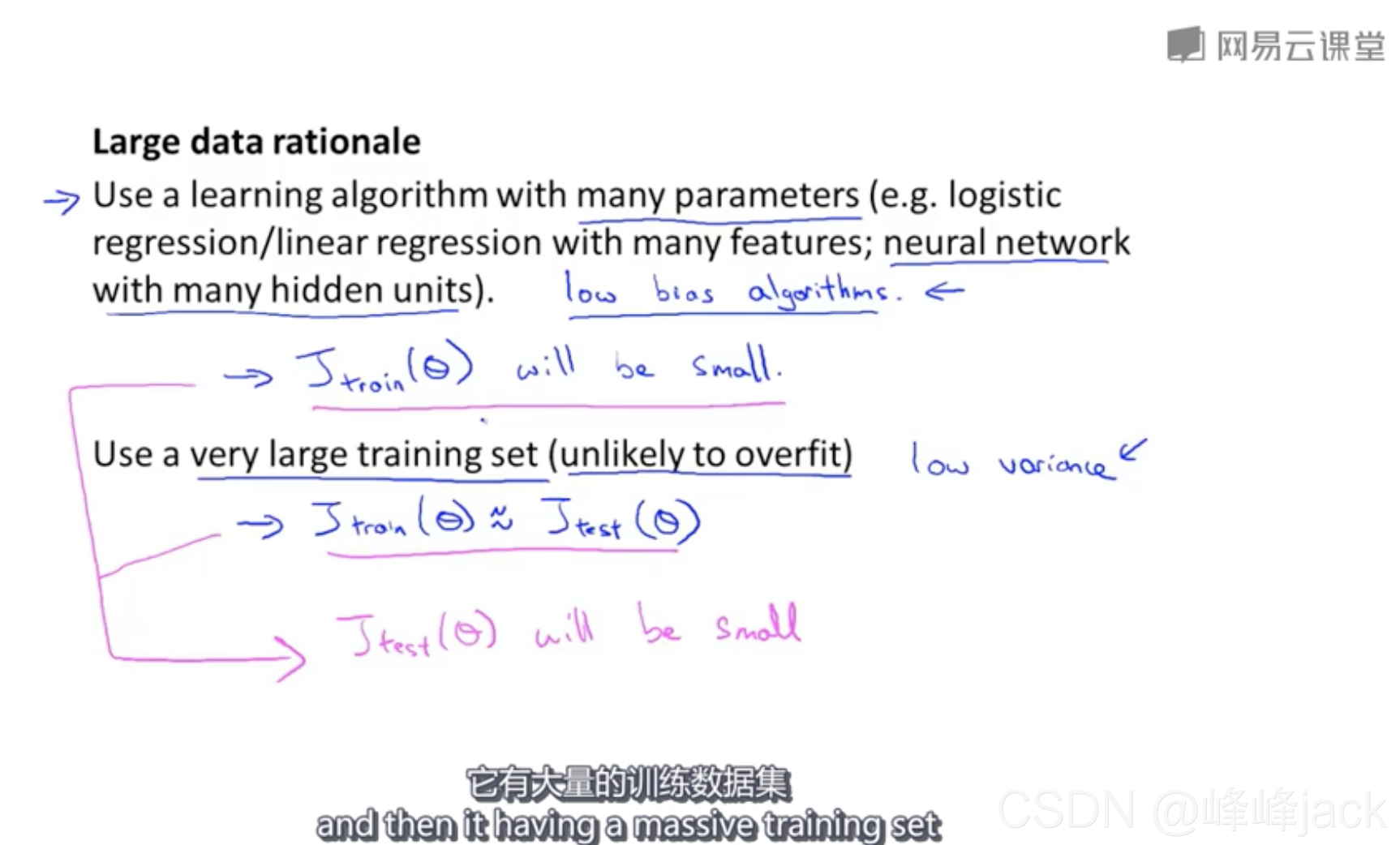

当我们使用足够复杂的模型(比如:有很多特征的lr或者有很多隐藏层的神经网络),bias通常来说就能控制到比较小的程度。

当训练数据量很小甚至小于模型参数量时,此时模型容易发生过拟合,模型的方差会比较大。而当训练数据量远大于模型参数量时,此时模型不易发生过拟合,模型的方差会比较小。

所以方差大并不是针对算法而言,算法无所谓方差大或方差小。方差描述的是在特定数据集下训练出来的模型的变异性,也就是数据中的噪点对于模型稳定性的影响。这个影响越小则方差越小,影响越大则方差越大。数据量大时,模型的方差更可能会比较小;数据量太小时,模型的方差可能会很大,此时任何一个数据点对于模型参数的影响都非常巨大。