Stacking集成算法是一个两层模型的集成,第一层含有多个基础分类器,把预测的结果(元特征)提供给第二层,而第二层的分类器通常是逻辑回归,将第一层分类器的结果当作特征做拟合输出预测结果。

1、Blending集成学习算法

Blending集成学习的流程:

- (1)将数据划分为训练集和测试集(test set),其中训练集需要再次划分为训练集(train set)和验证集(val set).

- (2)创建第一层的多个模型,这些模型可以是同质或者异质。

- (3)使用 train set训练步骤2中的多个模型,然后使用训练好的模型预测val set和test set得到val predict,test predict.

- (4)创建第二层的模型,使用val predict作为训练集训练第二层的模型。

- (5)使用第二层训练好的模型对第二层测试集test predict 进行预测,该结果作为整个测试集的结果。

Blending集成方式的优势是实现简单粗暴,没有太多的理论分析。但是缺点很明显:Blending只使用了一部分数据集作为测试集进行验证,也就是只用上数据中的一部分,实际上这对数据来说很奢侈浪费。

2、Stacking集成学习算法

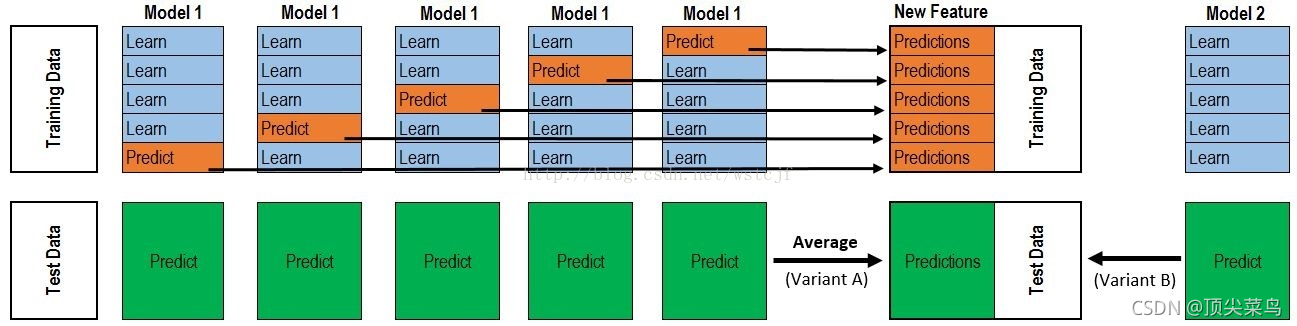

回顾Blending集成算法,第二层模型只用到验证集的数据,对数据实际上是一种很大的浪费。stacking集成方法对其进行了改进,在第一层模型中对数据的划分类似于交叉验证,而不是简单的划分为训练集和测试集,针对不同的model采用不同的数据集。

3、两种算法的对比

Blending与Stacking对比:

Blending的优点在于:

- 比stacking简单(因为针对一层模型,训练集直接划分为了两个部分)

而缺点在于: - 使用了很少的数据(采样hold-out作为测试集,并非cv)

- blending可能会过拟合(其实大概率是第一点导致的)

- stacking使用多次的cv会比较稳健。