文章目录

机器学习的目标

机器学习分类

- 监督学习(supervised learning)

- 无监督学习(unsupervised learning)

- 强化学习(reinforcement learning)

- 半监督学习(semi-supervised learning)

- 深度学习(deep learning)

python scikit-learn

- 一组简单有效的工具集

- 依赖python的numpy,scipy和matplotlib库

- 开源、可复用

scikit-learn常用函数

| 应用 | 算法 | |

|---|---|---|

| 分类classification | 异常检测,图像识别等 | KNN,SVM |

| 聚类clustering | 图像分割,群体划分等 | K-means,谱聚类 |

| 回归regression | 价格预测,趋势预测等 | 线性回归,SVR |

| 降维dimension reduction | 可视化 | PCA,NMF |

sklearn库的简介

无监督学习

利用无标签的数据学习数据的分布或数据与数据之间的关系被称作无监督学习。

- 有监督学习和无监督学习的最大区别在于数据是否有标签

- 无监督学习最常应用的场景是聚类clustering和降维dimension reduction

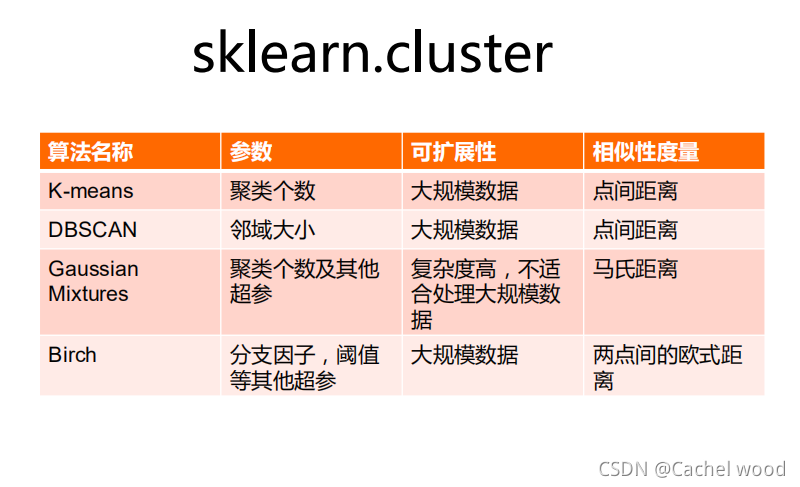

聚类clustering

聚类clustering,就是根据数据的“相似性”将数据分为多类的过程。

评估两个不同样本之间的“相似性”,通常使用的方法就是计算两个样本之间的“距离”。使用不同的方法计算样本间的距离会关系到聚类结果的好坏。

欧式距离

d = ∑ k = 1 n ( x 1 k ? x 2 k ) 2 d = \sqrt{\sum_{k=1}^n (x_{1k}-x_{2k})^2} d=∑k=1n?(x1k??x2k?)2?

曼哈顿距离

d = ∑ k = 1 n ∣ x 1 k ? x 2 k ∣ d = \sum_{k=1}^n |x_{1k}-x_{2k}| d=∑k=1n?∣x1k??x2k?∣

马氏距离

d ( x i , x j ) = ( x i ? x j ) T s ? 1 ( x i ? x j ) d(x_i,x_j) = \sqrt{(x_i-x_j)^Ts^{-1}(x_i-x_j)} d(xi?,xj?)=(xi??xj?)Ts?1(xi??xj?)?

夹角余弦

cos(\theta) = \frac{}{}

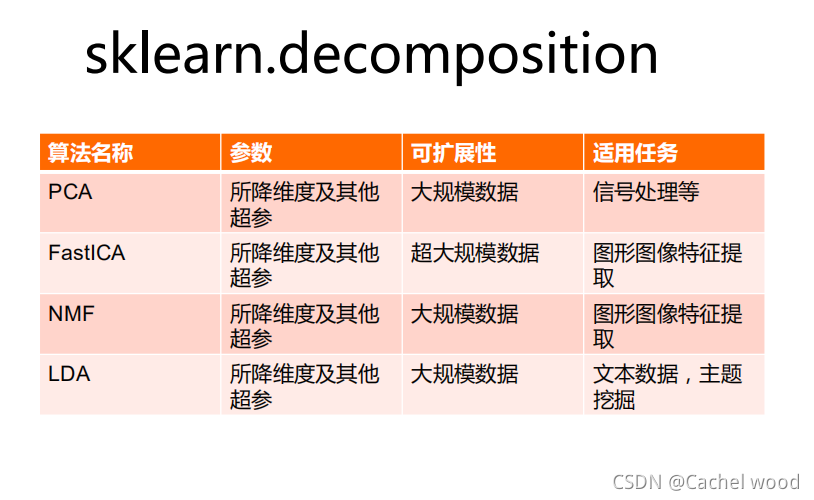

降维

保证数据所具有的代表性特性或者分布的情况下,将高维数据转化为低维数据的过程:

- 数据的可视化

- 精简数据

k-means聚类算法

以k为参数,把n个对象分成k个簇,使簇内具有较高的相似度,而簇间的相似度较低。

其处理过程如下:

- 随机选择k个点作为初始的聚类中心;

- 对于剩下的点,根据其与聚类中心的距离,将其归入最近的簇。

- 对每个簇,计算所有点的均值作为新的聚类中心

- 重复2、3直到聚类中心不再发生改变

DBSCAN密度聚类

- 聚类的时候不需要预先指定簇的个数

- 最终的簇的个数不定

DBSCAN算法将数据点分为三类:

- 核心点:在半径eps内含有超过MinPts数目的点

- 边界点:在半径eps内点的数量小于MinPts,但是落在核心点的邻域内

- 噪音点:既不是核心点也不是边界点的点

PCA方法及其应用

- 主成分分析(principal component analysis,PCA)是最常用的一种降维方法,通常用于高维数据集的探索与可视化,还可以用作数据压缩和预处理等。

- PCA可以把具有相关性的高维变量合成为线性无关的低维变量,称为主成分。主成分能够尽可能保留原始数据的信息。

原理:矩阵的主成分就是其协方差矩阵对应特征向量,按照对应的特征值大小进行排序,最大的特征值就是第一主成分,其次是第二主成分,以此类推。

非负矩阵分解(NMF)

Non-negative Matrix Factorization, NMF是在矩阵中所有元素均为非负数约束条件之下的矩阵分解方法。

基本思想:给定一个非负矩阵V,NMF能够找到一个非负矩阵W和一个非负矩阵H,使得矩阵W和H的乘积近似等于矩阵V中的值。

V n ? m = W n ? k ? H k ? m V_{n*m} = W_{n*k} * H_{k*m} Vn?m?=Wn?k??Hk?m?

基于聚类的“图像分割”实例

图像分割:利用图像的灰度、颜色、纹理、形状等特征,把图像分成若干个互不重叠的区域,并使这些特征在同一区域内呈现相似性,在不同的区域之间存在明显的差异性。然后就可以将分割的图像中具有独特性质的区域提取出来用于不同的研究。

图像分割常用方法:

- 阈值分割:对图像灰度值进行度量,设置不同类别的阈值,达到分割的目的。

- 边缘分割:对图像边缘进行检测,即检测图像中灰度值发生跳变的地方,则为一片区域的边缘。

- 直方图法:对图像的颜色建立直方图,而直方图的波峰波谷能够表示一块区域的颜色值的范围,来达到分割的目的。

- 特定理论:基于聚类分析、小波变换等理论完成图像分割。

监督学习

利用一组带有标签的数据,学习从输入到输出的映射,然后将这种映射关系应用到位置数据上,达到分类或回归的目的。

分类:当输出是离散的,学习任务为分类任务。

回归:当输出是连续的,学习任务为回归任务。

分类学习

输入:一组有标签的训练数据(也称观察和评估),标签表明了这些数据(观察)的所属类别。

输出:分类模型根据这些训练数据,训练自己的模型参数,学习出一个适合这组数据的分类器,当有新数据(非训练数据)需要进行类别判断,就可以将这组新数据作为输入送给学好的分类器进行判断。

回归分析

统计学分析数据的方法,目的在于了解两个或多个变数间是否相关、研究其相关方向与强度,并建立数学模型以便观察特定变数来预测研究者感兴趣的变数。回归分析可以帮助人们了解在自变量变化时因变量的变化量。