决策树之LightGBM

主要用于解决 GDBT 在海量数据中遇到的问题,相对 XGBoost 具有训练速度快、内存占用低的特点。

1. 优化

为了避免XGBoost的缺陷,并且能够在不损害准确率的条件下加快GBDT模型的训练速度,lightGBM在传统的GBDT算法上进行了如下优化:

- 基于Histogram的决策树算法。

- 单边梯度采样 Gradient-based One-Side Sampling(GOSS):使用GOSS可以减少大量只具有小梯度的数据实例,这样在计算信息增益的时候只利用剩下的具有高梯度的数据就可以了,相比XGBoost遍历所有特征值节省了不少时间和空间上的开销。

- 互斥特征捆绑 Exclusive Feature Bundling(EFB):使用EFB可以将许多互斥的特征绑定为一个特征,这样达到了降维的目的。

- 带深度限制的Leaf-wise的叶子生长策略:大多数GBDT工具使用低效的按层生长 (level-wise) 的决策树生长策略,因为它不加区分的对待同一层的叶子,带来了很多没必要的开销。实际上很多叶子的分裂增益较低,没必要进行搜索和分裂。LightGBM使用了带有深度限制的按叶子生长 (leaf-wise) 算法。

- 直接支持类别特征(Categorical Feature)

- 支持高效并行

- Cache命中率优化

2. 相对XGBoost优缺点

优点:

- 速度更快

- LightGBM 采用了直方图算法将遍历样本转变为遍历直方图,极大的降低了时间复杂度;

- LightGBM 在训练过程中采用单边梯度算法过滤掉梯度小的样本,减少了大量的计算;

- LightGBM 采用了基于 Leaf-wise 算法的增长策略构建树,减少了很多不必要的计算量;

- LightGBM 采用优化后的特征并行、数据并行方法加速计算,当数据量非常大的时候还 - 可以采用投票并行的策略;

- LightGBM 对缓存也进行了优化,增加了缓存命中率;

- 内存更小

- XGBoost使用预排序后需要记录特征值及其对应样本的统计值的索引,而 LightGBM 使用了直方图算法将特征值转变为 bin 值,且不需要记录特征到样本的索引,将空间复杂度从KaTeX parse error: Expected 'EOF', got '#' at position 7: O(2 * #?data)降低为 O ( b i n ) O(bin) O(bin),极大的减少了内存消耗;

- LightGBM 采用了直方图算法将存储特征值转变为存储 bin 值,降低了内存消耗;

- LightGBM 在训练过程中采用互斥特征捆绑算法减少了特征数量,降低了内存消耗。

缺点:

- 可能会长出比较深的决策树,产生过拟合。因此LightGBM在Leaf-wise之上增加了一个最大深度限制,在保证高效率的同时防止过拟合;

- Boosting族是迭代算法,每一次迭代都根据上一次迭代的预测结果对样本进行权重调整,所以随着迭代不断进行,误差会越来越小,模型的偏差(bias)会不断降低。由于LightGBM是基于偏差的算法,所以会对噪点较为敏感;

- 在寻找最优解时,依据的是最优切分变量,没有将最优解是全部特征的综合这一理念考虑进去;

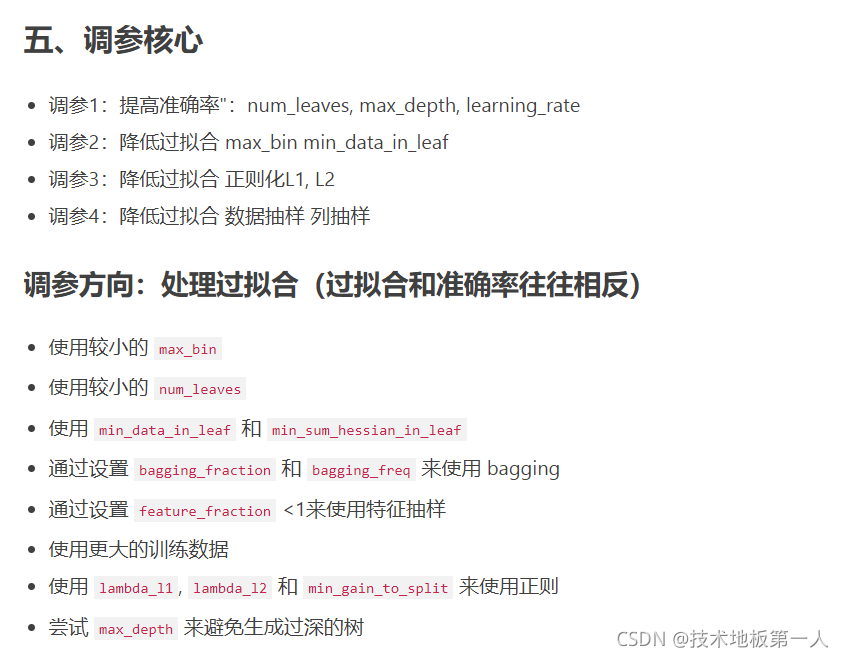

3. 调参

boosting:基模型,有gbdt,rf。

num_leaves:一颗树上的叶子树。

max_depth:最大树深度。

feature_fraction:相当于采样,可以用来加速训练和处理过拟合。

lambda_l2:L2正则化参数。

tree_method:树方法,直方图算法tree_method=hist。