Abstract

Transformer模型:自注意力机制和自我监督

自监督用于大规模未标注数据的预训练

主流识别任务:图像分类 目标检测 行为识别 分割

多模态任务:视觉问答、视觉推理、视觉基础;视频处理(活动识别和视频预测)

低级视觉:图像超分辨率、图像增强和彩色化和3D分析

背景介绍

BERT(Bidirectional Encoder Representations from Transformers)

GPT(Generative Pre-trained Transformer)

RoBERTa(Robustly Optimized BERT Pre-training)

T5(Text-to-Text Transfer Transformer)

大规模数据集上的自我监控允许培训复杂模型,而无需手动注释成本,从而学习对给定数据集中存在的实体之间的有用关系进行编码的可概括表示。这是一个重要特征,因为与其他形式的深度学习模型(如CNN和RNN)相比,自我注意假设最小的诱导偏差。自注意层通过学习令牌集合元素(token set)之间的关系来考虑给定序列中的广域上下文。

基础知识

自我监督(ssl)

用于在大型未标注语料库预训练Transformer,然后用一个小的标记的数据集微调到目标任务。

ssl的基本思想是填空,尝试预测图像中被遮挡的数据,时间视频序列中未来或过去的帧,或者预测一个pretext任务(核心)。

例如:输入的旋转量,应用于图像块的排列或灰度图像的颜色。

另一种方法是通过对比学习。使用麻烦的转换用于创建同一图像的两种修改版本,即不改变底层语义(图像样式化和裁剪)和语义变化(用同一场景中的另一个目标替换目标,或通过对图像进行较小的对抗性更改来更改类)

最后,对模型进行训练,使其对麻烦转换保持不变,并强调对可能改变语义标签的微小改变进行建模。

SSL分两阶段:首先,训练模型通过解决借口任务来学习底层数据的有意义表示。根据数据属性和任务定义自动生成借口任务的伪标签(无需任何手动注释)。在第二阶段,第一阶段训练的模型使用标记数据在下游任务上进行微调。下游任务的示例包括图像分类、对象检测和动作识别。

自我注意

允许捕获序列元素之间的“长期”信息和依赖关系,而传统的循环模型发现编码这种关系很难。

自我注意机制是transformers不可分割的组成部分,它明确地为结构化预测任务建模序列中所有实体之间的交互。基本上,自我注意层通过聚合来自完整输入序列的全局信息来更新序列的每个组成部分。

自我注意的目标是通过根据全局上下文信息对每个实体进行编码来捕获所有元素之间的相互作用。

卷积运算与自我注意的主要区别在于,权重是动态计算的,而不是卷积运算中的静态权重(对于任何输入都保持不变)。此外,自我注意对输入点数量的排列和变化是不变的。因此,与需要网格结构的标准卷积相比,它可以轻松地对不规则输入进行操作。

它具有编码器-解码器结构。编码器由六个相同的层组成,每层有两个子层:一个多头自我注意块和一个简单的位置全连接前馈网络。如图所示,在每一层之后使用残差连接和层规范化。注意,与同时执行特征聚合和特征转换的常规卷积网络不同,这两步在Transformer中解耦,自注意力层仅执行聚合,前馈层执行转换。解码器包括六个相同的层。每个解码器层有三个子层,前两个子层(多头自注意和前馈)类似于编码器,而第三个子层对相应编码器层的输出执行多头注意。

Transformer&自注意力在视觉中

全局自注意力:不受输入特征大小限制——引入一个以非局部方式层,该层将注意力应用于整个要素地图,同时通过设计稀疏注意图降低非局部运算的计算复杂度。

局部自注意力:试图在给定的邻域内建立关系模型,将注意力限制在给定像素位置周围的特定窗口内,以减少计算开销。

目标检测中的Transformer

1.首次使用Transformer 侵入检测问题

2.将扩展到多尺度体系,侧重于提高检测效率,侧重于提高效率

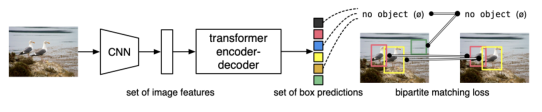

DETR

将目标检测视为一个使用Tansformer和损失函数预测问题。

DETR主要优点是,他消除了对手工制作的模块和操作的依赖,这种方式,对于复杂结构化任务,对先验知识和仔细地工程设计的依赖性得到了放松。

可变形DETR

解决计算成本大、收敛速度慢的问题

只关注真个特征映射中的稀疏元素,不管其空间大小。

Transformer未解决问题&未来展望

1.高计算成本:Transformer参数复杂度高

2.高数据成本:Transformer需要通过查看大量的示例来找出图像属性。

3.新颖的设计:直接将Transformer使用

4.Transformer的可解释性:

5.硬件

6.自我监督模式