深度残差收缩网络

-

论文主要贡献

- 拟解决问题

在处理强噪声振动信号的时候,深度残差网络的特征学习能力经常会降低。深度残差网络中的卷积核,其实就是滤波器,在噪声的干扰下,可能不能检测到故障特征。 - 解决思路

本文提出了两种深度残差收缩网络,即通道间共享阈值的深度残差收缩网络、通道间不同阈值的深度残差收缩网络,来提高从强噪声振动信号中学习特征的能力,最终提高故障诊断准确率。

本文效果的三大法宝:1–使用残差结构加深模型,并且可以让模型自行选择是否需要更新参数;2–在残差模块中构建分支结构,嵌套两层卷积神经网络,自适应寻找合适的阈值;3–使用软阈值化消除噪声。在软阈值化中,共考虑了两种阈值,也就是通道间共享的阈值、通道间不同的阈值。这也是所提出方法名称的由来。

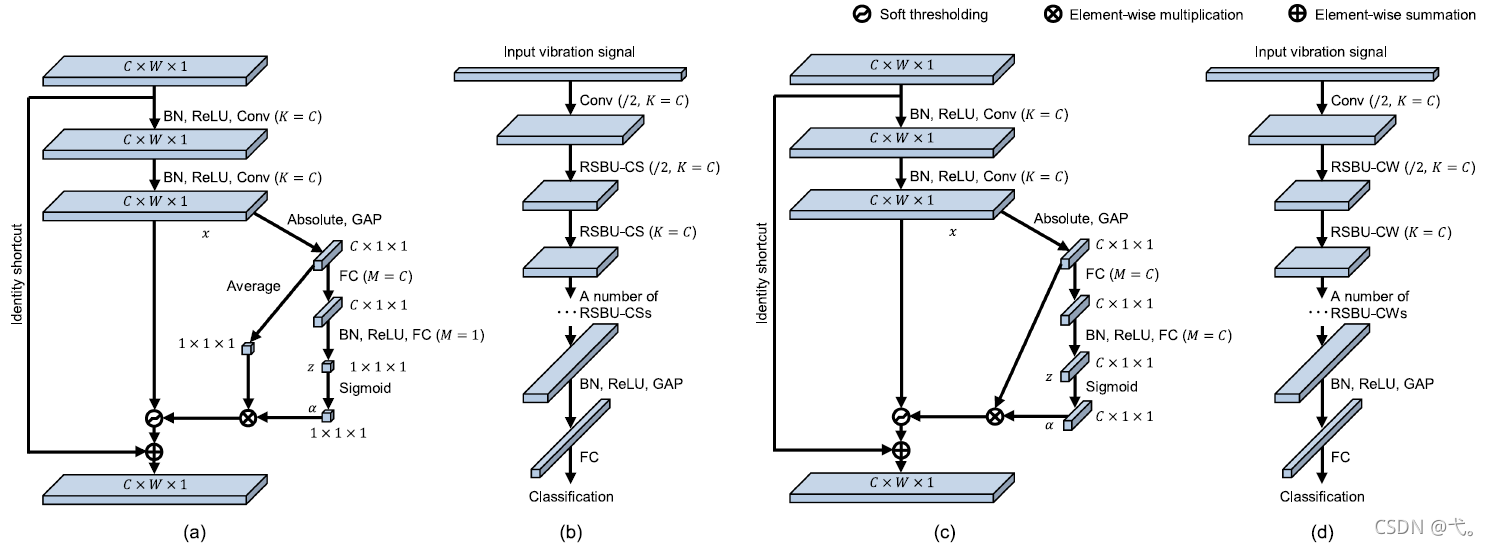

如图(a)所示,该方法为通道间共享的阈值,文中命名为DRSN-CS(residual shrinkage building unit with channel-shared thresholds)。在这个特殊模块中,全局均值池化被应用在特征图的绝对值上面,来获得一维向量。然后,这个一维向量被输入到一个两层的全连接网络中,来获得一个尺度化参数。Sigmoid函数将这个尺度化参数规整到零和一之间。然后,这个尺度化参数,乘以特征图的绝对值得平均值,作为阈值。一定数量的RSBU-CS被堆叠起来,从而噪声相关的特征被逐渐削减。另一个优势在于,阈值是自动学习得到的,而不是由专家手工设置的,所以在实施通道间共享阈值的深度残差收缩网络的时候,不需要信号处理领域的专业知识。

如图(b)所示,该方法为通道间不同的阈值,文中命名为DRSN-CW(residual shrinkage building unit with channel-wise thresholds)。与通道间共享阈值的深度残差收缩网络的区别在于,特征图的每个通道有着自己独立的阈值。通道间不同阈值的残差模块如图4?所示。特征图x首先被压缩成了一个一维向量,并且输入到一个两层的全连接层中。全连接层的第二层有多于一个神经元,并且神经元的个数等于输入特征图的通道数。全连接层的输出被强制到零和一之间。之后计算出阈值。

- 拟解决问题

-

必要背景知识

- 残差网络

目的:采用特殊设计的子网络,来自适应地设置阈值,从而每段振动信号都有着自己独特的一组阈值。

过程:残差构建模块包含了两个批标准化、两个整流线性单元、两个卷积层和一个恒等路径。恒等路径是让深度残差网络优于卷积神经网络的关键。交叉熵损失函数的梯度,在普通的卷积神经网络中,是逐层反向传播的。当使用恒等路径的时候,梯度能够更有效地流回前面的层,从而参数能够得到更有效的更新。

理解:A-残差网络可以使深度梯度回传更加顺畅,因为有一路是恒等映射,一定可以保证梯度为1,防止梯度消失。

B-残差网络设计类似于LSTM结构,可以把卷积网络输出理解为遗忘门,且该输出允许为0,这样可以使模型自己判断该层是需要更新还是保持原输出。避免模型加深,参数爆炸,效果更差。有时候什么都不做一样重要,不训练就可以保证信息无损失, - 软阈值化

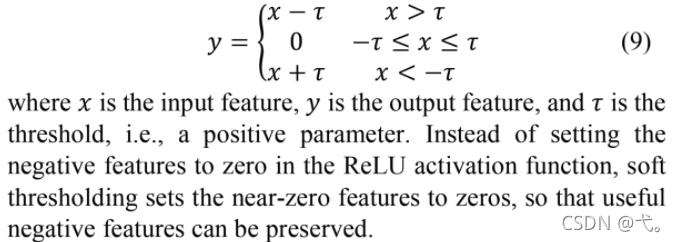

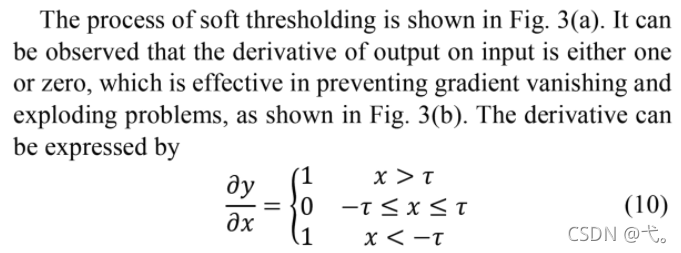

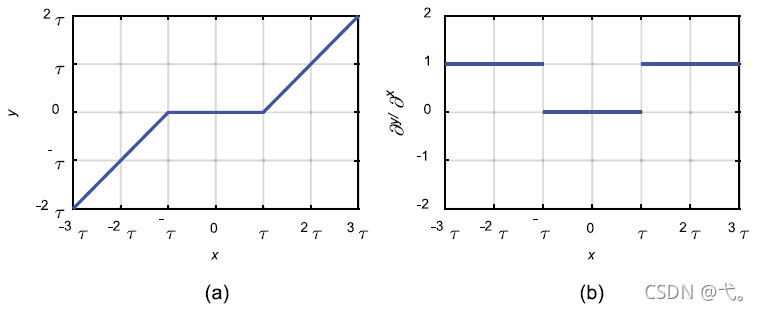

目的:软阈值化(也就是一种流行的收缩方程)作为非线性层,被嵌入深度结构之中,以有效地消除噪声相关的特征。

过程:正向传播阶段,其效果如图(a)所示。

反向传播阶段,导数为1或0,这一设计降低模型复杂度,且保证随模型加深,梯度不会消失,其效果如图(b)所示。

- 残差网络

-

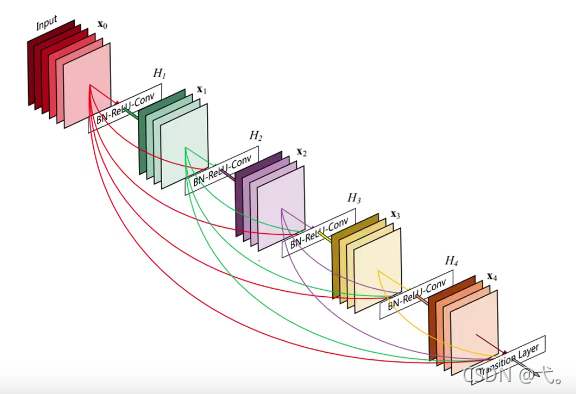

模型改进思路

参考本文模型+CVPR2017最佳论文,DenseNet,理论上可以对结构进行优化。本文模型为基本的残差网络模型,仅考虑残差块内的联系,并未考虑残差块之间的关系。而DenseNet可以让同尺度的残差块之间,学习到同样的输入,以保证信息传递的有效性,其结构如下所示。

改进思路-1,在本文提出的新型残差模块间实现DenseNet模型。

改进思路-2,将本文残差模块拆分,仅保留软阈值化部分,逐层实现DenseNet模型。

理论上,上述两模型在保证去噪效果的同时,可以增加模型的深度,对已知故障识别性能有提升。